目前我可以把大模型拉到自己电脑上跑,数据不出本地,既不用租云也不用上千块的显卡。LocalAI 就是把这事儿变成现实的那个开源项目。

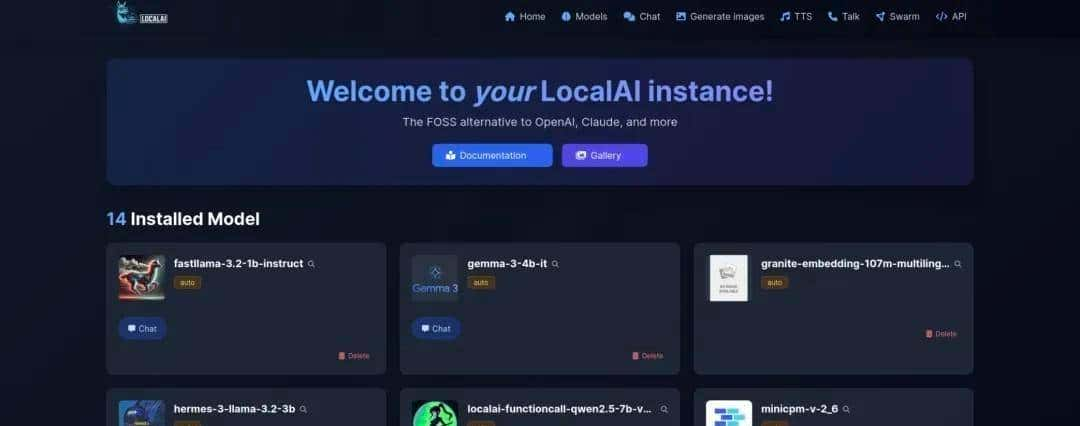

我先跟你讲个亲身试验的过程,免得你听起来像听天书。我找了台普通的服务器,用 Docker 把 LocalAI 启动起来,挑了一个体积比较小的语言模型。服务起来后,我用 curl 发了一个生成请求,几秒钟就回来了。过程里没有任何数据飞出去,响应速度也还算可以。体验上跟调用云端接口差不多,操作感熟悉,但好处是控制权在自己手里,这点很直观——数据不走外网、环境你能看得见、问题能自己查日志解决。

说说为什么会有人搞这个东西。背景蛮简单的:越来越多团队想把 AI 嵌进自家系统,但又担心隐私合规、预算和长期成本。目前市面上的主流服务都跑在云上,数据要传来传去,调用费用也不是小数目。LocalAI 把接口做得像 OpenAI 那样好用,但把推理放到本地跑,能把上面这些痛点都缓解不少。项目在 GitHub 上活跃,维护者是 Ettore Di Giacinto(用户名 mudler),到 2025 年的时候 Star 数已经破三万三,采用 MIT 授权,能随意用、改。

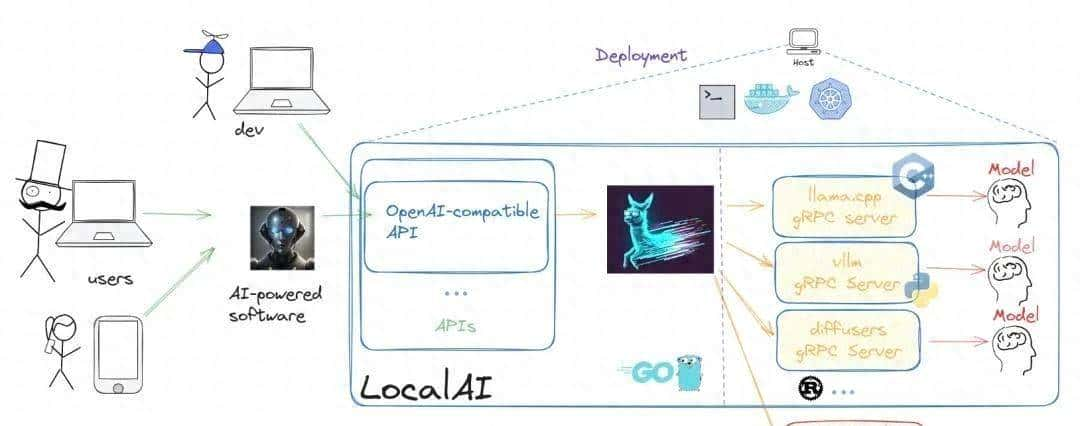

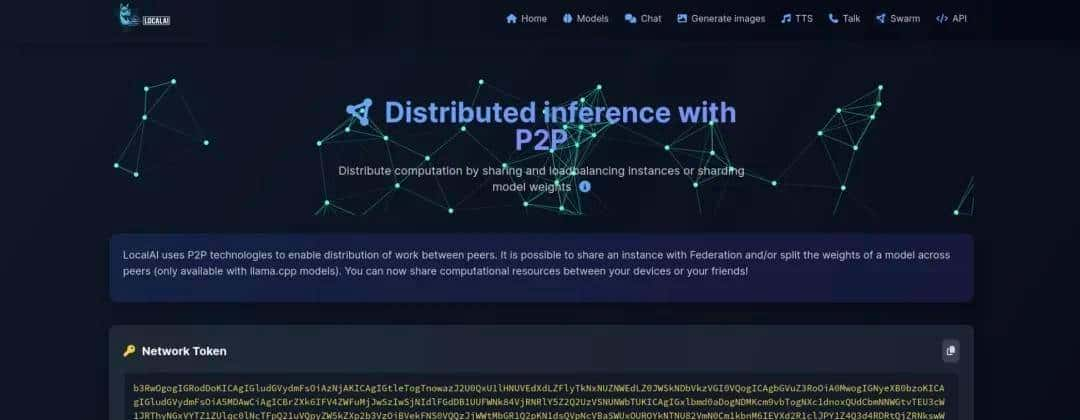

从架构角度看,LocalAI 没有重复造一套推理引擎,它更像是把社区里成熟的组件串起来。上层用 Go 写的 API 层,负责收请求、分发、管理模型等事务;真正做高性能推理的是社区已有的库,列如用 C++ 的 llama.cpp 来跑文本模型,whisper.cpp 处理语音。这样做好处明显:一方面上手门槛低,另一面兼容和性能也更稳。服务间通信可以走 gRPC 或 HTTP,部署上 Docker 最方便,复杂场景可以用 Kubernetes 来做扩展和调度。模型一般从 Hugging Face 之类地方拉,支持文本、图像、音频这些多模态模型接入。

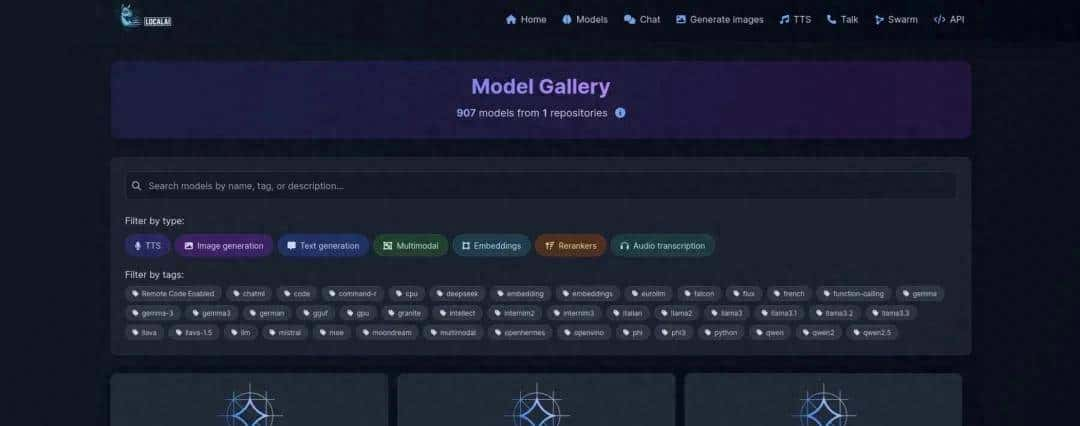

说得具体一点,LocalAI 能做什么:文本生成、对话、图像生成、语音识别或合成之类都能串。它支持在只有 CPU 的机器上跑着玩,这点对没有显卡的人很友善;如果有 GPU,自然能把性能提上来。对开发者来说,用它就像在本地开了个 OpenAI API,绝大多数调用逻辑几乎不用改。对企业而言,本地化能省钱、也利于合规;对个人或爱好者,这是探索模型本地化的捷径。

要实操的话,步骤并不复杂。先把镜像拉下来,或者用社区提供的一键脚本;接着把想用的模型放到指定目录,或者配置让 LocalAI 自动去下载;然后启动容器,服务会在本地暴露一个端口;最后用 curl 或 Postman 对 completions 或 chat 的 endpoint 发 POST 请求,就能拿到结果。第一次运行会去拉模型文件,下载可能需要几分钟,耐心等它完成。测试过程中别忘了看容器日志,许多问题都能从日志里找到线索。

再补充点细节。Go 负责上层的路由和并发处理,适合做轻量级 API;实际的算力密集部分交给 C++ 的推理库。网络通信选 gRPC 的话延迟更低,HTTP 则兼容性更好。部署上 Docker 是最省心的入门方法,到了生产环节可以把它放进 K8s,配合监控、限流、健康检查来保证稳定。模型文件你可以直接从 Hugging Face 下载并版本化管理,遇到模型不兼容的情况,一般是格式或配置不匹配,这时候对照文档调整路径或转换格式就行。

要不要上手,得看你的需求。如果你要求数据绝对不出境、想把系统嵌到内部网络或边缘设备上,或者长期调用量大、希望控制成本,本地化值得一试。反过来,如果你需要最新最强的大模型,而又不想在硬件上投入,云服务短期内还是省事的选择。我的见解是,本地化有它的吸引力:能控制、能调优、能把长期花销压下来,这些对技术团队来说都是现实问题。

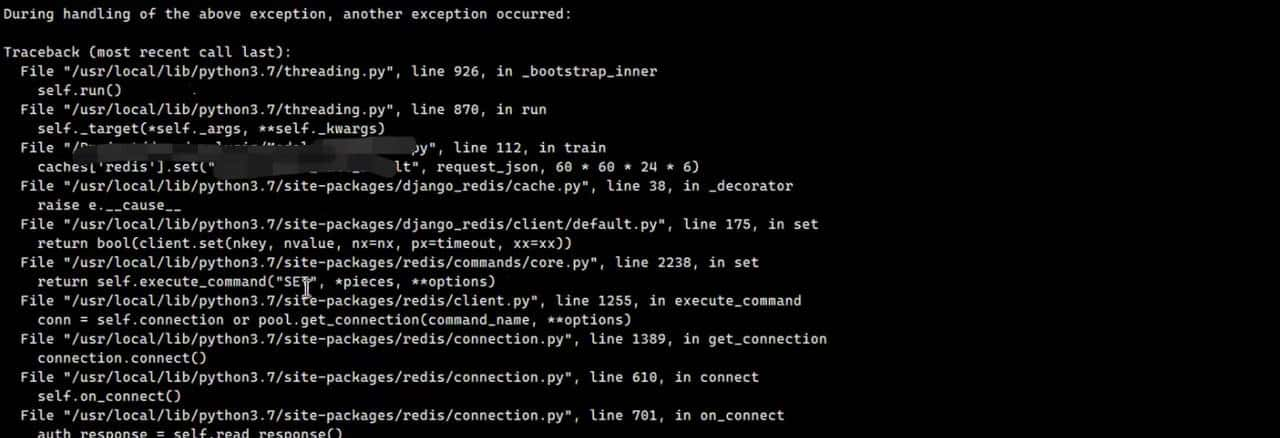

调优和排坑方面,给你几点实践经验:容器启动后先看日志确认模型加载成功,内存不足时会报错或直接被系统 OOM;CPU-only 的时候响应会慢,遇到超时别急着重试,先确认是不是还在下载模型。把模型目录挂载成持久卷,避免每次重启都重新下载。要追求高可用,就把容器放到 K8s 里做副本、配合自动扩缩容和资源请求限制。还有权限和合规问题,虽然数据不出本地但要注意日志是否包含敏感信息,日志管理也要纳入流程。

我说这些的背景是想让你判断信息的来源。我的名字是徐小夕,做过架构和产品工作,参与过大流量系统的建设。目前在做 Dooring AI 的零代码搭建平台、flowmixAI 的多模态办公软件,还有 pxcharts 的多维表格编辑器和 JitWord 的协同文档工具。平时喜爱拆开开源项目看实现、评估适用场景,所以把 LocalAI 挖出来跟大家讲讲实操和注意点。

源码地址在

https://github.com/mudler/LocalAI,感兴趣就去看看,代码、Issue 和社区讨论都很热闹。要是想省事开始,按着一键 Docker 启动走一遍;要是想做稳定可靠的生产部署,可以把容器编排、监控、模型管理这些环节都补齐,调好资源和权限,就能把本地化玩得更稳更长久。

暂无评论内容