数据编排与数据虚拟化:像餐厅一样管理数据的“后厨”与“菜单”

关键词:数据编排, 数据虚拟化, 数据管理, 数据流程, 虚拟视图, 数据源整合, 数据服务

摘要:数据编排与数据虚拟化是数据管理领域的“双璧”,但很多人对它们的区别与联系一知半解。本文用“餐厅运营”的类比,从流程管理(数据编排)和用户接口(数据虚拟化)两个角度,拆解它们的核心逻辑:数据编排像“后厨的流水线”,负责把零散食材(数据源)变成可上桌的菜品(结构化数据);数据虚拟化像“餐厅的菜单”,负责把菜品整理成易懂的选项(虚拟视图),让顾客(应用程序)不用进厨房就能点餐。通过生活例子、代码实战和架构解析,帮你彻底搞懂两者的区别,并学会如何让它们协同工作,提升数据使用效率。

背景介绍

目的和范围

在数据爆炸的时代,企业面临两个核心问题:如何高效处理零散的数据(比如来自MySQL、MongoDB、API的异构数据),以及如何让业务人员快速使用这些数据(不用关心数据存在哪里、怎么处理的)。数据编排(Data Orchestration)和数据虚拟化(Data Virtualization)正是解决这两个问题的关键技术,但它们的定位和作用完全不同。本文的目的是:

用“餐厅”类比,讲清两者的核心定义;用流程图和代码,展示两者的技术架构;用实战案例,说明两者的协同方式;帮读者建立“数据从生产到使用”的完整认知链。

范围覆盖数据管理的“流程层”(数据编排)和“访问层”(数据虚拟化),不涉及底层存储或深度学习等高级主题。

预期读者

数据工程师:想搞懂“数据处理流程”与“数据访问接口”的边界;产品经理:想理解“数据中台”中两个核心模块的价值;业务分析师:想知道“为什么不用直接查数据库,而是用虚拟视图”;技术新手:想入门数据管理,避免混淆概念。

文档结构概述

本文遵循“问题引入→概念拆解→关系分析→实战验证→趋势展望”的逻辑,用“餐厅”类比贯穿始终:

故事引入:用“餐厅如何把食材变成菜品”类比“数据如何从数据源变成服务”;核心概念:用“后厨流程”解释数据编排,用“菜单”解释数据虚拟化;关系分析:说明“流程”与“接口”的协同逻辑(没有流程就没有菜品,没有菜单就卖不出菜品);实战案例:用Airflow(数据编排)和Denodo(数据虚拟化)搭建一个电商数据服务;趋势展望:预测两者未来的发展方向(实时化、智能化)。

术语表

核心术语定义

数据编排(Data Orchestration):管理数据处理流程的工具或技术,负责协调多个数据任务(如提取、转换、加载)的执行顺序、依赖关系和资源分配,确保数据从数据源准确、高效地流向目标(如数据仓库、数据湖)。数据虚拟化(Data Virtualization):一种数据访问技术,通过创建“虚拟视图”(Virtual View)隐藏底层数据源的细节(如存储位置、格式、结构),让应用程序可以用统一的接口(如SQL)查询多个数据源的数据,无需复制或移动数据。

相关概念解释

数据源(Data Source):数据的来源,如数据库(MySQL、MongoDB)、文件(CSV、Excel)、API(RESTful接口)、流数据(Kafka)等。数据管道(Data Pipeline):数据从数据源到目标的处理流程,通常包括“提取(Extract)→转换(Transform)→加载(Load)”三个步骤(ETL),数据编排是管理数据管道的“大脑”。虚拟视图(Virtual View):数据虚拟化平台创建的“逻辑表”,它不存储实际数据,而是映射到底层多个数据源的物理表,应用程序查询虚拟视图时,平台会自动转换查询并从数据源取数。

缩略词列表

ETL:Extract-Transform-Load(提取-转换-加载)DAG:Directed Acyclic Graph(有向无环图,数据编排中用于表示任务依赖)API:Application Programming Interface(应用程序编程接口)

核心概念与联系:用“餐厅”类比搞懂一切

故事引入:餐厅是如何运转的?

想象你走进一家川菜馆,点了一份“番茄炒蛋”。你不需要知道:

番茄来自哪个菜市场(数据源:蔬菜供应商);鸡蛋是哪个农场养的(数据源:禽蛋供应商);厨师是先炒番茄还是先炒蛋(数据处理流程:备菜→炒菜);

你只需要看菜单(虚拟视图),点“番茄炒蛋”(查询虚拟视图),然后等着菜端上来(获取数据结果)。

这家餐厅的运转逻辑,正好对应数据管理的两个核心环节:

后厨流程(数据编排):厨师要把番茄、鸡蛋变成“番茄炒蛋”,需要按顺序完成“洗番茄→切番茄→打鸡蛋→炒番茄→加鸡蛋→调味”等步骤,每个步骤都要依赖前一个步骤的结果(比如没切番茄就不能炒),这就是数据编排的工作——协调数据处理的顺序和依赖。菜单设计(数据虚拟化):菜单把“番茄炒蛋”这个菜品呈现给你,隐藏了背后的食材来源和制作过程,你只需要点单,不需要进厨房,这就是数据虚拟化的价值——隐藏数据细节,提供统一接口。

接下来,我们用这个类比,一步步拆解两个概念。

核心概念解释:像给小学生讲“餐厅故事”一样

核心概念一:数据编排——“后厨的流水线工人”

数据编排的本质是**“管理数据处理的流程”**,就像餐厅的“后厨经理”,负责安排厨师的工作顺序,确保每个步骤都正确执行。

生活类比:

假设餐厅要做“番茄炒蛋”,后厨经理需要安排:

蔬菜工:洗番茄、切番茄(提取并转换蔬菜数据);禽蛋工:打鸡蛋、调蛋液(提取并转换禽蛋数据);炒菜师傅:先炒番茄,再加入蛋液,调味(合并并加载数据)。

如果蔬菜工没切完番茄,炒菜师傅就不能开始炒——这就是任务依赖;如果番茄不够了,后厨经理要及时通知采购(资源监控);如果客人催单,后厨经理要优先安排这个菜的制作(优先级调度)。

技术定义:

数据编排工具(如Airflow、NiFi)通过**有向无环图(DAG)**来表示数据流程,每个节点是一个任务(如“从MySQL取用户数据”“清洗订单数据”),边表示任务之间的依赖关系(如“取用户数据”必须在“清洗订单数据”之前完成)。工具会自动按照DAG的顺序执行任务,并处理失败重试、资源分配等问题。

核心概念二:数据虚拟化——“餐厅的菜单服务员”

数据虚拟化的本质是**“隐藏数据细节,提供统一接口”**,就像餐厅的“服务员”,把后厨的菜品整理成菜单,让顾客不用进厨房就能点餐。

生活类比:

菜单上的“番茄炒蛋”是一个“虚拟菜品”——它不存储实际的番茄和鸡蛋,而是对应后厨的“番茄”(来自蔬菜供应商)和“鸡蛋”(来自禽蛋供应商)。当你点“番茄炒蛋”时,服务员会告诉后厨:“需要一份番茄炒蛋”,后厨会把番茄和鸡蛋做成菜,再由服务员端给你。你不需要知道番茄来自哪里,鸡蛋是怎么来的,只要知道“番茄炒蛋”是你要的菜就行。

技术定义:

数据虚拟化平台(如Denodo、Apache Calcite)通过虚拟视图来映射底层数据源。例如,你可以创建一个虚拟视图

v_user_orders

user

orders

SELECT * FROM v_user_orders WHERE user_id = 123

解析查询:确定需要从

user

user_id=123

orders

user_id=123

SELECT

find

你看,应用程序就像“顾客”,虚拟视图就像“菜单”,数据虚拟化平台就像“服务员”,底层数据源就像“后厨的食材”。

核心概念之间的关系:“流程”与“接口”的协同

数据编排和数据虚拟化是数据管理的“前后端”:数据编排是“后端”(处理数据),数据虚拟化是“前端”(提供接口),两者结合才能让数据真正发挥价值。

类比说明:

没有数据编排(后厨流程):后厨混乱,厨师不知道该做什么,番茄没洗、鸡蛋没打,根本做不出“番茄炒蛋”——数据无法从数据源变成可用的结构化数据。没有数据虚拟化(菜单):顾客不知道有什么菜,只能自己进厨房找食材,要么找不到,要么找到的是生的番茄和鸡蛋——应用程序无法快速使用数据,只能直接查询多个数据源,效率极低。两者结合:数据编排把食材变成菜品(结构化数据),数据虚拟化把菜品做成菜单(虚拟视图),顾客点单(查询虚拟视图),服务员端菜(返回数据结果)——这就是一个完整的数据服务流程。

具体关系拆解:

数据编排是数据虚拟化的“数据源”:

数据虚拟化的虚拟视图需要底层有“可用的数据”,而这些数据通常是数据编排处理后的结果。例如,你要创建

v_user_orders

user

orders

数据虚拟化是数据编排的“价值出口”:

数据编排处理数据的目的是“让数据可用”,而数据虚拟化是“让数据容易用”。例如,数据编排把用户数据和订单数据合并成

user_orders

user_orders

两者共同解决“数据孤岛”问题:

企业的数据通常分散在多个数据源(MySQL、MongoDB、API),形成“数据孤岛”。数据编排通过流程管理把这些数据整合到一起(解决“数据在哪里”的问题),数据虚拟化通过虚拟视图把这些数据统一呈现(解决“数据怎么用”的问题)。

核心概念原理和架构的文本示意图

我们用“餐厅运营”的架构,类比数据管理的架构:

| 餐厅环节 | 对应数据管理环节 | 核心角色/工具 | 功能描述 |

|---|---|---|---|

| 食材供应商 | 数据源 | MySQL、MongoDB、API、CSV | 提供原始数据(如用户信息、订单信息、物流信息) |

| 后厨流程 | 数据编排 | Airflow、Apache NiFi、Prefect | 协调数据处理任务(提取、转换、加载),把原始数据变成结构化数据 |

| 菜品存储 | 数据仓库/数据湖 | Snowflake、Amazon S3、Hadoop | 存储数据编排处理后的结构化数据 |

| 菜单设计 | 数据虚拟化 | Denodo、TIBCO、Apache Calcite | 创建虚拟视图,映射底层数据仓库/数据源,提供统一查询接口 |

| 顾客点餐 | 应用程序/业务人员 | BI工具(Tableau)、APP、API | 通过虚拟视图查询数据,获取所需结果(如用户订单统计、物流跟踪) |

Mermaid 流程图:数据从“食材”到“顾客”的完整流程

graph TD

A[数据源(MySQL、MongoDB、API)] --> B[数据编排引擎(Airflow)]

B --> C[数据仓库(Snowflake)]

C --> D[数据虚拟化平台(Denodo)]

D --> E[虚拟视图(v_user_orders)]

E --> F[应用程序(BI工具、APP)]

F --> G[业务人员/用户]

%% 注释:数据编排处理数据源,存入数据仓库;数据虚拟化从数据仓库创建虚拟视图,供应用程序查询。

核心算法原理 & 具体操作步骤

数据编排:用Airflow构建DAG(有向无环图)

数据编排的核心是管理任务依赖,而DAG是表示任务依赖的关键结构。我们用Airflow(最流行的开源数据编排工具)举个例子,说明如何构建一个“整合用户与订单数据”的DAG。

步骤1:定义DAG的基本信息

from airflow import DAG

from airflow.operators.python_operator import PythonOperator

from datetime import datetime, timedelta

# 定义DAG的默认参数:所有者、开始时间、重试策略

default_args = {

'owner': 'data_engineer',

'start_date': datetime(2024, 1, 1),

'retries': 3,

'retry_delay': timedelta(minutes=5)

}

# 创建DAG实例:id为“user_order_orchestration”,每天执行一次

dag = DAG(

'user_order_orchestration',

default_args=default_args,

schedule_interval='@daily' # 每天凌晨执行

)

步骤2:定义数据处理任务

我们需要三个任务:

提取用户数据:从MySQL取

user

orders

import pymysql

from pymongo import MongoClient

import snowflake.connector

# 任务1:提取用户数据(从MySQL)

def extract_user_data():

conn = pymysql.connect(host='mysql_host', user='root', password='password', db='user_db')

cursor = conn.cursor()

cursor.execute('SELECT user_id, name, email FROM user')

user_data = cursor.fetchall()

conn.close()

return user_data

# 任务2:提取订单数据(从MongoDB)

def extract_order_data():

client = MongoClient('mongodb://mongodb_host:27017/')

db = client['order_db']

orders = db['orders'].find({}, {'_id': 0, 'order_id': 1, 'user_id': 1, 'amount': 1})

order_data = list(orders)

client.close()

return order_data

# 任务3:合并数据(存入Snowflake)

def merge_data(ti):

# 从任务1和任务2获取结果(ti是TaskInstance,用于获取上游任务的输出)

user_data = ti.xcom_pull(task_ids='extract_user_data')

order_data = ti.xcom_pull(task_ids='extract_order_data')

# 合并数据(用user_id关联)

merged_data = []

for user in user_data:

user_id = user[0]

# 找到该用户的所有订单

user_orders = [order for order in order_data if order['user_id'] == user_id]

for order in user_orders:

merged_data.append({

'user_id': user_id,

'name': user[1],

'email': user[2],

'order_id': order['order_id'],

'amount': order['amount']

})

# 存入Snowflake

conn = snowflake.connector.connect(

user='snowflake_user',

password='snowflake_password',

account='snowflake_account',

warehouse='snowflake_warehouse',

database='data_warehouse',

schema='public'

)

cursor = conn.cursor()

# 创建表(如果不存在)

cursor.execute('''

CREATE TABLE IF NOT EXISTS user_orders (

user_id INT,

name VARCHAR(255),

email VARCHAR(255),

order_id INT,

amount DECIMAL(10,2)

)

''')

# 插入数据

for data in merged_data:

cursor.execute('''

INSERT INTO user_orders (user_id, name, email, order_id, amount)

VALUES (%s, %s, %s, %s, %s)

''', (data['user_id'], data['name'], data['email'], data['order_id'], data['amount']))

conn.commit()

conn.close()

步骤3:定义任务依赖

用

PythonOperator

# 创建任务实例

extract_user_task = PythonOperator(

task_id='extract_user_data',

python_callable=extract_user_data,

dag=dag

)

extract_order_task = PythonOperator(

task_id='extract_order_data',

python_callable=extract_order_data,

dag=dag

)

merge_task = PythonOperator(

task_id='merge_data',

python_callable=merge_data,

dag=dag

)

# 定义依赖关系:extract_user_task和extract_order_task完成后,才能执行merge_task

extract_user_task >> merge_task

extract_order_task >> merge_task

步骤4:运行DAG

把上述代码保存为

user_order_orchestration.py

dags

提取用户数据(

extract_user_data

extract_order_data

merge_data

如果某个任务失败(比如MySQL连接超时),Airflow会自动重试3次,每次间隔5分钟,确保数据处理流程的可靠性。

数据虚拟化:用Denodo创建虚拟视图

数据虚拟化的核心是创建虚拟视图,我们用Denodo(商业数据虚拟化工具,支持多种数据源)举个例子,说明如何创建一个

v_user_orders

user_orders

步骤1:连接数据源

Denodo支持连接多种数据源,包括关系型数据库(MySQL、Snowflake)、NoSQL数据库(MongoDB)、API(RESTful)等。我们需要连接两个数据源:

Snowflake:存储数据编排处理后的

user_orders

https://logistics-api.com/orders/{order_id}

连接Snowflake:

在Denodo的“数据源”界面,选择“Snowflake”,输入连接信息(主机、端口、数据库、用户名、密码),测试连接通过后,保存数据源。

连接物流API:

在Denodo的“数据源”界面,选择“RESTful Web Service”,输入API地址(

https://logistics-api.com/orders/{order_id}

步骤2:创建虚拟视图

虚拟视图是Denodo的核心对象,它可以映射单个数据源的表,也可以关联多个数据源的表。我们要创建一个

v_user_orders

user_orders

步骤2.1:创建Snowflake的虚拟表

在Denodo的“虚拟数据库”界面,右键点击“Snowflake”数据源,选择“创建虚拟表”,选择

user_orders

vt_user_orders

步骤2.2:创建物流API的虚拟表

右键点击“物流API”数据源,选择“创建虚拟表”,设置API的参数:

路径参数:

order_id

vt_user_orders

order_id

status

update_time

保存为

vt_logistics

步骤2.3:关联两个虚拟表

右键点击“虚拟数据库”,选择“创建视图”,输入视图名称

v_user_orders

vt_user_orders

vt_logistics

SELECT

u.user_id,

u.name,

u.email,

u.order_id,

u.amount,

l.status AS logistics_status,

l.update_time AS logistics_update_time

FROM

vt_user_orders u

LEFT JOIN

vt_logistics l ON u.order_id = l.order_id

点击“验证”按钮,确认SQL语法正确,然后保存视图。

步骤3:查询虚拟视图

现在,应用程序可以用SQL查询

v_user_orders

user_id=123

SELECT * FROM v_user_orders WHERE user_id = 123

Denodo会自动处理以下步骤:

解析查询:需要从

vt_user_orders

user_id=123

vt_logistics

SELECT

user_orders

GET

https://logistics-api.com/orders/{order_id}

你看,应用程序不需要知道数据来自Snowflake还是物流API,只要知道

v_user_orders

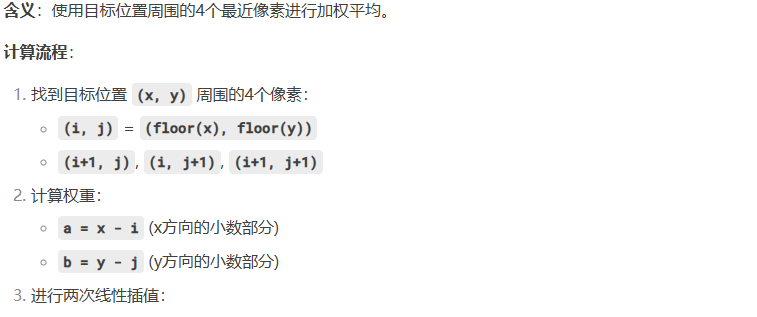

数学模型和公式:数据虚拟化的查询优化

数据虚拟化的核心挑战是查询性能——因为要从多个数据源取数,合并结果,所以必须优化查询流程。其中,查询转换(Query Translation)和查询合并(Query Merging)是两个关键技术,我们用数学公式来解释。

1. 查询转换:虚拟查询到物理查询的映射

假设虚拟视图

v

t1

S1

t2

S2

t1.id = t2.id

Q_v

数据虚拟化平台需要把

Q_v

S1

S2

Q1

Q2

然后,合并

Q1

Q2

Q_v

2. 查询合并:减少数据源访问次数

如果虚拟查询涉及多个虚拟视图,数据虚拟化平台会尝试合并查询(Query Merging),减少对数据源的访问次数。例如,有两个虚拟视图

v1

t1

v2

t2

Q_v

如果不合并查询,平台会先查询

v1

id

v2

id

Q_v

然后,把

Q_{ ext{merged}}

举例说明:物流API的查询优化

假设我们有一个虚拟视图

v_user_orders

user_orders

orders

如果不优化,平台会先从Snowflake取

user_id=123

order_id

GET

order_id

而通过批量查询优化(Batch Query Optimization),平台会把10个

order_id

这样,只需要一次API请求,就能获取所有10个订单的物流信息,大大提升性能。批量查询的数学模型是:

项目实战:搭建电商数据服务

我们用“电商用户订单查询”场景,展示数据编排与数据虚拟化的协同工作流程。

需求说明

电商平台需要为客服人员提供一个“用户订单查询”功能,要求:

可以查询某个用户的所有订单信息(来自MySQL的

user

orders

user_id

技术方案

数据编排:用Airflow构建DAG,每天凌晨提取MySQL的

user

orders

user_orders

v_user_orders

user_orders

orders

v_user_orders

user_id

开发环境搭建

1. 数据编排环境(Airflow)

安装Airflow:

pip install apache-airflow

airflow db init

airflow webserver -p 8080

airflow scheduler

2. 数据虚拟化环境(Denodo)

下载Denodo Express(免费版):https://www.denodo.com/en/express;安装Denodo:按照官方文档步骤安装;启动Denodo:运行

denodo_platform.bat

denodo_platform.sh

3. 数据源准备

MySQL:创建

user

CREATE TABLE user (

user_id INT PRIMARY KEY,

name VARCHAR(255),

email VARCHAR(255)

);

INSERT INTO user VALUES (123, '张三', 'zhangsan@example.com');

MongoDB:创建

orders

{

"_id": ObjectId("65c3b1f9e1b8a3a1b2c3d4e5"),

"order_id": 456,

"user_id": 123,

"amount": 100.00

}

物流API:用Postman模拟一个RESTful API,返回订单的物流信息:

{

"order_id": 456,

"status": "已发货",

"update_time": "2024-03-01 10:00:00"

}

源代码详细实现和代码解读

1. 数据编排:Airflow DAG(参考之前的代码)

提取用户数据:从MySQL的

user

orders

user_orders

2. 数据虚拟化:Denodo虚拟视图(参考之前的步骤)

连接数据源:连接Snowflake(

user_orders

vt_user_orders

user_orders

vt_logistics

v_user_orders

vt_user_orders

vt_logistics

3. 应用程序:Tableau dashboard

连接Denodo:在Tableau中选择“ODBC”连接,输入Denodo的ODBC驱动信息(主机、端口、数据库);选择虚拟视图:选择

v_user_orders

user_id

name

order_id

amount

logistics_status

user_id

user_id

效果演示

客服人员打开Tableau dashboard,输入

user_id=123

用户信息:张三,zhangsan@example.com;订单信息:order_id=456,amount=100.00;物流信息:已发货,更新时间2024-03-01 10:00:00。

整个过程中,客服人员不需要知道数据来自MySQL、MongoDB还是物流API,只要输入

user_id

实际应用场景

1. 电商实时推荐系统

数据编排:用Flink(流数据编排工具)实时提取用户行为数据(来自APP的点击、浏览)、商品数据(来自MySQL)、订单数据(来自Kafka),实时处理(如计算用户偏好、商品相似度),存入Redis(缓存)和Elasticsearch(搜索);数据虚拟化:用Denodo创建虚拟视图

v_user_recommendations

user_id

2. 企业BI分析

数据编排:用Apache NiFi(可视化数据编排工具)整合企业的ERP(SAP)、CRM(Salesforce)、Excel文件数据,清洗、转换后存入数据仓库(BigQuery);数据虚拟化:用TIBCO Data Virtualization创建虚拟视图

v_sales_analysis

3. 金融风险控制

数据编排:用Prefect(现代数据编排工具)定时提取用户的交易数据(来自核心系统)、征信数据(来自人行API)、社交媒体数据(来自微博),处理后存入数据湖(S3);数据虚拟化:用Apache Calcite(开源数据虚拟化工具)创建虚拟视图

v_risk_assessment

工具和资源推荐

数据编排工具

| 工具名称 | 类型 | 特点 | 适用场景 |

|---|---|---|---|

| Apache Airflow | 开源 | 灵活的DAG定义,丰富的插件生态,适合批量数据处理 | 定时ETL、数据仓库同步 |

| Apache NiFi | 开源 | 可视化流程设计,支持流数据和批量数据,适合数据集成 | 实时数据管道、数据源整合 |

| Prefect | 开源/商业 | 现代的工作流引擎,支持动态任务、并行执行,适合云原生环境 | 云数据处理、机器学习流程 |

| AWS Step Functions | 商业 | 托管的工作流服务,与AWS生态深度集成,适合Serverless场景 | AWS上的数据处理、应用编排 |

数据虚拟化工具

| 工具名称 | 类型 | 特点 | 适用场景 |

|---|---|---|---|

| Denodo | 商业 | 支持多种数据源,强大的查询优化,适合企业级应用 | 数据中台、BI分析 |

| TIBCO Data Virtualization | 商业 | 整合多种数据源,支持实时数据,适合大型企业 | 企业数据整合、风险控制 |

| Apache Calcite | 开源 | 轻量级,支持SQL优化,适合自定义数据虚拟化解决方案 | 开源项目、小型应用 |

| Starburst Galaxy | 商业 | 基于Trino(Presto),支持联邦查询,适合大数据场景 | 数据湖查询、实时分析 |

资源推荐

书籍:《Apache Airflow实战》(讲解数据编排的具体工具)、《数据虚拟化:整合企业数据的新方式》(讲解数据虚拟化的理论和实践);文档:Airflow官方文档(https://airflow.apache.org/docs/)、Denodo官方文档(https://community.denodo.com/docs);课程:Coursera《数据工程基础》(讲解数据编排和数据虚拟化的基础概念)、Udemy《Apache Airflow Masterclass》(实战数据编排)。

未来发展趋势与挑战

数据编排的未来趋势

实时化:传统数据编排主要处理批量数据(如每天一次的ETL),未来会向实时数据编排发展(如用Flink处理流数据),支持实时推荐、实时监控等场景;智能化:用AI优化任务调度,比如预测任务的执行时间,自动调整资源分配(如增加CPU资源应对峰值),减少人工干预;云原生:数据编排工具会更深度地集成云服务(如AWS S3、Google BigQuery),支持Serverless架构(如AWS Step Functions),降低运维成本。

数据虚拟化的未来趋势

支持更多数据源:未来会支持更多新型数据源,如区块链数据、物联网(IoT)数据、大语言模型(LLM)的向量数据库;更低延迟:通过缓存(如Redis)、预计算(如Materialized View)、边缘计算(Edge Computing)等技术,降低查询延迟,支持实时应用;更灵活的映射:支持动态schema变化(如JSON数据的 schema 自动识别),适应数据结构频繁变化的场景(如社交媒体数据)。

共同挑战

性能优化:数据编排需要处理越来越多的数据源和数据量,如何提升流程执行效率是挑战;数据虚拟化需要处理越来越复杂的查询,如何优化查询性能是挑战;数据安全:数据编排涉及数据的提取、转换、加载,需要确保数据在传输和处理过程中的安全(如加密);数据虚拟化涉及多个数据源的访问,需要确保数据的访问权限(如角色-based访问控制);人才短缺:数据编排和数据虚拟化是新兴技术,需要既懂数据管理又懂业务的人才,目前市场上人才短缺。

总结:学到了什么?

核心概念回顾

数据编排:像“后厨的流水线工人”,负责管理数据处理的流程(如提取、转换、加载),确保数据从数据源变成结构化数据;数据虚拟化:像“餐厅的菜单服务员”,负责创建虚拟视图,隐藏数据细节,提供统一的查询接口,让应用程序不用关心数据来自哪里。

概念关系回顾

数据编排是“后端”,处理数据;数据虚拟化是“前端”,提供接口;数据编排是数据虚拟化的“数据源”,数据虚拟化是数据编排的“价值出口”;两者结合,解决“数据孤岛”问题,让数据更容易用。

关键结论

如果你需要处理数据流程(如整合多个数据源的数据),用数据编排;如果你需要让数据容易用(如让业务人员快速查询数据),用数据虚拟化;大多数情况下,两者需要协同工作,才能发挥最大价值。

思考题:动动小脑筋

你生活中有没有类似“数据编排”和“数据虚拟化”的场景?比如快递分拣(数据编排)和快递查询(数据虚拟化)?请举例说明。如果你们公司有多个数据源(如ERP、CRM、Excel文件),需要让业务人员查询数据,你会选择数据编排还是数据虚拟化?为什么?数据编排和数据虚拟化可以一起使用吗?如果可以,举一个例子说明它们如何配合。数据虚拟化会影响查询性能吗?如果会,有哪些优化方法?未来,数据编排和数据虚拟化会融合吗?为什么?

附录:常见问题与解答

Q1:数据编排和ETL有什么区别?

A:ETL(提取-转换-加载)是数据编排的一种具体形式,数据编排更广泛,包括ETL、ELT(提取-加载-转换)、实时数据处理(如Flink流处理)等。数据编排是管理数据流程的“大脑”,而ETL是数据流程的“具体步骤”。

Q2:数据虚拟化需要复制数据吗?

A:不需要。数据虚拟化通过虚拟视图映射底层数据源,不复制或移动数据,只在查询时从数据源取数,因此可以节省存储成本,避免数据冗余。

Q3:数据虚拟化支持实时数据吗?

A:是的。现代数据虚拟化工具(如Denodo、TIBCO)支持实时数据源(如Kafka、流API),可以创建实时虚拟视图,提供实时数据查询服务。

Q4:数据编排需要写代码吗?

A:取决于工具。有些数据编排工具(如Apache NiFi)支持可视化流程设计,不需要写代码;有些工具(如Airflow)需要写Python代码定义DAG。

扩展阅读 & 参考资料

《数据管理圣经》(David Loshin):讲解数据管理的整体概念,包括数据编排和数据虚拟化;《Apache Airflow实战》(Bas Harenslak、Julien Le Dem):实战数据编排的具体工具;《数据虚拟化:整合企业数据的新方式》(Mark Madsen):讲解数据虚拟化的理论和实践;Airflow官方文档:https://airflow.apache.org/docs/;Denodo官方文档:https://community.denodo.com/docs;《数据工程基础》(Coursera课程):讲解数据编排和数据虚拟化的基础概念。

作者:[你的名字]

日期:2024年3月1日

版权:本文采用CC BY-SA 4.0协议,转载请注明出处。

(注:本文中的代码示例和工具配置仅供参考,实际使用时请根据具体环境调整。)

暂无评论内容