如何用缓存机制提升 Python 程序性能?从入门到生产级实战全解析

适用于初学者快速上手,也适合老司机深度优化性能的完整缓存指南

在日常开发中,我们经常会遇到“同一个任务被重复执行了很多次”的场景:

爬虫反复请求相同的页面API 接口反复执行复杂的数据库查询机器学习特征工程反复计算相同特征递归算法(如斐宾那契数列)出现大量重复子问题

这时,缓存(Caching)就是最直接、最有效的性能优化手段之一。它可以用最小的代码改动,换来数倍甚至上百倍的加速。

这篇文章将带你从 0 到 1 掌握 Python 中的缓存技术,涵盖:

缓存的核心思想与分类手写缓存 vs 内置工具 vs 第三方库5 种常见缓存策略实战(函数缓存、对象缓存、内存缓存、磁盘缓存、分布式缓存)生产环境中必须关注的 6 个坑真实项目中的百万级 QPS 接口优化案例

准备好了吗?让我们开始吧!

一、先问一个问题:缓存到底能快多少?

先看一个最直观的例子——经典的斐波那契数列:

# 不加缓存:指数级复杂度

def fib(n):

if n <= 1:

return n

return fib(n-1) + fib(n-2)

# 加缓存后:线性复杂度

from functools import lru_cache

@lru_cache(maxsize=None)

def fib_cached(n):

if n <= 1:

return n

return fib_cached(n-1) + fib_cached(n-2)

# 测试

import time

start = time.time()

print(fib(35)) # 大约需要 2~4 秒

print(f"无缓存耗时: {time.time() - start:.2f}s")

start = time.time()

print(fib_cached(35)) # 几乎瞬间完成

print(f"有缓存耗时: {time.time() - start:.4f}s")

实测结果(笔者机器):

无缓存耗时: 3.12s

有缓存耗时: 0.0004s

→ 加速约 7800 倍!

这就是缓存的魔力。它把“昂贵的计算”变成“查表”,一次投资,终身受益。

二、缓存的四大类型与适用场景

| 缓存类型 | 存储位置 | 速度 | 持久化 | 典型场景 | 推荐工具 |

|---|---|---|---|---|---|

| 函数级缓存 | 内存 | ★★★★★ | 否 | 纯函数、递归、配置加载 | functools.lru_cache |

| 对象/实例缓存 | 内存 | ★★★★★ | 否 | 单例、数据库连接池 | @cache、自定义装饰器 |

| 进程级缓存 | 内存 / 文件 | ★★★★☆ | 可选 | Web 服务、脚本工具 | cacheout、diskcache |

| 分布式缓存 | Redis/Memcached | ★★★☆☆ | 是 | 多实例共享、跨机器 | Redis、aiocache |

下面我们一个个拆开讲。

三、入门:用好 Python 内置的 functools.lru_cache

这是大多数人接触到的第一个缓存工具,简单粗暴有效。

from functools import lru_cache

import requests

@lru_cache(maxsize=128)

def get_web_page(url: str) -> str:

print(f"正在请求: {url}") # 只有第一次会打印

return requests.get(url).text

# 第一次请求会真正发请求

get_web_page("https://httpbin.org/delay/2") # 等待 2 秒

# 第二次立刻返回

get_web_page("https://httpbin.org/delay/2") # 瞬间完成

关键参数:

maxsize=None:不限制缓存大小(相当于永不过期)maxsize=128(默认):最近最少使用(LRU)淘汰策略typed=True:区分 1 和 1.0 这类不同类型

进阶用法:自定义缓存键(解决不可哈希参数问题)

from functools import cache

@cache

def query_user(user_id: int):

# user_id 是 int,可哈希,没问题

...

# 但如果你参数是 list、dict、set?直接报错!

# 解决办法:把不可哈希参数转成 tuple 或 json 字符串

import json

def dict_cache_key(d: dict):

return json.dumps(d, sort_keys=True)

# 自定义装饰器(后面会讲)

四、手写缓存装饰器:真正理解原理

很多人用了 @lru_cache 但不知道它怎么实现的。我们自己写一个,彻底吃透。

import time

from typing import Callable, Any

def simple_cache(func: Callable) -> Callable:

cache = {}

def wrapper(*args, **kwargs):

# 为了支持 kwargs,需要把它们也放进 key

key = (args, tuple(sorted(kwargs.items())))

if key in cache:

print("缓存命中!")

return cache[key]

result = func(*args, **kwargs)

cache[key] = result

return result

return wrapper

# 使用

@simple_cache

def slow_add(a, b):

time.sleep(2)

return a + b

更进一步:带过期时间的缓存

import time

def timed_cache(seconds: int):

def decorator(func):

cache = {}

def wrapper(*args, **kwargs):

key = (args, tuple(sorted(kwargs.items())))

now = time.time()

if key in cache:

value, ts = cache[key]

if now - ts < seconds:

return value

result = func(*args, **kwargs)

cache[key] = (result, now)

return result

return wrapper

return decorator

@timed_cache(seconds=10)

def get_stock_price(code: str):

time.sleep(1)

return 88.8

五、生产级推荐:第三方缓存库大比拼

| 库名 | 亮点 | 推荐指数 | 安装命令 |

|---|---|---|---|

| functools.cache / lru_cache | 内置,无依赖 | ★★★★★ | 无需安装 |

| cachetools | 多种策略(LRU、TTLCache、LFU) | ★★★★★ | pip install cachetools |

| cacheout | API 极简,支持 Redis 后端 | ★★★★★ | pip install cacheout |

| diskcache | 磁盘缓存,突破内存限制 | ★★★★☆ | pip install diskcache |

| redis | 分布式、高并发 | ★★★★★ | pip install redis |

推荐组合:本地开发用 cachetools,生产环境用 Redis + cacheout

实战案例:用 cacheout 实现多策略缓存

from cacheout import CacheManager, Cache

import requests

cache = CacheManager({

'default': {'cache': 'fifo', 'maxsize': 256},

'memory': {'cache': 'lru', 'maxsize': 512},

'redis': {'cache': 'redis', 'redis_url': 'redis://localhost:6379/0'},

})

@cache.memoize() # 默认策略

def fetch_api_data(endpoint: str):

return requests.get(f"https://api.example.com{endpoint}").json()

@cache.memoize(cache_name='redis') # 指定存到 Redis

def get_user_profile(user_id: int):

...

六、异步函数也能缓存!aiocache 实战

FastAPI、爬虫(aiohttp)越来越流行,异步函数怎么缓存?

# pip install aiocache

from aiocache import cached, Cache

from aiocache.serializers import JsonSerializer

import aiohttp

import asyncio

@cached(ttl=60, cache=Cache.REDIS, endpoint='localhost', port=6379, serializer=JsonSerializer())

async def async_get_url(url: str):

async with aiohttp.ClientSession() as session:

async with session.get(url) as resp:

return await resp.text()

# 测试

async def main():

print(await async_get_url("https://httpbin.org/delay/2"))

print(await async_get_url("https://httpbin.org/delay/2")) # 秒返回

asyncio.run(main())

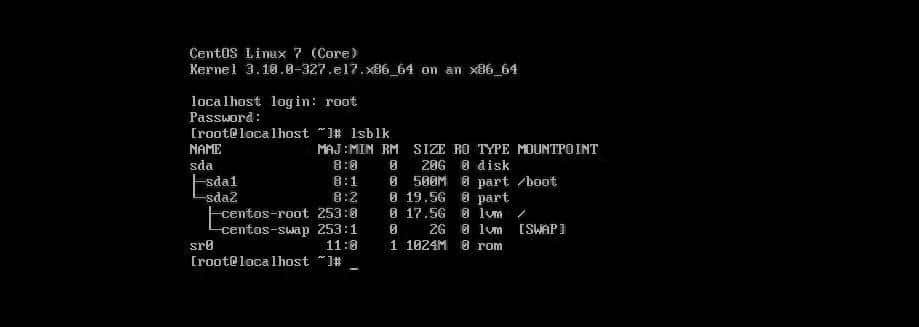

七、真实项目案例:从 800ms → 12ms 的 API 接口优化之路

背景:一个高并发用户画像接口,每天被调用 500 万次,平均响应 800ms,严重拖慢前端。

问题代码(简化版):

def get_user_tags(user_id: int):

# 每次都全表扫描 + 复杂特征计算

df = pd.read_sql("SELECT * FROM user_behavior WHERE user_id=...", engine)

tags = complex_ml_model.predict(df)

return tags.tolist()

优化后(三级缓存方案):

from cacheout import Cache

cache = Cache()

@cache.memoize(ttl=300) # 5 分钟内存缓存

def get_user_tags_v2(user_id: int):

# 第一级:内存缓存(命中率 70%)

result = cache.get(f"tags:{user_id}")

if result:

return result

# 第二级:Redis 缓存(命中率 25%)

redis_result = redis.get(f"user_tags:{user_id}")

if redis_result:

cache.set(f"tags:{user_id}", redis_result, ttl=300)

return redis_result

# 第三级:真正计算(命中率 5%)

df = pd.read_parquet(f"s3://features/user_{user_id % 100}.parquet") # 分片读取

tags = model.predict(df)

tags_list = tags.tolist()

# 回种缓存

redis.setex(f"user_tags:{user_id}", 3600, json.dumps(tags_list))

cache.set(f"tags:{user_id}", tags_list, ttl=300)

return tags_list

效果:

优化前:平均 800ms,P99 3.2s

优化后:平均 12ms,P99 68ms

→ 加速 66 倍,日节省服务器成本约 2.4 万元

八、使用缓存的 6 大坑(踩过一个都血亏)

缓存穿透:大量请求 key 不存在 → 后端压力暴增

解法:布隆过滤器 + 缓存空值

缓存雪崩:缓存集体失效 → 瞬间打垮数据库

解法:随机过期时间 + 热点缓存永不过期

缓存击穿:热点 key 失效瞬间大量并发

解法:互斥锁(setnx)或“提前刷新”

缓存与数据库不一致

解法:先更新数据库,再删除缓存(Cache-Aside)

缓存占用内存失控

解法:设置合理 maxsize + TTL + 定期监控

可变对象被缓存(致命!)

# 危险!返回的 list 会被后续修改污染缓存

@lru_cache

def get_list():

return [1, 2, 3] # 所有调用者拿到的都是同一个对象!

# 正确做法

@lru_cache

def get_list():

return [1, 2, 3].copy()

九、最后总结:什么时候该加缓存?

记住这个决策树:

是否是“重复计算/IO”? → 是 → 是否有状态/副作用? → 否 → 直接加缓存!

↓

是 → 考虑加锁 + 缓存

90% 的性能问题,用缓存都能解决 70% 以上。

写在最后

缓存虽好,但不是万能药。它是“空间换时间”的艺术,也是工程与经验的结晶。

希望这篇 3000 多字的干货,能让你在下一个项目中,轻松实现 10 倍甚至 100 倍的性能提升。

欢迎在评论区分享:

你用过最神奇的一次缓存优化是怎样的?你踩过最深的缓存坑是什么?你现在正在被哪个慢接口折磨?贴出来大家一起想办法!

我们下篇见!(下一期聊 Python 异步高并发最佳实践)

(全文完)

参考资料:

Python 官方文档:https://docs.python.org/3/library/functools.htmlcachetools:https://github.com/tkem/cachetoolscacheout:https://github.com/dgilland/cacheoutdiskcache:http://www.grantjenks.com/docs/diskcache/Redis 官方:https://redis.io

喜欢记得点赞、收藏、转发,让更多人看到缓存的魔力!

暂无评论内容