在 AI 时代,Java 程序员的核心提升逻辑是:立足 Java 生态的稳定性优势,叠加 AI / 数据相关的技术能力,形成 “Java+AI / 数据” 的复合竞争力—— 不盲目转行做算法,而是做 “能落地 AI 的 Java 专家”“懂 Java 的 AI 工程化人才”。

一、夯实 Java 核心:跟上语言演进,筑牢后端根基

Java 是所有拓展的基础,AI 时代对 Java 的要求从 “能用” 升级为 “高效支撑 AI 场景”,需重点补充这些内容:

1、Java 新版本核心特性:聚焦 JDK 17+(长期支持版)的实用功能,列如:

- 虚拟线程(Project Loom):解决高并发场景下的线程开销问题,适配 AI 推理服务的高 QPS 需求;

- 密封类(Sealed Classes):优化代码安全性,适合 AI 模型配置、数据结构的定义;

- 模式匹配(Pattern Matching for instanceof)、record 类:简化数据处理逻辑,提升 AI 数据流转效率;

- GraalVM 原生镜像:将 Java 应用编译为原生可执行文件,解决 AI 推理场景的启动慢、内存占用高问题(关键优化点)。

2、高性能 Java 技术栈:

并发编程:深入 CompletableFuture、线程池参数调优、AQS,支撑 AI 服务的高并发请求;

响应式编程:学习 Spring WebFlux、Project Reactor,适配 AI 流式数据处理(列如实时推荐、语音转文字的流式返回);

性能优化:JVM 调优(GC 参数、内存模型)、Redis 缓存设计、MySQL 索引优化,确保 AI 应用的低延迟响应。

3、微服务与分布式架构升级:

- 核心框架:Spring Boot 3.x、Spring Cloud Alibaba/Netflix,掌握服务注册发现、配置中心、熔断降级(AI 服务依赖多,需保障稳定性);

- 服务编排:Docker 容器化、Kubernetes(K8s)部署,适配 AI 模型的规模化部署和弹性扩容;分布式数据:Sharding-JDBC 分库分表、Elasticsearch(存储 AI 生成的非结构化数据,如日志、文档)。

二、AI 工程化:Java 与 AI 模型的 “对接能力”(核心拓展)

无需深入算法理论,但要掌握 “让 AI 模型在 Java 系统中落地” 的工程化技能,这是 Java 程序员在 AI 时代的核心竞争力:

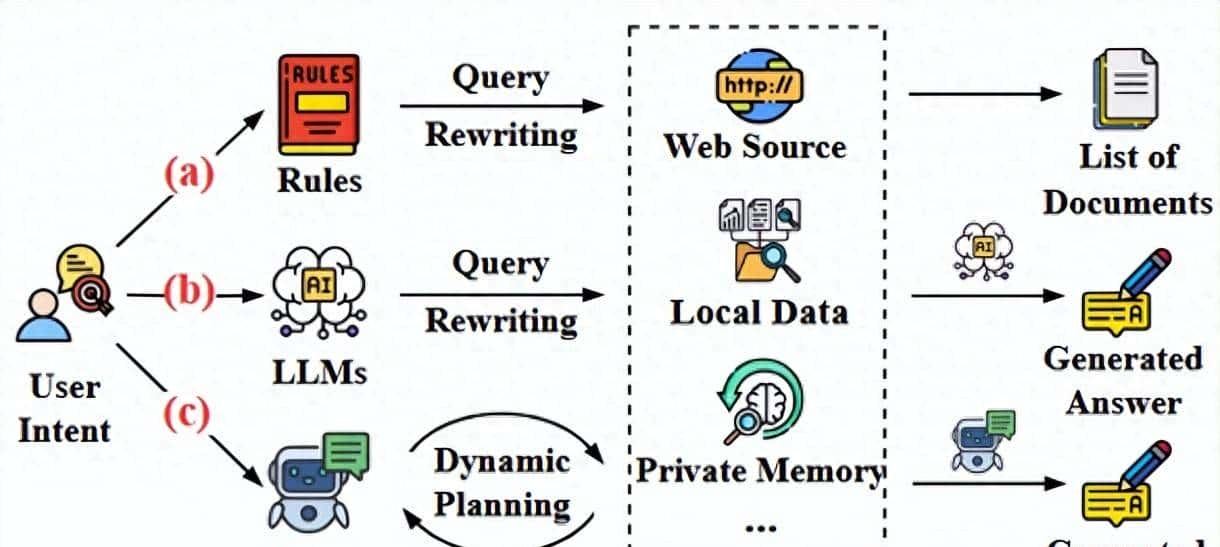

- AI 模型调用与集成:RESTful API 调用:对接主流 AI 大模型(OpenAI、阿里云通义千问、百度文心一言),通过 Java 的 HttpClient、OkHttp 封装请求,处理 JSON 响应(列如在电商系统中集成 AI 商品推荐、智能客服);gRPC 调用:针对高性能场景(如实时 AI 推理),学习 gRPC 的 Java 实现,降低模型调用的网络开销;模型格式适配:了解 ONNX(开放神经网络交换格式),通过 Java 的 ONNX Runtime 库,直接加载训练好的 ONNX 模型(如简单的图像分类、回归模型),避免依赖 Python 环境。

- Java AI 专属框架与工具:Deeplearning4j(DL4J):Java 生态的深度学习框架,无需 Python 基础,可直接在 Java 中构建、训练简单模型(如线性回归、CNN),或部署预训练模型,适合嵌入企业级业务系统;ND4J(NumPy for Java):DL4J 的底层数值计算库,学习其数组操作、矩阵运算,理解 AI 数据的处理逻辑;Spring AI:Spring 官方推出的 AI 集成框架,简化大模型调用、向量数据库集成,是 Java 程序员对接 AI 的 “捷径”,重点学习其 Prompt 模板、模型封装、异常处理。

- 向量数据库与语义检索:核心概念:理解 “向量嵌入”(将文本、图像等转化为数值向量),这是 AI 语义检索、推荐系统的基础;主流向量库:学习 Milvus、Chroma、Elasticsearch 8.x(支持向量搜索)的 Java SDK,实现 “文本→向量→类似性查询” 的全流程(列如 AI 知识库问答、商品类似推荐);应用场景:搭建企业内部 AI 知识库(如将文档转化为向量存储,通过大模型生成答案)。

- AI 场景的数据处理:数据格式:JSON、Protobuf(高性能序列化,适合 AI 数据传输)的 Java 处理;数据清洗:使用 Java 8+ Stream API、Apache Commons Lang3 处理 AI 训练 / 推理的输入数据(如去重、格式转换、缺失值填充);流式数据:通过 Kafka 接收实时数据(如用户行为日志),结合 Java 处理后投喂给 AI 模型,实现实时决策。

三、数据工程:AI 的 “燃料” 支撑(必备配套技能)

AI 的核心是数据,Java 程序员需掌握 “数据采集、处理、存储” 的全链路能力,成为 AI 的 “数据后盾”:

- 大数据框架与 Java 集成:Hadoop 生态:了解 HDFS(分布式存储)、MapReduce(批处理),通过 Java API 操作 Hadoop,处理 AI 训练所需的海量数据;Spark:学习 Spark Core、Spark SQL 的 Java 编程,实现大规模数据的离线计算(如用户行为数据分析、特征工程);Flink:实时数据处理框架(Java 是核心开发语言),适配 AI 实时推理的数据流需求(如实时风控、实时推荐)。

- 数据存储与处理:关系型数据库:MySQL、PostgreSQL 的复杂查询、事务优化(存储 AI 模型的配置数据、用户交互数据);非关系型数据库:Redis(缓存 AI 推理结果、向量数据)、MongoDB(存储非结构化数据,如 AI 生成的文案、图像 URL);数据管道:使用 Apache Airflow、Spring Cloud Data Flow 编排数据处理任务,为 AI 模型提供稳定的数据输入。

四、软实力与场景化能力:让技术落地更有价值

- AI 场景业务理解:聚焦 1-2 个垂直领域(如电商、金融、医疗),理解 AI 在该领域的应用场景(如金融风控的 AI 反欺诈、医疗的 AI 影像辅助诊断),让技术适配业务需求;学习 AI 相关的基础概念(如模型精度、推理延迟、过拟合),能与算法团队高效沟通。

- DevOps 与 AI 工程化流程:CI/CD:使用 Jenkins、GitHub Actions 搭建 Java+AI 应用的自动化部署流程(如模型更新后自动打包部署);监控告警:Prometheus、Grafana 监控 AI 服务的响应时间、调用成功率、资源占用,快速定位问题;安全合规:AI 模型的 API 鉴权、数据加密(如用户隐私数据处理),符合行业合规要求(如金融行业的 PCI DSS、医疗行业的 HIPAA)。

- 跨领域学习与工具:基础 Python:无需精通,但要能看懂简单的 Python 脚本(如算法团队提供的模型训练代码、数据预处理脚本),方便协作;Prompt Engineering(提示工程):了解基础的提示词设计技巧,能通过 Java 代码动态生成高效提示词,提升 AI 模型的响应质量;可视化工具:使用 ECharts、Grafana 展示 AI 模型的运行状态、数据分布,辅助业务决策。

学习路径提议(从易到难,循序渐进)

- 阶段 1(1-3 个月):夯实 Java 核心升级目标:掌握 JDK 17 + 新特性、GraalVM 优化、Spring Boot 3.x+WebFlux,完成 1 个高性能 Java 后端项目(如高并发接口)。

- 阶段 2(3-6 个月):AI 工程化入门目标:学习 Spring AI、ONNX Runtime,实现 “Java 调用大模型 API”“Java 加载 ONNX 模型”“向量数据库集成”,完成 1 个场景化 Demo(如 AI 知识库问答系统)。

- 阶段 3(6-12 个月):数据 + 分布式深化目标:学习 Spark/Flink 的 Java 编程、K8s 部署,搭建 “数据采集→处理→AI 推理→服务输出” 的全链路系统(如实时推荐系统)。

- 阶段 4(长期):垂直领域深耕目标:聚焦某个行业(如金融、电商),沉淀 “Java+AI” 的行业解决方案,形成差异化竞争力。

总结

AI 时代的 Java 程序员,不用 “抛弃 Java 转 AI”,而是要做 “AI 落地的赋能者”—— 以 Java 的后端、分布式优势为根基,叠加 AI 工程化、数据处理能力,既能承接企业级 AI 应用的开发需求,又能凭借 Java 生态的稳定性,在银行、金融、电商等核心行业保持不可替代性。核心是 “不贪多求全,聚焦‘Java+AI 工程化’的交叉点”。

- 最新

- 最热

只看作者