论文地址:https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=11092578

针对Segment Anything Models在低质量图像上性能下降的问题,本文提出了GleSAM框架,通过生成性潜在空间增强技术,显著提升了模型在退化图像上的分割鲁棒性,同时保持了对清晰图像的泛化能力。

引言

Segment Anything Models(SAMs)作为基础分割模型,因其出色的零样本分割能力而在计算机视觉领域产生了重大影响。然而,当面对现实世界中常见的低质量图像(如噪声、模糊和压缩伪影等退化图像)时,SAMs的性能会显著下降,这严重限制了其在实际应用中的有效性。

传统方法通过基于蒸馏的一致性学习来增强退化鲁棒性特征,但在处理复杂退化图像时仍然面临挑战。本文提出的GleSAM(Generative Latent space Enhancement SAM)创新性地将生成扩散模型的强大能力整合到SAM的潜在空间中,通过重建高质量特征表示来改善分割性能。

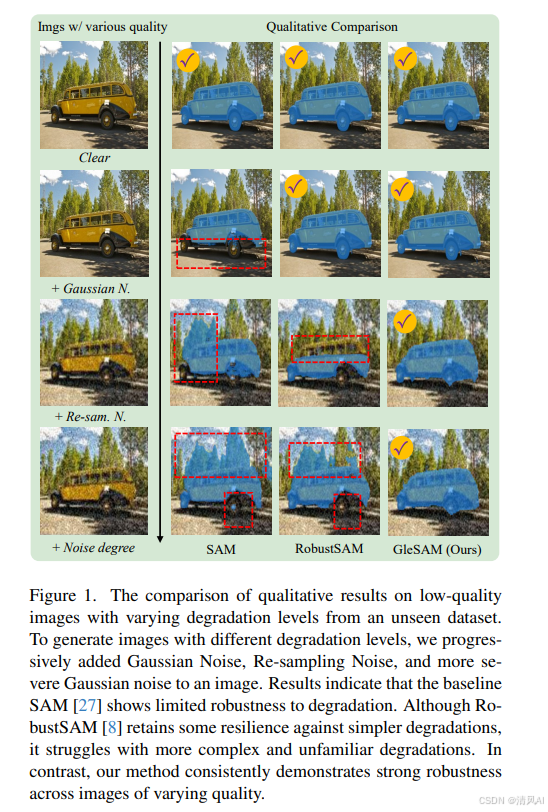

从图1可以看出,基线SAM在退化图像上表现出有限的鲁棒性,而我们的方法在各种质量图像上都保持了一致的强大鲁棒性。

方法概述

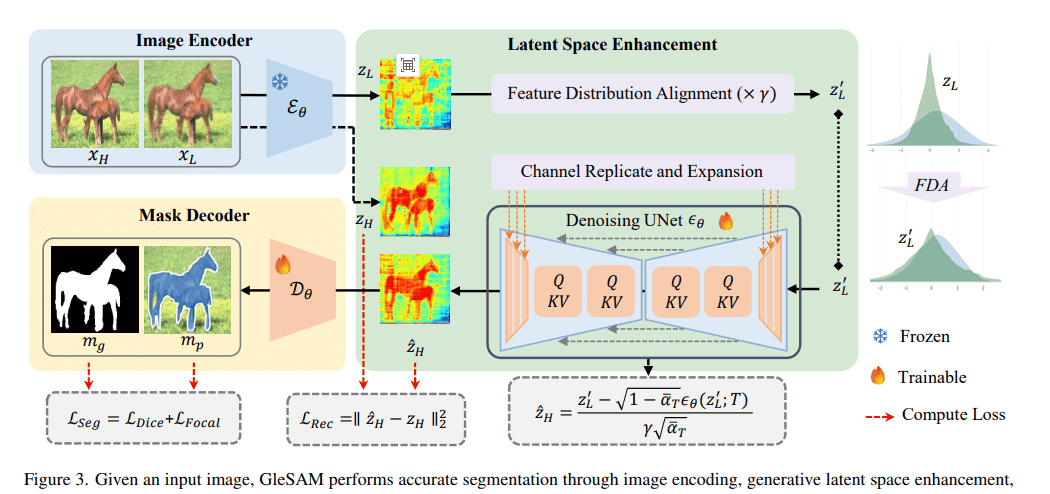

GleSAM的核心思想是利用预训练扩散模型的生成先验来增强SAM的潜在空间表示。整个框架包含三个关键组件:生成性潜在空间增强、特征分布对齐技术和通道复制扩展方法。

整体框架

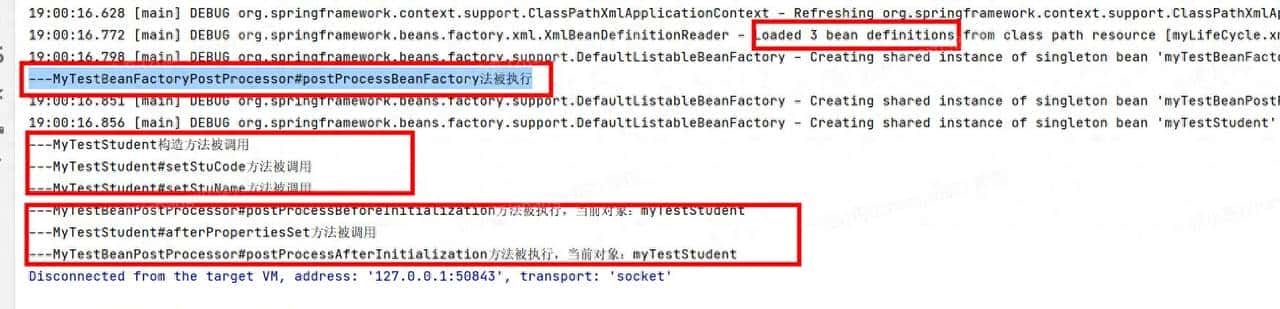

如图3所示,GleSAM的工作流程包括:

图像编码:输入图像通过冻结的SAM编码器提取潜在特征

生成性潜在空间增强:使用基于LoRA的生成去噪U-Net重建高质量特征表示

掩码解码:使用增强后的特征进行精确的分割预测

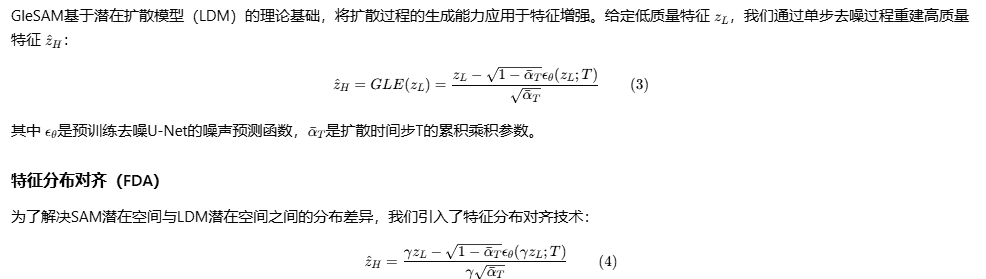

潜在去噪扩散过程

通道复制扩展(CRE)

为了解决预训练U-Net与SAM特征之间的通道数不匹配问题,我们提出了通道复制扩展方法。该方法通过复制和拼接预训练权重来匹配所需的通道维度,同时在训练期间保持头尾层参数冻结,仅通过LoRA层进行适应性微调。

创新技术细节

双阶段微调策略

GleSAM采用两阶段微调过程:

LQSeg数据集构建

为了全面训练和评估模型,我们构建了LQSeg数据集,包含多种退化类型和级别:

退化类型:模糊、随机重采样、噪声和JPEG压缩

退化级别:LQ-1(轻微)、LQ-2(中等)、LQ-3(严重)

数据来源:LVIS、ThinObject-5K、MSRA10K等知名数据集

评估子集:包含已见数据集和未见数据集(ECSSD、COCO-val)

实验结果与分析

定量性能比较

在已见数据集上的性能

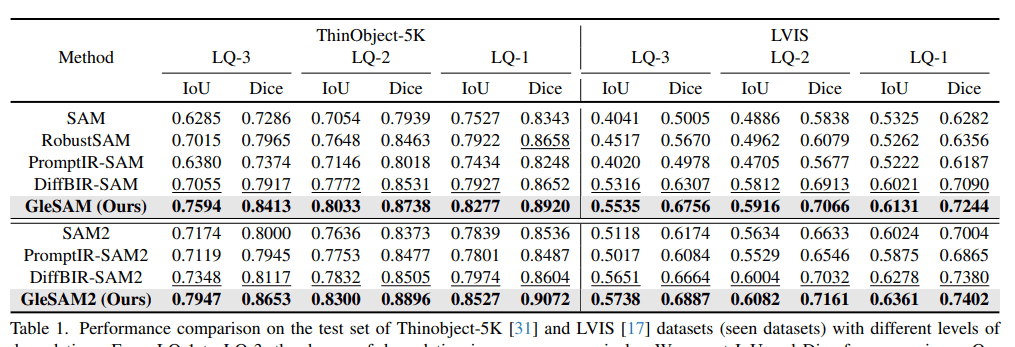

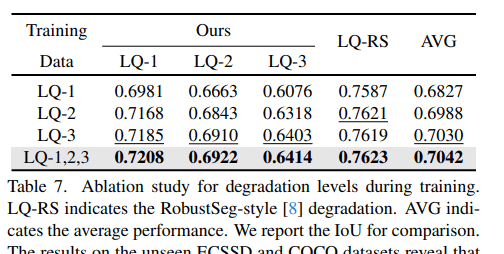

表1显示了在ThinObject-5K和LVIS数据集上的性能比较结果:

在未见数据集上的性能

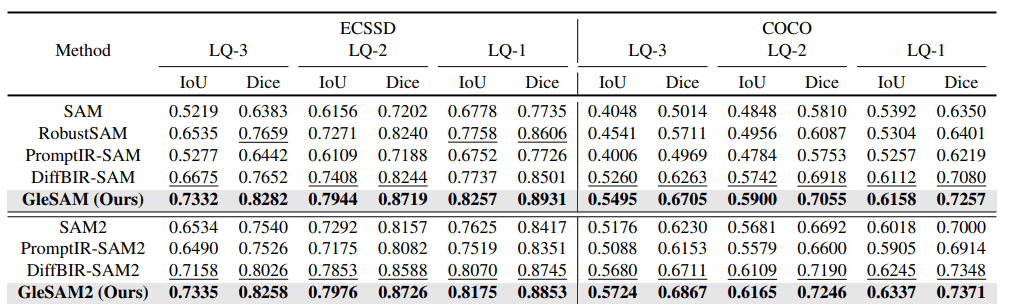

表2显示了在ECSSD和COCO数据集上的零样本性能:

定性结果分析

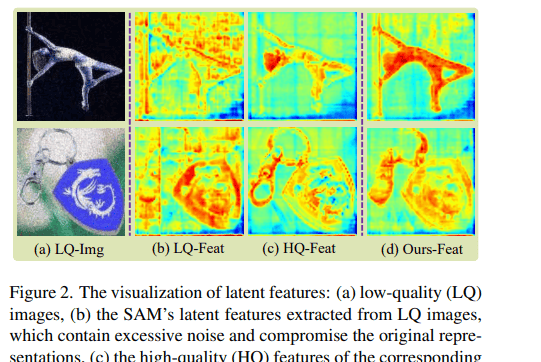

图2展示了潜在特征的可视化结果,可以看出:(a)低质量图像包含明显的退化伪影;(b)SAM提取的特征包含过多噪声;(c)清晰图像对应的高质量特征更加显著;(d)GleSAM增强后的特征恢复了清晰度和显著性。

消融研究

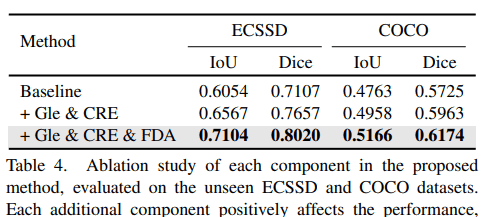

我们进行了详细的消融实验来验证各个组件的有效性:

结论与展望

GleSAM通过生成性潜在空间增强成功解决了SAM在低质量图像上的性能下降问题。关键创新包括:

生成性特征增强:利用预训练扩散模型的生成能力重建高质量特征

分布对齐技术:FDA和CRE技术有效桥接了不同模型间的特征分布差距

高效微调策略:通过LoRA实现参数高效微调,保持预训练知识

综合数据集:LQSeg数据集为低质量图像分割研究提供了良好基准

实验结果表明,GleSAM在保持清晰图像性能的同时,显著提升了在退化图像上的分割鲁棒性,并且具有良好的泛化能力。

未来工作将探索更高效的增强策略、扩展到视频分割领域,以及适应更多样化的退化类型。GleSAM为提升基础分割模型在真实场景中的实用性提供了有前景的方向。

本文内容基于《Segment Any-Quality Images with Generative Latent Space Enhancement》一文,详细实验数据和算法实现请参考原始论文。

暂无评论内容