AI架构师设计个性化学习系统:6个避坑要点,从0到1搭建实战

一、引言:为什么个性化学习系统不能“为AI而AI”?

你有没有遇到过这样的学习场景?

明明已经掌握了“一元一次方程”,系统还在推荐基础题;明明更喜欢视频讲解,系统却一个劲推文本资料;做错一道题后,系统没有针对性反馈,反而跳转到完全不相关的内容。

这就是大部分“伪个性化”学习系统的通病——只停留在“用户分群”或“相似推荐”,没有真正结合「AI技术」与「学习科学」的底层逻辑。

作为AI架构师,我曾参与过3个教育AI项目的从0到1搭建,踩过“重技术轻教育”“重静态轻动态”的坑,也总结出一套可落地的设计框架。

本文将带你拆解AI架构师设计个性化学习系统的6个核心要点,结合实战代码与教育场景的具体要求,帮你避开“为了个性化而个性化”的弯路,真正实现“千人千面”的学习体验。

二、目标读者与收益

目标读者

想进入AI教育领域的AI架构师/算法工程师(有机器学习、推荐系统基础,但对教育场景不熟悉);正在搭建个性化学习系统的产品经理/技术负责人(需要理解技术落地的关键逻辑);对教育AI感兴趣的开发者(想了解AI如何与教育场景结合)。

读者收益

掌握**“AI+教育”的底层逻辑**:不再用“推荐商品”的思路设计学习系统;学会6个核心设计要点:从用户画像到知识图谱,从推荐引擎到实时反馈;获得可直接复用的实战代码:覆盖用户行为采集、知识图谱构建、实时推荐等关键模块;避开常见坑:比如“静态画像”“不可解释的推荐”等。

三、准备工作:你需要的技术与认知储备

在开始设计前,你需要具备这些基础:

1. 技术栈要求

AI基础:熟悉机器学习(分类/回归)、推荐系统(协同过滤、内容推荐)、深度学习(TensorFlow/PyTorch);大数据基础:了解流处理(Flink/Kafka)、缓存(Redis)、图数据库(Neo4j);教育领域知识:至少听说过「认知诊断」「最近发展区」「元认知」等概念(后面会详细讲)。

2. 工具与环境

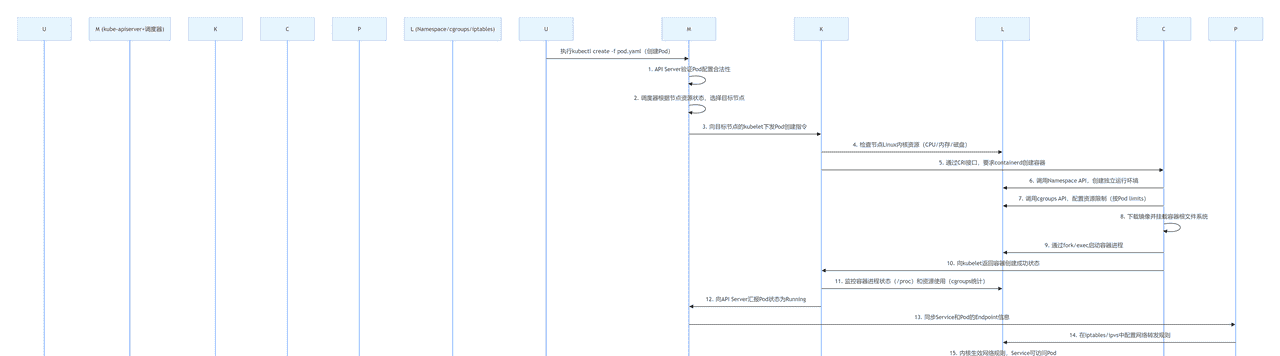

开发工具:Python 3.8+、TensorFlow 2.x、Neo4j、Flink;数据准备:教育领域数据集(比如KDD Cup的「EdNet」数据集,包含学生答题、学习路径等数据);基础设施:Kafka(实时数据传输)、Redis(实时用户画像)、Docker(环境隔离)。

四、核心要点:6个关键设计维度(附实战代码)

接下来是本文的核心——AI架构师设计个性化学习系统的6个必须要点。每个要点都会回答3个问题:「为什么要做?」「怎么做?」「实战代码示例」。

要点1:底层逻辑——用「学习科学」约束AI,而不是反过来

为什么?:AI不能“主导”学习,只能“辅助”学习

很多团队的误区是:用“推荐商品”的思路设计学习系统——比如根据用户浏览记录推荐“相似课程”。但学习是一个认知发展的过程,需要遵循学习科学的规律:

最近发展区(Zone of Proximal Development):学生能独立完成的任务,与在指导下能完成的任务之间的区域,才是最有效的学习区间;认知诊断(Cognitive Diagnosis):需要精准识别学生的“知识漏洞”,而不是“猜测”他们的兴趣;螺旋式上升:学习内容需要重复但逐步加深(比如小学数学的“乘法”会在不同年级以不同形式出现)。

结论:AI模型必须“嵌套”在学习科学的框架里,而不是反过来。

怎么做?:用「认知诊断模型」量化学生的学习状态

认知诊断模型(CDM)是连接AI与学习科学的关键工具,它能将学生的答题行为转化为可量化的“认知状态”(比如“掌握了80%的一元一次方程”“逻辑推理能力处于中等水平”)。

最常用的认知诊断模型是项目反应理论(IRT, Item Response Theory),它通过学生的答题数据,计算两个核心参数:

θ(学生能力值):数值越高,学生的能力越强;b(题目难度值):数值越高,题目越难。

实战代码:用IRT模型计算学生能力值

我们用

pyirt

pyirt

pip install pyirt

import numpy as np

from pyirt import IRT

# 1. 模拟学生答题数据:100个学生,20道题,值为1(答对)或0(答错)

student_answer = np.random.randint(0, 2, size=(100, 20))

# 2. 初始化IRT模型(单参数模型,只考虑题目难度)

model = IRT(model_type="1PL") # 1PL:只有难度参数b;2PL:加区分度a;3PL:加猜测参数c

# 3. 训练模型

model.fit(student_answer, n_iter=1000, lr=0.01) # 迭代1000次,学习率0.01

# 4. 输出结果:学生能力值(θ)、题目难度值(b)

student_theta = model.get_theta() # 100个学生的能力值,范围[-3,3]

item_b = model.get_b() # 20道题的难度值,范围[-3,3]

# 示例:找到学生1的能力值对应的“最近发展区”题目

student1_theta = student_theta[0]

# 筛选难度在[student1_theta - 0.5, student1_theta + 0.5]的题目(最近发展区)

zpd_items = [i for i, b in enumerate(item_b) if (student1_theta - 0.5) <= b <= (student1_theta + 0.5)]

print(f"学生1的能力值:{student1_theta:.2f}")

print(f"最近发展区的题目ID:{zpd_items}")

关键说明:

IRT模型的核心是“匹配”——让学生做难度略高于其当前能力的题目(最近发展区),这样学习效果最好;不要用“正确率”代替能力值:比如一个学生做10道简单题全对,正确率100%,但能力值可能低于做对5道难题的学生。

要点2:用户画像——不是“标签集合”,而是“学习状态的动态快照”

为什么?:静态画像解决不了学习的“动态性”

传统用户画像(比如“25岁,男性,喜欢科技”)对学习系统毫无意义——学习是一个动态过程:

上午还没掌握“一元一次方程”,下午学会了;昨天喜欢视频讲解,今天可能更喜欢互动练习;做题时的“犹豫时间”(比如30秒才提交答案)比“正确率”更能反映真实水平。

结论:个性化学习系统的用户画像必须是动态的、学习相关的、多维度的。

怎么做?:构建「学习画像」的4个维度

我总结了学习画像的4层金字塔模型(从底层到顶层,重要性递增):

| 维度 | 说明 | 示例 |

|---|---|---|

| 静态属性 | 不会变的基础信息 | 年龄、学历、学习目标(考雅思/学Python) |

| 动态行为 | 实时的学习行为数据 | 最近10题的正确率、视频观看时长、做题犹豫时间 |

| 认知状态 | 用认知诊断模型计算的能力值 | 逻辑推理能力(θ=1.2)、知识漏洞(“一元一次方程”未掌握) |

| 学习偏好 | 个性化的学习风格 | 喜欢视频>文本、早上学习效率高、偏好“步骤式讲解” |

实战代码:用Redis构建实时学习画像

学习画像需要低延迟读写(比如实时更新“最近10题的正确率”),Redis是最佳选择。以下是用Python+Redis采集用户行为的示例:

import redis

from flask import Flask, request

import json

# 初始化Redis连接

r = redis.Redis(host='localhost', port=6379, db=0)

app = Flask(__name__)

# 埋点接口:接收用户学习行为(比如“提交题目”“观看视频”)

@app.route('/track_learning_event', methods=['POST'])

def track_event():

event = request.json

user_id = event['user_id']

event_type = event['event_type'] # 比如'submit_question'/'watch_video'

event_data = event['event_data'] # 比如{'question_id': 'q1', 'correct': True, 'time_spent': 25}

# 1. 存储实时行为:保留最近10条(比如最近10题的记录)

if event_type == 'submit_question':

# 用List结构存储,LPUSH添加到头部,LTRIM保留最近10条

r.lpush(f'user:{user_id}:question_history', json.dumps(event_data))

r.ltrim(f'user:{user_id}:question_history', 0, 9) # 只保留前10条

# 2. 更新动态属性:比如“最近10题的正确率”

if event_type == 'submit_question':

# 读取最近10条记录

history = r.lrange(f'user:{user_id}:question_history', 0, 9)

correct_count = 0

total = len(history)

for item in history:

data = json.loads(item)

if data['correct']:

correct_count += 1

# 计算正确率并存储

accuracy = correct_count / total if total > 0 else 0

r.set(f'user:{user_id}:recent_accuracy', round(accuracy, 2))

# 3. 更新认知状态:比如用IRT模型实时更新能力值(可异步处理)

# 这里简化为调用IRT模型的API,实际中可以用Celery异步执行

# update_irt_theta(user_id, event_data)

return {'code': 200, 'message': 'success'}

if __name__ == '__main__':

app.run(debug=True, port=5000)

关键说明:

用Redis的

List

要点3:知识图谱——不是“百科全书”,而是“学习路径的导航图”

为什么?:知识不是孤立的,学习需要“路径依赖”

比如学习“一元二次方程”,必须先掌握“一元一次方程”和“平方运算”——知识是有依赖关系的。如果系统推荐内容时忽略这种依赖,会导致学生“学不会”(比如没学过“平方运算”就去学“一元二次方程”)。

结论:知识图谱是个性化学习系统的**“导航系统”**,它能:

明确“先学什么,后学什么”;识别学生的“知识漏洞”(比如没学过“平方运算”,就无法学“一元二次方程”);推荐“补漏内容”(比如先学“平方运算”,再学“一元二次方程”)。

怎么做?:设计「动态知识图谱」的3个关键

知识图谱的核心是**“节点+关系”,但学习系统的知识图谱需要动态更新**(比如学生掌握某个节点后,解锁下一个节点)。以下是设计步骤:

定义知识节点:每个节点代表一个“可学习的单元”(比如“一元一次方程”“平方运算”),属性包括:

id

name

type

difficulty

mastery

定义关系:最核心的关系是

DEPENDS_ON

DEPENDS_ON

动态更新:当学生掌握某个节点(比如

mastery≥0.8

实战代码:用Neo4j构建动态知识图谱

Neo4j是最常用的图数据库,以下是用Python操作Neo4j的示例:

from neo4j import GraphDatabase

import json

class DynamicKnowledgeGraph:

def __init__(self, uri, user, password):

self.driver = GraphDatabase.driver(uri, auth=(user, password))

def close(self):

self.driver.close()

# 1. 创建知识节点

def create_knowledge_node(self, node_id, name, type_, difficulty):

with self.driver.session() as session:

session.run("""

CREATE (n:KnowledgeNode {

id: $node_id,

name: $name,

type: $type,

difficulty: $difficulty,

mastery: 0.0 # 初始掌握度为0

})

""", node_id=node_id, name=name, type=type_, difficulty=difficulty)

# 2. 创建依赖关系

def create_dependency(self, from_node_id, to_node_id):

with self.driver.session() as session:

session.run("""

MATCH (a:KnowledgeNode {id: $from}), (b:KnowledgeNode {id: $to})

CREATE (a)-[:DEPENDS_ON]->(b)

""", from=from_node_id, to=to_node_id)

# 3. 动态更新节点掌握度

def update_mastery(self, user_id, node_id, new_mastery):

with self.driver.session() as session:

# 用“用户-节点”关系存储每个用户的掌握度(避免节点属性被共享)

session.run("""

MATCH (u:User {id: $user_id}), (n:KnowledgeNode {id: $node_id})

MERGE (u)-[r:LEARNED]->(n)

SET r.mastery = $new_mastery

""", user_id=user_id, node_id=node_id, new_mastery=new_mastery)

# 4. 推荐“下一步学习节点”(根据依赖关系和掌握度)

def recommend_next_node(self, user_id):

with self.driver.session() as session:

result = session.run("""

MATCH (u:User {id: $user_id})-[:LEARNED]->(n:KnowledgeNode {mastery: 1.0})

MATCH (n)<-[:DEPENDS_ON]-(next:KnowledgeNode)

WHERE NOT EXISTS ((u)-[:LEARNED]->(next))

RETURN next.id AS node_id, next.name AS node_name, next.difficulty AS difficulty

ORDER BY next.difficulty ASC LIMIT 3

""", user_id=user_id)

return [record.data() for record in result]

# 示例使用

kg = DynamicKnowledgeGraph("neo4j://localhost:7687", "neo4j", "password")

kg.create_knowledge_node("math1", "一元一次方程", "concept", 2.0)

kg.create_knowledge_node("math2", "平方运算", "concept", 1.5)

kg.create_knowledge_node("math3", "一元二次方程", "concept", 3.0)

kg.create_dependency("math3", "math1") # 一元二次方程依赖一元一次方程

kg.create_dependency("math3", "math2") # 一元二次方程依赖平方运算

# 更新用户1的“一元一次方程”掌握度为1.0(完全掌握)

kg.update_mastery("user1", "math1", 1.0)

# 推荐下一步学习节点(会推荐“平方运算”,因为“一元二次方程”依赖它)

print(kg.recommend_next_node("user1"))

kg.close()

关键说明:

用“用户-节点”关系存储掌握度:避免节点属性被所有用户共享(比如“一元一次方程”的掌握度是用户1的1.0,用户2的0.5);推荐逻辑要结合依赖与掌握度:比如只推荐“已掌握前置节点”且“未学习”的节点;知识图谱要动态扩展:比如新增“二元一次方程”时,只需添加节点和依赖关系即可。

要点4:推荐引擎——不是“猜你喜欢”,而是“帮你学会”

为什么?:学习推荐≠商品推荐

很多团队用“推荐商品”的思路设计学习推荐(比如“看了这个课程的用户也看了那个课程”),但学习的目标是**“掌握知识”**,而不是“浏览更多内容”。

结论:学习推荐引擎的核心是**“基于学习目标的精准匹配”**,它需要结合:

用户的认知状态(比如能力值θ=1.2);知识的依赖关系(比如需要先学“平方运算”);用户的学习偏好(比如喜欢视频讲解)。

怎么做?:构建「混合推荐引擎」的3层结构

我设计的学习推荐引擎包含3个模块(从底层到顶层):

过滤层:用知识图谱过滤“不可学”的内容(比如没掌握前置节点的内容);匹配层:用用户画像匹配“适合学”的内容(比如难度在最近发展区的内容);排序层:用学习偏好排序“喜欢学”的内容(比如视频>文本)。

实战代码:用TensorFlow构建混合推荐模型

以下是一个简化的混合推荐模型(结合用户画像、内容特征、知识图谱特征):

import tensorflow as tf

from tensorflow.keras.layers import Input, Dense, Concatenate

from tensorflow.keras.models import Model

# 1. 输入层:用户特征、内容特征、知识图谱特征

user_input = Input(shape=(10,), name='user_features') # 学习画像的10维特征(比如能力值、最近正确率)

content_input = Input(shape=(5,), name='content_features') # 内容特征(比如类型:视频=1/文本=0,难度)

kg_input = Input(shape=(3,), name='kg_features') # 知识图谱特征(比如依赖节点数、用户已掌握前置节点数)

# 2. 隐藏层:分别处理不同特征

user_dense = Dense(64, activation='relu', kernel_regularizer='l2')(user_input) # L2正则防止过拟合

content_dense = Dense(32, activation='relu', kernel_regularizer='l2')(content_input)

kg_dense = Dense(16, activation='relu', kernel_regularizer='l2')(kg_input)

# 3. 拼接层:融合多维度特征

concat_layer = Concatenate()([user_dense, content_dense, kg_dense])

# 4. 输出层:推荐分数(0-1,分数越高越推荐)

output = Dense(1, activation='sigmoid', name='recommendation_score')(concat_layer)

# 5. 构建与编译模型

model = Model(inputs=[user_input, content_input, kg_input], outputs=output)

model.compile(

optimizer=tf.keras.optimizers.Adam(learning_rate=0.001),

loss=tf.keras.losses.BinaryCrossentropy(),

metrics=[tf.keras.metrics.AUC(name='auc')] # 用AUC评估推荐效果(比准确率更适合推荐场景)

)

# 打印模型结构

model.summary()

关键说明:

输入层要多维度:结合用户、内容、知识图谱的特征,避免“单一维度”的偏差;隐藏层要正则化:学习数据通常比较稀疏,L2正则能防止过拟合;评估指标用AUC:推荐系统的核心是“排序准确性”(把最适合的内容排在前面),AUC比准确率更能反映这一点。

要点5:实时反馈——不是“答对/答错”,而是“为什么错,怎么改”

为什么?:反馈是学习的“发动机”

心理学研究表明:及时、针对性的反馈,能让学习效率提升30%以上。比如:

学生做错一道题后,系统立即指出“你错在‘移项时符号没变’”,并推荐“移项技巧”的视频;学生做对一道题但用时很长,系统提示“你掌握了这个知识点,但可以加快速度”。

结论:实时反馈是个性化学习系统的**“灵魂”**——没有反馈的学习,就是“盲目刷题”。

怎么做?:设计「实时反馈系统」的3个步骤

实时反馈需要低延迟(比如答题后1秒内给出反馈),因此需要用流处理框架(比如Flink)处理实时数据。以下是设计步骤:

采集实时行为:用Kafka采集用户的答题、观看等行为(比如“提交题目”事件);实时分析:用Flink计算行为的“特征”(比如做题时间、正确率);触发反馈:根据分析结果,触发针对性的反馈(比如推荐讲解视频、调整后续内容)。

实战代码:用Flink处理实时答题数据

以下是用Flink的Python API计算“实时正确率”并触发反馈的示例:

from pyflink.datastream import StreamExecutionEnvironment

from pyflink.table import StreamTableEnvironment, DataTypes

from pyflink.table.udf import udf

# 1. 创建执行环境

env = StreamExecutionEnvironment.get_execution_environment()

t_env = StreamTableEnvironment.create(env)

# 2. 定义Kafka输入表(用户答题流)

t_env.execute_sql("""

CREATE TABLE user_question_stream (

user_id STRING,

question_id STRING,

correct BOOLEAN,

time_spent INT, # 做题时间(秒)

timestamp TIMESTAMP(3)

) WITH (

'connector' = 'kafka',

'topic' = 'user_question',

'properties.bootstrap.servers' = 'localhost:9092',

'properties.group.id' = 'flink_consumer',

'format' = 'json',

'scan.startup.mode' = 'latest-offset'

)

""")

# 3. 定义UDF(用户自定义函数):根据答题结果生成反馈

@udf(result_type=DataTypes.STRING())

def generate_feedback(correct: bool, time_spent: int) -> str:

if not correct:

return "你答错了,建议观看《这道题的解题技巧》视频"

elif time_spent > 60:

return "你做对了,但用时较长,建议练习《快速解题训练》"

else:

return "做得很好!继续保持"

# 4. 实时计算并生成反馈

t_env.execute_sql("""

CREATE TABLE feedback_sink (

user_id STRING,

question_id STRING,

feedback STRING,

timestamp TIMESTAMP(3)

) WITH (

'connector' = 'kafka',

'topic' = 'user_feedback',

'properties.bootstrap.servers' = 'localhost:9092',

'format' = 'json'

)

""")

# 5. 执行计算:从输入表读取数据,生成反馈,写入输出表

t_env.execute_sql("""

INSERT INTO feedback_sink

SELECT

user_id,

question_id,

generate_feedback(correct, time_spent) AS feedback,

timestamp

FROM user_question_stream

""").wait()

关键说明:

用Kafka作为输入/输出:保证实时数据的传输;UDF要轻量化:反馈逻辑要简单(复杂逻辑可以后续处理);反馈要针对性:比如“答错”的反馈要指出具体错误原因(而不是泛泛的“再试一次”)。

要点6:可解释性——不是“可选功能”,而是“必须要求”

为什么?:用户需要“信任”系统

想象一下:你打开学习系统,系统推荐了一个“移项技巧”的视频,但你不知道为什么推荐它——你会点击吗?大概率不会。可解释性是用户信任系统的关键。

另外,教育领域有监管要求(比如“双减”政策要求“教育APP必须说明推荐理由”)。

结论:可解释性是个性化学习系统的**“信任基石”**——没有可解释性的推荐,就是“黑箱”,用户不会用。

怎么做?:实现「可解释推荐」的2种方式

可解释性的实现方式有2类(根据复杂度从低到高):

规则式解释:用简单的规则说明推荐理由(比如“因为你最近做错了3道‘移项’的题,所以推荐这个视频”);模型式解释:用模型解释推荐的决策过程(比如“你的‘移项’能力值较低,这个视频能提升你的能力值”)。

实战代码:用SHAP解释推荐模型

SHAP(SHapley Additive exPlanations)是最常用的模型解释工具,能解释“每个特征对推荐结果的贡献”。以下是用SHAP解释推荐模型的示例:

import numpy as np

import tensorflow as tf

import shap

# 1. 加载训练好的推荐模型(见要点4的代码)

model = tf.keras.models.load_model('recommendation_model.h5')

# 2. 生成样本数据(用户特征、内容特征、知识图谱特征)

user_features = np.random.rand(100, 10) # 100个用户的10维特征

content_features = np.random.rand(100, 5) # 100个内容的5维特征

kg_features = np.random.rand(100, 3) # 100个内容的3维知识图谱特征

# 3. 创建SHAP解释器(DeepExplainer用于深度学习模型)

explainer = shap.DeepExplainer(model, [user_features, content_features, kg_features])

# 4. 解释一个样本的推荐结果

sample_user = user_features[0:1] # 第一个用户的特征

sample_content = content_features[0:1] # 第一个内容的特征

sample_kg = kg_features[0:1] # 第一个内容的知识图谱特征

# 计算SHAP值:每个特征对推荐分数的贡献

shap_values = explainer.shap_values([sample_user, sample_content, sample_kg])

# 5. 可视化解释结果

shap.summary_plot(

shap_values,

feature_names=['user_features', 'content_features', 'kg_features'],

title='推荐结果的特征贡献'

)

关键说明:

SHAP值的含义:正数表示该特征“增加推荐分数”,负数表示“降低推荐分数”;可视化结果能让你快速看到“哪个特征对推荐结果影响最大”(比如“用户的‘移项’能力值较低”是推荐该视频的主要原因);规则式解释要通俗易懂:比如把“user_features[3]的值较低”翻译成“你的‘移项’能力值较低”。

五、进阶探讨:从“能用”到“好用”的3个方向

当你掌握了以上6个要点,系统已经“能用”了。接下来可以向“好用”进阶:

1. 性能优化:处理百万级用户

用Redis集群存储用户画像:解决单节点的容量瓶颈;用Flink的Window批量处理数据:降低实时计算的资源消耗;用模型蒸馏压缩推荐模型:把大模型压缩成小模型,提升推理速度。

2. 多模态内容的个性化

结合文本、视频、互动练习的推荐:比如用户喜欢视频,推荐“视频讲解+互动练习”的组合;用多模态模型(比如CLIP)匹配用户偏好:比如用户喜欢“步骤式讲解”,推荐包含“步骤动画”的视频。

3. 伦理与隐私

匿名化用户数据:比如用“用户ID哈希”代替真实ID;让用户“控制自己的数据”:比如允许用户删除自己的学习记录;避免“过度个性化”:比如不要推荐“太简单”或“太难”的内容,防止用户“厌学”。

六、总结:AI架构师的“教育思维”比“技术能力”更重要

回顾本文的6个要点:

用学习科学约束AI,而不是反过来;构建动态学习画像,而不是静态标签;设计动态知识图谱,而不是静态百科;推荐能学会的内容,而不是“猜你喜欢”;提供针对性实时反馈,而不是泛泛的结果;实现可解释推荐,而不是“黑箱”。

最核心的结论:

AI架构师设计个性化学习系统,不是“用AI改造教育”,而是“用AI辅助教育”——技术是工具,教育规律才是核心。

最后送你一句话:“好的个性化学习系统,应该让用户感觉‘系统懂我’,而不是‘系统在猜我’。”

七、行动号召:一起讨论,一起进步

如果你正在设计个性化学习系统,或者遇到了问题,欢迎在评论区留言:

你踩过哪些“伪个性化”的坑?你对知识图谱/推荐引擎有什么疑问?你想了解哪些具体的实战细节?

我会一一回复,并在后续文章中分享更多实战经验(比如“如何用大模型优化推荐引擎”“如何评估个性化学习系统的效果”)。

让我们一起,用AI让学习更高效!

暂无评论内容