如果你听说过人工智能(AI)训练,可能会注意到一个高频词:GPU。有人说“AI是吃GPU长大的”,甚至有人说“没有GPU就没有今天的AI”。

那么,GPU到底是什么?为什么它成了AI训练的“必需品”?我们用最直白的语言来解释。

一、先说说CPU和GPU的区别

在解释GPU为什么重大之前,我们先看看计算机里最常见的两个“大脑”——CPU和GPU。

- CPU(中央处理器)

它是计算机的“总指挥”,负责处理各种任务,列如运行软件、浏览网页、写文档等。

特点:核心数量少(列如普通电脑的CPU有4-8个核心),但每个核心都很强劲,擅长按顺序处理复杂任务。 - GPU(图形处理器)

它最初是为游戏和图形渲染设计的,列如处理屏幕上几百万个像素的颜色和光影。

特点:核心数量极多(列如普通GPU有几千个核心),但每个核心很简单,擅长同时处理大量简单任务。

举个栗子:

假设你要搬1000块砖,CPU是几个大力士,一次能搬几十块,但需要来回跑许多趟;而GPU是1000个小学生,每人搬一块,一次搞定。

虽然每个小学生力气小,但胜在人多力量大!

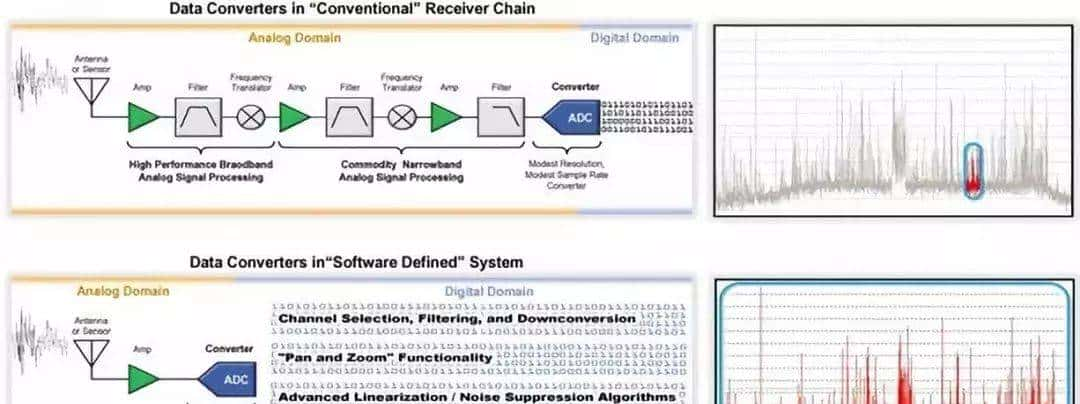

二、AI训练到底在做什么?

AI模型(尤其是深度学习模型)的核心任务是“学习”。列如,教AI识别一只猫,需要给它看几百万张猫的图片,让它自己总结规律。

这个过程需要大量的数学运算,尤其是矩阵乘法(想象成一大堆数字的加减乘除)。

举个具体场景:

- 一张图片进入AI模型后,会被分解成几百万个像素点。

- 每个像素点都要经过层层计算,调整模型的参数(列如“猫耳朵尖尖的”“猫眼睛是椭圆形的”)。

- 这个过程需要重复几百万次,直到模型学会准确识别猫。

关键问题来了:这种计算量有多大?

以著名的GPT-3模型为例,它的训练需要完成数万亿次数学运算。如果用普通CPU,可能需要几十年;但用GPU集群,几个月就能完成。

三、GPU为什么比CPU更适合AI训练?

答案就藏在三个关键词里:并行计算、显存带宽、软件生态。

- 并行计算能力

AI训练中的矩阵乘法、数据调整等任务,可以拆分成无数个小任务,同时进行。

GPU的几千个核心就像流水线工人,各自负责一部分计算,效率极高。而CPU的核心少,只能逐个处理,速度慢如蜗牛。 - 显存带宽

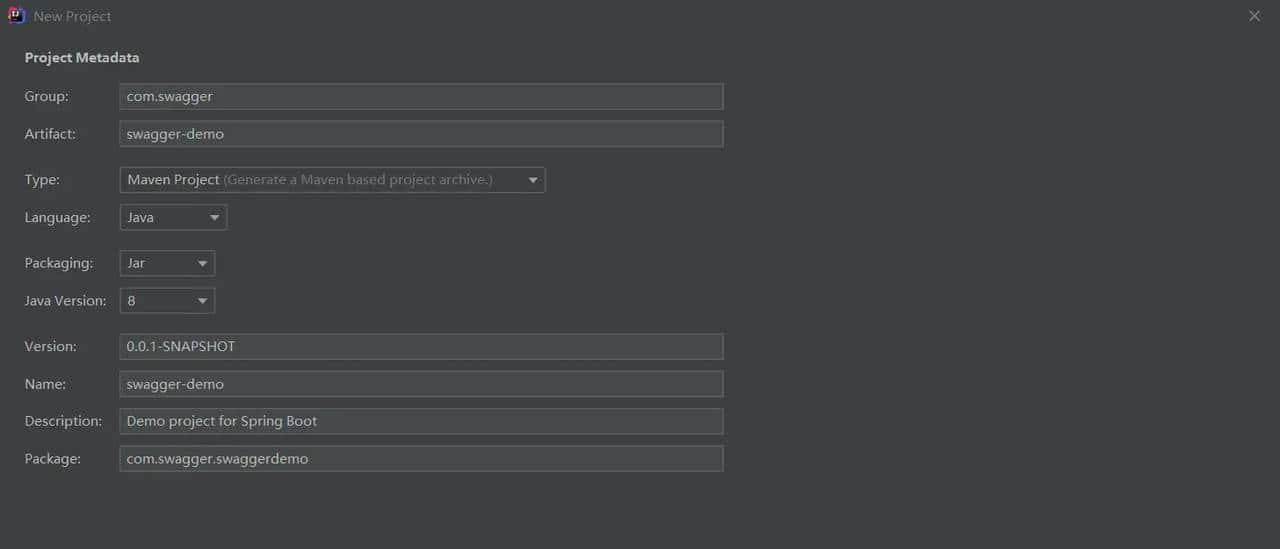

GPU自带高速显存(类似内存),能快速读取海量数据。AI训练需要反复调用数据(列如图片、文本),显存带宽越高,数据搬运速度越快。 - 软件生态支持

GPU厂商(列如NVIDIA)开发了专门的工具库(如CUDA),让程序员能轻松调用GPU的算力。主流AI框架(如PyTorch、TensorFlow)也都对GPU做了优化。

再举个栗子:

AI训练就像一场大型演唱会,CPU是几个专业歌手轮流独唱,虽然唱得好,但耗时太长;GPU是万人合唱团,虽然每个人声音小,但合起来气势磅礴,瞬间完成演出!

四、GPU的其他优势

除了算得快,GPU还有两个隐藏优点:

- 省钱

虽然一块高端GPU的价格可能高达上万美元,但相比用几百台CPU服务器训练模型,总体成本反而更低。 - 体积小

一台服务器可以塞进多块GPU,节省机房空间。

五、总结:GPU是AI时代的“加速引擎”

如果用一句话概括:

GPU用“人多力量大”的暴力计算模式,把原本需要几年的AI训练缩短到几天甚至几小时,让AI技术得以快速落地。

今天的AI应用(列如ChatGPT、自动驾驶、人脸识别)都离不开GPU的支持。可以说,没有GPU,就没有现代人工智能的爆发式发展。

小白快速记忆版

- CPU:机智但人少,适合干细活。

- GPU:人海战术,适合干粗活。

- AI训练是“粗活”,所以GPU完胜!

© 版权声明

文章版权归作者所有,未经允许请勿转载。如内容涉嫌侵权,请在本页底部进入<联系我们>进行举报投诉!

THE END

暂无评论内容