一、核心概念:什么是大模型的“短记忆”与“长记忆”

我们可以这样类比:

短记忆:

定义: 模型在处理当前一次对话或查询时,所能直接“看到”的上下文信息。技术本质: 模型在生成下一个词时,其注意力机制能够关注到的前方所有Token的集合。特点: 记忆完全在模型的内部激活中,是瞬时的、与当前任务强相关的。一旦生成结束,这些“记忆”就消失了。

长记忆:

定义: 模型能够跨会话、跨任务持久化保存和调用的知识或信息。技术本质: 模型本身无法直接实现长记忆。长记忆需要通过外部技术将信息在推理时“注入”到模型的上下文窗口中,从而转化为短记忆来使用。特点: 信息被存储在模型之外(如向量数据库、文件等),需要时被检索并唤醒。

二、技术原理详解

1. 短记忆的技术原理

短记忆的能力直接由模型的上下文窗口 决定。

技术基础:Transformer的注意力机制

在生成每个Token时,自注意力机制会计算当前Token与上下文窗口中所有其他Token的关联度。这使得模型能够理解并记住当前窗口内词与词、句与句之间的关系。

上下文窗口的演进:

早期模型(如GPT-3): 窗口较小(2k/4k Token),只能记住很短的对话历史。现代模型(如GPT-4 Turbo, Claude 3): 窗口极大扩展(128k/200k Token),能处理数百页的文档,短记忆能力极大增强。

实现方式:

滑动窗口: 当对话长度超过窗口限制时,最早的信息会被丢弃。关键点: 无论上下文窗口多大,它始终是模型单次处理信息的固定工作内存,是短记忆的物理上限。

2. 长记忆的技术原理

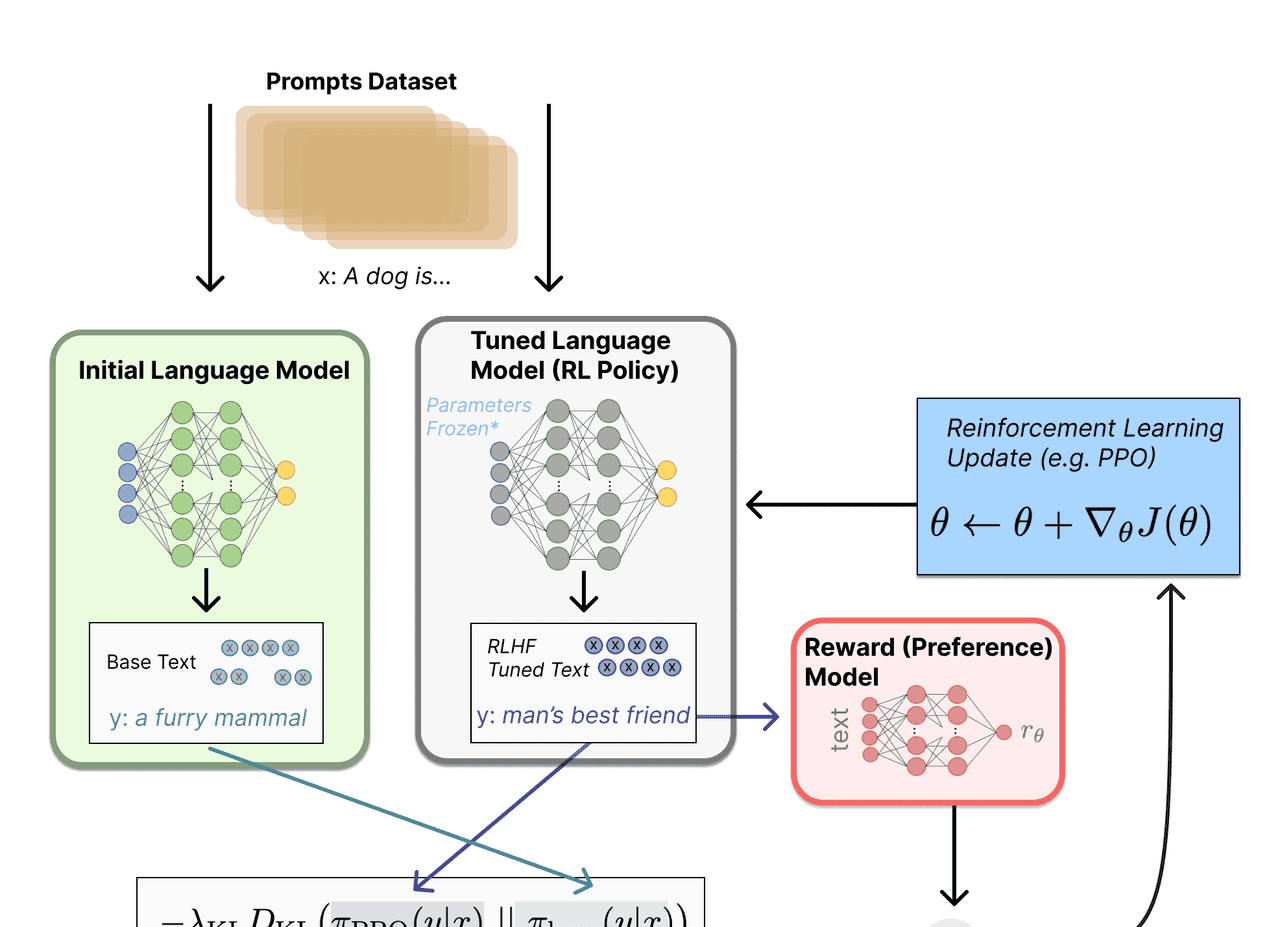

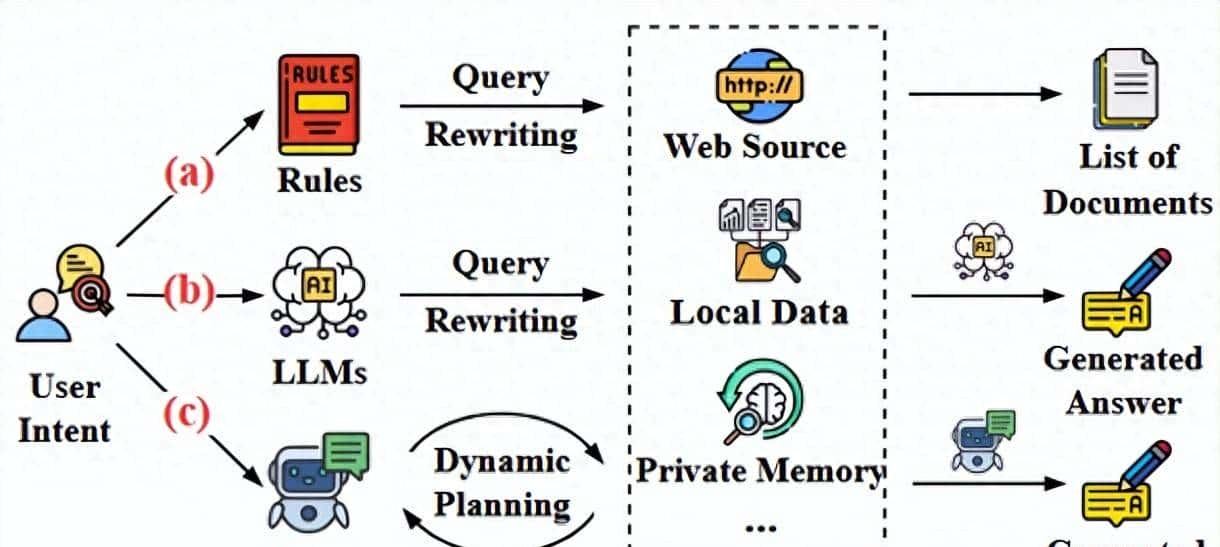

长记忆不是模型的内生能力,而是一套系统工程。其核心范式是 RAG。

RAG的工作流程完美诠释了长记忆的实现:

记忆存储:

知识库构建: 将需要被“长期记住”的知识(如公司文档、产品手册、用户对话历史)进行切分,并编码成向量,存入向量数据库。这一步相当于把知识写入“外部硬盘”。

记忆检索:

当用户提出新问题时,系统将问题也编码成向量。在向量数据库中进行相似度搜索,找到与当前问题最相关的知识片段。这一步相当于从“外部硬盘”中调取相关的记忆。

记忆唤醒与合成:

将检索到的知识片段(长记忆)与用户当前的问题(短记忆的引子)一起组合成一个新的、信息增强的提示,送给大模型。大模型基于这个包含“背景信息”的提示来生成回答。此时,外部长记忆被注入到本次推理的上下文窗口中,转化成了模型的短记忆。

其他长记忆技术方案:

微调:

原理: 使用特定的数据集对模型权重进行调整,将知识“熔断”到模型参数中。类比: 像是一种“肌肉记忆”,通过反复练习让模型掌握某种知识或风格。缺点: 知识更新成本高,容易发生遗忘,无法记忆动态的、个性化的信息。

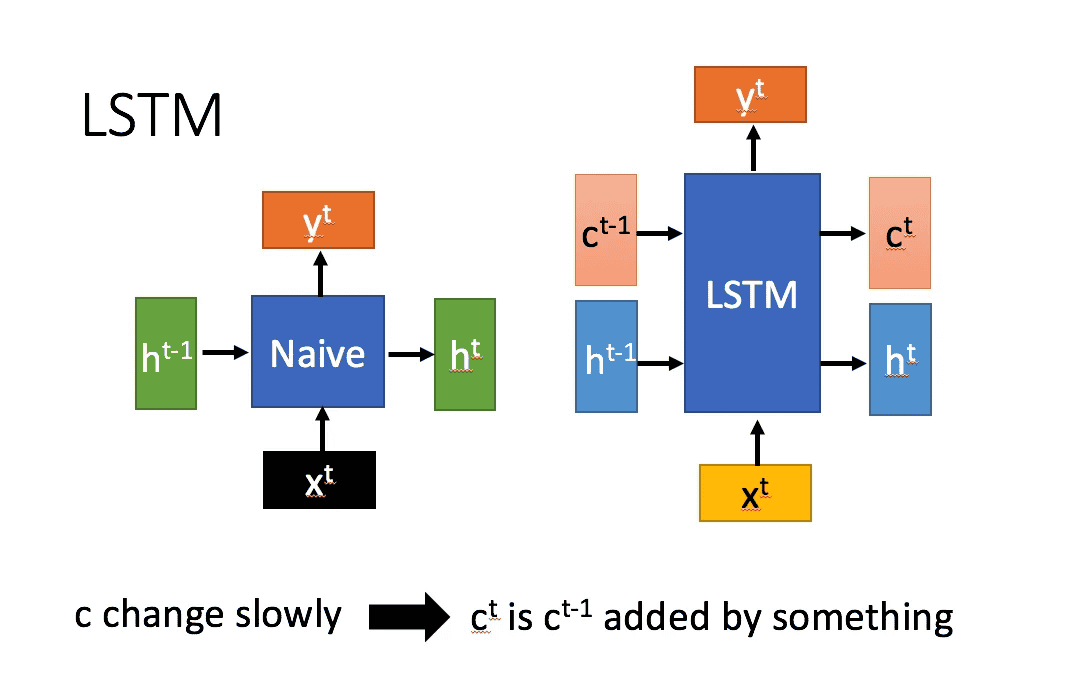

架构改进:

递归机制: 让模型能够处理无限长的序列,但训练复杂,效果不稳定。外部记忆模块: 为模型显式地设计一个可读写的记忆单元,仍是前沿研究领域。

三、应用场景对比

| 记忆类型 | 核心技术 | 应用场景 | 优点 | 缺点 |

|---|---|---|---|---|

| 短记忆 | 大上下文窗口 | 1. 长文档摘要/QA:一次性处理整本书或长报告。 2. 复杂代码编写:在单个会话中维护完整的代码文件结构。 3. 多轮对话:在同一聊天窗口内保持对话连贯性。 |

1. 简单直接,无需额外工程。 2. 信息保真度高,模型能直接理解全部上下文。 |

1. 容量有限,受上下文窗口限制。 2. 无法跨会话,关闭窗口即“失忆”。 |

| 长记忆 | RAG | 1. 智能客服/问答:基于不断更新的产品文档回答用户问题。 2. 企业知识库:员工可查询公司制度、项目历史等。 3. 个性化AI助手:记住用户的偏好、历史记录,提供定制化服务。 |

1. 记忆容量无限。 2. 知识可动态更新,成本低。 3. 来源可追溯,答案更可信。 |

1. 系统复杂,需要额外的数据管道和检索系统。 2. 检索质量直接影响最终效果。 |

| 长记忆 | 微调 | 1. 专业领域模型:打造法律、医疗等领域的专家模型。 2. 风格模仿:让模型学会特定的写作或对话风格。 3. 任务定制:优化模型在特定任务(如代码生成)上的表现。 |

1. 响应速度快,无需检索步骤。 2. 深度整合,模型输出更自然。 |

1. 无法记忆动态信息。 2. 训练成本高,更新不灵活。 3. 可能导致“知识灾难性遗忘”。 |

四、总结与趋势

分工明确:

短记忆 是模型的“工作记忆”,负责处理当前任务的上下文。长记忆 是模型的“外部知识库”,负责存储和提供历史与背景知识。

组合使用是王道:

最先进的AI应用通常会同时利用两者。例如,一个个性化AI助手会:

使用 RAG 从你的历史记录中检索相关信息(长记忆)。将这些信息与你的当前问题一起,放入一个巨大的上下文窗口中,进行复杂的推理和对话(短记忆)。可能还经过微调,以更好地适应助手的对话风格。

未来趋势:

上下文窗口持续扩大,短记忆能力越来越强。RAG技术不断成熟,检索更精准、系统更高效,成为长记忆的标配解决方案。智能体架构会赋予模型主动管理、读写长记忆的能力,使其更像一个拥有“记忆”的智能体。

简单来说,让大模型拥有“记忆”的关键,不在于改变模型本身,而在于为它设计一个强大的“外部大脑”(如向量数据库),并通过高效的“神经链接”(RAG)在需要时为其注入信息。

暂无评论内容