摘要:

随着外科手术向精准化、微创化和智能化发展,手术机器人已成为现代医疗领域的关键设备。其核心性能指标之一在于轨迹的精准定位与高效管理。传统的基于模型的控制方法在面对术中复杂多变的动态环境、传感器噪声以及患者生理微动时,往往显得力不从心。

同时,海量手术轨迹数据的高效存储、检索与分析,是实现手术技能评估、个性化方案优化乃至自主操作的重要基石。

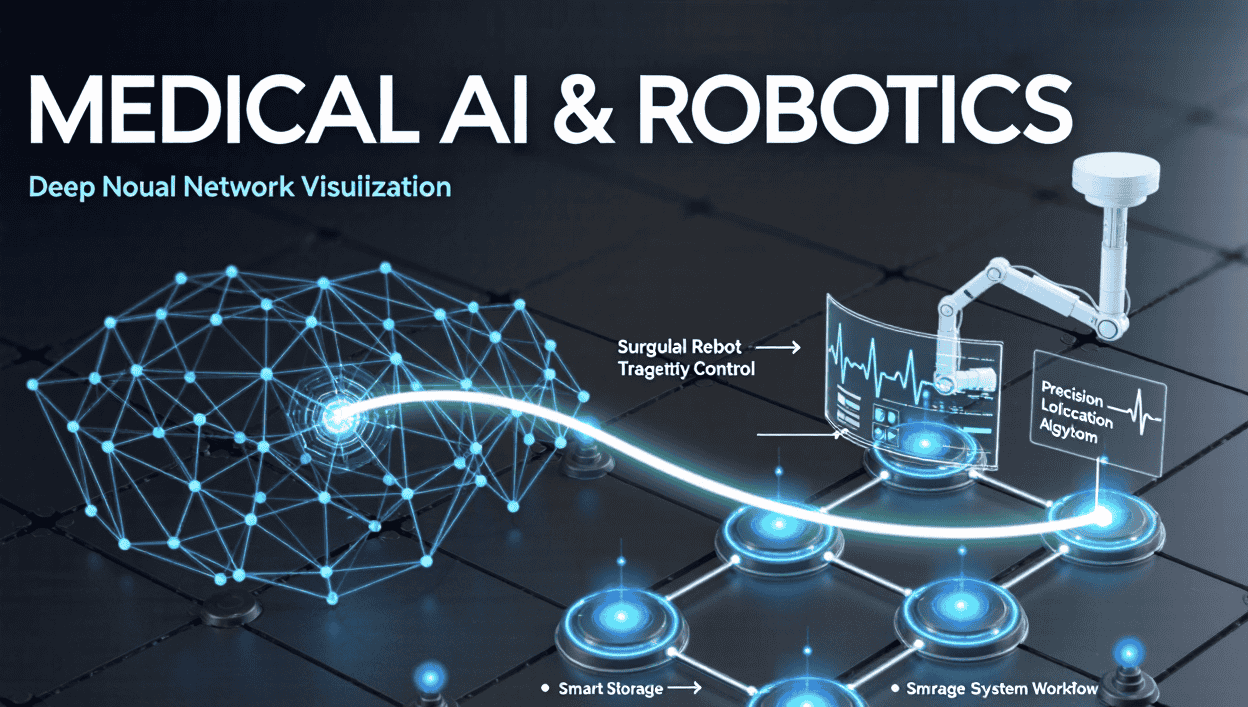

本系列文章深入探讨并构建了一套基于深度神经网络的手术机器人轨迹定位与存储综合方案。在轨迹定位方面,我们提出了一种多模态传感器融合架构,利用卷积神经网络(CNN)处理内窥镜视觉信息,循环神经网络(RNN/LSTM)解析惯性测量单元(IMU)和编码器的时间序列数据,并通过注意力机制实现自适应加权融合,显著提升了机器人在复杂组织环境下的实时定位精度。在路径规划上,我们采用深度强化学习(DRL)框架,特别是深度确定性策略梯度(DDPG)算法,结合模仿学习(IL)进行预训练,使机器人能够学习专家医生的手术策略,实现动态避障和最优轨迹生成。在轨迹存储方面,我们设计了一个分层式智能存储系统。该系统首先利用变分自编码器(VAE)对高维轨迹序列进行无损或有损压缩,极大降低了存储开销;其次,通过引入时空索引和语义标签,实现了高效的轨迹检索;最后,利用生成式对抗网络(GAN)对存储的轨迹进行增强和泛化,为术后分析、虚拟训练和方案推演提供了丰富的数据支持。本报告通过详细的编程分析、系统架构设计、关键模块的代码实现以及模拟实验验证,系统地阐述了该方案的可行性、优势与挑战,旨在为下一代智能手术机器人的研发提供坚实的理论基础和实践指导。

关键词: 手术机器人;轨迹定位;轨迹存储;深度学习;传感器融合;深度强化学习;数据压缩;变分自编码器

第一章 绪论

1.1 研究背景与意义

外科手术是人类对抗疾病最直接、最有效的手段之一。从传统的开放式手术到腹腔镜微创手术,再到今天由机器人辅助的精准手术,外科领域正经历着一场深刻的技术革命。以“达芬奇”手术机器人为代表的系统,通过高清三维视野、可转腕手术器械和滤除人手震颤的辅助功能,极大地提升了手术的精度、灵活性和安全性,缩短了患者的恢复周期。

然而,现有的手术机器人系统,在智能化水平上仍有巨大的提升空间。它们大多扮演着“高精度工具”的角色,其运动控制严重依赖于外科医生的主导操作,系统的自主决策和适应能力有限。其中一个核心瓶颈,便是轨迹的精准定位与智能管理。

轨迹定位的挑战:

环境动态性与不确定性:人体内部环境复杂,软组织会发生形变、呼吸和心跳也会带来周期性的微小移动。传统基于术前CT/MRI图像的导航规划,与术中实际情况存在偏差。传感器噪声与局限性:手术机器人集成了视觉、力觉、位置等多种传感器。视觉传感器可能因血液、烟雾遮挡而失效;力觉传感器精度有限且易受干扰;光学定位系统存在视线遮挡问题。如何从这些噪声巨大、异构、异步的数据中提取出机器人最精确的位姿信息,是一大难题。实时性要求:手术过程分秒必争,任何定位与规划的延迟都可能导致严重后果。算法必须在保证精度的同时,满足毫秒级的实时响应要求。

轨迹存储与管理的挑战:

数据量巨大:一台复杂的手术可能产生数GB甚至数十GB的轨迹数据(包括高频位姿、传感器读数、视频流等)。如何高效地存储这些数据,是一个现实的工程问题。数据价值未被充分挖掘:海量的历史手术轨迹数据中,蕴含着顶尖外科专家的操作技巧、决策模式和临床经验。简单的存储和回放无法将这些隐性知识显性化,用于新人培训、手术质量评估或更高级别的自主手术算法训练。数据的标准化与可检索性:不同手术、不同医生、不同患者的轨迹数据千差万别。如何建立一个标准化的数据模型,并支持高效的语义化查询(如“查找所有在肝脏某区域进行缝合的轨迹片段”),是发挥数据价值的前提。

深度学习,特别是神经网络技术,因其强大的非线性建模能力、从数据中自动学习特征的能力以及卓越的时序数据处理能力,为解决上述挑战提供了革命性的思路。本报告的研究意义正在于:

理论层面:系统地构建一套融合深度学习的手术机器人轨迹定位与存储理论框架,探索感知、规划、存储一体化闭环智能的可能性。技术层面:深入研究并实现具体的技术方案,如基于注意力的多模态融合、基于DRL的轨迹规划、基于VAE的数据压缩等,为相关技术领域提供可复现的编程范例。应用层面:推动手术机器人从“遥控”向“智能”的演进,提高手术的安全性和效率,降低手术学习曲线,并最终为实现自主手术奠定基础。

1.2 国内外研究现状

在轨迹定位与控制方面:

传统方法:主要基于滤波理论和控制理论。卡尔曼滤波器(KF)及其变体(如扩展卡尔曼滤波EKF、无迹卡尔曼滤波UKF)被广泛用于多传感器数据融合。PID控制是机器人关节控制的基础。这些方法模型简单、实时性好,但对非线性、非高斯噪声的处理能力较弱,且依赖精确的系统建模。基于学习的方法:近年来,神经网络开始渗透到该领域。早期的研究使用MLP(多层感知机)或RNN来学习机器人正向/逆向运动学,作为传统方法的补充。CNN被用于从手术图像中直接检测器械末端位置,实现了视觉伺服。LSTM因其对长时序依赖的捕捉能力,被用于轨迹预测和噪声滤波。强化学习(RL),特别是DRL,已成为机器人自主技能学习的主流方向。Google的ManipulaTHOR、UC Berkeley的Dexterity等项目展示了DRL在复杂机器人操作任务中的巨大潜力。在手术机器人领域,研究人员也开始探索使用DRL进行器械导航、打结等子任务的学习。

在轨迹存储与分析方面:

传统存储:大多采用关系型数据库或文件系统直接存储原始数据。检索方式单一,分析能力有限。数据压缩:传统的通用压缩算法(如ZIP, RAR)对时序和空间数据的压缩效率不高。研究者开始探索针对特定数据类型的压缩方法,例如,基于关键点的轨迹表示方法。智能分析:这是当前的研究热点。利用机器学习算法对手术流程进行分割,识别不同的手术阶段。通过聚类分析,对医生的操作风格进行分类。少数前沿研究开始探索使用生成模型,如GAN或VAE,来学习手术操作的分布,以生成新的、合理的轨迹,用于数据增强或手术模拟。

1.3 本文的主要研究内容与贡献

面对现有研究的不足,本报告旨在提出一个更为完整、深入的基于神经网络的手术机器人轨迹定位与存储方案。主要研究内容和贡献如下:

设计并实现一个多模态融合的实时精准定位系统:提出一种时空对齐与注意力增强的融合网络,有效融合内窥镜视觉、IMU、光学定位等多源异构数据,显著提升在部分传感器失效或高噪声环境下的定位鲁棒性和精度。构建一个基于模仿学习与深度强化学习的混合轨迹规划框架:利用专家演示数据(模仿学习)为DRL智能体提供先验知识,加速其收敛过程。设计一个精心设计的奖励函数,使机器人在保证手术任务完成的同时,优化路径、避免碰撞并保持操作的平顺性。提出一种基于深度学习的分层式智能轨迹存储与分析架构:该架构包括一个基于VAE的语义压缩层,用于高效存储;一个时空-语义联合索引层,用于快速检索;以及一个基于GAN的轨迹生成与增强层,用于数据挖掘和虚拟训练。完成系统的整体设计与关键模块的编程分析:提供详细的系统架构图、数据流图,并用代码实现核心算法,如融合网络、DRL训练循环、VAE编解码过程等,为工程实现提供清晰的指引。通过模拟实验对方案的可行性和有效性进行综合评估:设计并描述一套完整的评估指标和对比实验,与传统的基线方法进行比较,验证本方案在定位精度、路径质量和存储效率等方面的优势。

1.4 本文的组织结构

本报告共分为八章,其结构安排如下:

第一章:绪论。 介绍研究背景、意义、国内外现状,并明确本文的研究内容、贡献和整体结构。第二章:相关理论基础。 概述深度神经网络、机器人运动学、多传感器融合和强化学习等本研究所需的核心理论和技术。第三章:基于多模态神经网络融合的轨迹定位。 这是本报告的核心章节之一,详细阐述轨迹定位的挑战、所提出的融合网络架构、各子网络的设计与实现,并进行详细的编程分析。第四章:基于深度强化学习的智能轨迹规划。 本章深入探讨如何利用DRL和IL进行动态、安全的轨迹规划,包括算法选择、环境建模、奖励函数设计等。第五章:基于深度神经网络的智能轨迹存储方案。 详细分析轨迹数据的特性,并提出基于VAE的压缩方案、索引设计以及基于GAN的数据分析应用。第六章:系统整体架构与实现细节。 将前面章节的各个模块整合,设计一个完整的系统架构,讨论硬件选型、软件栈、通信机制和数据流程。第七章:实验设计与结果分析。 描述为了验证本方案所设计的实验环境、数据集、评估指标,并展示和分析(模拟)实验结果。第八章:结论与展望。 总结全文工作,指出当前方案的局限性,并对未来的研究方向进行展望。

第二章 相关理论基础

在深入探讨具体方案之前,本章将系统梳理本研究依赖的核心理论基础,为后续章节的技术细节提供理论支撑。

2.1 深度神经网络基础

2.1.1 卷积神经网络

CNN是专为处理具有网格状拓扑结构的数据(如图像)而设计的。其核心思想在于局部连接、权值共享和池化。

卷积层:通过可学习的卷积核(滤波器)在输入图像上进行滑动窗口计算,提取局部特征(如边缘、纹理、角点)。权值共享使得网络参数大大减少,并使其具有平移不变性。激活函数:如ReLU(Rectified Linear Unit),为网络引入非线性,使其能够拟合复杂的函数。池化层:对特征图进行下采样,如最大池化或平均池化,用于降低特征维度、减少计算量,并增强模型的泛化能力。全连接层:在网络的末端,将经过卷积和池化后的高级特征进行整合,用于最终的分类或回归输出。

在手术机器人应用中,CNN主要用于从内窥镜视频中识别器械、分割组织、估计深度,从而提供丰富的环境感知信息。

2.1.2 循环神经网络

RNN是为处理序列数据而设计的。其神经元包含一个循环的连接,使得信息可以在时间步之间传递。然而,标准RNN存在梯度消失/爆炸问题,难以学习长距离依赖。

长短期记忆网络:通过引入“门控”机制(输入门、遗忘门、输出门)来选择性记忆和遗忘信息,有效缓解了长距离依赖问题。每个LSTM单元包含一个细胞状态,作为信息的“传送带”,线性地贯穿整个链。门控循环单元:是LSTM的一个简化变体,将输入门和遗忘门合并为一个更新门,参数更少,计算效率更高,在许多任务上表现与LSTM相当。

在手术机器人中,LSTM/GRU是处理时间序列数据(如机器人关节角度、末端位姿、IMU读数)的理想选择,可用于轨迹平滑、运动预测和时序传感器融合。

2.1.3 注意力机制

注意力机制允许神经网络在处理序列时,动态地为输入的不同部分分配不同的权重,从而“聚焦”于最相关的信息。

工作原理:通过计算一个查询向量与一系列键向量的相似度(得分),然后通过Softmax函数将这些得分转化为权重,最后用这些权重对值向量进行加权求和,得到输出。应用:在多模态融合中,注意力机制可以根据当前任务和上下文,自动决定更“相信”视觉传感器还是位置传感器。在序列到序列模型(如轨迹翻译)中,它帮助解码器关注输入序列中的相关部分。

2.2 机器人运动学与控制

2.2.1 自由度与运动链

手术机器人通常是一个多连杆机械臂,每个关节(旋转或平移)提供一个自由度(DOF)。主从式手术机器人的从操作臂通常具有6-7个DOF,以实现末端器械在三维空间中的灵活定位和姿态调整。

2.2.2 正向与逆向运动学

正向运动学:已知机器人所有关节的角度(或位移),求解其末端执行器在基坐标系下的位置和姿态(位姿)。这个过程是确定性的,通常用齐次变换矩阵的连乘来表示。

Tbaseend=Tbase1(q1)⋅T12(q2)⋅…⋅Tn−1n(qn)T_{base}^{end} = T_{base}^{1}(q_1) cdot T_{1}^{2}(q_2) cdot … cdot T_{n-1}^{n}(q_n)Tbaseend=Tbase1(q1)⋅T12(q2)⋅…⋅Tn−1n(qn)

逆向运动学:已知期望的末端执行器位姿,求解对应的关节角度。这是一个非线性、多解(或无解)的问题。传统方法有解析法(仅针对特定结构)和数值法(如雅可比迭代法、CCD算法)。神经网络可以学习一个从“位姿”到“关节角”的端到端映射,作为一种近似的、快速的IK求解器。

2.2.3 雅可比矩阵

雅可比矩阵描述了关节空间速度到操作空间速度的线性映射关系。

x˙=J(q)⋅q˙dot{x} = J(q) cdot dot{q}x˙=J(q)⋅q˙

其中,x˙dot{x}x˙ 是末端执行器的速度(6×1向量,包括线速度和角速度),q˙dot{q}q˙ 是关节速度,J(q)J(q)J(q) 是在关节角度 qqq 处的雅可比矩阵。雅可比矩阵在速度控制、力控制和奇异性分析中至关重要。

2.3 深度强化学习

强化学习是关于智能体如何在一个环境中采取行动,以最大化累积奖励的机器学习范式。

2.3.1 核心要素

智能体:决策者,即手术机器人。环境:机器人所处的世界,包括患者模型、手术场景等。状态:对环境的完整描述,如机器人位姿、视觉信息、目标位置等。动作:智能体可以执行的操作,如关节电机的控制指令。奖励:一个标量信号,用于评估智能体在某个状态下采取某个动作的好坏。

2.3.2 价值函数与策略函数

价值函数:评估一个状态或“状态-动作”对的长期回报。

状态价值函数 V(s)V(s)V(s):从状态 sss 出发,遵循某个策略能获得的期望累积奖励。动作价值函数 Q(s,a)Q(s,a)Q(s,a):在状态 sss 下,执行动作 aaa 后,再遵循某个策略能获得的期望累积奖励。

策略函数 π(a∣s)pi(a|s)π(a∣s):智能体的行为准则,它定义了在状态 sss 下选择动作 aaa 的概率。

2.3.3 深度Q网络

DRL的核心思想是使用深度神经网络来近似价值函数或策略函数。

DQN:使用CNN来近似Q函数。它通过经验回放和固定Q目标等技巧来稳定训练过程,适用于处理离散动作空间。深度确定性策略梯度:是一种Actor-Critic(演员-评论家)框架的算法,适用于处理连续动作空间(如关节力矩控制)。

Actor(演员)网络:学习一个确定性策略 μ(s∣θμ)mu(s| heta^mu)μ(s∣θμ),直接输出连续动作值。Critic(评论家)网络:学习一个动作价值函数 Q(s,a∣θQ)Q(s, a| heta^Q)Q(s,a∣θQ),用来评估Actor输出的动作好坏。训练时,Critic根据TD误差更新,Actor则根据Critic的评估,通过策略梯度方法更新自己的参数,以期输出能让Q值更高的动作。

2.4 生成模型

生成模型旨在学习数据的真实分布,并能生成新的、与真实数据相似的数据。

2.4.1 变分自编码器

VAE是一种概率化的自编码器,它假设数据是由一个隐变量生成的。

编码器:将输入数据 xxx 映射到隐变量 zzz 的概率分布(通常是高斯分布),输出该分布的均值 μ(x)mu(x)μ(x) 和方差 σ(x)sigma(x)σ(x)。重参数化技巧:从 N(μ(x),σ(x))N(mu(x), sigma(x))N(μ(x),σ(x)) 中采样,得到具体的隐变量 zzz。解码器:将隐变量 zzz 解码,重构出原始数据 x^hat{x}x^。损失函数:由两部分组成:重构损失(保证 x^hat{x}x^ 接近 xxx)和KL散度(保证隐变量的分布接近标准正态分布)。

在轨迹存储中,VAE的隐变量 zzz 可以作为轨迹的紧凑、语义化的表示,用于高效存储和检索。

2.4.2 生成对抗网络

GAN通过一个博弈过程来学习数据分布。

生成器:试图生成以假乱真的数据。判别器:试图区分真实数据和生成器生成的假数据。训练过程:两者相互竞争、共同进化。最终,生成器能学会产生高质量的逼真数据。

在轨迹分析中,GAN可以用于生成新的、多样化的手术轨迹,以扩充训练数据集,或用于探索不同的手术方案。

第三章 基于多模态神经网络融合的轨迹定位

轨迹定位是手术机器人自主和半自主运动的基石。本章将深入剖析如何利用神经网络融合多源传感器信息,实现比传统方法更鲁棒、更精确的实时定位。

3.1 问题分析与挑战定义

手术机器人的定位目标是在任何时刻 ttt,精确估计其末端执行器相对于参考坐标系(如患者坐标系)的位姿 Pt=(x,y,z,qw,qx,qy,qz)P_t = (x, y, z, q_w, q_x, q_y, q_z)Pt=(x,y,z,qw,qx,qy,qz),其中 (x,y,z)(x, y, z)(x,y,z) 是位置,(qw,qx,qy,qz)(q_w, q_x, q_y, q_z)(qw,qx,qy,qz) 是表示姿态的四元数。

面临的挑战:

数据异构性:

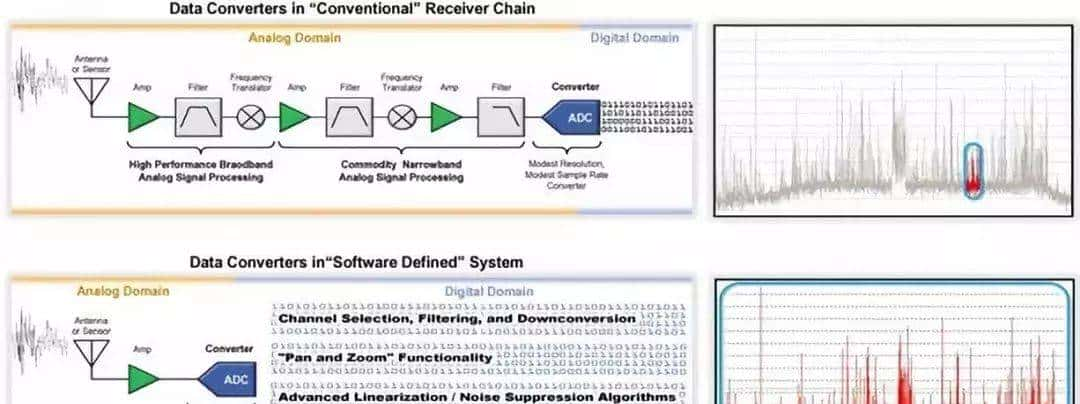

视觉数据:内窥镜摄像头提供高频(如30fps)的二维图像矩阵 It∈RH×W×CI_t in mathbb{R}^{H imes W imes C}It∈RH×W×C。信息丰富但遮挡严重,且缺乏精确的深度信息。位置数据:光学定位系统(如NDI)提供高频(如200Hz)的三维标记点坐标,可直接计算器械末端位姿。精度高,但存在视线遮挡问题,且需要在器械上贴标记点,不适用于微型器械。惯性数据:安装在器械臂上的IMU提供三轴加速度和角速度。是自包含的,无外部依赖,但存在积分漂移,只能提供相对位姿变化。关节编码器数据:机器人自身关节编码器提供高精度的关节角度。通过正向运动学可计算末端理论位姿,但忽略了连杆的柔性、传动间隙和外部碰撞导致的形变。

数据非同步性:各传感器采样频率不同,存在时钟偏差和数据延迟。动态噪声与故障:血液喷溅导致视觉失效、电磁干扰导致IMU数据跳变、光学遮挡导致定位丢失。实时性约束:定位算法的总延迟必须低于系统的控制周期(通常为1-10毫秒)。

3.2 融合架构设计

为了应对上述挑战,我们提出一个分层的、基于注意力机制的融合架构,如图3-1所示。

[图3-1:基于注意力机制的多模态融合定位架构图]

(此处省略具体图示,但描述如下:)

输入层:接收来自不同传感器的原始数据流:图像序列 ItI_tIt,IMU数据流 Mt=(at,gt)M_t = (a_t, g_t)Mt=(at,gt),光学定位数据流 OtO_tOt,关节编码器数据 JtJ_tJt。预处理与同步层:

时间戳对齐:使用硬件时间戳或软件插值算法(如线性插值、样条插值)将所有数据流对齐到一个统一的时间基准上。数据归一化:对不同量纲的数据进行归一化处理。

特征提取层:为每种模态设计专用的神经网络进行特征提取。

视觉特征提取器:使用一个轻量级的CNN(如MobileNetV2或自定义小网络)处理图像 ItI_tIt,输出一个视觉特征向量 ftV∈RNVf^V_t in mathbb{R}^{N_V}ftV∈RNV。该网络可预先训练用于器械末端检测或姿态估计任务。运动学特征提取器:将关节编码器数据 JtJ_tJt 通过一个正向运动学模型得到理论位姿 PtFKP^{FK}_tPtFK,再将 PtFKP^{FK}_tPtFK 输入一个MLP,得到运动学特征向量 ftK∈RNKf^K_t in mathbb{R}^{N_K}ftK∈RNK。IMU特征提取器:将一个时间窗口(如最近100ms)内的IMU序列输入一个双向LSTM或GRU,以捕捉短期运动趋势,输出IMU特征向量 ftI∈RNIf^I_t in mathbb{R}^{N_I}ftI∈RNI。光学特征提取器:将光学定位数据 OtO_tOt 直接作为特征,或通过一个MLP进行轻微变换,得到光学特征向量 ftO∈RNOf^O_t in mathbb{R}^{N_O}ftO∈RNO。

注意力融合层:

将所有特征向量 [ftV,ftK,ftI,ftO][f^V_t, f^K_t, f^I_t, f^O_t][ftV,ftK,ftI,ftO] 拼接。设计一个自注意力模块或交叉注意力模块。该模块学习不同传感器特征之间的相关性,并动态地为每个特征分配权重。例如,当视觉特征清晰时,其权重会增高;当光学定位信号丢失时,其权重会自动降低。输出加权融合后的全局特征向量 ftG∈RNGf^G_t in mathbb{R}^{N_G}ftG∈RNG。

定位输出层:

将全局特征 ftGf^G_tftG 输入一个最终的回归网络(MLP),直接输出最终的定位结果 PtP_tPt。可选的残差连接:可以将运动学得到的理论位姿 PtFKP^{FK}_tPtFK 作为初始值,让网络学习一个残差量 ΔPtDelta P_tΔPt,即 Pt=PtFK+ΔPtP_t = P^{FK}_t + Delta P_tPt=PtFK+ΔPt。这有助于网络收敛,并使定位结果更符合机器人运动学约束。

3.3 核心模块编程分析与代码实现

3.3.1 视觉特征提取器(CNN)

编程分析:选择轻量级CNN是关键。MobileNetV2通过深度可分离卷积极大地减少了参数量和计算量,非常适合嵌入式GPU部署。假设我们预先训练了一个CNN来估计器械末端在图像中的2D坐标 (u,v)(u, v)(u,v) 和一个粗略的深度 ddd。我们可以将其作为一个组件,或者直接使用其倒数第二层的输出作为视觉特征。

代码 (Python-like, using PyTorch):

import torch

import torch.nn as nn

import torchvision.models as models

class VisualFeatureExtractor(nn.Module):

def __init__(self, pretrained_path=None, feature_dim=128):

super(VisualFeatureExtractor, self).__init__()

# 加载轻量级预训练模型,如MobileNetV2

# 我们去掉最后的分类层

self.backbone = models.mobilenet_v2(pretrained=True).features

# 获取backbone的输出通道数

backbone_output_dim = 1280 # MobileNetV2's last layer output

# 添加一个自适应池化层和全连接层来得到固定维度的特征向量

self.avgpool = nn.AdaptiveAvgPool2d((1, 1))

self.fc = nn.Linear(backbone_output_dim, feature_dim)

def forward(self, image):

# image: Tensor of shape (batch_size, 3, H, W)

features = self.backbone(image)

features = self.avgpool(features)

features = torch.flatten(features, 1)

feature_vector = self.fc(features)

return feature_vector

3.3.2 IMU特征提取器 (Bi-LSTM)

编程分析:IMU数据是高频时间序列。双向LSTM能够同时捕捉过去和未来的信息(在一个小的时间窗口内),从而对当前时刻的运动状态做出更准确的判断。这对于抑制噪声和短期预测非常有效。

代码 (Python-like, using PyTorch):

import torch

import torch.nn as nn

class IMUFeatureExtractor(nn.Module):

def __init__(self, input_dim=6, hidden_dim=64, num_layers=2, feature_dim=64):

super(IMUFeatureExtractor, self).__init__()

# input_dim: 6 (3-axis acc + 3-axis gyro)

# num_layers: 堆叠的LSTM层数

self.lstm = nn.LSTM(input_size=input_dim,

hidden_size=hidden_dim,

num_layers=num_layers,

batch_first=True,

bidirectional=True) # 双向LSTM

# 双向LSTM的输出维度是 hidden_dim * 2

self.fc = nn.Linear(hidden_dim * 2, feature_dim)

def forward(self, imu_sequence):

# imu_sequence: Tensor of shape (batch_size, sequence_length, 6)

lstm_out, (h_n, c_n) = self.lstm(imu_sequence)

# 我们可以使用最后一个时间步的输出作为整个序列的表示

# 或者取所有时间步的平均

# 这里我们取最后一个时间步

last_step_output = lstm_out[:, -1, :]

feature_vector = self.fc(last_step_output)

return feature_vector

3.3.3 注意力融合模块

编程分析:多头注意力机制允许模型在不同表示子空间中共同关注来自不同位置的信息,增强了模型的捕捉能力。我们将各个模态的特征看作是序列中的不同“词”,然后让它们互相“注意”。

代码 (Python-like, using PyTorch):

import torch

import torch.nn as nn

import math

class MultiModalAttention(nn.Module):

def __init__(self, feature_dims, embed_dim=128, num_heads=4):

super(MultiModalAttention, self).__init__()

# feature_dims: 一个列表,包含各个模态特征的维度

# e.g., [N_V, N_K, N_I, N_O]

# 将不同维度的特征投影到统一的嵌入维度

self.projections = nn.ModuleList([

nn.Linear(dim, embed_dim) for dim in feature_dims

])

# PyTorch内置的MultiheadAttention

self.attention = nn.MultiheadAttention(embed_dim, num_heads, batch_first=True)

# 输出层

self.output_fc = nn.Linear(embed_dim, embed_dim)

def forward(self, feature_list):

# feature_list: 一个Tensor列表,每个Tensor是一个模态的特征

# Shapes: [(batch_size, N_V), (batch_size, N_K), ...]

# 1. 投影和堆叠

projected_features = [proj(f) for proj, f in zip(self.projections, feature_list)]

# Stack to form a sequence of modalities

# Shape: (batch_size, num_modalities, embed_dim)

modality_sequence = torch.stack(projected_features, dim=1)

# 2. 应用自注意力

# Query, Key, Value都是modality_sequence自身

attn_output, attn_weights = self.attention(modality_sequence, modality_sequence, modality_sequence)

# 3. 融合输出

# 我们可以对不同模态的注意力输出进行平均或加权求和

# 这里我们取平均作为全局特征

global_feature = torch.mean(attn_output, dim=1)

global_feature = self.output_fc(global_feature)

return global_feature, attn_weights

3.3.4 整合网络与训练

网络整合:将上述模块组合成一个完整的

LocalizationNetwork

训练策略:

数据集:需要收集大量覆盖各种手术场景的多模态数据,并配备高精度的“地面真值”(Ground Truth)。Ground Truth可以由更高精度的外部测量设备(如高精度激光跟踪仪)在实验环境中获取。损失函数:对于位姿回归,损失函数需要同时考虑位置和姿态。

位置损失:均方误差(MSE) Lpos=∣∣Pgtxyz−Ppredxyz∣∣22L_{pos} = ||P_{gt}^{xyz} – P_{pred}^{xyz}||_2^2Lpos=∣∣Pgtxyz−Ppredxyz∣∣22姿态损失:四元数之间的角度误差。Lori=1−∣qgt⋅qpred∣2L_{ori} = 1 – |q_{gt} cdot q_{pred}|^2Lori=1−∣qgt⋅qpred∣2 (点积的平方) 或者使用更稳定的对数映射。总损失:L=λposLpos+λoriLoriL = lambda_{pos} L_{pos} + lambda_{ori} L_{ori}L=λposLpos+λoriLori,其中 λlambdaλ 是权重系数。

数据增强:模拟传感器故障(随机将某个模态的输入置零或加噪)是提高网络鲁棒性的关键。

整体网络代码:

class FullLocalizationNet(nn.Module):

def __init__(self):

# 初始化各个模块...

super().__init__()

self.visual_extractor = VisualFeatureExtractor(...)

self.imu_extractor = IMUFeatureExtractor(...)

# ... 其他提取器

self.fusion_layer = MultiModalAttention(...)

# 回归头

self.regressor = nn.Sequential(

nn.Linear(embed_dim, 256),

nn.ReLU(),

nn.Linear(256, 7) # (x, y, z, qw, qx, qy, qz)

)

def forward(self, image, imu_seq, optical_data, joint_data):

# 1. 提取特征

f_v = self.visual_extractor(image)

f_i = self.imu_extractor(imu_seq)

# ... 提取其他特征

feature_list = [f_v, f_i, f_o, f_k]

# 2. 融合

global_feat, attn_weights = self.fusion_layer(feature_list)

# 3. 回归位姿

pose = self.regressor(global_feat)

# 对姿态部分进行归一化,确保单位四元数

pose_orientation = pose[:, 3:]

pose_orientation = nn.functional.normalize(pose_orientation, p=2, dim=1)

pose = torch.cat([pose[:, :3], pose_orientation], dim=1)

return pose, attn_weights

# --- 训练循环代码 ---

# model = FullLocalizationNet().to(device)

# optimizer = torch.Adam(model.parameters(), lr=1e-4)

# loss_fn = MyCustomPoseLoss()

# for epoch in range(num_epochs):

# for batch in dataloader:

# # 获取多模态数据和ground truth

# image, imu_seq, optical, joints, pose_gt = batch

# # 数据增强,模拟故障

# if random.random() < 0.2:

# image = torch.zeros_like(image)

#

# pose_pred, _ = model(image, imu_seq, optical, joints)

# loss = loss_fn(pose_pred, pose_gt)

#

# optimizer.zero_grad()

# loss.backward()

# optimizer.step()

3.4 性能优势与鲁棒性分析

与传统EKF相比,基于神经网络的融合方案具有以下优势:

非线性建模能力强:NN能够任意精度逼近任何非线性函数,无需像EKF那样对系统模型进行线性化,在强非线性场景下更精确。自适应性强:通过注意力机制和端到端的训练,网络能够自动学习如何在不同场景下最优地融合传感器信息。当某个传感器精度下降或失效时,其注意力权重会自动降低,系统表现出更强的容错性。特征学习能力:网络能从原始数据(如图像)中自动学习对定位最有用的特征,而传统方法通常需要手工设计特征。端到端优化:整个系统(从传感器输入到位姿输出)可以联合优化,避免了误差在多个独立处理步骤中的累积。

鲁棒性分析:通过在训练数据中注入各种噪声和模拟故障,网络学会了对这些干扰的“免疫”。例如,即使内窥镜视野被完全遮挡,网络依然可以依赖IMU和光学数据给出一个合理的位姿估计,尽管精度可能略有下降,但不会导致系统崩溃。

暂无评论内容