HBase与MLflow:模型管理与追踪系统的完美协作

关键词:HBase, MLflow, 模型管理, 模型追踪, 机器学习生命周期, 分布式存储, 实验复现

摘要:在机器学习项目中,“训练出模型”只是万里长征的第一步——如何记录实验过程、管理模型版本、存储海量训练数据和模型文件,才是让模型真正落地的关键。本文将带你认识两位”超级助手”:HBase(分布式数据”仓库管理员”)和MLflow(机器学习”实验日记本”)。我们会用生活化的比喻拆解它们的核心原理,展示它们如何分工协作:MLflow负责记录每次实验的”配方”(参数)和”味道”(指标),HBase则像超大号”冰箱”,安全存储所有实验”食材”(数据集)和”成品”(模型文件)。最终,你将学会如何将两者结合,搭建一个能支撑大规模机器学习项目的”模型管理与追踪系统”,让你的模型开发从”混乱厨房”变成”标准化工厂”。

背景介绍

目的和范围

想象你是一家面包店的研发总监,带领团队开发新口味面包。每天,团队会尝试不同的配方(面粉比例、发酵时间、温度),烤出不同的面包(模型),并记录口感评分(指标)。如果没有系统管理,你可能会遇到:

记不清上周”蜂蜜全麦面包”用的发酵时间是2小时还是3小时(实验参数丢失);冰箱里堆满了没贴标签的面团(模型版本混乱);老板问”为什么这款面包成本比上个月高”时,你翻遍笔记本也找不到原料采购记录(数据不可追溯)。

机器学习项目也是如此:数据科学家每天运行上百次实验,调整参数、更换数据集、训练不同模型。如果缺乏管理,会导致实验结果无法复现、模型版本混乱、大规模模型/数据存储困难等问题。

本文的目的就是解决这些痛点:我们将介绍如何用HBase(分布式列式数据库)和MLflow(机器学习生命周期管理工具)搭建”模型管理与追踪系统”,让实验过程可记录、模型版本可控制、数据文件可存储,最终实现机器学习项目的”标准化生产”。

范围:本文不深入HBase的底层分布式原理或MLflow的源码实现,而是聚焦两者的”协作模式”——如何让MLflow的实验追踪能力与HBase的海量存储能力结合,解决实际项目中的模型管理问题。

预期读者

本文适合三类读者:

数据科学家:想让自己的实验过程更规范,结果可复现;机器学习工程师:需要搭建模型管理平台,支撑团队协作;技术管理者:想了解如何通过工具链提升ML项目效率。

无论你是刚接触机器学习工程的新手,还是有经验的开发者,都能通过本文掌握”模型管理与追踪”的核心思路和实操方法。

文档结构概述

本文将按”问题→工具→协作→实战”的逻辑展开:

背景介绍:为什么需要模型管理与追踪?核心概念:HBase和MLflow是什么?它们的”超能力”在哪里?协作原理:两者如何分工协作,实现”实验记录+数据存储”一体化?实战案例:手把手教你搭建系统,用代码演示从实验到模型存储的全流程;应用场景与挑战:真实项目中如何落地?会遇到哪些坑?

术语表

核心术语定义

| 术语 | 通俗解释 | 专业定义 |

|---|---|---|

| HBase | 分布式”数据冰箱”,擅长存大量、结构灵活的数据 | 基于Hadoop的分布式列式存储数据库,支持高并发读写和海量数据存储 |

| MLflow | 机器学习”实验日记本”,记录每次实验的参数、指标和模型 | 开源机器学习生命周期管理平台,包含实验追踪、模型管理、项目打包等组件 |

| 模型管理 | 给模型”贴标签、建档案”,方便查找和复用 | 对模型的版本控制、元数据记录、部署状态追踪等全生命周期管理 |

| 模型追踪 | 记录模型”成长日记”:谁在什么时候用什么数据和参数训练了它 | 跟踪机器学习实验过程中的参数、指标、代码版本、数据集等信息,确保实验可复现 |

| 实验运行(Run) | 一次”烤面包尝试”:用特定配方(参数)烤出一个面包(模型) | MLflow中最小的实验单元,对应一次完整的模型训练过程,包含参数、指标、 artifacts 等 |

| Artifacts | 实验的”副产品”:配方单(代码)、面团(数据集)、成品面包(模型) | MLflow中存储的实验相关文件,如模型文件、数据集、日志等 |

相关概念解释

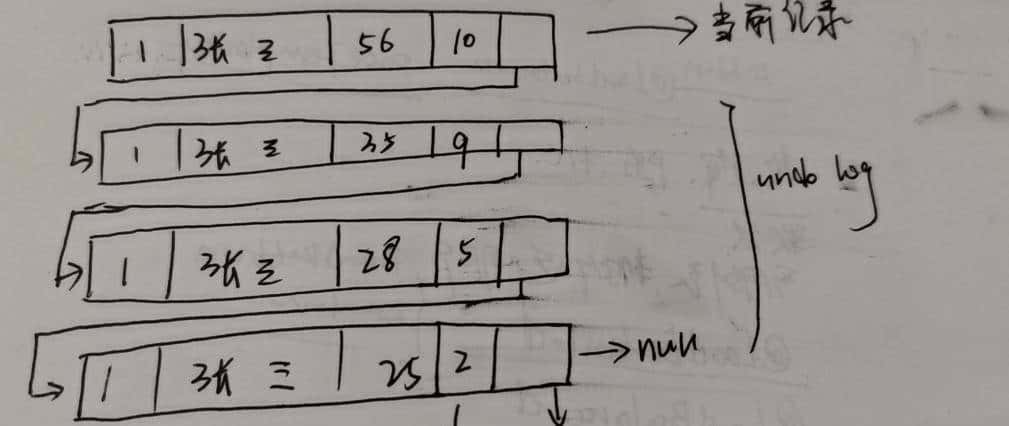

列式存储:HBase的”特殊收纳法”——按列而不是按行存数据。比如存学生信息时,”姓名列”单独放一个抽屉,”成绩列”放另一个抽屉,查成绩时不用翻整个抽屉,效率更高。模型版本控制:给每个模型”编学号”,比如V1.0、V2.1,避免”新版覆盖旧版,想回退却找不到”的问题。实验复现:用同样的”配方”(参数)和”食材”(数据),能烤出一模一样的”面包”(模型),这是科研和生产的基本要求。

缩略词列表

HBase:Hadoop Database(基于Hadoop的数据库)MLflow:Machine Learning Flow(机器学习流程)API:Application Programming Interface(应用程序接口,不同工具之间的”对话语言”)URI:Uniform Resource Identifier(统一资源标识符,定位网络资源的”地址”)JVM:Java Virtual Machine(Java虚拟机,HBase运行的环境)

核心概念与联系

故事引入:混乱的”机器学习厨房”与两位”救星”

小明是一家AI公司的数据科学家,团队正在开发一个”用户 churn 预测模型”(预测用户是否会流失)。三个月后,小明遇到了大麻烦:

老板问:”上周那个准确率85%的模型,用的是哪个版本的用户数据集?”小明翻遍聊天记录,只找到一个名为”final_data_v3_final.csv”的文件,但不确定是不是;新来的同事小李想复现小明的实验,结果调了两天参数,准确率始终差5%——原来小明当时用了”随机森林”,而小李默认用了”逻辑回归”,但没人记录这个细节;服务器上存了20多个”model.pkl”文件,分不清哪个是线上正在用的,哪个是测试版,上周不小心删了一个,导致线上模型无法更新。

小明的”机器学习厨房”彻底乱了套——就像没有收纳盒的冰箱,食材、半成品、成品堆在一起,标签混乱,找东西全靠运气。

这时,公司的架构师老王推荐了两位”救星”:

MLflow:像一本”智能实验日记本”,自动记录每次实验的”配方”(参数,如学习率、树的数量)、“火候”(训练过程,如每轮损失值)、“味道”(指标,如准确率、AUC),还能给每个模型贴标签(版本号);HBase:像一个”超大号智能冰箱”,专门存”实验食材”(大规模数据集)和”成品”(模型文件),支持快速查找(按模型ID、时间戳检索),还不怕断电(分布式存储,数据不丢失)。

有了这两位助手,小明的团队终于把”混乱厨房”改造成了”标准化工厂”——实验可复现,模型可追溯,存储不混乱。

核心概念解释(像给小学生讲故事一样)

核心概念一:HBase——分布式数据”仓库管理员”

HBase就像学校的”图书馆仓库”,有三个特别厉害的”超能力”:

“无限储物间”:普通冰箱只能存几百升东西,HBase可以存”无数本书”(PB级数据)。因为它是分布式的——就像一个图书馆有多个分馆,每个分馆负责一部分书籍,合起来就能存全世界的书。

“按列找书快”:普通仓库按”货架-行-列”存东西(比如A货架第3行第2列放苹果),HBase按”列族”分类——比如”学生信息馆”分”基本信息列族”(姓名、学号)和”成绩列族”(数学、语文),查成绩时直接去”成绩列族”找,不用翻整个仓库。

“标签永不丢”:每本书都有唯一的”索书号”(行键),比如”2023-10-01-model-001″(日期+模型ID),只要记住索书号,就能立刻找到书。而且HBase会自动备份——就像图书馆每本书都有复印件,即使原件丢了,复印件也能用。

生活例子:想象你是图书馆管理员,学生来借”2023年10月1日训练的 churn 预测模型V1″,你只要输入索书号”model_churn_20231001_v1″,HBase就会从”模型列族”的”文件数据列”中取出模型文件,3秒内送到学生手上。

核心概念二:MLflow——机器学习”实验日记本”

MLflow就像科学家的”实验记录本”,但它是”智能版”,能自动帮你记笔记,还能生成”实验报告”。它有四个主要”本子”:

Tracking(实验追踪本):记录每次实验的”原料”(参数,如学习率=0.01)、“过程”(指标,如训练10轮后准确率=82%)、“成品照片”( artifacts ,如模型文件路径、代码版本)。

Projects(项目打包本):把”实验步骤”写成”食谱”(MLproject文件),明确需要什么”厨具”(依赖库,如scikit-learn=1.2.2),别人按食谱做,就能做出一模一样的”菜”(复现实验)。

Models(模型登记本):给模型”办身份证”——记录模型版本(V1、V2)、描述(“用用户行为数据训练的 churn 模型”)、状态(“开发中”、“已上线”),还能管理模型的”家属”(依赖环境、输入输出格式)。

Registry(模型仓库本):把”登记本”里的优质模型”放到展示柜”,支持模型”晋升”(从测试环境到生产环境)、“退休”(下线),还能设置”警报”(模型性能下降时通知管理员)。

生活例子:你用MLflow做实验,就像玩”我的世界”:每次搭房子(训练模型),游戏会自动记录你用了多少块砖(参数)、房子有多高(指标)、用了什么材质包(代码版本),还能把房子保存为”蓝图”(模型文件),下次想建一样的房子,直接加载蓝图就行。

核心概念之间的关系(用小学生能理解的比喻)

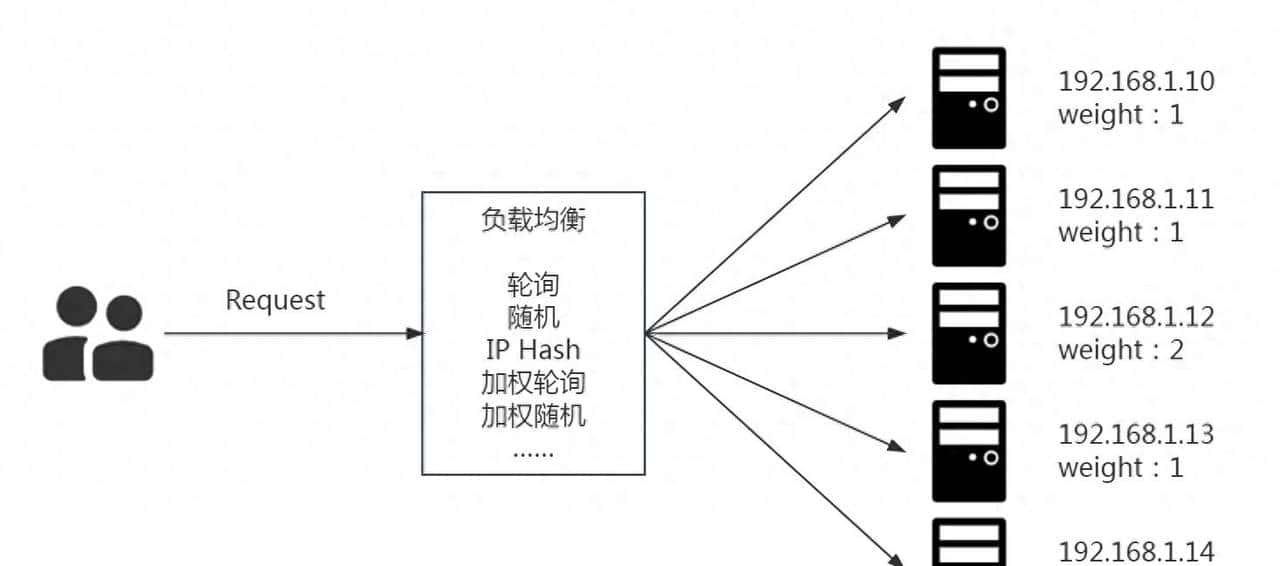

HBase和MLflow不是”竞争对手”,而是”最佳搭档”——就像医院里的”护士”和”医生”:护士(HBase)负责准备和管理药品、器械(存储数据和模型),医生(MLflow)负责诊断和记录病情(设计实验和追踪过程),两者配合才能治好病人(做好机器学习项目)。

MLflow Tracking与HBase的关系:“实验记录”与”物资存储”

MLflow Tracking像”实验室的记录本”,HBase像”实验室的储藏柜”。

分工:记录本只记”今天用了3瓶药水(参数),实验结果是蓝色沉淀(指标)”,不直接存药水;储藏柜则存药水本身,但不记谁什么时候用过。协作:当你做完实验,MLflow会在记录本上写”模型文件存在储藏柜第5层第3格(HBase的行键)”,下次需要时,按这个位置就能从HBase取到模型。

生活例子:就像点外卖——外卖App(MLflow)记录你点了”红烧肉(模型)“,下单时间是12:00(时间戳),但不直接做红烧肉;餐馆后厨(HBase)负责做和存红烧肉,App告诉你”去3号取餐口(HBase行键)拿”,你就能取到餐。

MLflow Models与HBase的关系:“模型身份证”与”模型储物柜”

MLflow Models像”模型的身份证”,HBase像”模型的储物柜”。

分工:身份证记录模型的”姓名(版本号)、出生日期(训练时间)、家庭住址(来源实验)“;储物柜则存模型的”身体(文件数据)”。协作:当模型”成年”(准备部署)时,MLflow会给它办身份证,同时把它的”身体”存入HBase的”成人储物柜”(特定表),并在身份证上写清楚”储物柜编号(行键)”。

生活例子:就像博物馆的文物管理——文物卡片(MLflow Models)记录文物的年代、发现地,而文物本身(模型文件)存放在恒温恒湿的库房(HBase),卡片上会标注”库房A区第3展柜”,方便工作人员查找。

HBase的分布式存储与MLflow的实验追踪:“大规模支持”与”精细化管理”

HBase的分布式存储能力让MLflow”不用怕东西多”,MLflow的精细化追踪让HBase”不用怕东西乱”。

当你有1000个实验、每个实验产生1GB模型文件时,普通硬盘存不下(HBase的分布式存储解决”容量问题”);当你在HBase存了1000个模型文件,分不清哪个是最好的时,MLflow的指标记录(如准确率排名)帮你快速找到”明星模型”(解决”混乱问题”)。

生活例子:就像快递仓库——HBase是”自动分拣系统”,能处理 millions 个包裹(模型/数据)而不混乱;MLflow是”快递单系统”,记录每个包裹的目的地(实验ID)、重量(文件大小)、收件人(负责人),两者结合让快递(模型)又快又准地送到目的地(部署环境)。

核心概念原理和架构的文本示意图(专业定义)

HBase架构:分布式”数据仓库”的组成

HBase的架构像一个”大型超市”,由以下”部门”组成:

HMaster(店长):负责”超市管理”,如分配货架(Region)、招聘员工(Region Server)、处理顾客投诉(故障恢复)。它不直接管商品(数据),但确保超市正常运行。Region Server(货架管理员):每个货架管理员负责一片货架(Region,数据分片),直接服务顾客(处理读写请求)。比如1号管理员管生鲜区,2号管零食区。ZooKeeper(监控摄像头):监控超市状态,比如”店长是否在岗(HMaster活性检测)”、“哪个货架有空位(Region位置)”,确保信息实时同步。HDFS(仓库囤货区):货架上放不下的商品(冷数据)存到仓库,HBase定期把不常用的数据”搬”到HDFS,节省货架空间(内存)。表(Table)与列族(Column Family):超市按”商品大类”分区(表),如”食品区”、“日用品区”;每个大类再分”货架组”(列族),如食品区分”零食架”、“饮料架”,每个货架放一类商品(列)。

MLflow架构:机器学习”实验管理平台”的组成

MLflow的架构像一个”科研中心”,由以下”实验室”组成:

Tracking Server(实验记录室):科学家在这里记实验笔记,包含三个子模块:

Backend Store(笔记数据库):存结构化数据,如实验ID、参数、指标(用数据库如MySQL、PostgreSQL);Artifact Store(样品存储室):存非结构化文件,如模型文件、日志(默认用本地文件系统,可配置为HBase、S3等)。

Model Registry(模型展示厅):展示通过”质检”的模型,支持版本管理、状态流转(如”Staging→Production”)。Client API(实验操作台):科学家用API”操作实验设备”,如”记录参数”(

mlflow.log_param()

mlflow.sklearn.log_model()

HBase+MLflow协作架构:”实验管理+存储”一体化系统

当HBase作为MLflow的Artifact Store时,两者的协作流程如下:

实验开始:数据科学家通过MLflow Client启动实验(

mlflow.start_run()

max_depth=5

accuracy=0.85

model.pkl

mlflow.end_run()

Mermaid 流程图:HBase与MLflow协作流程

graph TD

A[数据科学家启动实验] -->|mlflow.start_run()| B[MLflow Tracking Server]

B --> C{记录元数据}

C -->|参数/指标| D[Backend Store<br>(数据库)]

A --> E[训练模型/处理数据]

E --> F{生成文件}

F -->|模型/数据集| G[调用HBase API]

G --> H[HBase存储文件<br>(行键=实验ID+版本)]

H --> I[返回HBase行键]

I --> B

B -->|记录Artifact路径=HBase行键| D

A -->|mlflow.end_run()| J[实验结束]

J --> K[MLflow UI更新结果]

L[需要加载模型时] --> M[MLflow查询Backend Store]

M --> N[获取HBase行键]

N --> O[HBase读取文件]

O --> P[返回模型文件]

核心算法原理 & 具体操作步骤

MLflow Tracking的核心机制:如何记录实验数据?

MLflow Tracking的核心原理很简单:“给每次实验贴标签,按标签分类存储”。就像图书馆给每本书贴ISBN号,按号入库。具体步骤如下:

1. 实验标识:Run ID的生成

每次调用

mlflow.start_run()

run_id

a1b2c3d4

2. 参数与指标的存储:键值对与时间序列

参数(Parameters):键值对格式(如

learning_rate=0.01

runs

accuracy: 0.80@epoch1, 0.85@epoch2

metrics

run_id

3. Artifacts的存储:路径映射与外部存储

Artifacts(模型、数据等文件)默认存在本地文件系统,但MLflow支持”委托存储”——把文件存在HBase、S3等分布式存储中,自己只存”文件地址”(如HBase的行键)。

以HBase为例,存储Artifacts的步骤:

数据科学家调用

mlflow.log_artifact(local_path, artifact_path)

local_path

run_id=abc123_artifact=model.pkl

artifacts

run_id=abc123, artifact_path=model.pkl, hbase_rowkey=run_id=abc123_artifact=model.pkl

HBase存储模型文件的核心机制:行键设计与列族规划

HBase存储模型文件的关键是**“如何设计表结构”**——就像设计货架,要方便存取。以下是最佳实践:

1. HBase表设计:模型存储表

创建一个专门存储模型文件的表(如

ml_models

meta

meta:run_id

meta:version

meta:metrics

{"accuracy":0.85,"auc":0.90}

meta:timestamp

data

data:file

model.pkl

data:file_name

data:file_size

2. 行键(RowKey)设计:唯一标识与快速查询

行键是HBase的”查找密码”,设计不好会导致查询很慢。推荐格式:

[模型类型]_[实验ID]_[版本号]_[时间戳]

例如:

churn_prediction_abc123_v1_202310011200

好处:

唯一性:实验ID+版本号确保不会重复;可排序:按时间戳排序,方便查询”最近训练的模型”;可前缀查询:用

churn_prediction_

3. 数据写入与读取流程

写入模型到HBase:

import happybase # HBase Python客户端

# 连接HBase

connection = happybase.Connection('hbase-host', port=9090)

table = connection.table('ml_models') # 打开模型表

# 定义行键

row_key = f"churn_prediction_{run_id}_v{version}_{timestamp}"

# 准备数据:元数据和文件内容

meta_data = {

'meta:run_id': run_id,

'meta:version': str(version),

'meta:metrics': json.dumps(metrics),

'meta:timestamp': str(timestamp)

}

data_data = {

'data:file_name': file_name,

'data:file_size': str(file_size),

'data:file': model_bytes # 模型文件二进制数据

}

# 合并数据并写入HBase

table.put(row_key, {**meta_data,** data_data})

从HBase读取模型:

# 按行键查询

row = table.row(row_key)

# 解析元数据和文件内容

meta = {k.decode(): v.decode() for k, v in row.items() if k.startswith(b'meta:')}

model_bytes = row[b'data:file']

# 将二进制数据转换为模型对象(以scikit-learn模型为例)

import pickle

model = pickle.loads(model_bytes)

配置MLflow使用HBase作为Artifact Store

MLflow默认用本地文件系统存储Artifacts,要改用HBase,需要”告诉MLflow如何访问HBase”。这需要自定义Artifact Repository( artifact 仓库)。

关键步骤:实现HBaseArtifactRepository

MLflow允许通过

mlflow.tracking.artifact_repository.ArtifactRepository

| 方法 | 作用 |

|---|---|

|

将本地文件上传到HBase |

|

将本地目录下所有文件上传到HBase |

|

从HBase下载文件到本地 |

|

列出HBase中某路径下的所有文件 |

核心代码:自定义HBaseArtifactRepository

from mlflow.tracking.artifact_repository import ArtifactRepository

from mlflow.entities import Artifact

import happybase

import os

import json

from datetime import datetime

class HBaseArtifactRepository(ArtifactRepository):

def __init__(self, artifact_uri):

# artifact_uri格式: hbase://<table_name>@<host>:<port>

self.artifact_uri = artifact_uri

# 解析URI获取表名、主机、端口

self.table_name = artifact_uri.split('@')[0].split('://')[1]

self.host, self.port = artifact_uri.split('@')[1].split(':')

self.port = int(self.port)

# 连接HBase

self.connection = happybase.Connection(self.host, port=self.port)

self.table = self.connection.table(self.table_name)

def log_artifact(self, local_file, artifact_path=None):

# local_file: 本地文件路径

# artifact_path: MLflow中的artifact相对路径(如'model')

run_id = os.environ.get('MLFLOW_RUN_ID') # 从环境变量获取当前实验ID

if not run_id:

raise ValueError("MLFLOW_RUN_ID environment variable not set")

# 生成行键:run_id_artifactPath_filename

file_name = os.path.basename(local_file)

if artifact_path:

row_key = f"{run_id}_{artifact_path}_{file_name}"

else:

row_key = f"{run_id}_{file_name}"

# 读取本地文件内容

with open(local_file, 'rb') as f:

file_content = f.read()

file_size = os.path.getsize(local_file)

timestamp = datetime.now().strftime("%Y%m%d%H%M%S")

# 准备数据:meta列族存元数据,data列族存文件内容

data = {

'meta:run_id': run_id,

'meta:artifact_path': artifact_path or '',

'meta:file_name': file_name,

'meta:timestamp': timestamp,

'meta:file_size': str(file_size),

'data:content': file_content

}

# 写入HBase

self.table.put(row_key, data)

print(f"Artifact logged to HBase: {row_key}")

# 其他方法(log_artifacts, download_artifact等)类似实现...

注册自定义Artifact Repository

实现后,需要告诉MLflow使用这个自定义仓库。在

mlflow_config.py

import mlflow

from mlflow.tracking.artifact_repository_registry import ArtifactRepositoryRegistry

# 注册HBase Artifact Repository,支持' hbase://' URI

ArtifactRepositoryRegistry.register('hbase', HBaseArtifactRepository)

# 配置MLflow使用HBase作为Artifact Store

mlflow.set_tracking_uri("http://mlflow-tracking-server:5000") # MLflow Tracking Server地址

mlflow.set_experiment("churn_prediction_experiment") # 设置实验名称

数学模型和公式 & 详细讲解 & 举例说明

HBase的存储优化:数据压缩与分区策略

HBase存储模型文件时,为了节省空间和加速传输,需要压缩数据。常用的压缩算法有Gzip、Snappy、LZO,选择时需权衡压缩率和速度。

压缩率公式

压缩率 CRCRCR 定义为压缩前后文件大小的比值:

压缩速度与压缩率的权衡

| 算法 | 压缩率(CR) | 压缩速度(MB/s) | 解压速度(MB/s) | 适用场景 |

|---|---|---|---|---|

| Gzip | 0.2-0.3 | ~20 | ~100 | 模型文件(不常更新,追求高压缩率) |

| Snappy | 0.4-0.5 | ~100 | ~200 | 训练日志(频繁写入,追求速度) |

| LZO | 0.3-0.4 | ~50 | ~150 | 中等需求,平衡压缩率和速度 |

举例:一个1GB的深度学习模型,用Gzip压缩后约250MB(CR=0.25),但压缩需要50秒;用Snappy压缩后约400MB(CR=0.4),但压缩只需10秒。如果模型每周更新一次,选Gzip更省空间;如果每天更新,选Snappy更省时。

MLflow的实验对比:指标可视化与最优模型选择

MLflow UI会自动绘制”参数vs指标”的散点图,帮助选择最优模型。背后的数学原理是多变量优化——在参数空间中找到使指标(如准确率)最大化的点。

准确率与参数的关系模型

假设我们训练随机森林模型,关注参数

n_estimators

accuracy

(n_estimators, accuracy)

举例:用MLflow选择最优随机森林参数

假设实验数据如下:

| Run ID | n_estimators | max_depth | accuracy |

|---|---|---|---|

| run1 | 10 | 5 | 0.78 |

| run2 | 50 | 5 | 0.83 |

| run3 | 100 | 5 | 0.85 |

| run4 | 200 | 5 | 0.85 |

| run5 | 100 | 10 | 0.87 |

MLflow UI会生成:

n_estimators

accuracy

n_estimators

max_depth

accuracy

max_depth=10

最终选择

run5

项目实战:代码实际案例和详细解释说明

开发环境搭建

我们将搭建一个完整的”模型管理与追踪系统”,包含以下组件:

HBase:存储模型文件和数据集;MLflow Tracking Server:记录实验参数、指标,管理Artifact路径;MySQL:作为MLflow的Backend Store(存储元数据);Python环境:数据科学库(scikit-learn、pandas)、HBase客户端(happybase)。

步骤1:启动HBase

使用Docker快速启动HBase(需安装Docker和Docker Compose):

# docker-compose-hbase.yml

version: '3'

services:

hbase:

image: harisekhon/hbase:latest

ports:

- "2181:2181" # ZooKeeper端口

- "16010:16010" # HBase Master UI

- "16020:16020" # Region Server端口

- "9090:9090" # Thrift Server端口(happybase依赖)

environment:

- HBASE_MANAGES_ZK=true

volumes:

- hbase-data:/hbase-data

volumes:

hbase-data:

启动命令:

docker-compose -f docker-compose-hbase.yml up -d

验证HBase是否启动:访问

http://localhost:16010

步骤2:创建HBase模型表

用HBase Shell创建

ml_models

meta

data

# 进入HBase容器

docker exec -it <hbase-container-id> bash

# 启动HBase Shell

hbase shell

# 创建表

create 'ml_models', 'meta', 'data'

# 验证表是否存在

list 'ml_models' # 应输出'ml_models'

步骤3:启动MLflow Tracking Server

用MySQL作为Backend Store,HBase作为Artifact Store:

# 启动MySQL(如需)

docker run -d -p 3306:3306 -e MYSQL_ROOT_PASSWORD=password mysql:latest

# 启动MLflow Tracking Server

mlflow server

--backend-store-uri mysql+pymysql://root:password@localhost:3306/mlflow

--default-artifact-root hbase://ml_models@localhost:9090 # HBase表和地址

--host 0.0.0.0

--port 5000

验证MLflow是否启动:访问

http://localhost:5000

步骤4:配置Python环境

安装依赖:

pip install mlflow scikit-learn pandas happybase numpy

源代码详细实现和代码解读

我们以”用户 churn 预测模型”为例,演示如何用MLflow追踪实验,并将模型存储到HBase。

完整代码:churn_prediction.py

import os

import json

import pandas as pd

import numpy as np

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score, roc_auc_score

import mlflow

from mlflow.tracking import MlflowClient

import happybase

# ----------------------

# 1. 配置MLflow和HBase

# ----------------------

# 设置MLflow Tracking Server地址

mlflow.set_tracking_uri("http://localhost:5000")

# 设置实验名称

experiment_name = "churn_prediction_experiment"

mlflow.set_experiment(experiment_name)

# 连接HBase(用于后续验证模型存储)

hbase_connection = happybase.Connection('localhost', port=9090)

hbase_table = hbase_connection.table('ml_models')

# ----------------------

# 2. 加载和准备数据

# ----------------------

def load_data():

# 生成模拟数据(用户特征和churn标签)

np.random.seed(42)

n_samples = 10000

data = {

'age': np.random.randint(18, 70, size=n_samples),

'tenure': np.random.randint(1, 60, size=n_samples), # 用户在网时长(月)

'monthly_fee': np.random.uniform(10, 200, size=n_samples),

'total_fee': np.random.uniform(100, 5000, size=n_samples),

'churn': np.random.randint(0, 2, size=n_samples) # 0:不流失,1:流失

}

df = pd.DataFrame(data)

return df

# 加载数据并拆分训练集/测试集

df = load_data()

X = df.drop('churn', axis=1)

y = df['churn']

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# ----------------------

# 3. 训练模型并使用MLflow追踪

# ----------------------

def train_model(n_estimators, max_depth):

# 启动MLflow Run

with mlflow.start_run():

# 记录参数

mlflow.log_param("n_estimators", n_estimators)

mlflow.log_param("max_depth", max_depth)

mlflow.log_param("model_type", "RandomForestClassifier")

# 记录数据集信息

mlflow.log_param("train_samples", len(X_train))

mlflow.log_param("test_samples", len(X_test))

# 训练模型

model = RandomForestClassifier(

n_estimators=n_estimators,

max_depth=max_depth,

random_state=42

)

model.fit(X_train, y_train)

# 评估模型

y_pred = model.predict(X_test)

y_proba = model.predict_proba(X_test)[:, 1]

accuracy = accuracy_score(y_test, y_pred)

auc = roc_auc_score(y_test, y_proba)

# 记录指标

mlflow.log_metric("accuracy", accuracy)

mlflow.log_metric("auc", auc)

# 记录模型文件(自动存储到HBase,因为MLflow配置了HBase Artifact Store)

mlflow.sklearn.log_model(

sk_model=model,

artifact_path="model", # Artifact路径,对应HBase行键的一部分

registered_model_name="churn_prediction_model" # 注册到Model Registry

)

# 记录数据集(可选:将训练数据也存入HBase)

X_train.to_csv("train_data.csv", index=False)

mlflow.log_artifact("train_data.csv", artifact_path="data")

# 打印结果

print(f"n_estimators={n_estimators}, max_depth={max_depth}")

print(f"Accuracy: {accuracy:.4f}, AUC: {auc:.4f}")

# 返回Run ID和指标,用于后续验证

return mlflow.active_run().info.run_id, accuracy, auc

# ----------------------

# 4. 运行多组实验,寻找最优参数

# ----------------------

# 定义参数网格(n_estimators和max_depth的组合)

param_grid = {

"n_estimators": [50, 100, 200],

"max_depth": [5, 10, 15]

}

best_auc = 0

best_run_id = None

# 遍历参数组合

for n_estimators in param_grid["n_estimators"]:

for max_depth in param_grid["max_depth"]:

run_id, accuracy, auc = train_model(n_estimators, max_depth)

# 记录最优模型

if auc > best_auc:

best_auc = auc

best_run_id = run_id

print(f"

Best model: Run ID={best_run_id}, AUC={best_auc:.4f}")

# ----------------------

# 5. 验证模型是否存储到HBase

# ----------------------

def verify_model_in_hbase(run_id):

# 从HBase查询该Run的模型文件

# 行键格式:{run_id}_model_random_forest_model.pkl(mlflow.sklearn.log_model生成的默认文件名)

# 实际文件名可通过MLflow API查询,这里简化处理

scan_filter = f"RowFilter(=, 'substring:{run_id}_model_')"

for key, data in hbase_table.scan(filter=scan_filter):

print(f"

Found model in HBase: RowKey={key.decode()}")

print("Meta data:")

for col, val in data.items():

if col.decode().startswith("meta:"):

print(f" {col.decode()}: {val.decode()}")

return True

print("Model not found in HBase")

return False

# 验证最优模型是否存储在HBase

verify_model_in_hbase(best_run_id)

代码解读与分析

关键步骤1:MLflow配置与HBase集成

代码开头设置了MLflow的Tracking URI(

http://localhost:5000

--default-artifact-root hbase://ml_models@localhost:9090

mlflow.sklearn.log_model()

mlflow.log_artifact()

ml_models

关键步骤2:实验参数与指标追踪

在

train_model

mlflow.log_param()

n_estimators

max_depth

mlflow.log_metric()

关键步骤3:模型存储到HBase

mlflow.sklearn.log_model()

model.pkl

HBaseArtifactRepository

{run_id}_model_random_forest_model.pkl

run_id

关键步骤4:验证HBase存储

verify_model_in_hbase

run_id

运行结果与MLflow UI展示

运行代码后,访问

http://localhost:5000

churn_prediction_experiment

实际应用场景

场景1:金融风控模型的版本管理

某银行开发信用卡欺诈检测模型,每天需要测试20组参数(如逻辑回归的正则化系数、树模型的深度)。使用HBase+MLflow后:

MLflow:记录每组参数对应的”欺诈识别率

暂无评论内容