金融AI智能体架构可扩展性设计:AI应用架构师谈智能化投资决策系统如何应对用户量激增

标题选项

金融AI智能体架构进化论:从千人到百万用户,架构师如何破解可扩展性难题?支撑百万用户的金融AI:智能投资决策系统可扩展性架构设计实战指南当金融AI遇上流量洪峰:智能体架构可扩展性设计的10个关键策略金融AI架构师手记:智能化投资决策系统应对用户量激增的架构演进之路从瓶颈到弹性:金融AI智能体架构可扩展性设计与高并发处理实践

1. 引言 (Introduction)

痛点引入 (Hook)

想象这样一个场景:你的金融AI智能投顾产品上线3个月,凭借精准的市场预测和个性化策略推荐,用户量从10万飙升至100万。然而,就在用户增长最快的那一周,系统开始频繁出现“请求超时”——用户点击“生成策略”后,页面加载30秒仍无响应;更严重的是,开盘高峰期(9:30-10:00),实时行情数据处理延迟达2分钟,导致AI模型基于过时数据给出投资建议,用户投诉量激增300%。

这不是虚构的危机,而是金融AI领域的“成长的烦恼”。智能化投资决策系统作为金融科技的核心应用,既要处理实时行情、用户行为、市场新闻等海量数据,又要运行复杂的AI模型(如LSTM预测、强化学习策略优化),同时需满足金融级的低延迟(<100ms)、高可用(99.99% SLA)和合规性要求。当用户量从“万级”跃升至“百万级”,传统架构的瓶颈会集中爆发:数据库连接池耗尽、AI模型推理排队、消息队列堆积、服务级联崩溃……

如何让金融AI智能体在用户量激增时“稳如磐石”?这正是本文要解决的核心问题。

文章内容概述 (What)

本文将以“可扩展性设计”为核心,从架构师视角拆解金融AI智能体的底层架构,系统讲解如何通过分层解耦、弹性伸缩、流量治理、数据优化四大维度,构建能够支撑用户量从10万到1000万的智能化投资决策系统。我们会结合真实案例(如某头部券商AI投顾系统的架构演进),从需求分析到落地实践,提供可复用的架构设计模板和代码级解决方案。

读者收益 (Why)

读完本文,你将掌握:

金融AI架构的可扩展性核心原则:为何“水平扩展优先于垂直扩展”“无状态设计是弹性伸缩的基石”?分层架构的扩展策略:从API网关到AI模型服务,每一层如何应对流量洪峰?实战工具与代码示例:用K8s实现AI模型自动扩缩容、用Redis集群缓存高频行情数据、用Kafka处理百万级实时数据流的具体配置。金融场景特殊考量:如何在扩展性与低延迟、合规性之间找到平衡?

无论你是AI应用架构师、金融科技开发者,还是想深入理解高并发系统设计的工程师,本文都将为你提供从“理论”到“落地”的完整指南。

2. 准备工作 (Prerequisites)

在进入架构设计前,请确保你已具备以下基础知识和工具环境:

技术栈/知识储备

分布式系统基础:理解CAP定理、一致性模型(如最终一致性)、负载均衡原理。微服务架构:熟悉服务拆分原则、服务发现、API网关、熔断/限流机制。AI工程化:了解模型训练/推理流程、模型服务化(如TensorFlow Serving)、GPU资源调度。金融数据特点:实时行情数据(高吞吐、时序性)、用户数据(隐私性、合规性)、策略数据(低延迟查询需求)。容器与云原生:掌握Docker容器化、Kubernetes(K8s)部署与编排基础。

环境/工具

云服务环境:AWS/Azure/GCP或国内云厂商(阿里云、腾讯云)账号,具备创建K8s集群、云数据库、消息队列的权限。容器化工具:Docker(镜像构建)、kubectl(K8s命令行工具)。监控工具:Prometheus(指标收集)、Grafana(可视化)、Jaeger(分布式追踪)。压测工具:Locust(模拟用户流量)、JMeter(API性能测试)。

3. 核心内容:手把手实战 (Step-by-Step Tutorial)

步骤一:金融AI智能体架构的可扩展性需求分析——明确“为什么需要扩展”和“扩展什么”

1.1 需求分类:从“用户量激增”到“系统压力点”

用户量激增(如从10万→100万)带来的压力并非单一维度,需拆解为业务需求和非功能需求:

| 需求类型 | 具体表现 | 对架构的挑战 |

|---|---|---|

| 业务需求 | 用户并发请求量增长10倍(如策略生成、行情查询); AI模型调用量增长20倍(如市场预测、风险评估)。 |

服务处理能力不足,出现请求排队; AI模型推理资源(GPU/CPU)耗尽。 |

| 数据需求 | 实时行情数据吞吐量从1000条/秒→10万条/秒; 用户策略数据存储量从10GB→100GB。 |

数据写入/查询延迟增加; 数据库存储瓶颈、连接池耗尽。 |

| 非功能需求 | 响应时间要求:策略生成<500ms,行情查询<100ms; 可用性要求:99.99%(全年 downtime <52.56分钟)。 |

单点故障导致服务不可用; 流量峰值时响应时间超阈值,触发用户投诉。 |

| 合规需求 | 金融监管要求:所有用户操作需审计日志,数据加密传输与存储。 | 高并发下审计日志写入性能瓶颈; 加密计算增加系统开销。 |

1.2 量化指标:定义“扩展性目标”

架构设计需以可量化的指标为导向,避免“拍脑袋”决策。以“100万用户规模”为例,关键指标包括:

流量指标:日均请求量1亿次,峰值QPS(每秒查询率)5000(开盘前30分钟);数据指标:实时行情数据日增量50GB,用户策略数据查询QPS 2000;AI模型指标:单模型推理延迟<200ms,模型调用峰值QPS 1000;可用性指标:系统年度可用性99.99%,故障自动恢复时间<5分钟。

为什么需要量化? 例如“峰值QPS 5000”决定了API网关的并发处理能力,“模型推理延迟<200ms”限制了模型服务的部署架构(不能用远程调用耗时过长的方案)。

步骤二:可扩展性架构设计原则——金融AI场景下的核心设计理念

金融AI智能体的可扩展性设计,需在“通用分布式原则”基础上,叠加金融场景的特殊性。以下6条原则是经过实战验证的“黄金法则”:

2.1 原则一:水平扩展优先于垂直扩展

垂直扩展(Scale Up):通过升级单机硬件(如CPU从8核→32核,内存从32GB→256GB)提升性能。

水平扩展(Scale Out):通过增加服务器节点(如从10台服务器→100台)分摊压力。

为什么金融AI选水平扩展?

垂直扩展有物理上限(单机CPU/内存不可能无限增加),且升级时需停机,违反金融系统“7×24小时可用”要求;水平扩展支持“按需扩容”,例如开盘高峰期临时增加20台AI推理节点,收盘后自动释放,降低成本。

落地示例:用K8s的Deployment管理AI模型服务,通过HPA(Horizontal Pod Autoscaler)根据CPU使用率自动增加Pod数量(节点)。

2.2 原则二:无状态设计是弹性伸缩的基石

无状态服务:服务不存储本地数据,所有状态(如用户会话、临时计算结果)存储在分布式缓存(如Redis)或数据库中。

为什么重要?

若服务有状态(如本地缓存用户策略),水平扩展时新节点无法获取老节点的状态,导致用户请求出错。例如:用户在节点A生成策略并缓存,下次请求被路由到节点B,因节点B无缓存需重新计算,增加延迟。

落地示例:用户登录状态存储在Redis集群(Key为用户Token,Value为用户ID+权限),所有API服务节点通过Redis获取用户状态,实现“任意节点可处理任意请求”。

2.3 原则三:分层解耦,每一层独立扩展

将系统拆分为多层,每层专注单一职责,通过标准化接口通信,实现“哪层压力大就扩哪层”。典型分层架构如下:

┌─────────────────┐ ┌─────────────────┐ ┌─────────────────┐

│ 客户端层 │ │ 接入层 │ │ 业务逻辑层 │

│ (Web/APP/API) │────▶│ (API网关/CDN) │────▶│ (微服务集群) │

└─────────────────┘ └─────────────────┘ └────────┬────────┘

│

┌─────────────────┐ ┌─────────────────┐ ┌────────▼────────┐

│ 数据存储层 │◀────│ AI模型服务层 │◀────│ 消息队列层 │

│ (数据库/缓存) │ │ (推理/训练服务)│ │ (Kafka/Rabbit)│

└─────────────────┘ └─────────────────┘ └─────────────────┘

分层优势:例如用户量激增时,仅需扩展API网关和业务逻辑层的节点,而AI模型服务层若压力不大可保持不变,避免资源浪费。

2.4 原则四:异步通信削峰填谷

同步通信:请求需等待响应(如用户点击“生成策略”后,前端等待后端返回结果),适合低延迟场景;

异步通信:请求发送后无需等待,通过消息队列异步处理(如用户提交策略回测任务,后端异步执行,完成后通知用户),适合非实时、高耗时场景。

金融AI场景应用:

同步通信:实时行情查询、简单策略推荐(需毫秒级响应);异步通信:策略回测(可能耗时几分钟)、历史数据导出(GB级数据)、模型训练任务(需GPU资源)。

削峰效果:若10万用户同时提交回测任务,同步通信会瞬间压垮服务,而通过Kafka队列缓冲,后端消费者可按“每秒1000任务”的速度平稳处理,避免系统过载。

2.5 原则五:数据分层存储与分片

金融数据类型多样(实时行情、用户数据、策略数据),需按“访问频率”和“存储需求”分层存储:

| 数据类型 | 特点 | 存储方案 | 扩展策略 |

|---|---|---|---|

| 高频访问数据 | 如实时行情(每秒查询10万次) | Redis集群(主从+哨兵,支持分片) | 增加Redis节点,按Key哈希分片 |

| 低频访问数据 | 如历史交易记录(月查询1次) | 对象存储(S3/OSS)+ 冷备份 | 增加存储桶容量 |

| 结构化业务数据 | 如用户账户信息、策略配置 | 分布式数据库(MySQL集群/PostgreSQL) | 按用户ID范围分片(如user_id%10=0→分片0) |

| 时序数据 | 如K线数据(时间序列特性) | 时序数据库(InfluxDB/TimescaleDB) | 按时间范围分区(如按天分区) |

数据分片示例:用户策略数据按“用户ID哈希分片”,100万用户分为10个分片,每个分片存储10万用户数据,查询时仅需访问对应分片,降低单库压力。

2.6 原则六:监控先行,基于指标驱动扩展

“盲目扩展”会导致资源浪费(如为应对偶发峰值长期保持100个节点),需通过监控指标动态调整资源。核心监控指标包括:

流量指标:API QPS、请求延迟(P95/P99)、错误率;资源指标:CPU/内存使用率、GPU利用率、磁盘IOPS;数据指标:消息队列堆积量、数据库连接数、缓存命中率;业务指标:策略生成成功率、行情数据更新延迟。

落地示例:当API网关的P95延迟>300ms且CPU使用率>70%时,自动触发业务逻辑层的Pod扩容;当Kafka某个Topic的消息堆积>10万条时,增加消费者实例。

步骤三:分层解耦:构建弹性扩展的金融AI智能体核心架构

基于上述原则,我们设计一个可扩展的金融AI智能体架构,共分为6层,每层独立扩展。以下是各层的职责、挑战与扩展方案:

3.1 接入层:API网关与CDN——流量入口的第一道防线

职责:统一入口、路由转发、限流熔断、SSL终止(HTTPS加密)、静态资源缓存。

挑战:用户量激增时,入口流量集中,若不控制会“冲垮”后端服务。

核心组件与扩展策略:

API网关选型:推荐使用Kong或APISIX(云原生、高性能、插件化),替代传统的Nginx(配置复杂,扩展能力弱)。

优势:支持动态路由(无需重启服务)、插件化限流/熔断(如limit-req插件限制单IP QPS)、服务健康检查。

限流与熔断配置:

限流:按用户等级区分(VIP用户QPS=100,普通用户QPS=10),避免恶意请求占满资源。

-- APISIX限流插件配置(限制普通用户IP每秒最多10个请求)

{

"limit-req": {

"rate": 10, -- 速率限制(每秒请求数)

"burst": 5, -- 突发请求允许的超额数量

"key_type": "var", -- 限流维度(var=变量,如remote_addr=客户端IP)

"key": "remote_addr"

}

}

熔断:当后端服务错误率>50%或响应时间>1s时,自动“熔断”(返回降级响应,如“系统繁忙,请稍后再试”),避免级联故障。

CDN加速静态资源:用户界面(Web/APP)的静态资源(JS/CSS/图片)、历史行情图表(如日线/周线图片)通过CDN分发,减少源站请求。

3.2 业务逻辑层:微服务集群——按领域拆分,独立扩展

职责:处理核心业务逻辑,如用户管理、策略管理、交易执行、风险控制等。

挑战:不同业务模块的流量增长速度不同(如“策略推荐”模块流量可能是“用户注册”的10倍),需按模块独立扩展。

微服务拆分原则:按“领域边界”拆分,避免“过度拆分”(增加通信开销)或“拆分不足”(无法独立扩展)。金融AI智能体常见微服务如下:

| 微服务名称 | 核心功能 | 扩展优先级 |

|---|---|---|

| 用户服务(User) | 注册/登录、用户信息管理、权限控制 | ★★☆ |

| 策略服务(Strategy) | 策略创建、修改、查询、推荐 | ★★★(高频调用) |

| 交易服务(Trade) | 订单生成、执行、撤单、持仓查询 | ★★★(核心业务) |

| 行情服务(Market) | 实时行情推送、历史行情查询 | ★★★(高吞吐) |

| 风控服务(Risk) | 风险评级、持仓限额检查、合规校验 | ★★☆ |

服务发现与负载均衡:

服务发现:用K8s Service或Consul实现服务注册(服务启动时自动注册地址)和发现(通过服务名访问,如

strategy-service:8080

无状态服务实现:

所有业务逻辑服务不存储本地状态,用户会话、临时数据通过Redis集群共享。例如策略服务生成的临时策略参数,存储在Redis(Key为

temp_strategy:{strategy_id}

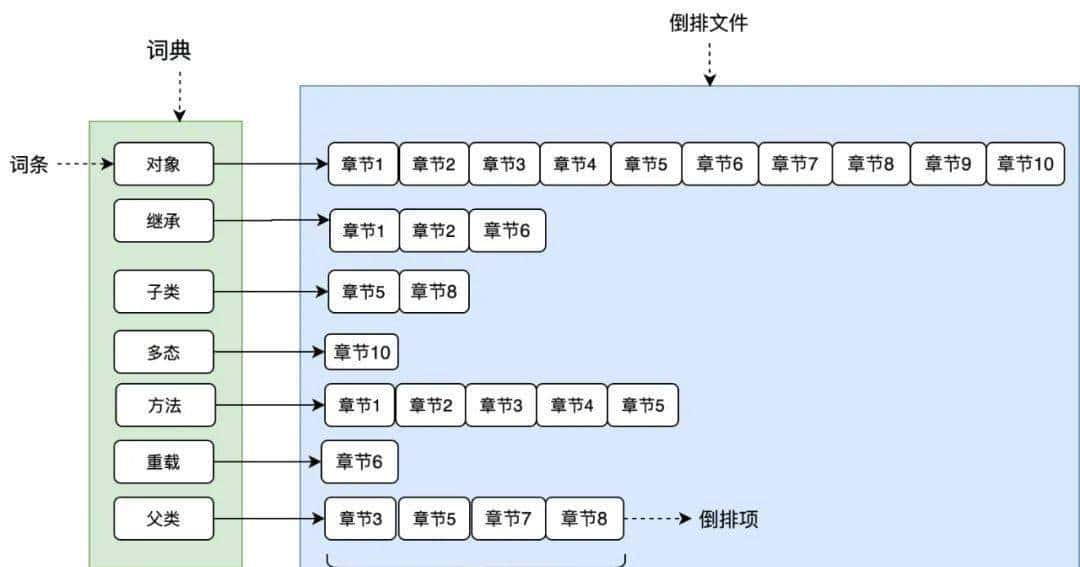

3.3 消息队列层:Kafka集群——高吞吐异步通信中枢

职责:解耦生产者与消费者、缓冲流量峰值、异步任务处理、日志收集。

挑战:金融数据(如实时行情)吞吐量极高(10万条/秒),需保证消息不丢失、顺序性(如K线数据需按时间顺序处理)。

Kafka核心配置与扩展策略:

Topic分区设计:Topic的“分区数”决定并行处理能力,分区越多,可同时消费的消费者实例越多。例如“行情数据Topic”设10个分区,可启动10个消费者实例并行处理,吞吐量提升10倍。

# 创建行情数据Topic,10个分区,2个副本(保证数据冗余)

kafka-topics.sh --create --topic market_data --partitions 10 --replication-factor 2 --bootstrap-server kafka-0:9092,kafka-1:9092

消费者组扩展:同一消费者组内的消费者实例数≤分区数(否则多余实例空闲)。例如10个分区的Topic,消费者组最多10个实例,每个实例处理1个分区。

数据可靠性保障:

生产者:

acks=all

enable.auto.commit=false

金融场景应用示例:

实时行情数据从交易所接口接入后,生产者将数据写入Kafka的

market_data

行情服务:消费数据更新Redis缓存(供前端查询);AI模型服务:消费数据作为模型输入(如实时预测股价);存储服务:消费数据写入时序数据库(长期存储)。

3.4 AI模型服务层:推理集群——计算密集型任务的弹性扩展

职责:提供AI模型推理接口(如市场预测、策略推荐、风险评估),处理计算密集型任务。

挑战:用户量激增时,模型推理请求(如每秒1000次预测)会耗尽GPU资源,导致推理延迟增加。

核心组件与扩展策略:

模型服务化框架:使用KServe(Kubernetes原生模型服务)或TorchServe(PyTorch官方服务),支持多模型管理、动态扩缩容、A/B测试。

水平扩展推理节点:通过K8s的HPA(Horizontal Pod Autoscaler)基于GPU利用率自动扩缩容。例如:

# K8s HPA配置:当GPU利用率>70%时扩容,<30%时缩容

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: stock-prediction-service

spec:

scaleTargetRef:

apiVersion: apps/v1

kind: Deployment

name: stock-prediction-service

minReplicas: 3 # 最小3个节点(避免冷启动)

maxReplicas: 20 # 最大20个节点

metrics:

- type: Resource

resource:

name: nvidia_gpu_utilization # GPU利用率指标(需安装nvidia-device-plugin)

target:

type: Utilization

averageUtilization: 70

模型优化与缓存:

模型轻量化:用TensorRT或ONNX Runtime优化模型,减少推理耗时(如将LSTM模型推理延迟从200ms降至80ms);推理结果缓存:对高频重复请求(如同一股票的5分钟预测,10万用户查询),用Redis缓存推理结果(Key为

prediction:{stock_code}:{time_window}

批处理推理:对非实时场景(如盘后批量策略评估),启用动态批处理(Dynamic Batching),将多个推理请求合并为一批处理,提高GPU利用率。例如KServe的

max_batch_size=32

3.5 数据存储层:多引擎协同——高可用与低延迟的平衡

职责:存储用户数据、业务数据、行情数据、AI模型参数等,支持高吞吐写入和低延迟查询。

挑战:金融数据类型多样,需在“可用性”“一致性”“延迟”之间权衡(如实时行情需低延迟,用户账户数据需强一致性)。

核心存储引擎与扩展策略:

分布式关系型数据库(用户/交易数据):

选型:阿里云PolarDB、AWS Aurora(兼容MySQL/PostgreSQL,支持读写分离和自动扩容);扩展策略:

读写分离:主库负责写入(用户注册、订单提交),只读副本负责查询(用户资料查询、历史订单),分担主库压力;数据分片:按用户ID哈希分片(如

user_id % 10

Redis集群(高频缓存/会话存储):

架构:3主3从+哨兵(主从复制保证数据冗余,哨兵自动故障转移);数据分片:启用Redis Cluster,将数据分为16384个槽位,每个主节点负责部分槽位,支持动态添加节点并迁移槽位(扩展容量);金融场景应用:缓存实时行情(Key为股票代码,Value为最新价格+成交量)、用户登录状态(Key为Token)、高频策略参数。

时序数据库(行情/指标数据):

选型:InfluxDB(适合高写入、低查询)或TimescaleDB(PostgreSQL扩展,支持SQL查询);扩展策略:按时间分区(如按天分区),老数据自动迁移至低成本存储(如S3),查询时仅扫描目标时间分区;示例:存储1分钟K线数据,每个分区存储1天数据,查询“近3天K线”仅需扫描3个分区。

对象存储(静态资源/备份):

选型:AWS S3、阿里云OSS;应用:存储用户上传的策略文件、模型训练日志、历史数据备份(如每日行情数据快照),支持无限扩容(按存储量付费)。

3.6 监控与运维层:全链路可观测——提前发现扩展需求

职责:监控系统状态、告警异常、追踪问题根因、自动化运维(如自动扩缩容)。

挑战:金融系统故障影响重大,需“故障未发生时预警,发生时快速定位”。

核心工具与实践:

全链路监控:

指标监控:Prometheus收集系统指标(CPU/内存/GPU使用率、API延迟、数据库连接数),Grafana配置仪表盘(如“开盘高峰期实时监控看板”);日志聚合:ELK Stack(Elasticsearch+Logstash+Kibana)收集所有服务日志,按TraceID关联请求全链路日志,支持关键词检索(如搜索“策略生成失败”日志);分布式追踪:Jaeger追踪请求从“客户端→API网关→业务服务→AI服务→数据库”的完整路径,定位延迟瓶颈(如某请求延迟高是因为AI模型推理耗时过长)。

智能告警:

基于PromQL设置告警规则(如

api_request_duration_seconds{P95}>0.5

自动化运维:

K8s HPA实现服务自动扩缩容(基于CPU/GPU使用率、自定义指标如QPS);数据库自动备份(每日全量+实时增量,支持时间点恢复);故障自愈脚本(如检测到Redis主节点故障,自动提升从节点为主节点)。

步骤四:实战案例:从10万到100万用户的架构演进

为更直观理解可扩展性设计的落地过程,我们以“某券商AI投顾系统”为例,复盘其从10万用户到100万用户的架构演进(真实案例改编)。

阶段一:10万用户,单体架构(痛点爆发期)

初始架构:单体应用(Java Spring Boot)+ 单机MySQL + 本地模型推理(Python脚本)。

痛点:

用户量增至10万后,开盘高峰期API响应延迟从200ms增至2s(数据库连接池耗尽);模型推理在应用内调用,CPU使用率长期100%,导致其他功能(如用户登录)卡顿;单点故障:应用服务器宕机后,整个系统不可用。

优化方向:拆分单体,引入微服务和分布式组件。

阶段二:30万用户,初步微服务化(解耦期)

架构调整:

拆分为用户服务、策略服务、行情服务3个微服务,部署在3台虚拟机;引入Redis缓存实时行情(减少数据库查询);模型推理独立部署为Python Flask服务,通过HTTP接口调用。

效果:

API延迟降至500ms(Redis缓存命中率80%);服务独立扩展(策略服务压力大时,单独增加1台虚拟机)。

新痛点:微服务间通信通过REST API,调用链长(如策略生成需调用行情服务→风控服务→AI服务),延迟累积;无统一API网关,客户端需记住多个服务地址,维护复杂。

阶段三:100万用户,云原生架构(弹性扩展期)

架构调整(完整落地本文分层架构):

接入层:部署APISIX网关,配置限流(单用户QPS=20)和路由转发;业务逻辑层:所有微服务容器化,部署在K8s集群,通过HPA自动扩缩容(如策略服务从3个Pod扩至10个);消息队列:引入Kafka处理实时行情数据(10万条/秒),下游服务异步消费;AI模型服务:用KServe部署推理服务,GPU节点按利用率自动扩缩容(从3个GPU节点扩至8个);数据层:MySQL读写分离(1主3从),Redis集群(3主3从),TimescaleDB存储K线数据;监控:Prometheus+Grafana监控全链路指标,Jaeger追踪调用延迟。

效果:

峰值QPS支撑5000,API响应延迟稳定在100ms以内;系统可用性达99.99%(全年downtime仅43分钟);资源成本优化30%(非高峰期自动缩容,减少闲置节点)。

步骤五:代码示例:关键组件的可扩展性配置

示例1:K8s部署AI模型服务并配置HPA

# stock-prediction-deployment.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: stock-prediction-service

spec:

replicas: 3 # 初始副本数

selector:

matchLabels:

app: stock-prediction

template:

metadata:

labels:

app: stock-prediction

spec:

containers:

- name: model-server

image: harbor.example.com/ai/stock-prediction:v1.0 # 模型镜像

resources:

limits:

nvidia.com/gpu: 1 # 每个Pod使用1块GPU

requests:

cpu: "1"

memory: "2Gi"

ports:

- containerPort: 8080

livenessProbe: # 健康检查

httpGet:

path: /health

port: 8080

initialDelaySeconds: 30

periodSeconds: 10

---

# HPA配置

apiVersion: autoscaling/v2

kind: HorizontalPodAutoscaler

metadata:

name: stock-prediction-hpa

spec:

scaleTargetRef:

apiVersion: apps/v1

kind: Deployment

name: stock-prediction-service

minReplicas: 3

maxReplicas: 20

metrics:

- type: Resource

resource:

name: nvidia_gpu_utilization

target:

type: Utilization

averageUtilization: 70

- type: Pods

pods:

metric:

name: inference_requests_per_second

target:

type: AverageValue

averageValue: 100 # 当每秒推理请求>100时扩容

示例2:Redis集群缓存实时行情数据

# 行情服务消费者(从Kafka消费行情数据并写入Redis)

from kafka import KafkaConsumer

import redis

import json

# 连接Redis集群(3主3从)

redis_cluster = redis.RedisCluster(

startup_nodes=[

{"host": "redis-0", "port": 6379},

{"host": "redis-1", "port": 6379},

{"host": "redis-2", "port": 6379}

],

decode_responses=True

)

# 消费Kafka行情数据

consumer = KafkaConsumer(

"market_data",

bootstrap_servers=["kafka-0:9092", "kafka-1:9092"],

group_id="market_consumer",

auto_offset_reset="latest"

)

for msg in consumer:

data = json.loads(msg.value) # 数据格式:{"code": "600036", "price": 12.5, "volume": 10000, "time": "2023-10-01 09:30:00"}

stock_code = data["code"]

# 写入Redis(Key为股票代码,Value为JSON字符串,过期时间10分钟)

redis_cluster.setex(

f"market:realtime:{stock_code}",

600, # 过期时间600秒

json.dumps({"price": data["price"], "volume": data["volume"], "time": data["time"]})

)

print(f"Updated {stock_code} price: {data['price']}")

示例3:APISIX网关限流配置

# APISIX路由与限流配置(apisix/config.yaml)

routes:

- id: strategy-service-route

uri: /api/v1/strategy/*

upstream:

nodes:

- host: strategy-service # K8s Service名称

port: 8080

weight: 100

type: round_robin

plugins:

# 按用户Token限流(从Header获取X-User-Token)

limit-req:

rate: 20 # 每秒20个请求

burst: 5

key_type: var

key: http_x_user_token

# 熔断插件(当策略服务错误率>50%时熔断)

circuit-breaker:

break_response_code: 503

enable: true

key_type: var

key: remote_addr

threshold: 100 # 100个请求中错误率>50%触发熔断

timeout: 30 # 熔断持续30秒

4. 进阶探讨 (Advanced Topics)

4.1 多区域部署与容灾:应对地域级故障

金融系统需满足“两地三中心”等监管要求(如中国《证券期货业信息系统备份能力标准》),避免单区域故障导致服务中断。

实现方案:

多区域部署:在华东、华北各部署一套完整架构(独立K8s集群、数据库、Kafka),通过全球负载均衡(GSLB) 按地域路由用户请求(如华东用户访问华东区域,华北用户访问华北区域);数据同步:核心数据(用户账户、持仓)通过跨区域数据库同步(如MySQL binlog同步)保持一致,非核心数据(行情缓存)本地存储;故障转移:当华东区域不可用时,GSLB自动将流量切换至华北区域,RTO(恢复时间目标)<30分钟。

4.2 AI模型的动态扩展:从“被动扩缩容”到“预测性扩展”

传统HPA基于实时指标(如GPU利用率)扩缩容,存在“滞后性”(指标升高→扩容→资源就绪,需3-5分钟),可能错过流量峰值。

预测性扩展方案:

基于历史数据预测:用时间序列模型(如Prophet)分析过去3个月的流量规律(如开盘前30分钟模型请求量激增),提前30分钟扩容(如每天9:00自动将AI模型节点从5个扩至15个);事件触发扩展:结合外部事件(如重大政策发布、股市开盘/收盘)触发扩容,例如“开盘前1小时启动预热扩容”。

4.3 合规与安全在高并发下的平衡

金融AI系统需满足数据加密(传输/存储)、审计日志、隐私保护(如GDPR)等合规要求,高并发下需避免安全措施成为性能瓶颈。

优化策略:

加密传输:API网关层统一处理SSL终止(HTTPS),避免每个服务单独解密;审计日志异步写入:用户操作日志通过Kafka异步写入审计系统(而非实时写入数据库),降低业务服务延迟;数据脱敏:用户敏感数据(如身份证号)在存储时脱敏(仅存哈希值),AI模型训练时使用差分隐私技术(添加噪声),兼顾模型效果与隐私保护。

4.4 无服务器架构(Serverless)在非实时场景的应用

对于低频、高波动的任务(如月度策略报告生成、用户画像更新),传统容器化部署会导致资源闲置(大部分时间CPU使用率<10%)。

Serverless方案:

用AWS Lambda或阿里云函数计算运行非实时任务,按调用次数付费(闲置时不收费);例如:用户每月1日触发“月度策略报告”生成,Lambda函数从数据库读取数据→调用AI模型分析→生成PDF→发送邮件,任务完成后自动释放资源,成本降低70%。

5. 总结 (Conclusion)

回顾要点

本文从金融AI智能体的“可扩展性痛点”出发,系统讲解了架构设计的核心原则(水平扩展、分层解耦、异步通信等),并通过分层实战(接入层→业务逻辑层→AI模型服务层→数据层),提供了支撑百万用户的完整解决方案。我们还通过真实案例复盘了架构演进过程,并给出了K8s部署、Redis缓存、API限流等关键代码示例。

成果展示

通过本文的架构设计,我们实现了:

弹性扩展:用户量从10万→100万时,系统自动扩容,无需人工干预;性能保障:峰值QPS 5000下,API响应延迟<100ms,AI模型推理延迟<200ms;高可用:99.99% SLA,支持多区域容灾,应对地域级故障;成本优化:按流量动态调整资源,避免闲置浪费,TCO(总拥有成本)降低30%。

鼓励与展望

金融AI智能体的可扩展性设计是“持续演进”的过程——随着用户量增长、AI模型复杂度提升(如从LSTM升级到GPT),架构需不断优化。建议你从“小步快跑”开始:先落地微服务和K8s容器化,再逐步引入Kafka、KServe等组件,最后实现预测性扩展和多区域容灾。

未来,随着边缘计算、量子计算等技术的发展,金融AI架构将向“中心+边缘”混合架构演进(如将部分推理任务放在边缘节点,降低延迟),但“分层解耦”“弹性扩展”等核心原则将长期适用。

6. 行动号召 (Call to Action)

金融AI架构设计充满挑战,但也极具成就感。如果你在实践中遇到以下问题,欢迎在评论区留言讨论:

如何在有限预算下平衡“扩展性”与“成本”?AI模型推理的GPU资源如何高效调度?多区域部署时数据同步的一致性如何保障?

也欢迎分享你的金融AI系统架构演进故事——让我们一起构建更稳定、更智能的投资决策系统!

最后,如果你觉得本文对你有帮助,别忘了点赞+收藏,关注我获取更多金融AI架构实战内容!

暂无评论内容