上一章,当我们费尽心血构建好了“黄金数据集”后,我们面临一个新的难题:谁来改卷子?

在 NLP(自然语言处理)的旧时代,我们有 BLEU 和 ROUGE 这样的机械指标(比对词重叠率)。但在 Agent 时代,答案一般是开放的、复杂的。

本章将探讨 LLM-as-a-Judge 范式,这是目前工业界实现大规模自动化测试的唯一可行路径。同时,我们将深入探讨 2025 年的评测新趋势——成对比较(Pairwise Evaluation)。

在传统的软件测试中,断言(Assertion)是非黑即白的:

assert result == expected_output但在 AI 系统中,如果我们问:“天空为什么是蓝的?”

- 期望输出:“由于瑞利散射。”

- 实际输出:“阳光进入大气层后,短波长的蓝光被气体分子散射……”

这两句话的意思完全一样,但字符串匹配度几乎为 0。如果我们靠人工去审核每一次 CI/CD 的构建结果,不仅慢,而且贵。

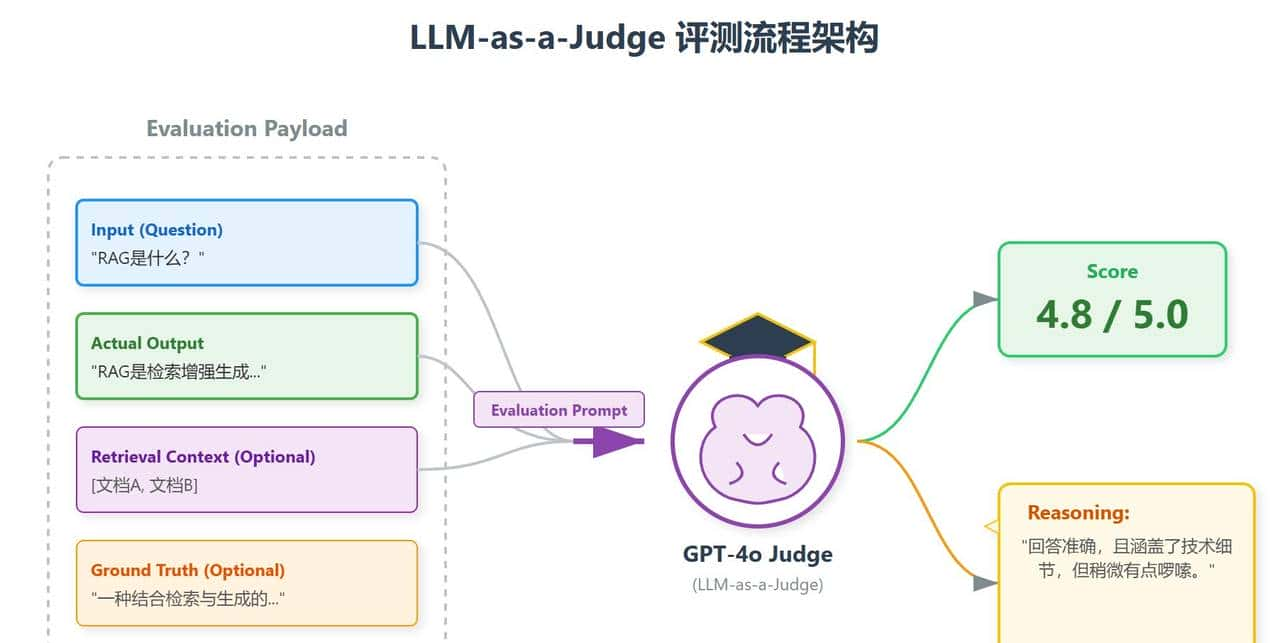

图9.0 LLM-as-a-Judg

LLM-as-a-Judge 的核心思想是:用一个更强的模型(如 GPT-4o),去评测一个较弱的模型(如 Qwen-Turbo)的输出。

它不仅能打分,还能给出理由(Reasoning),就像一位不知疲倦的老师。

9.1 评测架构:G-Eval 范式

目前业界公认的评测标准是 G-Eval (GPT-4 based Evaluation) 框架。

一个标准的 AI 评测流程包含四个要素,如图9.1所示。

图9.1 LLM-as-a-Judge 的标准输入输出流

9.1.1 裁判的提示词 (Judge Prompt)

写好裁判的 Prompt 是评测准确的关键。一个工业级的裁判 Prompt 模板如下:

你是一个公正的 AI 评测员。请根据以下标准对“实际回答”进行打分(1-5分)。

### 评分标准:

1. **有用性 (Helpfulness)**: 回答是否直接解决了用户的问题?

2. **准确性 (Accuracy)**: 回答是否与参考信息 (Context) 冲突?

3. **完整性 (Completeness)**: 是否遗漏了关键细节?

### 输入数据:

- 用户问题: {question}

- 参考信息: {context}

- 实际回答: {answer}

### 输出格式:

请先输出一段简短的评价理由(Reasoning),然后输出最终得分(Score)。

格式示例:

Reasoning: 回答正确,但缺少了关于XX的细节。

Score: 49.2 RAG 指标三剑客:Ragas 体系

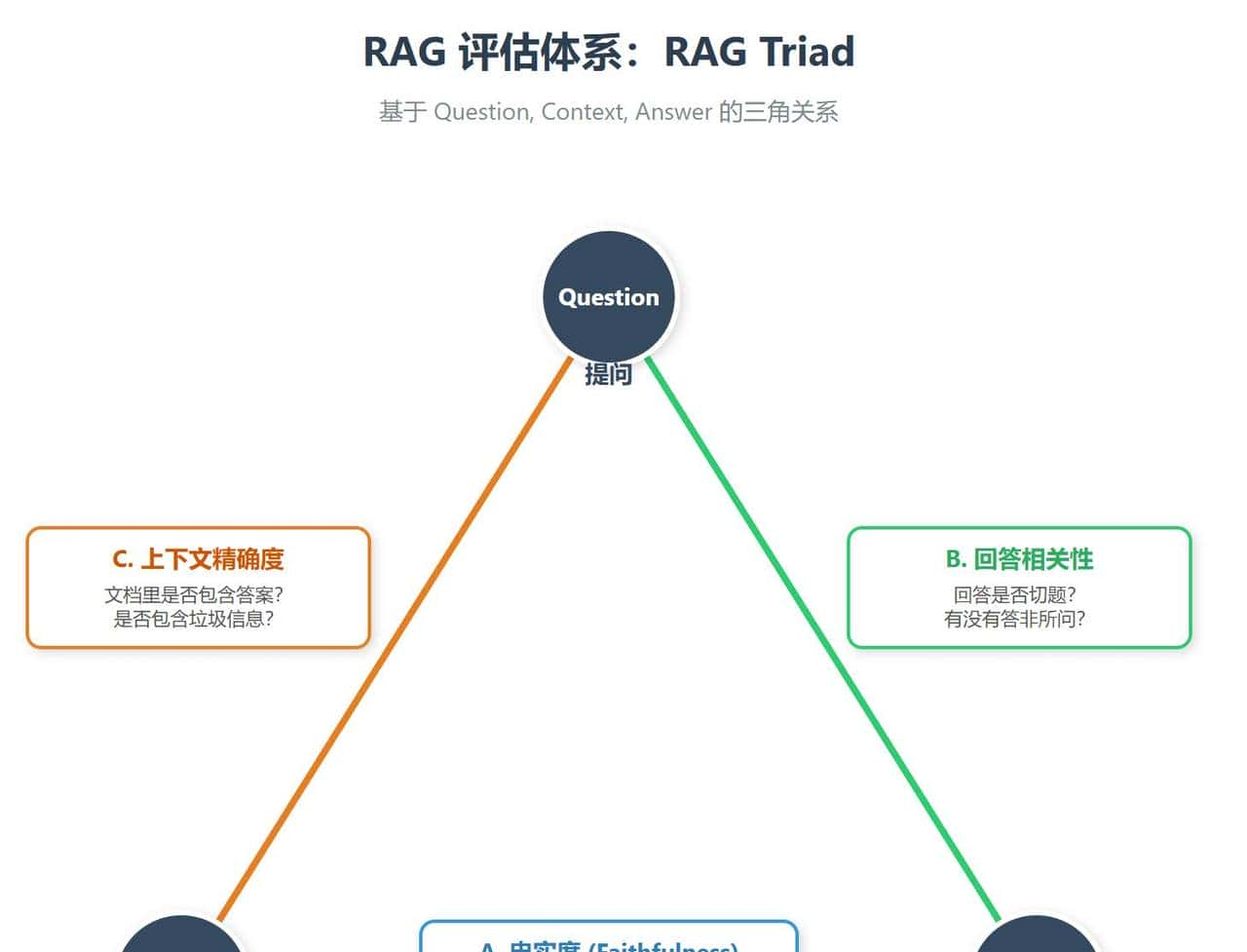

对于 RAG 系统,我们不能只看一个总分。我们需要诊断是哪一步出了问题:是检索没搜到?还是模型没看懂?

Ragas (Retrieval Augmented Generation Assessment) 框架定义了三个核心指标,构成了 RAG 优化的三角,如图9.2所示。

图9.2 RAG 评测的“不可能三角”诊断体系

- 忠实度 (Faithfulness):这是防幻觉的核心指标。裁判会核对 Answer 中的每一句话,看能否在 Context 中找到出处。如果找不到,就是幻觉。

- 上下文准确度 (Context Precision):这是检索引擎的指标。如果搜出来的 5 个文档里只有第 5 个有用,准确度就低,会导致 LLM 分心(Lost in the Middle)。

- 回答相关性 (Answer Relevance):这是指令遵循的指标。用户问“多少钱”,模型回答“天气不错”,相关性为 0。

9.3 2025 新趋势:成对比较 (Pairwise Evaluation)

在 2023-2024 年,我们习惯让模型打绝对分(1-5 分)。

但这有一个严重问题:模型的分数校准极差。

- GPT-4 可能倾向于打高分(平均 4.5)。

- Claude 可能倾向于打保守分(平均 3.8)。

这使得不同裁判之间的分数无法比较。

2025 年的主流趋势是**“成对比较” (Pairwise Comparison)**,也就是 A/B 测试。

我们不问裁判“这个回答得几分?”,而是问:“回答 A 和回答 B,哪个更好?”

9.3.1 Elo Rating (天梯积分)

这借鉴了国际象棋的排名系统。

- 让新模型(Challenger)和旧模型(Champion)进行 100 场 PK。

- 如果 Challenger 赢了,它的 Elo 分上涨。

- 这种相对排名的稳定性远高于绝对打分。

9.3.2 偏见与去偏 (Bias Mitigation)

即便是成对比较,AI 裁判也有偏见:

- 位置偏见 (Positional Bias):模型倾向于认为第一个出现的答案更好。解法:Swap & Average。交换 A 和 B 的顺序测两次。如果两次都选同一个内容,才算有效。

- 长度偏见 (Verbosity Bias):模型倾向于认为更长的答案更好(哪怕是废话)。解法:在 Prompt 中明确惩罚啰嗦:“更简洁的答案应获得更高评价”。

- 自我中心偏见 (Self-Preference):GPT-4 更喜爱 GPT-4 风格的回答。解法:Judge Mixture。同时引入 Claude 和 GPT-4 当裁判,取投票结果。

9.4 实战:使用 DeepEval 进行自动化评测

DeepEval 是目前最流行的开源 LLM 评测框架。它将评测封装成了类似于 Pytest 的体验。

from deepeval import assert_test

from deepeval.test_case import LLMTestCase

from deepeval.metrics import FaithfulnessMetric, AnswerRelevancyMetric

def test_rag_system():

# 1. 准备测试用例 (来自 Golden Dataset)

test_case = LLMTestCase(

input="咱们公司的CEO是谁?",

actual_output="公司的CEO是张三。",

retrieval_context=["2024年财报显示,张三被任命为首席执行官。"]

)

# 2. 定义裁判指标

# 这里的 threshold=0.7 意味着置信度必须由 GPT-4 打分超过 7分(满分10)

metric_faithfulness = FaithfulnessMetric(threshold=0.7, model="gpt-4o")

metric_relevance = AnswerRelevancyMetric(threshold=0.8, model="gpt-4o")

# 3. 运行评测 (Assert)

# 这一步会自动调用 GPT-4 进行判卷,如果分数不够,测试失败

assert_test(test_case, [metric_faithfulness, metric_relevance])

# 运行: deepeval test run test_file.py在 CI/CD 流水线中,如果 assert_test 失败,Pipeline 会直接红灯,阻止这版糟糕的代码上线。这才是评估驱动开发 (EDD) 的完全体。

9.5 成本控制:级联评测 (Cascade Judging)

用 GPT-4o 当裁判很贵。如果我们要跑 1000 个测试用例,成本可能高达几十美元。

架构师需要设计级联评测策略:

- L1: 规则裁判 (Rule-based Judge),检查 JSON 格式、关键词匹配、黑名单。成本 $0。

- L2: 小模型裁判 (Small Model Judge),使用专门微调过的评测模型(如 Prometheus-7B 或 JudgeLM)。它们在打分任务上逼近 GPT-4,但成本低 10 倍。

- L3: 权威裁判 (GPT-4o),只有当 L2 裁判觉得“模棱两可”(置信度低)时,才升级给 GPT-4o 进行最终裁决。

本章小结

本章我们解决了“谁来监督 AI”的问题。

- LLM-as-a-Judge 是实现 AI 自动化的唯一解。

- Ragas 提供了 RAG 系统的诊断听诊器。

- Pairwise Evaluation 取代了绝对打分,成为更客观的标准。

- 级联评测 让我们在成本和准确度之间找到平衡。

有了数据(第8章)和裁判(第9章),我们终于可以放心地将评估集成到自动化流水线中,实现真正的自动化测试框架。这正是下一章的内容。

思考与面试角

Q1:为什么说“人工评测”在长远来看是不可行的?

参考答案:除了慢和贵,人工评测最大的问题是不可复现(Non-reproducible)和标准不一(Inconsistent)。张三心情好给 5 分,李四心情不好给 3 分。而 LLM 裁判(尤其是设置了 temperature=0 后)是确定性的,它保证了每次代码提交都在用同一把尺子衡量。

Q2:Faithfulness (忠实度) 高就代表回答正确吗?

参考答案:不必定。忠实度高只代表**“没有幻觉”**(回答完全基于 Context)。但如果 Context 本身是错的(检索到了过期的旧文档),那么模型忠实地回答了错误信息,这依然是一个错误的回答(Correctness 低)。所以必须结合 Ground Truth 来综合评估。

Q3:如何发现 AI 裁判的“自我中心偏见”?

参考答案:做一个交叉盲测。用 GPT-4 生成一组答案,用 Claude 生成一组答案。然后分别让 GPT-4 和 Claude 去当裁判。如果 GPT-4 显著偏向自己生成的答案(胜率远高于 Claude 裁判给出的胜率),就说明存在自我偏见。此时应引入第三个中立模型(如 Llama-3)或取平均值。

暂无评论内容