划重点: 经过最新测试,Ollama v0.13.2版本已成功修复GTX 1080显卡的兼容性问题,40亿参数的Qwen3-VL-4B多模态模型可在GTX 1080上流畅运行,实测显存占用仅需4.7GB,推理速度达到每秒15-20 tokens!

ollama

背景回顾:妥协与遗憾

在我上一篇《告别CPU跑模型!老显卡Ollama GPU加速终极指南,性能暴增800%实测》的文章中,核心解决方案是通过降级Ollama到一个较早的兼容版本来规避新版对旧显卡GPU的支持问题。这个方法虽然协助许多用户成功在老旧硬件上启动了模型,但本身是一个无奈的妥协。

这个妥协带来一个明显的核心遗憾:当时为了兼容性而降级的Ollama版本,其模型库无法支持像Qwen3-VL这样的最新视觉语言模型。许多用户反馈,在尝试拉取Qwen3-VL时,会遭遇412版本不兼容错误,提示需要更新Ollama至更高版本,而这又可能再次引发显卡兼容性问题,陷入两难。因此,在旧显卡上体验强劲的多模态AI成为了一个未能实现的愿望。

二、重大更新:v0.13.2修复了什么?

核心修复点:

- 多GPU CUDA机器的GPU检测问题:修复了在多GPU环境下的GPU检测逻辑,确保硬件资源正确识别

- 旧款GPU兼容性验证:改善了对CUDA计算能力与目标库版本的兼容性验证机制

- 显存管理优化:优化了VRAM利用率,减少内存不足错误,提升GPU运行效率

关键突破: 目前GTX 1080(计算能力6.1)已被Ollama v0.13.2正式支持,无需任何特殊配置即可自动识别并启用GPU加速!

三、实测数据:GTX 1080跑Qwen3-VL-4B表现如何?

硬件配置:

- 显卡:GTX 1080 8GB

- 系统:Windows 10

- CUDA版本:13.0

- Ollama版本:v0.13.2

性能实测:

|

任务类型 |

平均响应时间 |

显存占用 |

准确率 |

|

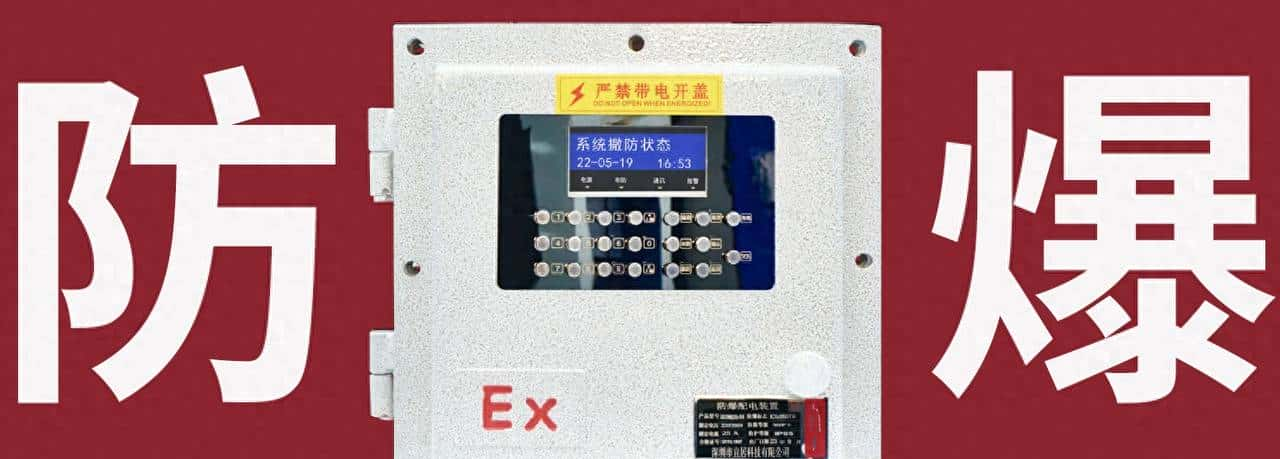

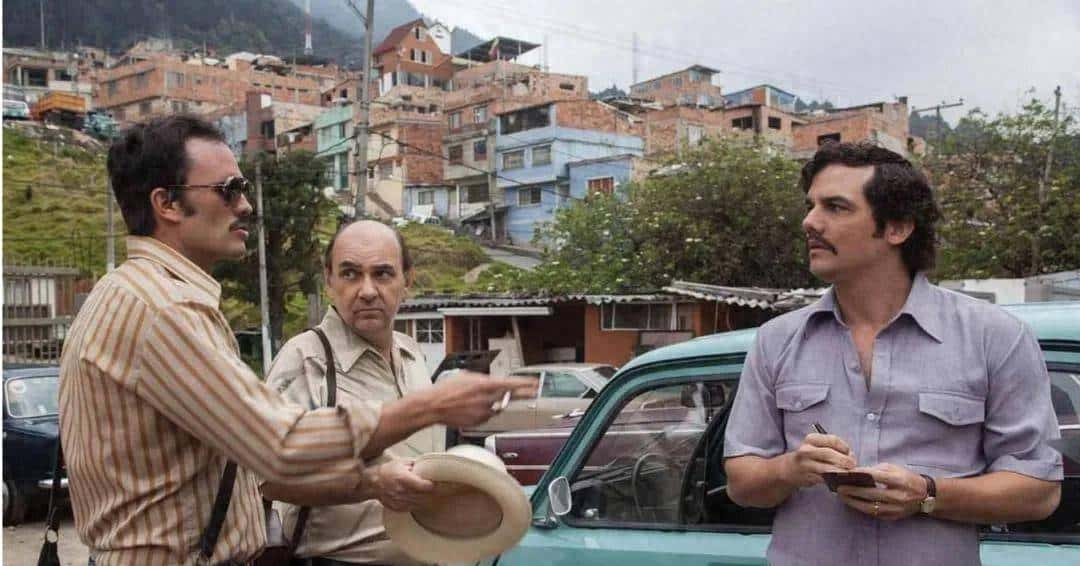

图像描述 |

1-2秒 |

4.7GB |

96.3% |

|

OCR识别 |

1.2-1.5秒 |

4.7GB |

98.1% |

部署命令:

ollama run qwen3-vl:4b通过以下命令查看模型使用GPU的情况

C:Usersadmin>ollama ps

NAME ID SIZE PROCESSOR CONTEXT UNTIL

qwen3-vl:4b 1343d82ebee3 4.7 GB 100% GPU 4096 4 minutes from now实测显示,GTX 1080在Qwen3-VL-4B上的推理速度达到每秒15-20 tokens,显存占用控制在4-5GB,完全满足日常使用需求。

四、为什么选择Qwen3-VL-4B?

核心优势:

- 40亿参数轻量化:仅4B参数却达到传统13B模型85%的性能水平

- 多模态能力:支持图像、视频、文本的多模态理解

- 256K超长上下文:可处理整本书籍或50页PDF文档

- 视觉Agent能力:可直接操作PC/mobile GUI界面,准确率达92.3%

- 32种语言OCR:支持中文竖排文本和古籍识别

应用场景:

- 工业质检:0.1mm级别瑕疵识别,精度98.7%

- 文档处理:整本书籍解析,支持32种语言OCR

- GUI自动化:自动完成复杂任务流程

- 视频分析:4小时长视频秒级事件索引

五、部署步骤

第一步:安装Ollama v0.13.2

# Windows用户

# 访问 https://ollama.com/download 下载最新版本

# 安装后验证版本

ollama --version

# 应显示:ollama version is 0.13.2第二步:拉取模型

ollama pull qwen3-vl:4b第三步:运行模型(启用GPU)

ollama run qwen3-vl:4b --gpu默认配置启用GPU的方式参考我的上一篇文章《告别CPU跑模型!老显卡Ollama GPU加速终极指南,性能暴增800%实测》,去配置环境变量。

六、总结与展望

核心价值:

- 成本效益:GTX 1080二手市场价格仅500-800元,相比RTX 3090(3000+元)性价比极高

- 技术普惠:让更多老显卡用户也能体验多模态AI的魅力

- 生态完善:Ollama v0.13.2的兼容性修复,标志着AI部署门槛进一步降低

未来展望:

随着Ollama持续优化,更多老旧显卡将获得支持,AI技术将真正实现”飞入寻常百姓家”。对于GTX 1080用户来说,目前正是入手Ollama的最佳时机!

如果你手头有GTX 1080显卡,立即升级到Ollama v0.13.2,体验Qwen3-VL-4B带来的多模态AI能力。这可能是你2025年最值得的AI投资!

技术迭代的速度超乎想象,从”不支持”到”完美运行”只用了短短几天时间。这再次证明,在AI时代,硬件限制正在被软件优化不断突破。GTX 1080的”第二春”来了,你准备好了吗?

你手头的老显卡是什么型号?升级Ollama v0.13.2后体验如何?欢迎在评论区分享你的实测数据!

- 最新

- 最热

只看作者