Transformer 用于处理不定长的序列输入并生成不定长的输出,却不包含RNN。仅使用注意力机制的Transformer不仅有良好的效果,其并行能力也比RNN大大提高。

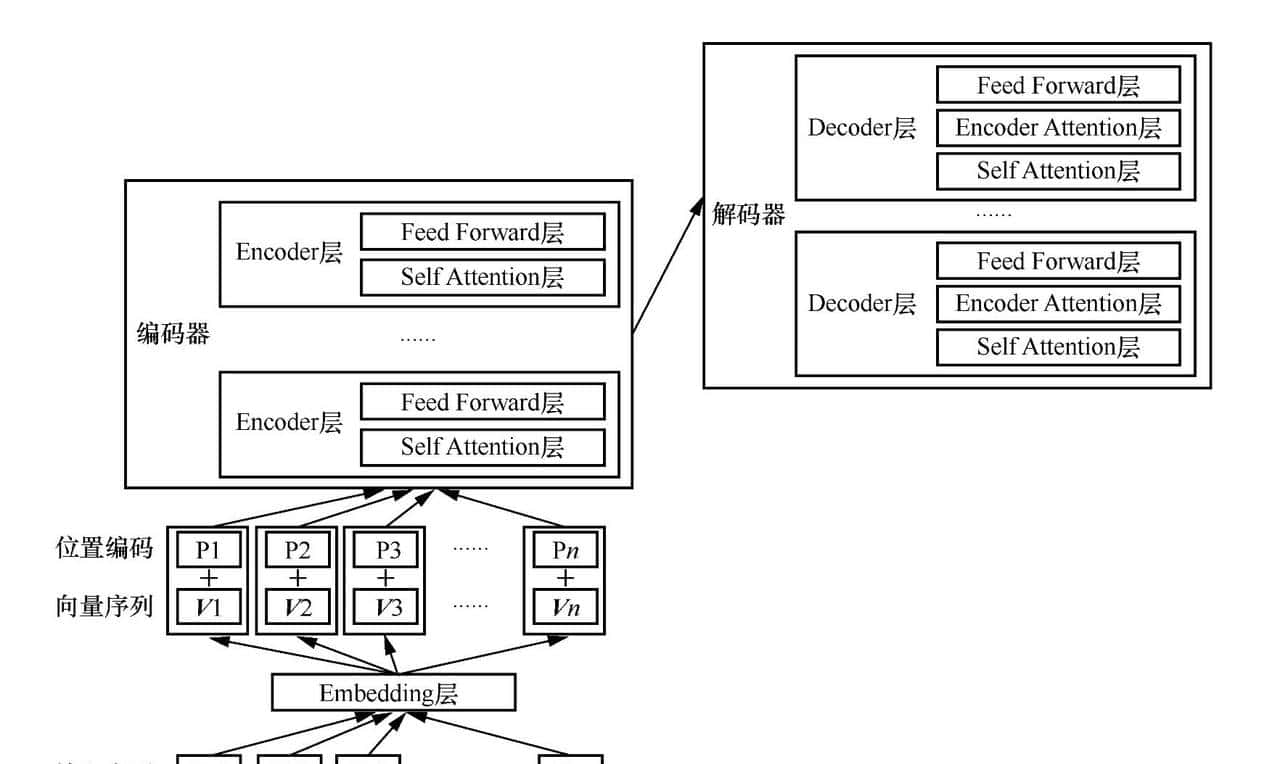

Transformer也是一种Seq2seq,它的编码器和解码器的主体结构采用自注意力机制。其编码器和解码器都由多个编码器层和解码器层构成。

编码器层又包含两个子层,分别是自注意力子层和Feed Forward子层。Feed Forward就是前馈神经网络。解码器的子层多了一个编码器到解码器的注意力的层。

如下是Transformer结构示意图。

输入序列要经过Embedding层得到词向量,然后词向量会叠加代表序列位置信息的位置编码序列,相加后的序列作为编码器的输入。

Transformer结构是GPT和BERT等模型的基本结构,甚至在图像处理领域,Transformer结构也取得了优秀的成绩。

Huggingface Transformers 是基于一个开源基于 transformer 模型结构提供的预训练语言库,它支持 Pytorch,Tensorflow2.0,并且支持两个框架的相互转换。框架支持了最新的各种NLP预训练语言模型,使用者可以很快速的进行模型的调用,并且支持模型further pretraining 和 下游任务fine-tuning。

#Transformer##暑期创作大赛#

© 版权声明

文章版权归作者所有,未经允许请勿转载。如内容涉嫌侵权,请在本页底部进入<联系我们>进行举报投诉!

THE END

暂无评论内容