在大模型推理的PD分离架构中,KV Cache既是支撑推理流程的“核心枢纽”,也是制约性能突破的“关键瓶颈”——它的存储量会随上下文长度呈线性扩容,单靠GPU显存根本无法承载长文本处理、高并发访问等实际业务场景的需求。而NVMe SSD搭配NVFile并行文件存储的组合,恰好精准命中“存储容量不足”与“读写速度滞后”两大痛点,成为PD分离架构落地的核心支撑,其背后的技术逻辑可拆解为三大关键环节:

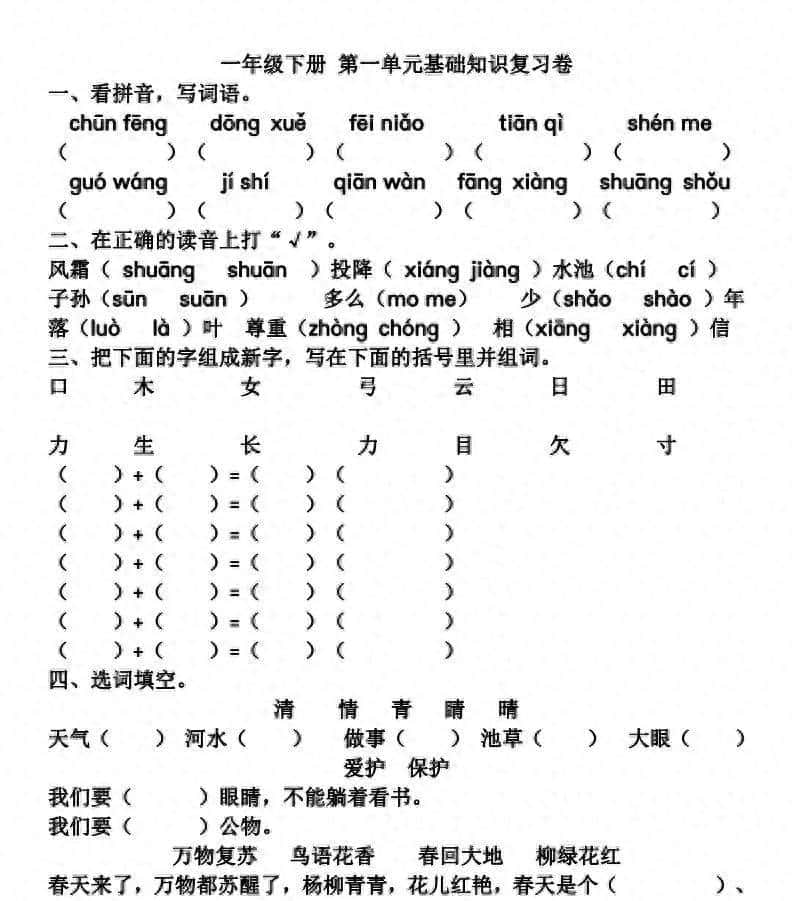

一、基础逻辑:PD分离架构为何离不开“高速缓存载体”?

PD分离的核心设计,是将推理流程拆分为两大核心阶段:Prefill阶段依托GPU算力完成输入数据的并行处理,生成初始KV Cache;Decode阶段则需要反复调取已生成的KV Cache,逐token完成预测推理。这一流程对KV Cache提出了双重严苛要求:既要满足“大容量存储”以承载长上下文数据,又要保证“高速读写”以避免推理延迟飙升。

若仅依赖GPU显存存储KV Cache,即便采用80GB级别的高端显卡,也难以支撑千token级长上下文与多用户并发访问的叠加需求;若改用普通SATA SSD存储,其读写速度又会成为致命短板——SATA接口的传输速率仅500MB/s左右,且IO响应延迟达毫秒级,完全跟不上Decode阶段微秒级的KV Cache调取需求,直接导致推理效率断崖式下降。因此,PD分离架构迫切需要一种“容量充足、速度拔尖”的高速缓存载体,而NVMe SSD+NVFile的组合恰好完美匹配这一需求。

二、核心支撑:NVMe SSD——打破存储速度桎梏,筑牢“缓存粮仓”

普通SATA SSD因接口与协议限制,始终无法突破速度瓶颈,而NVMe SSD天生为高速存储场景而生,成为替代GPU显存承载KV Cache的理想选择:

– 接口层面直连PCIe通道,传输速率可达3-8GB/s,是普通SATA SSD的6-16倍,能实现KV Cache数据的高速搬运,满足Decode阶段的高频调取需求;

– 搭载NVMe协议,绕开了传统磁盘控制器的冗余处理流程,将IO响应延迟压缩至微秒级(部分高端产品甚至低至10-50μs),接近GPU显存与内存的交互延迟,不会拖慢整体推理节奏;

– 存储容量极具优势,单盘容量可达数TB,多盘组合后可轻松扩容至数十TB级别,能稳稳承载海量KV Cache数据,大幅缓解GPU显存的存储压力。

三、性能放大:NVFile并行存储——解锁NVMe潜力,适配高频读写场景

单块NVMe SSD虽能解决“容量”与“基础速度”问题,但面对Decode阶段“高频小批量”的KV Cache读写特性,仍存在IO并发能力不足的短板——多用户同时调取数据时,单盘极易出现卡顿。而NVFile这类并行文件存储,通过“聚合算力+智能调度”,进一步放大NVMe SSD的性能优势,补全最后一块短板:

– 支持多NVMe SSD并行读写,通过智能负载均衡算法将KV Cache拆分存储至多块磁盘,可同时响应多个Decode请求,让系统并发处理能力翻倍;

– 优化缓存调度逻辑,采用“分层存储”策略:将高频访问的“热KV Cache”优先存储在靠近GPU的高速层(如内存缓存),低频访问的“冷KV Cache”则存储在NVMe集群中,最大限度减少数据搬运距离,提升调取效率;

– 深度兼容PD分离架构,能与主流推理引擎快速对接,避免因协议适配产生的性能损耗,让KV Cache实现“存得稳、取的顺”,全程支撑推理流程高效运转。

暂无评论内容