如何利用数据分析提高电商客户满意度

关键词:数据分析、电商、客户满意度、机器学习、用户行为分析、个性化推荐、客户流失预测

摘要:本文深入探讨如何利用数据分析技术提升电商平台的客户满意度。我们将从数据收集、处理、分析到实际应用的全流程进行详细讲解,包括用户行为分析、个性化推荐系统、客户流失预测等关键技术。通过实际案例和代码实现,展示如何将数据分析转化为可执行的商业策略,最终实现客户满意度和商业价值的双提升。

1. 背景介绍

1.1 目的和范围

在竞争激烈的电商领域,客户满意度已成为决定企业成败的关键因素。本文旨在:

系统介绍数据分析在提升电商客户满意度中的应用方法提供可落地的技术方案和实施步骤分享实际案例和最佳实践

范围涵盖从数据收集到分析应用的全流程,重点解决电商领域的三个核心问题:

如何准确理解客户需求如何预测客户行为如何实施有效的满意度提升策略

1.2 预期读者

本文适合以下读者:

电商平台的数据分析师和工程师产品经理和运营人员技术决策者和管理者对电商数据分析感兴趣的研究人员

1.3 文档结构概述

本文采用循序渐进的结构:

首先介绍核心概念和技术基础然后深入算法原理和数学模型接着通过实际案例展示应用方法最后探讨未来趋势和挑战

1.4 术语表

1.4.1 核心术语定义

客户满意度(CSAT): 衡量客户对产品或服务满意程度的指标净推荐值(NPS): 反映客户忠诚度和推荐意愿的指标RFM模型: 最近购买(Recency)、购买频率(Frequency)、消费金额(Monetary)组成的客户价值分析模型协同过滤: 基于用户行为的推荐算法

1.4.2 相关概念解释

A/B测试: 通过对比不同版本确定最优方案的方法购物车放弃率: 将商品加入购物车但未完成购买的比例转化漏斗: 描述用户从访问到购买的转化过程

1.4.3 缩略词列表

| 缩略词 | 全称 | 解释 |

|---|---|---|

| CSAT | Customer Satisfaction Score | 客户满意度评分 |

| NPS | Net Promoter Score | 净推荐值 |

| RFM | Recency, Frequency, Monetary | 客户价值分析模型 |

| CTR | Click Through Rate | 点击率 |

| LTV | Lifetime Value | 客户终身价值 |

2. 核心概念与联系

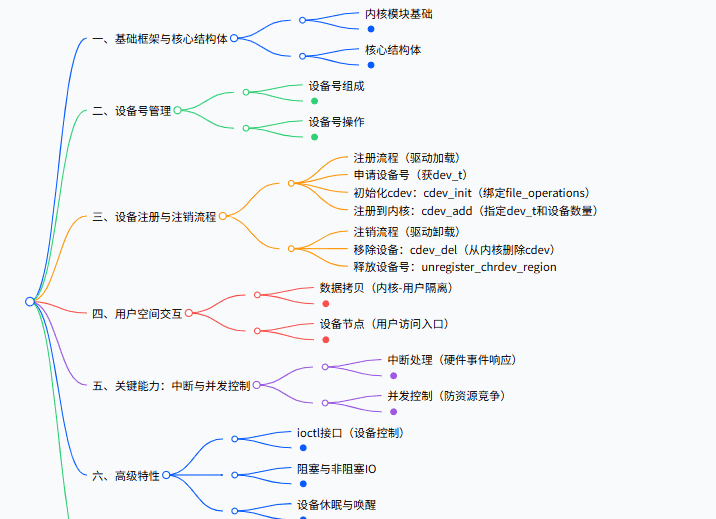

电商客户满意度数据分析的核心框架如下图所示:

2.1 数据来源与类型

电商平台可收集的数据主要分为四类:

用户行为数据:

页面浏览路径点击流数据搜索关键词停留时间

交易数据:

订单信息支付方式退换货记录优惠券使用

评价数据:

商品评分文字评价图片/视频反馈

客服数据:

咨询记录投诉内容解决时效

2.2 分析维度与方法

基于上述数据,我们可以从多个维度进行分析:

用户画像分析:

人口统计学特征购买偏好价格敏感度

行为路径分析:

典型购买路径转化漏斗异常行为检测

情感分析:

评价情感倾向客服对话情绪分析社交媒体舆情

预测分析:

购买预测流失预警满意度预测

3. 核心算法原理 & 具体操作步骤

3.1 用户分群算法

用户分群是理解客户需求的基础。我们使用K-means算法进行客户细分:

from sklearn.cluster import KMeans

from sklearn.preprocessing import StandardScaler

import pandas as pd

# 示例数据:包含RFM特征的客户数据

data = pd.read_csv('customer_data.csv')

# 数据标准化

scaler = StandardScaler()

scaled_data = scaler.fit_transform(data[['recency', 'frequency', 'monetary']])

# 确定最佳K值 - 肘部法则

wcss = []

for i in range(1, 11):

kmeans = KMeans(n_clusters=i, init='k-means++', random_state=42)

kmeans.fit(scaled_data)

wcss.append(kmeans.inertia_)

# 可视化肘部曲线选择最佳K值

import matplotlib.pyplot as plt

plt.plot(range(1, 11), wcss)

plt.title('Elbow Method')

plt.xlabel('Number of clusters')

plt.ylabel('WCSS')

plt.show()

# 应用K-means聚类

kmeans = KMeans(n_clusters=5, init='k-means++', random_state=42)

clusters = kmeans.fit_predict(scaled_data)

# 将聚类结果添加到原始数据

data['cluster'] = clusters

3.2 协同过滤推荐算法

个性化推荐是提升满意度的有效手段。基于用户的协同过滤算法实现:

import numpy as np

from sklearn.metrics.pairwise import cosine_similarity

# 用户-商品评分矩阵示例

ratings = {

'User1': {'ItemA': 5, 'ItemB': 3, 'ItemC': 4},

'User2': {'ItemA': 4, 'ItemB': 2, 'ItemC': 5},

'User3': {'ItemA': 2, 'ItemB': 5, 'ItemC': 3},

}

# 构建完整的用户-商品矩阵

items = ['ItemA', 'ItemB', 'ItemC']

users = list(ratings.keys())

matrix = np.zeros((len(users), len(items)))

for i, user in enumerate(users):

for j, item in enumerate(items):

matrix[i,j] = ratings[user].get(item, 0)

# 计算用户相似度

user_similarity = cosine_similarity(matrix)

# 预测用户对未评分商品的评分

def predict_rating(user_idx, item_idx):

# 找到与目标用户相似的其他用户

similar_users = np.argsort(user_similarity[user_idx])[::-1][1:]

numerator = 0

denominator = 0

for sim_user in similar_users:

if matrix[sim_user, item_idx] > 0: # 只考虑已评分的用户

similarity = user_similarity[user_idx, sim_user]

numerator += similarity * matrix[sim_user, item_idx]

denominator += similarity

if denominator == 0:

return 0

return numerator / denominator

# 为User1推荐商品

user_idx = 0

predicted_ratings = [predict_rating(user_idx, j) for j in range(len(items))]

recommended_item_idx = np.argmax(predicted_ratings)

print(f"推荐给{users[user_idx]}的商品是: {items[recommended_item_idx]}")

3.3 客户流失预测模型

使用XGBoost预测可能流失的客户:

import xgboost as xgb

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score, classification_report

# 假设我们有包含客户特征和是否流失标签的数据

data = pd.read_csv('customer_churn_data.csv')

X = data.drop('churn', axis=1)

y = data['churn']

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 创建XGBoost分类器

model = xgb.XGBClassifier(

objective='binary:logistic',

n_estimators=100,

max_depth=5,

learning_rate=0.1,

subsample=0.8,

colsample_bytree=0.8

)

# 训练模型

model.fit(X_train, y_train)

# 预测测试集

y_pred = model.predict(X_test)

# 评估模型

print("准确率:", accuracy_score(y_test, y_pred))

print(classification_report(y_test, y_pred))

# 获取特征重要性

importance = model.feature_booster().get_score(importance_type='weight')

sorted_importance = sorted(importance.items(), key=lambda x: x[1], reverse=True)

print("特征重要性:")

for feat, score in sorted_importance:

print(f"{feat}: {score}")

4. 数学模型和公式 & 详细讲解 & 举例说明

4.1 客户满意度预测模型

我们可以使用逻辑回归模型预测客户满意度:

其中:

P(CSAT=1∣X)P(CSAT=1|X)P(CSAT=1∣X) 表示给定特征X时客户满意的概率β0eta_0β0 是截距项β1eta_1β1到βneta_nβn 是各特征的系数X1X_1X1到XnX_nXn 是客户特征变量

举例说明:

假设我们有以下简化模型:

β0=−2.5eta_0 = -2.5β0=−2.5β1eta_1β1(配送速度) = 0.8β2eta_2β2(商品质量) = 1.2β3eta_3β3(价格敏感度) = -0.5

对于某客户:

配送速度评分(X1) = 4(5分制)商品质量评分(X2) = 5价格敏感度(X3) = 3

计算其满意概率:

该客户有93.7%的概率会给出满意评价。

4.2 推荐系统的矩阵分解

协同过滤的矩阵分解模型可以表示为:

其中:

r^uihat{r}_{ui}r^ui 是用户u对商品i的预测评分qiq_iqi 是商品i的潜在特征向量pup_upu 是用户u的潜在特征向量

优化目标是最小化以下损失函数:

其中:

κ 是已知评分的集合λ 是正则化参数∣∣⋅∣∣2||·||^2∣∣⋅∣∣2 表示L2范数

4.3 客户终身价值(LTV)计算

客户终身价值的预测模型:

其中:

GCtGC_tGCt 是第t期的毛利润d 是折现率P(active)tP(active)_tP(active)t 是客户在第t期仍然活跃的概率T 是预测的时间范围

计算示例:

假设某客户:

年均消费: $1000毛利率: 30%年保留率: 80%折现率: 10%预测年限: 3年

计算其LTV:

| 年份 | 毛利润 | 保留概率 | 折现因子 | 现值 |

|---|---|---|---|---|

| 1 | $300 | 1.0 | 0.909 | $272.73 |

| 2 | $300 | 0.8 | 0.826 | $198.35 |

| 3 | $300 | 0.64 | 0.751 | $144.24 |

LTV = $272.73 + $198.35 + $144.24 = $615.32

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

推荐使用以下环境进行电商数据分析项目:

Python环境:

conda create -n ecommerce python=3.8

conda activate ecommerce

pip install numpy pandas scikit-learn matplotlib seaborn xgboost lightgbm tensorflow

数据库:

MongoDB (存储用户行为数据)PostgreSQL (存储结构化交易数据)

大数据处理:

PySpark (处理大规模数据)Dask (并行计算)

可视化工具:

Tableau/Power BIPlotly/Dash (交互式可视化)

5.2 源代码详细实现和代码解读

5.2.1 用户行为分析管道

from pyspark.sql import SparkSession

from pyspark.sql.functions import col, count, when

# 初始化Spark会话

spark = SparkSession.builder

.appName("EcommerceBehaviorAnalysis")

.config("spark.executor.memory", "4g")

.getOrCreate()

# 加载用户行为数据

behavior_df = spark.read.parquet("hdfs://path/to/behavior_data/*.parquet")

# 计算关键行为指标

behavior_metrics = behavior_df.groupBy("user_id").agg(

count(when(col("event_type") == "page_view", True)).alias("page_views"),

count(when(col("event_type") == "product_click", True)).alias("product_clicks"),

count(when(col("event_type") == "add_to_cart", True)).alias("add_to_carts"),

count(when(col("event_type") == "purchase", True)).alias("purchases")

)

# 计算转化率

behavior_metrics = behavior_metrics.withColumn(

"click_to_cart_rate",

col("add_to_carts")/col("product_clicks")

).withColumn(

"cart_to_purchase_rate",

col("purchases")/col("add_to_carts")

)

# 识别异常行为(可能作弊或爬虫)

behavior_metrics = behavior_metrics.withColumn(

"abnormal_behavior",

when(

(col("page_views") > 1000) |

((col("product_clicks") > 100) & (col("purchases") == 0)),

True

).otherwise(False)

)

# 保存结果

behavior_metrics.write.parquet("hdfs://path/to/behavior_metrics/")

5.2.2 实时推荐系统实现

import numpy as np

from flask import Flask, request, jsonify

from redis import Redis

import pickle

app = Flask(__name__)

redis = Redis(host='localhost', port=6379, db=0)

# 加载预训练的推荐模型

with open('recommendation_model.pkl', 'rb') as f:

model = pickle.load(f)

# 商品特征矩阵

item_features = np.load('item_features.npy')

@app.route('/recommend', methods=['POST'])

def recommend():

# 获取用户ID和历史行为

user_id = request.json['user_id']

user_history = request.json.get('history', [])

# 从Redis获取用户特征向量

user_key = f"user:{user_id}"

user_vec = redis.get(user_key)

if user_vec is None:

# 新用户冷启动处理

user_vec = np.mean(item_features, axis=0)

else:

user_vec = pickle.loads(user_vec)

# 计算用户-商品得分

scores = np.dot(item_features, user_vec)

# 排除已购买商品

if user_history:

scores[user_history] = -np.inf

# 获取Top N推荐

top_n = 5

recommended_indices = np.argsort(scores)[-top_n:][::-1]

# 更新用户向量(基于最新点击)

latest_click = request.json.get('latest_click')

if latest_click is not None:

user_vec = 0.9 * user_vec + 0.1 * item_features[latest_click]

redis.set(user_key, pickle.dumps(user_vec), ex=86400) # 缓存1天

return jsonify({

"user_id": user_id,

"recommendations": recommended_indices.tolist(),

"scores": scores[recommended_indices].tolist()

})

if __name__ == '__main__':

app.run(host='0.0.0.0', port=5000)

5.3 代码解读与分析

用户行为分析管道解析

数据加载:

使用PySpark处理大规模用户行为数据支持Parquet列式存储格式,高效压缩和查询

指标计算:

统计关键用户行为事件(浏览、点击、加购、购买)计算转化率指标,识别转化瓶颈

异常检测:

定义业务规则识别可疑行为可结合机器学习模型提高准确性

扩展性:

代码设计为分布式执行,可处理TB级数据输出结果可直接用于下游分析和应用

实时推荐系统解析

架构设计:

微服务架构,通过HTTP API提供服务Redis缓存用户特征,实现低延迟访问

推荐逻辑:

基于矩阵分解的协同过滤算法处理新用户冷启动问题实时更新用户特征向量

性能优化:

向量化计算(numpy)提高性能预加载模型和特征矩阵减少延迟

扩展方向:

可加入多样性控制避免推荐过于相似商品可结合上下文信息(时间、地点)改进推荐

6. 实际应用场景

6.1 个性化营销活动

问题:传统营销活动转化率低,ROI不理想

解决方案:

基于用户分群设计差异化营销内容预测每个用户的最佳优惠券面额确定最优发送时机(基于活跃模式预测)

实施效果:

某电商平台实现营销邮件打开率提升40%优惠券核销率从8%提高到22%整体营销成本降低35%

6.2 智能客服优化

问题:客服响应慢,客户等待时间长

解决方案:

分析历史咨询数据,预测咨询高峰时段基于问题类型自动路由给最适合的客服实时监控对话情绪,及时升级高不满风险会话

实施效果:

平均响应时间从5分钟缩短至90秒客户满意度评分提升25%客服人力成本降低20%

6.3 动态定价策略

问题:固定定价导致部分客户流失

解决方案:

基于用户价格敏感度分群实时监测库存和需求变化个性化定价和促销策略

实施效果:

高价格敏感客户转化率提升18%整体利润率提高7%客户抱怨降价不公平的情况减少60%

6.4 供应链优化

问题:库存积压与缺货并存

解决方案:

基于用户行为预测商品需求优化区域仓库存分配预测配送时效并承诺最优送达时间

实施效果:

库存周转率提升30%配送准时率从85%提高到98%因缺货导致的订单取消减少45%

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

《数据驱动:从方法到实践》- 深入讲解数据驱动的决策方法《推荐系统实践》- 全面介绍推荐系统原理与实现《客户终身价值管理》- 系统阐述CLV理论与应用

7.1.2 在线课程

Coursera: “Machine Learning for Business Professionals” (Google)edX: “Data Science for Business Innovation” (Microsoft)Udacity: “AI for Business Leaders” (纳米学位)

7.1.3 技术博客和网站

Towards Data Science (Medium)Kaggle学习资源Google Analytics博客

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

Jupyter Notebook/Lab (交互式数据分析)VS Code (轻量级代码编辑)PyCharm Professional (完整Python开发环境)

7.2.2 调试和性能分析工具

PySpark UI (监控Spark作业)TensorBoard (可视化模型训练)cProfile (Python性能分析)

7.2.3 相关框架和库

PyTorch/TensorFlow (深度学习)LightGBM/XGBoost (梯度提升树)Surprise (推荐系统工具包)

7.3 相关论文著作推荐

7.3.1 经典论文

“Amazon.com Recommendations: Item-to-Item Collaborative Filtering” (2003)“The Netflix Recommender System: Algorithms, Business Value, and Innovation” (2016)“Deep Neural Networks for YouTube Recommendations” (2016)

7.3.2 最新研究成果

“Transformers for Recommendation Systems: A Survey” (2022)“Self-supervised Learning for Recommendation Systems” (2023)“Causal Inference in Customer Analytics” (2023)

7.3.3 应用案例分析

Alibaba双11大数据实战Amazon个性化推荐系统演进Netflix客户留存优化案例

8. 总结:未来发展趋势与挑战

8.1 未来发展趋势

实时化:

从批量分析向实时分析演进流式计算框架的广泛应用毫秒级决策支持

智能化:

深度学习在客户分析中的深入应用自动特征工程和模型选择可解释AI增强决策可信度

全渠道整合:

线上线下数据融合跨平台用户身份识别统一客户视图构建

隐私保护:

联邦学习应用差分隐私技术合规数据使用框架

8.2 主要挑战

数据质量问题:

数据缺失和不一致采样偏差问题概念漂移(客户行为变化)

模型可解释性:

复杂模型的黑箱特性业务人员理解困难监管合规要求

实施障碍:

组织数据文化缺乏部门数据孤岛技能缺口

伦理问题:

算法偏见和公平性过度个性化导致的”信息茧房”数据使用边界

8.3 应对策略

建立数据治理体系:

制定数据标准和流程实施数据质量监控构建企业级数据仓库

人才培养计划:

数据分析师业务培训业务人员数据素养提升跨职能团队建设

渐进式实施路径:

从具体业务问题切入快速验证和价值证明逐步扩展应用范围

伦理框架构建:

成立AI伦理委员会开发公平性检测工具客户数据使用透明化

9. 附录:常见问题与解答

Q1: 如何平衡个性化推荐和用户隐私保护?

A: 可采用以下策略:

数据最小化原则:只收集必要的推荐相关数据匿名化处理:使用差分隐私或联邦学习技术透明控制:提供隐私设置面板,让用户自主控制聚合分析:基于群体特征而非个体数据进行推荐

Q2: 小电商企业如何开始数据分析?

A: 小企业可以:

从免费工具开始:Google Analytics + 电子表格分析聚焦关键指标:转化率、复购率、客单价利用SaaS服务:如Shopify的分析插件优先解决最痛点的1-2个业务问题

Q3: 如何验证数据分析结果的有效性?

A: 推荐验证方法:

A/B测试:对比分析建议与原有策略时间序列验证:观察指标随时间的变化业务合理性检查:与业务直觉和经验对照模型稳定性检验:不同数据子集的结果一致性

Q4: 如何处理数据中的噪声和异常值?

A: 处理方法包括:

统计方法:Z-score、IQR识别异常业务规则过滤:排除不符合业务逻辑的数据机器学习方法:异常检测算法数据修正:基于相邻数据或业务规则插补

Q5: 如何让业务部门信任数据分析结果?

A: 建立信任的关键:

共同定义业务问题和成功指标逐步从小规模实验开始用业务语言解释分析结果展示可操作的具体建议而非复杂模型承认分析局限性和不确定性

10. 扩展阅读 & 参考资料

行业报告:

《全球电商数据分析趋势报告》- McKinsey《中国电商客户满意度白皮书》- 艾瑞咨询

技术文档:

Google Analytics官方文档AWS个性化推荐解决方案指南Apache Spark官方文档

开源项目:

Recommenders (Microsoft推荐系统工具包)PyMC3 (概率编程工具)Prophet (时间序列预测)

数据集:

Taobao用户行为数据集 (阿里云天池)Amazon产品评价数据集 (Kaggle)Retailrocket推荐系统数据集

行业案例:

京东618大促数据分析实践美团外卖个性化推荐系统演进拼多多社交电商数据分析模式

![[C++探索之旅] 第一部分第十一课:小练习,猜单词 - 鹿快](https://img.lukuai.com/blogimg/20251015/da217e2245754101b3d2ef80869e9de2.jpg)

暂无评论内容