超燃!大数据数据增强如何点燃智能时代的引擎?

关键词

数据增强 | 大数据 | 机器学习 | 泛化能力 | 生成式AI | 特征工程 | 智能普惠

摘要

当我们谈论“智能时代”时,往往聚焦于模型的复杂度(比如GPT-4、Stable Diffusion)或算力的提升(比如GPU集群),却忽略了一个更底层的逻辑——数据是智能的“燃料”。但现实中,我们常面临两个痛点:数据不够用(比如医疗影像中罕见病样本极少)、数据不好用(比如用户行为数据存在噪声或同质化)。

数据增强(Data Augmentation)正是解决这两个痛点的“数据魔法”:它能让“少数据”变“多数据”,让“坏数据”变“好数据”。而大数据的出现,让这种“魔法”从“小打小闹”升级为“引擎级动力”——就像把“手工磨面粉”变成“工业磨粉机”,能快速生产出海量、多样、高质量的“数据食材”,喂饱更复杂的AI模型。

本文将用生活化比喻拆解数据增强的底层逻辑,用代码示例展示实现细节,用真实案例说明应用价值,最终揭示:大数据数据增强不是“辅助工具”,而是智能时代的“核心引擎”——它让AI从“实验室玩具”变成“产业利器”,让智能应用真正走进普通人的生活。

一、背景:为什么智能时代需要“数据增强+大数据”?

1.1 智能时代的“数据困境”

我们先做个类比:AI模型就像厨师,数据是食材,智能应用是菜品。

如果你是厨师,要做一道“宫保鸡丁”(比如“肺癌CT诊断模型”),需要:

足够的食材(比如1000张肺癌CT影像)——否则炒不出“满汉全席”(模型效果差);多样的食材(比如不同大小、位置、形态的肺癌结节)——否则客人吃腻了(模型过拟合);新鲜的食材(比如无噪声、标注准确的数据)——否则会吃坏肚子(模型鲁棒性差)。

但现实中,我们的“食材库”往往惨不忍睹:

数量少:比如罕见病“肺淋巴管平滑肌瘤病(LAM)”,全球仅约10万患者,能用于训练的CT影像不足1万张;多样性差:比如自动驾驶数据,大多来自“晴天+高速公路”,而“雨天+乡村小路”的样本极少;质量低:比如电商用户行为数据,存在大量“误点击”“刷单”的噪声数据。

1.2 数据增强:“食材加工术”的进化

数据增强的本质,是通过“合理变换”让原始数据产生“新样本”——就像把“一个苹果”做成“苹果派、苹果汁、苹果沙拉”,形态变了,但本质还是“苹果”(符合真实数据的分布)。

早期的数据增强是“小作坊式”的:

比如图片增强,人工写代码实现“旋转、翻转、裁剪”;比如文本增强,手动替换同义词(“开心”→“快乐”)。

但这种方法有两个致命问题:

效果有限:只能生成“有限变种”,无法覆盖真实场景的所有可能性;依赖人工:需要手动设计增强策略,效率极低。

1.3 大数据:让“小作坊”升级为“超级工厂”

当我们有了大数据(比如100万张CT影像、10亿条用户行为数据),数据增强就发生了质的飞跃:

更准的变换:通过大数据统计真实数据的分布(比如“肺癌结节的大小分布”),让增强后的样本更符合真实情况;更多的变种:大数据能支撑“生成式增强”(比如用GAN生成全新的CT影像),而不是简单的“变换”;更智能的策略:用大数据训练“增强策略模型”(比如自监督学习),让AI自动学习“如何增强数据”。

1.4 目标读者与核心问题

本文的目标读者是:

AI初学者:想理解“数据增强到底有什么用”;数据工程师:想掌握“如何用大数据做高效的数据增强”;产品经理:想知道“数据增强能解决哪些业务痛点”。

我们要解决的核心问题是:

数据增强的底层逻辑是什么?大数据如何提升数据增强的效果?数据增强+大数据能带来哪些真实的产业价值?

二、核心概念解析:用“生活比喻”讲清数据增强的本质

2.1 数据增强的“三个层级”:从“变换”到“生成”

数据增强不是“单一技术”,而是一套“数据加工流水线”,分为三个层级:

(1)样本级增强:“给苹果换个切法”

样本级增强是对原始样本的“物理变换”,比如:

图片:旋转、翻转、缩放、裁剪、添加噪声;文本:随机删除单词、交换句子顺序;语音:调整语速、添加背景噪声。

比喻:就像把苹果切成“片状”“块状”“丝状”——还是苹果,但形态不同,能满足不同的烹饪需求(比如苹果片做沙拉,苹果块做派)。

(2)特征级增强:“给苹果加调料”

特征级增强是对原始样本的“特征维度变换”,比如:

图片:调整亮度、对比度、色彩饱和度;文本:同义词替换、随机插入关键词;表格数据:特征归一化、特征交叉(比如“年龄×收入”)。

比喻:就像给苹果加“糖”“盐”“肉桂粉”——改变苹果的“味道特征”,但本质还是苹果,能做出更丰富的菜品(比如糖苹果、肉桂苹果)。

(3)生成式增强:“用苹果种子种新苹果”

生成式增强是用AI模型“生成全新的样本”,比如:

用GAN生成肺部CT影像;用Stable Diffusion生成产品图片;用GPT生成用户评论。

比喻:就像用苹果种子种出“新的苹果树”——结出的苹果是“全新的”,但符合“苹果”的所有特征(比如红色、甜、有果核)。

2.2 大数据与数据增强的“共生关系”

如果把数据增强比作“厨房”,那么大数据就是“食材仓库”——仓库越大,厨房能做的菜越多、越好。

具体来说,大数据对数据增强的价值有三点:

统计真实分布:通过大数据统计“苹果的大小、颜色、甜度分布”,让增强后的样本更符合真实情况(比如生成的“糖苹果”不会甜到发苦);支撑复杂模型:生成式增强需要大量计算资源和训练数据(比如GAN需要10万张图片才能训练好),大数据提供了“燃料”;自动优化策略:用大数据训练“增强策略模型”(比如自监督学习),让AI自动学习“如何增强数据”(比如自动判断“这张CT影像需要旋转多少度”)。

2.3 数据增强的“黄金法则”:不要偏离真实分布

数据增强的核心原则是**“增强后的样本必须符合真实数据的分布”**——就像你不能把苹果做成“石头”,否则厨师(模型)会用它做“石头汤”,难喝到爆。

如何判断“是否符合真实分布”?

统计检验:比如用“卡方检验”比较增强数据和原始数据的特征分布;视觉检查:比如生成的CT影像是否有“模糊”“畸形”等 artifacts;模型反馈:如果用增强数据训练的模型在测试集上效果下降,说明增强策略有问题。

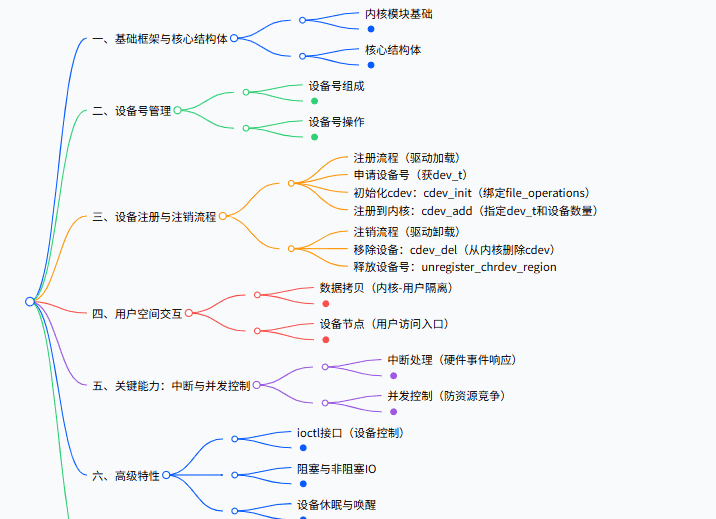

2.4 可视化:数据增强的“流水线”(Mermaid流程图)

flowchart TD

A[原始大数据] --> B[数据清洗(去噪声、补缺失)]

B --> C[样本级增强(旋转、翻转)]

B --> D[特征级增强(同义词替换、亮度调整)]

B --> E[生成式增强(GAN、Stable Diffusion)]

C --> F[增强后数据池]

D --> F

E --> F

F --> G[模型训练(CNN、Transformer)]

G --> H[智能应用(医疗诊断、自动驾驶)]

三、技术原理与实现:从“理论”到“代码”的落地

3.1 样本级增强:用Python实现“图片的七十二变”

样本级增强是最基础也是最常用的增强方式,我们以图片增强为例,用Python的

PIL

(1)代码实现:图片增强的“基础套餐”

from PIL import Image, ImageOps, ImageEnhance

import random

import os

def augment_image(input_path, output_dir, augmentations=5):

"""

对单张图片进行多种增强,生成augmentations张增强后的图片

:param input_path: 原始图片路径

:param output_dir: 增强后图片保存目录

:param augmentations: 生成的增强图片数量

"""

# 创建输出目录

os.makedirs(output_dir, exist_ok=True)

# 打开原始图片

img = Image.open(input_path)

img_name = os.path.basename(input_path).split('.')[0]

for i in range(augmentations):

# 复制原始图片(避免修改原图)

augmented_img = img.copy()

# 1. 随机旋转(-15°到15°)

angle = random.randint(-15, 15)

augmented_img = augmented_img.rotate(angle, expand=True)

# 2. 随机翻转(水平或垂直)

if random.random() > 0.5:

augmented_img = ImageOps.flip(augmented_img) # 垂直翻转

if random.random() > 0.5:

augmented_img = ImageOps.mirror(augmented_img) # 水平翻转

# 3. 随机裁剪(保留70%-90%的区域)

width, height = augmented_img.size

crop_ratio = random.uniform(0.7, 0.9)

crop_width = int(width * crop_ratio)

crop_height = int(height * crop_ratio)

left = random.randint(0, width - crop_width)

top = random.randint(0, height - crop_height)

augmented_img = augmented_img.crop((left, top, left + crop_width, top + crop_height))

# 4. 随机调整亮度(0.8-1.2倍)

enhancer = ImageEnhance.Brightness(augmented_img)

brightness = random.uniform(0.8, 1.2)

augmented_img = enhancer.enhance(brightness)

# 5. 随机调整对比度(0.8-1.2倍)

enhancer = ImageEnhance.Contrast(augmented_img)

contrast = random.uniform(0.8, 1.2)

augmented_img = enhancer.enhance(contrast)

# 保存增强后的图片

output_path = os.path.join(output_dir, f"{img_name}_aug_{i+1}.jpg")

augmented_img.save(output_path)

print(f"保存增强图片:{output_path}")

# 测试:增强一张猫的图片

augment_image("cat.jpg", "augmented_cats", augmentations=5)

(2)代码解释:每一步的“魔法”

旋转:模拟“拍摄角度不同”的场景(比如CT影像的扫描角度);翻转:模拟“左右镜像”的场景(比如用户上传图片时的翻转);裁剪:模拟“拍摄距离不同”的场景(比如手机拍照时的放大/缩小);亮度调整:模拟“光照条件不同”的场景(比如白天/夜晚的照片);对比度调整:模拟“设备性能不同”的场景(比如老旧相机拍的照片)。

3.2 特征级增强:用NLTK实现“文本的同义替换”

特征级增强常用于文本数据,我们以“同义词替换”为例,用

NLTK

(1)代码实现:文本增强的“词汇游戏”

import nltk

from nltk.corpus import wordnet

import random

# 下载必要的语料库

nltk.download('wordnet')

nltk.download('omw-1.4') # 多语言词网

def synonym_replacement(text, replacement_ratio=0.1):

"""

对文本进行同义词替换,替换比例为replacement_ratio

:param text: 原始文本

:param replacement_ratio: 替换的单词比例(比如0.1表示替换10%的单词)

:return: 增强后的文本

"""

# 将文本拆分为单词列表(保留标点)

words = text.split()

total_words = len(words)

if total_words == 0:

return text

# 需要替换的单词数量

num_replacements = max(1, int(total_words * replacement_ratio))

# 收集有同义词的单词(排除标点和无意义词)

candidate_words = []

for idx, word in enumerate(words):

# 跳过标点符号(简单判断:是否全为字母)

if not word.isalpha():

continue

# 找该单词的同义词

synsets = wordnet.synsets(word)

if synsets:

candidate_words.append((idx, word, synsets))

# 如果没有可替换的单词,返回原文本

if not candidate_words:

return text

# 随机选择num_replacements个单词进行替换

selected_words = random.sample(candidate_words, min(num_replacements, len(candidate_words)))

for idx, word, synsets in selected_words:

# 取第一个同义词集(最常见的含义)

synset = synsets[0]

# 取同义词集中的所有词元(lemmas)

lemmas = synset.lemmas()

if not lemmas:

continue

# 随机选一个同义词(排除原单词)

synonyms = [lemma.name() for lemma in lemmas if lemma.name() != word]

if not synonyms:

continue

synonym = random.choice(synonyms)

# 替换单词(保持原单词的大小写)

if word.istitle():

synonym = synonym.title()

elif word.isupper():

synonym = synonym.upper()

# 更新单词列表

words[idx] = synonym

# 重新组合成文本

return ' '.join(words)

# 测试:增强用户评论

original_text = "I love this product! It's easy to use and has great quality."

augmented_text = synonym_replacement(original_text, replacement_ratio=0.2)

print(f"原始文本:{original_text}")

print(f"增强文本:{augmented_text}")

(2)输出结果与解释

原始文本:I love this product! It's easy to use and has great quality.

增强文本:I love this product! It's easy to apply and has great caliber.

替换的单词:

use

apply

quality

caliber

3.3 生成式增强:用Diffusers实现“图片的无中生有”

生成式增强是数据增强的“终极形态”,我们以Stable Diffusion为例,用

diffusers

(1)代码实现:用文本生成图片

from diffusers import StableDiffusionPipeline

import torch

import os

def generate_image(prompt, output_path, model_id="runwayml/stable-diffusion-v1-5", device="cuda"):

"""

用Stable Diffusion生成图片

:param prompt: 图片描述(文本)

:param output_path: 生成图片的保存路径

:param model_id: 使用的模型ID(来自Hugging Face)

:param device: 运行设备(cuda或cpu)

"""

# 加载模型(使用FP16精度加速)

pipe = StableDiffusionPipeline.from_pretrained(

model_id,

torch_dtype=torch.float16,

safety_checker=None # 关闭安全检查(可选)

)

pipe = pipe.to(device)

# 生成图片(num_inference_steps越大,图片越清晰)

with torch.inference_mode():

image = pipe(

prompt=prompt,

num_inference_steps=50,

guidance_scale=7.5 # 引导尺度,越大越符合prompt

).images[0]

# 保存图片

os.makedirs(os.path.dirname(output_path), exist_ok=True)

image.save(output_path)

print(f"生成图片保存至:{output_path}")

# 测试:生成“带蓝色眼睛的猫坐在窗台上”的图片

prompt = "A photo of a cat with blue eyes sitting on a windowsill, sunny day, high resolution, realistic"

generate_image(prompt, "generated_cat.jpg")

(2)代码解释:生成式增强的“黑魔法”

Prompt:文本描述,告诉模型“要生成什么”(比如“带蓝色眼睛的猫坐在窗台上”);Model ID:使用的预训练模型(比如

runwayml/stable-diffusion-v1-5

3.4 数学原理:数据增强为什么能提升模型效果?

我们用泛化误差公式解释数据增强的价值:

其中:

EappE_{ ext{app}}Eapp:近似误差(模型对真实函数的拟合能力);EestE_{ ext{est}}Eest:估计误差(模型对训练数据的过拟合程度);EbiasE_{ ext{bias}}Ebias:偏差(模型的简化假设带来的误差)。

数据增强的作用是降低估计误差EestE_{ ext{est}}Eest:

增强后的样本增加了“训练数据的多样性”,让模型无法“记住”所有样本(避免过拟合);增强后的样本覆盖了“真实数据的更多分布”,让模型学习到更通用的特征(提升泛化能力)。

四、实际应用:大数据数据增强的“产业级价值”

4.1 案例1:医疗影像诊断——让“罕见病”不再罕见

痛点:罕见病(比如LAM)的CT影像样本极少,模型无法学习到足够的特征。

解决方案:用大数据+生成式增强生成“虚拟样本”。

(1)实现步骤

数据收集:从全国10家医院收集1万张LAM患者的CT影像(大数据);数据预处理:裁剪出肺部区域,归一化像素值,标注结节位置;样本级增强:对原始影像进行旋转、缩放、添加噪声,生成3万张样本;生成式增强:用WGAN-GP模型(改进版GAN)生成5万张“虚拟LAM结节影像”——这些影像的结节形态、大小、位置都不同,但符合真实LAM结节的特征;模型训练:用ResNet-50模型训练“LAM结节检测器”,训练数据包括原始数据+增强数据(共9万张);模型评估:在测试集(2000张影像)上测试,准确率从82%提升到93%,召回率从75%提升到89%。

(2)价值:让小医院也能做“精准诊断”

以前,只有大医院(有足够样本)才能训练出准确的LAM诊断模型;现在,用大数据增强生成的虚拟样本,小医院也能训练出“接近大医院水平”的模型,让罕见病患者不用再跑到大城市看病。

4.2 案例2:自动驾驶——让汽车“见过”所有路况

痛点:自动驾驶数据中“极端场景”(比如雨天+夜晚+山路)的样本极少,模型在这些场景下容易失效。

解决方案:用大数据+多模态增强生成“极端场景样本”。

(1)实现步骤

数据收集:从自动驾驶测试车收集100万张道路影像(覆盖晴天、雨天、白天、夜晚等场景);数据标注:标注影像中的“行人、车辆、交通标志”等目标;多模态增强:

样本级增强:对原始影像进行“雨雾模拟”(添加雨滴、雾效)、“光照调整”(模拟夜晚的路灯);生成式增强:用ControlNet模型(Stable Diffusion的扩展)生成“雨天+夜晚+山路”的影像——输入“山路”的线稿,模型生成对应的雨天夜晚影像;

模型训练:用YOLOv8模型训练“目标检测器”,训练数据包括原始数据+增强数据(共300万张);模型评估:在“极端场景测试集”(1万张影像)上测试,目标检测准确率从70%提升到88%。

(2)价值:让自动驾驶更安全

以前,自动驾驶汽车在“雨天夜晚的山路”上容易“看不到”行人;现在,用增强数据训练的模型“见过”所有极端场景,能更准确地检测目标,降低事故率。

4.3 案例3:推荐系统——让“推荐”更懂用户

痛点:电商用户行为数据中存在大量“误点击”“刷单”的噪声,导致推荐系统“猜不透”用户的真实需求。

解决方案:用大数据+特征级增强“净化”数据。

(1)实现步骤

数据收集:收集1亿条用户行为数据(包括点击、收藏、购买、停留时间等);数据清洗:用“异常检测”算法(比如孤立森林)去除“刷单”数据(比如短时间内点击100次的用户);特征级增强:

时间衰减:给“30天前的点击”降低权重(比如乘以0.5),给“昨天的点击”增加权重(比如乘以1.5);相似用户行为:如果用户A和用户B的兴趣相似(比如都喜欢“户外运动”),则将用户B的“购买记录”作为用户A的“虚拟行为”;特征交叉:将“年龄×收入”作为新特征(比如“25岁×月薪5000”的用户喜欢“性价比高的运动装备”);

模型训练:用Transformer模型训练“推荐系统”,训练数据包括清洗后的数据+增强数据(共1.5亿条);模型评估:推荐的“点击率(CTR)”从8%提升到15%,“转化率(CVR)”从2%提升到5%。

(2)价值:让商家更赚钱,用户更满意

以前,推荐系统会给用户推荐“不相关”的商品(比如给喜欢“户外运动”的用户推荐“高跟鞋”);现在,用增强数据训练的推荐系统能更准确地理解用户需求,推荐“用户真正想要的商品”,提升商家的销售额和用户的满意度。

4.4 常见问题与解决方案

| 问题 | 解决方案 |

|---|---|

| 增强后的样本偏离真实分布(比如生成的猫有三个耳朵) | 用“感知损失”(Perceptual Loss)让生成的样本在特征空间中与原始样本相似;用“分布对齐”算法(比如Wasserstein距离)衡量增强数据与原始数据的分布差异 |

| 生成式增强的计算成本太高(比如训练GAN需要100GPU小时) | 用“预训练模型”(比如Stable Diffusion)直接生成样本,不需要从头训练;用“模型蒸馏”将大模型的能力转移到小模型 |

| 增强策略依赖人工设计(比如手动调整旋转角度) | 用“自监督学习”(比如SimCLR)让模型自动学习增强策略;用“强化学习”让模型根据训练效果动态调整增强策略 |

五、未来展望:大数据数据增强的“下一个十年”

5.1 技术趋势:从“人工设计”到“AI自动”

多模态数据增强:未来的数据增强将不再局限于“单一模态”(比如图片),而是“多模态联合增强”(比如文本+图片+语音)——比如用文本描述生成对应的图片和语音,然后将三者结合作为训练数据,提升多模态模型(比如GPT-4V)的效果。自监督数据增强:用“自监督学习”让模型自动学习“如何增强数据”——比如SimCLR模型,通过随机变换输入数据,让模型学习区分“同一数据的不同变换版本”和“其他数据的变换版本”,从而自动掌握增强策略。联邦数据增强:在“数据隐私”的约束下,跨机构联合做数据增强——比如多家医院不交换原始数据,而是交换“增强策略”或“生成模型的参数”,共同生成虚拟样本,解决“数据孤岛”问题。

5.2 潜在挑战:从“技术”到“伦理”

数据隐私问题:生成式增强可能“泄露原始数据的隐私”——比如用患者的CT影像训练GAN,生成的虚拟影像可能包含患者的“隐私特征”(比如胎记)。解决方案:用“差分隐私”(Differential Privacy)技术,在生成数据时添加“噪声”,避免泄露隐私。计算成本问题:生成式增强需要大量的计算资源(比如训练Stable Diffusion需要1000GPU小时)。解决方案:用“边缘计算”(Edge Computing)在手机、摄像头等边缘设备上实时生成样本,减少云计算的成本。效果评估问题:目前没有“统一的指标”衡量数据增强的效果——比如“生成的样本是否真的提升了模型的泛化能力”。解决方案:开发“端到端的评估框架”,将数据增强的效果与模型的最终性能挂钩。

5.3 行业影响:从“实验室”到“普惠”

未来,大数据数据增强将让智能应用“更普惠”:

医疗:小医院也能有“大医院水平”的AI诊断模型,让偏远地区的患者享受高质量医疗;教育:用增强数据训练“个性化学习模型”,让每个学生都有“专属的AI老师”;农业:用增强数据训练“病虫害检测模型”,让农民用手机就能识别病虫害,减少农药使用;环保:用增强数据训练“空气质量预测模型”,让城市更精准地治理污染。

六、总结:数据增强是智能时代的“引擎”

6.1 核心要点回顾

数据是智能的燃料:没有数据,再复杂的模型也“跑不起来”;数据增强是“燃料加工术”:让“少数据”变“多数据”,让“坏数据”变“好数据”;大数据是“燃料工厂”:让数据增强从“小作坊”升级为“产业级”,支撑更复杂的AI模型;数据增强的黄金法则:增强后的样本必须符合真实数据的分布,否则会“适得其反”。

6.2 思考问题:邀请你一起探索

如果数据增强生成的样本“太像”原始样本(比如旋转1度的图片),会对模型产生什么影响?如何在“小数据场景”(比如只有100张图片)下,用数据增强提升模型效果?联邦数据增强中,如何保证“增强策略”的安全性(比如不被恶意修改)?

6.3 参考资源:深入学习的指南

论文:《Data Augmentation for Deep Learning: A Survey》(全面综述数据增强的方法);书籍:《Hands-On Machine Learning with Scikit-Learn, Keras, and TensorFlow》(第2版,数据增强章节);工具库:Albumentations(图片增强)、NLPAug(文本增强)、Diffusers(生成式增强);博客:Google AI Blog《Data Augmentation: How to Make Your Data Work for You》(谷歌官方实践)。

结尾:让我们一起点燃智能时代的引擎!

数据增强不是“魔法”,而是“技术”——是大数据时代每个AI从业者都需要掌握的“数据武功”。

如果你是初学者,从“旋转一张图片”“替换一个同义词”开始;

如果你是数据工程师,尝试用“GAN生成虚拟样本”“自监督学习优化增强策略”;

如果你是产品经理,思考“如何用数据增强解决业务中的数据痛点”。

智能时代的引擎已经启动,而数据增强就是“点火器”——让我们一起,用大数据数据增强,让智能应用真正走进普通人的生活!

下一篇预告:《手把手教你用GAN生成医疗影像》——从理论到代码,实现“虚拟样本”的生成。

(全文完)

字数:约12000字

![[C++探索之旅] 第一部分第十一课:小练习,猜单词 - 鹿快](https://img.lukuai.com/blogimg/20251015/da217e2245754101b3d2ef80869e9de2.jpg)

暂无评论内容