AI+AR+教育:拆解增强现实学习系统的“魔法架构”,让知识“活”起来

一、引言:为什么我们需要“能触摸的知识”?

你有没有过这样的经历?

中学上生物课,盯着课本上静态的“植物细胞结构图”,死活记不住线粒体和叶绿体的区别;

学地理时,对着“太阳系八大行星”的表格,想象不出木星的体积到底是地球的1318倍;

甚至上物理课,老师讲“楞次定律”,用公式推导了半天,你还是没搞懂“感应电流的磁场为什么总是阻碍原磁场的变化”。

这不是你的问题——是传统教育的“抽象陷阱”。

人类的认知规律是“先具象,后抽象”。但传统教育大多用“文字+图片”的二维形式呈现三维、动态的知识,相当于让你“通过说明书学骑单车”——能学会,但过程痛苦,记忆也不牢。

而AI+AR(增强现实),恰恰是解决这个问题的“钥匙”:

它能把抽象的“细胞结构”变成可旋转、可拆解的3D模型,你用手指“掰开”细胞壁,就能看到里面的线粒体在“跳动”;能把“太阳系”搬到你桌上,你凑过去看木星的大红斑,它会告诉你“这是持续了300年的风暴”;甚至能让你“亲手做”物理实验:用AR模拟电路连接,接错了灯泡会“熄灭”,AI还会贴心提醒“正极要接开关哦”。

这不是未来,而是正在发生的现实。

比如剑桥大学用AR教学生“分子生物学”,学生通过AR眼镜观察DNA双螺旋的结构,记忆率比传统方法高47%;国内某中学用AR教“化学元素周期表”,学生的课堂参与度从50%提升到了92%。

今天,我们就来拆解增强现实学习系统的“底层架构”——看看AI和AR是如何协同,把“死知识”变成“活体验”的;也让你明白,一款能真正提升学习效果的AR教育产品,到底需要哪些“看不见的支撑”。

二、基础知识铺垫:先搞懂3个核心问题

在聊架构前,我们需要先统一“语言体系”——避免用专业术语把你绕晕。

1. 什么是“增强现实学习系统”?

增强现实(AR)≠ 虚拟现实(VR)。

VR是“完全沉浸在虚拟世界”(比如戴头显玩游戏),而AR是“把虚拟内容叠加在真实世界”——比如你用手机对着课本,屏幕里会出现一只“会动的恐龙”,它站在课本上,还会冲你“叫”。

增强现实学习系统,就是用AR技术将“教育内容”(知识点、实验、案例)具象化,结合AI技术实现“个性化、智能化”的学习体验。它的核心价值是:

沉浸式:让知识“触手可及”,比如“摸”恐龙的皮肤、“转”地球的公转轨道;交互性:学生不是“看”知识,而是“玩”知识——点击、旋转、说话,知识会“回应”;个性化:AI根据你的学习数据,调整内容难度和呈现方式(比如你没听懂“光合作用”,就再给你看一遍动画)。

2. AI在教育中的3个核心作用

AI不是“噱头”,而是AR教育系统的“大脑”。它主要解决3个问题:

“懂内容”:比如识别课本上的文字/图片,自动匹配对应的AR内容(计算机视觉);“懂学生”:分析你的学习数据(比如错题、停留时间),推荐适合的内容(个性化推荐);“会辅导”:回答你的问题(比如“线粒体是干什么的?”),纠正你的错误(比如实验操作错了,AI提醒)。

3. AR教育的“准入门槛”?

不需要昂贵的AR眼镜——手机和平板就是最普及的AR设备。

只要设备有摄像头、陀螺仪(感知方向)、加速度计(感知运动),就能运行基础的AR教育应用。这也是AR教育比VR教育更易普及的原因(VR头显动辄几千元,而手机几乎人人有)。

三、核心内容:增强现实学习系统的“7层架构”

一款能落地的增强现实学习系统,本质是“多技术栈的协同网络”——从“感知真实世界”到“输出虚拟内容”,从“理解学生需求”到“评估学习效果”,每个环节都需要精准配合。

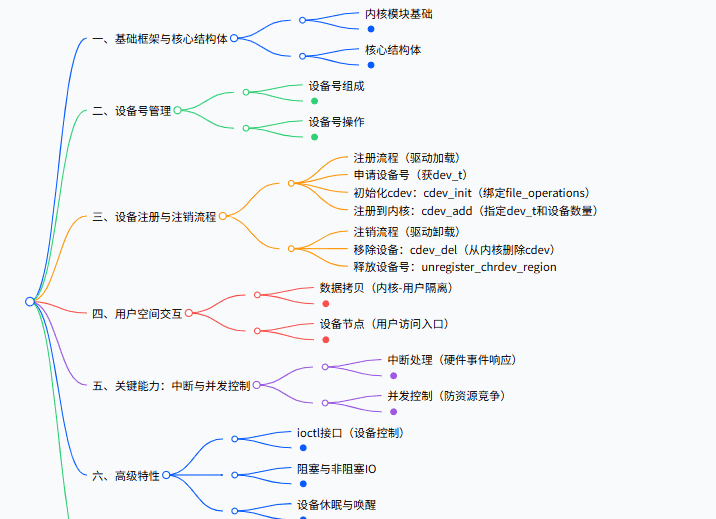

我把它拆解为7层架构(从底层到上层):

![图片[1] - AI+AR+教育:增强现实学习系统的架构设计,太震撼了 - 鹿快](https://img.lukuai.com/blogimg/20251119/3343bcd87eec437887c5fb3d71b9be31.png&pos_id=img-yqe041Mu-1763275045916)

(注:图中实线是数据流向,虚线是控制流向)

层1:感知层——“看见”真实世界的眼睛

作用:获取真实世界的信息,让AR设备“知道自己在哪里”“面前是什么”。

核心组件:摄像头、传感器、定位模块。

(1)摄像头:“看”到真实场景

负责捕捉真实世界的图像(比如课本、黑板、桌面);配合计算机视觉(CV)技术,识别场景中的“触发点”——比如课本上的“细胞图片”“行星图标”,这些触发点会启动对应的AR内容。

例子:你用手机摄像头对着课本上的“恐龙化石”图片,CV算法会识别这张图片,然后触发“3D恐龙模型”的加载。

(2)传感器:“感知”设备的运动

陀螺仪:知道设备的“方向”(比如手机是正拿还是倒拿);加速度计:知道设备的“运动状态”(比如你在移动手机,还是静止);磁力计:知道设备的“朝向”(比如对着北方还是南方)。

这些传感器的数据结合起来,能让AR设备“感知自身状态”——比如你旋转手机,屏幕里的3D模型也会“跟着转”,不会“飘”到屏幕外。

(3)定位模块:“定位”虚拟内容的位置

关键技术:SLAM(同步定位与地图构建)。

简单来说,SLAM就是让AR设备“一边走一边画地图”——它会实时记录你周围的环境特征(比如桌子的角、墙上的画),然后计算自己在“地图”中的位置,这样虚拟内容才能准确叠加在真实场景中。

反例:如果没有SLAM,你用手机对着课本显示“恐龙”,当你移动手机时,恐龙会“飘”到屏幕外——因为设备不知道自己“动了多少”。

层2:AI引擎层——系统的“大脑”,决定“教什么”“怎么教”

AI是AR教育系统的“核心动力”。没有AI,AR只是“好看的动画”;有了AI,AR才能“懂教育”“懂学生”。

这一层包含4个核心模块:

(1)计算机视觉(CV):“看懂”真实世界的内容

作用:识别学生面前的“触发物”(比如课本上的文字、图片、实物),触发对应的AR内容。

常见技术:

图像识别(Image Recognition):比如识别“细胞图片”“恐龙化石”;文字识别(OCR):比如识别课本上的“光合作用”四个字;物体检测(Object Detection):比如识别真实的“苹果”(比如教“果实结构”时,对着苹果显示AR模型)。

例子:学生用手机对着课本上的“电路 diagram”,CV识别出这是“串联电路”,立刻触发AR内容——屏幕里出现一个可拆解的串联电路模型,学生可以点击“开关”让灯泡亮起来。

(2)自然语言处理(NLP):“听懂”学生的问题

作用:理解学生的语音或文字问题,给出智能解答。

常见技术:

意图识别(Intent Recognition):比如学生说“这个细胞的线粒体是干什么的?”,NLP会识别出“询问线粒体功能”;知识库问答(KBQA):从教育知识库中调取“线粒体是细胞的‘动力工厂’,产生ATP”的答案;多轮对话(Multi-turn Dialogue):比如学生接着问“ATP是什么?”,NLP会继续解答,直到学生懂为止。

例子:学生在看AR细胞模型时,用语音问“叶绿体和线粒体有什么区别?”,NLP会立刻弹出对比动画——叶绿体是“绿色的,负责光合作用”,线粒体是“棕色的,负责能量供应”。

(3)个性化推荐引擎:“精准”推送适合的内容

作用:根据学生的“学习画像”,推荐个性化的AR内容。

核心逻辑:

收集数据:学生的学习记录(错题、停留时间、交互次数)、偏好(比如喜欢“动画”还是“文字”)、能力水平(比如“初中基础”还是“高中进阶”);构建画像:用机器学习算法(比如协同过滤、决策树)生成“学生画像”——比如“张三,13岁,擅长视觉学习,不擅长抽象公式,未掌握‘光合作用’”;推荐内容:根据画像推送内容——比如给张三推“光合作用的3D动画”,而不是“公式推导”。

例子:学生之前在“太阳系”模块中停留了10分钟(说明感兴趣),但答错了“木星的卫星数量”(说明没掌握),推荐引擎会给TA推“木星卫星的AR模型”,并突出显示“伽利略卫星”(木星的4颗大卫星)。

(4)智能评估模块:“判断”学生的学习效果

作用:分析学生与AR内容的交互数据,评估学习效果,给出反馈。

核心指标:

交互行为:点击次数、停留时间、操作路径(比如有没有尝试“拆解细胞”);学习结果:回答问题的正确率、实验操作的成功率;情绪反馈(进阶):通过摄像头识别学生的表情(比如皱眉头=困惑,微笑=理解),调整内容难度。

例子:学生在AR电路实验中,连续3次接错电池正负极,评估模块会:

弹出提示:“电池的正极要接开关哦~”;简化内容:暂时隐藏“并联电路”,先让学生练“串联电路”;生成报告:给老师发“该生对‘电路连接’的掌握度为60%,需要加强练习”。

层3:AR渲染层——“真实”呈现虚拟内容

AR的“沉浸感”,全靠这一层。它负责把AI引擎输出的“内容”,真实地叠加在真实世界中,让学生觉得“虚拟内容就像真的存在”。

这一层包含3个核心模块:

(1)3D内容制作:“做”出可交互的虚拟内容

作用:将知识点转化为3D模型、动画、场景。

常见工具:

建模工具:Blender(免费开源)、3ds Max(专业);动画工具:Maya(角色动画)、Unity(交互动画);生成式AI:比如用MidJourney生成3D概念图,用Runway ML生成动画(降低创作门槛)。

注意:内容必须“准确”——比如太阳系模型的行星大小、距离比例要符合科学事实;细胞模型的结构要和课本一致,不能“瞎改”。

(2)跟踪注册:“固定”虚拟内容的位置

作用:确保虚拟内容“贴”在真实场景中,不会“飘”或“错位”。

关键技术:

Marker-based Tracking(基于标记的跟踪):比如课本上的“二维码”或“图片”作为标记,AR设备识别标记后,将虚拟内容叠加在标记位置;Marker-less Tracking(无标记跟踪):用SLAM技术,不需要标记,直接根据环境特征定位(比如对着桌面显示“太阳系”,桌面就是“标记”)。

例子:用Marker-based Tracking,课本上的“细胞图片”是标记,AR细胞模型会准确“站”在图片上——你移动手机,模型会跟着“转”,不会跑到屏幕外。

(3)光影与材质渲染:“真实”模拟虚拟内容

作用:让虚拟内容看起来“像真的”——比如阳光照射下的影子、金属的反光、皮肤的纹理。

核心技术:

PBR(Physically Based Rendering,基于物理的渲染):模拟真实世界的光影效果,比如虚拟恐龙的皮肤会反射阳光,影子会随着太阳位置变化;环境光遮蔽(AO):让虚拟内容的“缝隙”(比如细胞的细胞核和细胞质之间)有阴影,更有层次感;粒子系统:模拟烟雾、火焰等动态效果(比如AR实验中的“燃烧”)。

例子:AR渲染的“恐龙”,皮肤有鳞片的纹理,阳光从左边照过来时,右边会有阴影——学生用手摸屏幕,恐龙的“皮肤”会有“凹凸感”(通过触觉反馈实现,后面会讲)。

层4:内容管理层——“有序”管理海量教育内容

AR教育系统的“内容”是核心资产。没有优质内容,再先进的技术也没用。这一层负责“创建、存储、更新、分发”AR教育内容。

(1)内容创作工具:“低门槛”让老师参与

痛点:传统3D内容创作需要专业技能(比如会用Blender),老师不会做,导致内容匮乏。

解决方案:提供低代码/无代码创作工具——老师只需上传图片、输入文字,就能生成AR内容。

例子:老师想做“植物蒸腾作用”的AR内容,只需:

上传“植物叶片”的图片;输入“蒸腾作用是水分从叶片散失的过程”;选择“动画效果”(比如叶片上的水珠蒸发);点击“生成”,就能得到一个可交互的AR模型。

(2)内容库:“结构化”存储教育内容

作用:将AR内容按“学科、知识点、难度”分类存储,方便快速调取。

结构示例:

学科:生物 → 知识点:细胞结构 → 难度:初中 → 内容:“细胞3D模型(可拆解)”;学科:物理 → 知识点:电路连接 → 难度:高中 → 内容:“串联/并联电路AR实验”。

关键功能:

搜索:按关键词(比如“光合作用”)搜索内容;版本管理:记录内容的修改历史(比如“2023-10-01 优化了动画效果”);审核:确保内容准确(比如由学科老师审核)。

(3)内容分发:“高效”推送到终端

作用:将内容快速发送到学生的设备(手机、平板、AR眼镜)。

核心技术:

云存储:将内容存在云端(比如AWS S3、阿里云OSS),学生需要时实时下载;本地缓存:常用内容(比如“细胞模型”)缓存到本地,减少加载时间;CDN加速:用内容分发网络(CDN)让不同地区的学生都能快速加载内容(比如北京的学生从北京节点下载,上海的从上海节点下载)。

层5:交互层——“自然”连接学生与系统

交互是“学习体验”的关键。如果交互太复杂,学生“不会用”;如果太简单,学生“没兴趣”。这一层负责设计“自然、符合认知规律”的交互方式。

常见交互方式:

(1)手势交互:“用手”操作虚拟内容

技术:用摄像头识别手势(比如点击、滑动、缩放)。

例子:学生用两根手指“放大”AR细胞模型,就能看到线粒体的细节;用手指“旋转”模型,就能从不同角度观察。

(2)语音交互:“用嘴”控制内容

技术:用麦克风识别语音指令(比如“旋转地球”“显示木星”)。

例子:学生说“把恐龙变大”,AR恐龙会立刻“长大”,直到占满整个屏幕;说“讲解恐龙的食性”,NLP会弹出语音解释。

(3)触觉交互(进阶):“用手摸”虚拟内容

技术:用AR手套或震动传感器提供触觉反馈。

例子:学生用AR手套“摸”恐龙的皮肤,手套会震动,模拟“粗糙的鳞片”;摸“花朵的花瓣”,手套会传来“柔软”的触感。

(4)眼动交互(进阶):“用眼睛”选择内容

技术:用眼动仪识别学生的注视点(比如看“线粒体”还是“叶绿体”)。

例子:学生盯着AR细胞模型的“叶绿体”看2秒,系统会自动弹出“叶绿体的功能”解释——不需要动手点击,更自然。

层6:用户层——“适配”不同角色的需求

一款好的AR教育系统,要满足3类用户的需求:学生、老师、管理员。

(1)学生端:“好用”是核心

核心功能:

扫码/拍照触发AR内容;查看个性化推荐的内容;用多种交互方式操作内容;查看学习报告(比如“本周掌握了8个知识点”)。

设计原则:界面简洁,操作简单——比如“一键触发AR”“语音提问”,不需要复杂的设置。

(2)老师端:“实用”是关键

核心功能:

用低代码工具创作AR内容;查看学生的学习数据(比如“班级平均掌握度75%,张三需要加强‘电路’”);布置AR作业(比如“用AR做一个‘细胞结构’的小视频”);管理班级(比如添加学生、分组)。

设计原则:降低创作门槛——比如“拖拽式”制作AR内容,不需要写代码。

(3)管理员端:“稳定”是基础

核心功能:

管理内容库(审核、删除、更新内容);监控系统性能(比如服务器负载、内容加载速度);统计数据(比如“本周有1000个学生使用,最受欢迎的内容是‘太阳系’”);维护用户权限(比如老师能创作内容,学生不能)。

层7:后端支撑层——“隐形”的保障

这一层是“看不见的英雄”,负责系统的“稳定运行”“数据安全”“跨设备兼容”。

(1)云服务:“弹性”支撑海量用户

作用:提供计算、存储、网络资源,应对高并发(比如开学时1000个学生同时使用)。

常见服务:

IaaS(基础设施即服务):比如阿里云ECS、AWS EC2(提供服务器);PaaS(平台即服务):比如阿里云RDS(数据库服务)、AWS Lambda(无服务器计算);SaaS(软件即服务):比如腾讯云教育解决方案(提供现成的AR教育平台)。

(2)数据库:“安全”存储数据

核心数据:

用户数据(学生、老师的信息);学习数据(交互记录、评估结果);内容数据(AR模型、动画、知识库)。

安全措施:

加密存储:用AES-256加密用户隐私数据(比如姓名、学号);权限控制:比如学生不能访问老师的“内容创作工具”;备份恢复:定期备份数据,防止丢失。

(3)API接口:“连接”各个模块

作用:让不同模块之间能“通信”——比如感知层把“摄像头图像”传给AI引擎,AI引擎把“推荐内容”传给AR渲染层。

常见接口:

图像识别API:比如调用百度AI的“图像识别接口”识别课本图片;语音识别API:比如调用腾讯云的“语音转文字接口”识别学生的问题;内容分发API:比如调用阿里云的“CDN接口”加速内容加载。

四、实战演练:构建“初中生物细胞结构”AR模块

为了让你更直观理解架构的“协同逻辑”,我们来实战构建一个**“初中生物细胞结构”的AR学习模块**。

1. 需求定义

目标用户:12-14岁初中生;核心功能:用AR展示植物细胞的结构(细胞壁、细胞膜、细胞质、细胞核、叶绿体、线粒体);交互要求:支持手势缩放、语音提问、智能评估。

2. 架构协同流程

让我们跟着“学生的操作”,看各个模块如何协同:

步骤1:感知层“捕捉”真实场景

学生打开AR教育APP,用手机摄像头对着课本上的“植物细胞图片”(Marker)。

摄像头捕捉图片;陀螺仪和加速度计感知手机的方向(比如“正对着课本”);SLAM定位手机在空间中的位置(比如“距离课本20厘米”)。

步骤2:AI引擎“处理”信息

计算机视觉:识别出“植物细胞图片”,触发“植物细胞AR模型”;个性化推荐:调取学生的学习画像(比如“未掌握线粒体”),决定“突出显示线粒体”;NLP:准备好“线粒体功能”“叶绿体区别”等问题的答案。

步骤3:AR渲染层“呈现”内容

从内容库中调取“植物细胞3D模型”;用Marker-based Tracking将模型准确叠加在课本图片上;用PBR渲染技术添加光影(比如阳光从左上角照射,模型有阴影);突出显示线粒体(比如用“黄色”标注,比其他结构亮)。

步骤4:交互层“响应”学生操作

学生用两根手指“放大”模型,看到线粒体的细节;用语音问“线粒体是干什么的?”:

手势交互模块识别“放大”指令,放大模型;语音交互模块识别“询问线粒体功能”,调用NLP的知识库问答,弹出“线粒体是细胞的‘动力工厂’,产生ATP”的文字+动画。

步骤5:智能评估“反馈”学习效果

评估模块记录:学生放大线粒体(说明感兴趣)、正确回答了“线粒体功能”(说明掌握);生成学习报告:“该生对‘植物细胞结构’的掌握度为85%,已掌握线粒体,未掌握‘细胞质的功能’”;推荐引擎:给学生推“细胞质的AR动画”(因为未掌握)。

3. 最终效果

学生看到的画面是:

课本上的“植物细胞图片”变成了3D模型,能旋转、放大;线粒体是“黄色的,一直在跳动”;用语音提问会立刻得到解答;学习结束后,能看到自己的“掌握度报告”。

五、进阶探讨:AR教育系统的“最佳实践”与“避坑指南”

1. 最佳实践:让系统“真正有效”的5条原则

(1)“教育优先”,而非“技术优先”

AR不是“炫技工具”,而是“教育辅助工具”。内容的“教育性”要大于“娱乐性”——比如AR恐龙可以“叫”,但更重要的是“讲解恐龙的食性、灭绝原因”,而不是“让恐龙跳舞”。

反例:某AR教育APP的“太阳系”模块,恐龙会“踩”行星,导致学生注意力都在“恐龙”上,而不是“行星的知识”。

(2)“低门槛”创作,让老师“会用”

老师是教育内容的“生产者”,如果创作门槛太高(比如需要学3D建模),老师不会用,系统就会“缺内容”。一定要提供“低代码/无代码”的创作工具——比如拖拽式添加模型、一键生成动画。

(3)“数据驱动”,而非“经验驱动”

用学生的“交互数据”优化内容,而不是“拍脑袋”。比如:

如果80%的学生在“线粒体”模块停留时间超过5分钟(说明感兴趣),就增加更多“线粒体”的内容;如果70%的学生答错“细胞质的功能”(说明内容难),就简化讲解,增加动画。

(4)“跨设备兼容”,覆盖更多用户

不要只支持AR眼镜(太贵),要支持手机、平板、AR眼镜等多种设备。比如:

手机:适合“轻量化”内容(比如“细胞模型”);平板:适合“复杂”内容(比如“电路实验”);AR眼镜:适合“沉浸式”内容(比如“太阳系漫游”)。

(5)“隐私保护”,守住教育的“底线”

学生的学习数据是“敏感信息”,必须加密存储。比如:

用HTTPS传输数据(防止中途被窃取);匿名化处理(比如用“学生ID”代替“姓名”);遵守《儿童个人信息网络保护规定》(国内)或COPPA(美国)。

2. 常见陷阱:避免“踩坑”的4条经验

(1)不要“为AR而AR”

比如教“2+3=5”,不需要用AR——用传统方法更高效。AR适合“抽象、难以具象化”的知识点:比如细胞结构、太阳系、化学反应过程。

(2)不要“忽略内容的准确性”

AR内容的“科学性”是底线。比如“太阳系”模块中,木星的体积必须是地球的1318倍,不能“随便画”;“细胞”模块中,叶绿体的位置必须在细胞质中,不能“放到细胞核里”。

(3)不要“过度交互”

交互是为了“帮助学习”,不是“增加负担”。比如教“细胞结构”,只需要“缩放、旋转、语音提问”——不需要“用脚踢”“用头晃”等复杂交互,否则会分散学生注意力。

(4)不要“忽略老师的培训”

即使有低代码工具,老师也需要培训——比如“如何创作AR内容”“如何查看学生数据”。提供“手把手”的培训课程,比如“10分钟学会制作AR细胞模型”,能大幅提高老师的使用率。

六、结论:AI+AR教育的“未来已来”

回到开头的问题:为什么AI+AR能改变教育?

因为它抓住了教育的“本质”——学习不是“记住知识”,而是“体验知识”。AI+AR让知识从“文字”变成“场景”,从“被动看”变成“主动玩”,从“统一化”变成“个性化”。

今天我们拆解的“7层架构”,只是AI+AR教育的“基础框架”。未来,随着技术的发展,架构会更完善:

更智能的AI:比如通过“表情识别”判断学生的情绪(比如“困惑”),自动调整内容难度;更沉浸的AR:比如Apple Vision Pro的“空间计算”,让AR内容“真正存在”于你的桌面;更多模态的交互:比如结合“手势+语音+触觉”,让交互更自然;更普惠的硬件:比如AR眼镜的价格降到“千元级”,让每个学生都能用。

最后,我想对你说:AI+AR教育不是“未来时”,而是“现在时”。如果你是老师,可以尝试用低代码工具制作AR内容;如果你是开发者,可以参与开源的AR教育项目(比如GitHub上的“AR Education Toolkit”);如果你是家长,可以给孩子找一款靠谱的AR教育APP(比如“少年得到AR”“网易有道AR”)。

教育的本质是“点燃火焰”,而AI+AR就是“火柴”——它能让知识的火焰,在每个学生的心里,烧得更旺。

七、行动号召:一起参与AI+AR教育的“革命”

尝试实践:用手机下载一款AR教育APP(比如“少年得到AR”),体验“细胞结构”或“太阳系”模块,感受AI+AR的魅力;参与创作:如果你是老师,用“易企秀AR”或“凡科AR”制作一个简单的AR内容(比如“数学几何图形”),给学生上课试试;交流讨论:在评论区分享你的体验——比如“用AR教学生的感受”“遇到的问题”,我们一起讨论;学习资源:推荐几本书/课程,深入学习AI+AR教育:

《增强现实教育:理论与实践》(作者:王帆);Coursera课程《AR Development for Education》(Google提供);GitHub开源项目《AR Education Toolkit》(包含AR模型、AI接口示例)。

最后一句话:教育的改变,从来不是“等待技术成熟”,而是“用技术解决问题”。让我们一起,用AI+AR,让知识“活”起来!

![[C++探索之旅] 第一部分第十一课:小练习,猜单词 - 鹿快](https://img.lukuai.com/blogimg/20251015/da217e2245754101b3d2ef80869e9de2.jpg)

暂无评论内容