社交媒体AI架构实时性设计:从0到1实现秒级推荐系统

标题选项

社交媒体AI架构实时性设计:如何让推荐“快”到用户心里?秒级推荐背后的技术密码:社交媒体实时AI架构实战从延迟10秒到1秒:拆解社交媒体实时推荐系统的核心设计社交媒体AI如何“瞬间懂你”?实时性架构的完整实现指南

引言:为什么你的推荐总慢半拍?

刷短视频时,你刚滑到一条“柯基拆家”的视频并点了赞,下一条立刻弹出“柴犬越狱”——这种“秒级响应”的推荐体验,已经成了社交媒体的“隐形刚需”。但对技术团队来说,让推荐从“离线天级更新”到“实时秒级响应”,背后藏着无数坑:

用户刚产生的行为(点赞/评论/转发),如何立刻反馈到推荐结果?百万级用户并发请求下,如何保证推荐接口延迟<1秒?实时特征(如“最近5分钟点击的品类”)和离线特征(如“历史偏好标签”)如何融合?

如果你也在困惑这些问题,那么本文正是为你写的。我会用**“场景-问题-解法-代码”**的逻辑,一步步拆解社交媒体实时推荐系统的架构设计,帮你搞懂“秒级推荐”的底层原理。

读完本文你能得到什么?

掌握实时推荐系统的端到端链路设计;学会用Kafka/Flink构建实时数据管道;解决实时特征存储与模型推理的性能瓶颈;实现一个能处理百万级并发的秒级推荐原型。

准备工作:你需要的技术基础与工具

在开始之前,确保你具备以下基础:

1. 技术栈/知识要求

熟悉分布式系统(理解消息队列、流处理的基本概念);懂机器学习基础(协同过滤、LR、特征工程的基本逻辑);会用至少一门后端语言(Python/Java/Golang均可);了解Redis/HBase等存储系统的使用场景。

2. 环境/工具准备

安装Docker(快速部署Kafka/Flink/Redis等组件);安装Python3.8+(用于模型推理与接口开发);准备一个云服务器/本地虚拟机(模拟生产环境的并发场景);可选:Grafana/Prometheus(用于监控系统延迟)。

核心内容:手把手实现秒级推荐系统

我们的目标是构建一个**“用户行为→实时特征→模型推理→推荐结果”**的端到端实时链路,整个流程延迟≤1秒。下面分5个步骤拆解:

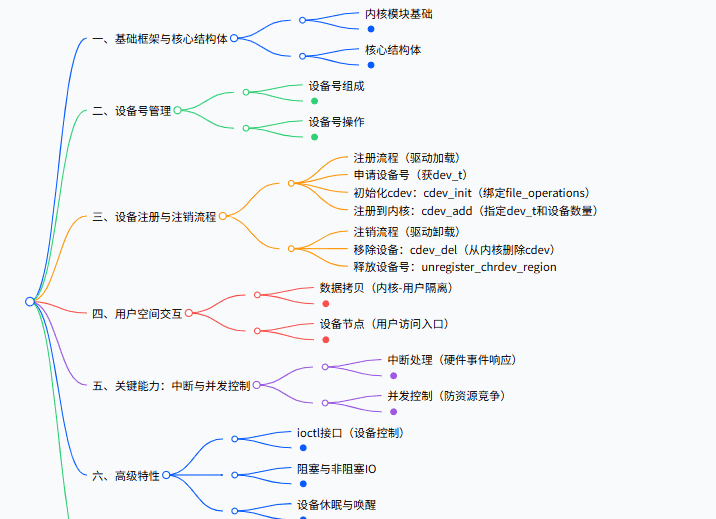

步骤一:理清实时推荐的核心链路

在讲技术细节前,先明确实时推荐系统的最小闭环(以短视频APP为例):

行为采集:用户滑动、点赞、评论等行为,通过SDK上报到消息队列(如Kafka);实时处理:用流处理引擎(如Flink)计算实时特征(如“最近5分钟点击的宠物视频数”);特征存储:实时特征存入Redis(低延迟读取),离线特征存入HBase(大容量存储);模型推理:当用户请求推荐时,拼接实时+离线特征,调用模型计算推荐分数;结果返回:按分数排序,返回TopN视频,同时记录推荐结果用于后续优化。

为什么这样设计?

消息队列解决“高并发行为采集”的问题;流处理解决“实时特征计算”的问题;分层存储解决“实时特征低延迟”与“离线特征大容量”的矛盾;模型推理解决“个性化推荐”的核心需求。

步骤二:搭建实时数据管道——从行为采集到特征计算

实时推荐的第一步,是把用户的行为数据“快速搬”到计算引擎。这里我们用Kafka+Flink组合:

1. 用Kafka采集用户行为

Kafka是实时系统的“数据总线”,负责接收高并发的用户行为数据。我们需要:

创建一个Kafka主题(Topic):

user_behavior

kafka-python

代码示例:Python上报用户行为

from kafka import KafkaProducer

import json

import time

producer = KafkaProducer(

bootstrap_servers=['kafka:9092'],

value_serializer=lambda v: json.dumps(v).encode('utf-8')

)

# 模拟用户点赞行为

def send_behavior(user_id, item_id, action):

behavior = {

"user_id": user_id,

"item_id": item_id,

"action": action, # 可选值:click/like/comment/share

"timestamp": int(time.time() * 1000) # 毫秒级时间戳

}

producer.send('user_behavior', value=behavior)

producer.flush()

# 测试:用户123点赞视频456

send_behavior(123, 456, "like")

关键说明:

bootstrap_servers

value_serializer

timestamp

2. 用Flink做实时特征计算

Flink是流处理引擎的“标杆”,擅长处理低延迟、高吞吐量的实时数据。我们的目标是用Flink计算用户最近5分钟的兴趣特征(比如“最近5分钟点击的宠物视频数”)。

第一步:定义数据结构

先定义用户行为和实时特征的Java类(Flink更适合Java/Scala):

// UserBehavior.java:用户行为事件

public class UserBehavior {

private Long userId;

private Long itemId;

private String action;

private Long timestamp;

// Getter/Setter/toString

}

// UserRealTimeFeature.java:实时特征结果

public class UserRealTimeFeature {

private Long userId;

private Integer recentPetClicks; // 最近5分钟点击的宠物视频数

private Long updateTime;

// Getter/Setter/toString

}

第二步:编写Flink流处理逻辑

我们需要实现:

从Kafka读取用户行为流;按用户ID分组(

keyBy

import org.apache.flink.streaming.api.datastream.DataStream;

import org.apache.flink.streaming.api.environment.StreamExecutionEnvironment;

import org.apache.flink.streaming.api.windowing.time.Time;

import org.apache.flink.streaming.connectors.kafka.FlinkKafkaConsumer;

import org.apache.flink.streaming.connectors.redis.RedisSink;

import org.apache.flink.streaming.connectors.redis.common.config.FlinkJedisPoolConfig;

import java.util.Properties;

public class RealTimeFeatureJob {

public static void main(String[] args) throws Exception {

// 1. 初始化Flink执行环境

StreamExecutionEnvironment env = StreamExecutionEnvironment.getExecutionEnvironment();

// 2. 配置Kafka消费者

Properties kafkaProps = new Properties();

kafkaProps.setProperty("bootstrap.servers", "kafka:9092");

kafkaProps.setProperty("group.id", "flink-consumer");

// 3. 从Kafka读取用户行为流

FlinkKafkaConsumer<UserBehavior> kafkaSource = new FlinkKafkaConsumer<>(

"user_behavior",

new UserBehaviorSchema(), // 自定义反序列化器,将Kafka消息转成UserBehavior对象

kafkaProps

);

DataStream<UserBehavior> behaviorStream = env.addSource(kafkaSource);

// 4. 计算实时特征:最近5分钟点击的宠物视频数

DataStream<UserRealTimeFeature> featureStream = behaviorStream

.filter(behavior -> "click".equals(behavior.getAction())) // 只处理点击行为

.keyBy(UserBehavior::getUserId) // 按用户ID分组

.timeWindow(Time.minutes(5), Time.minutes(1)) // 滑动窗口:5分钟窗口,1分钟滑动一次

.apply((window, behaviorIterable, out) -> {

Long userId = behaviorIterable.iterator().next().getUserId();

int petClickCount = 0;

for (UserBehavior behavior : behaviorIterable) {

// 假设itemId前缀为"pet_"的是宠物视频(实际需关联物品元数据)

if (behavior.getItemId().toString().startsWith("pet_")) {

petClickCount++;

}

}

UserRealTimeFeature feature = new UserRealTimeFeature();

feature.setUserId(userId);

feature.setRecentPetClicks(petClickCount);

feature.setUpdateTime(System.currentTimeMillis());

out.collect(feature);

});

// 5. 配置Redis连接

FlinkJedisPoolConfig redisConfig = new FlinkJedisPoolConfig.Builder()

.setHost("redis")

.setPort(6379)

.build();

// 6. 将实时特征写入Redis

RedisSink<UserRealTimeFeature> redisSink = new RedisSink<>(

redisConfig,

new UserRealTimeFeatureRedisMapper() // 自定义Redis映射器,将特征存为Hash结构

);

featureStream.addSink(redisSink);

// 7. 执行任务

env.execute("RealTimeFeatureJob");

}

}

关键说明:

滑动窗口:

Time.minutes(5), Time.minutes(1)

user:123

recent_pet_clicks

步骤三:实时特征存储——Redis vs HBase的分工

实时推荐需要两种特征:

实时特征:最近N分钟的行为统计(如最近5分钟点击的宠物视频数),要求低延迟读取(<1ms);离线特征:历史全量行为统计(如过去30天的偏好标签),要求大容量存储(支持TB级数据)。

1. 实时特征存Redis

Redis是内存数据库,读取延迟极低,适合存储高频访问、小容量的实时特征。我们用Hash结构存储用户特征:

Key:

user:{user_id}:realtime

user:123:realtime

recent_pet_clicks

recent_game_clicks

5

3

代码示例:Java写入Redis

// UserRealTimeFeatureRedisMapper.java:自定义Redis映射器

import org.apache.flink.streaming.connectors.redis.common.mapper.RedisCommand;

import org.apache.flink.streaming.connectors.redis.common.mapper.RedisCommandDescription;

import org.apache.flink.streaming.connectors.redis.common.mapper.RedisMapper;

public class UserRealTimeFeatureRedisMapper implements RedisMapper<UserRealTimeFeature> {

@Override

public RedisCommandDescription getCommandDescription() {

// 使用Hash命令:HSET key field value

return new RedisCommandDescription(RedisCommand.HSET, "user:realtime");

}

@Override

public String getKeyFromData(UserRealTimeFeature data) {

return "user:" + data.getUserId() + ":realtime"; // Key:user:123:realtime

}

@Override

public String getValueFromData(UserRealTimeFeature data) {

// Field: recent_pet_clicks,Value: 5

return "recent_pet_clicks:" + data.getRecentPetClicks();

}

}

优化技巧:

用

LTRIM

2. 离线特征存HBase

HBase是分布式列存储数据库,适合存储低频访问、大容量的离线特征。比如用户的“历史偏好标签”(如“宠物爱好者”“游戏玩家”),这些特征由离线计算引擎(如Spark)每天更新一次。

HBase表设计:

表名:

user_offline_feature

user_id

123

f

preference_tags

pet,game

total_clicks

1000

代码示例:Python读取HBase离线特征

from happybase import Connection

def get_offline_feature(user_id):

connection = Connection(host='hbase', port=9090)

table = connection.table('user_offline_feature')

row = table.row(str(user_id))

# 解析列值:b'f:preference_tags' → 'pet,game'

preference_tags = row.get(b'f:preference_tags', b'').decode('utf-8').split(',')

total_clicks = int(row.get(b'f:total_clicks', b'0').decode('utf-8'))

connection.close()

return {

"preference_tags": preference_tags,

"total_clicks": total_clicks

}

# 测试:获取用户123的离线特征

print(get_offline_feature(123))

步骤四:实时模型推理——从特征到推荐结果

有了实时+离线特征,下一步是用模型计算推荐分数。实时推理的核心要求是低延迟(<500ms),因此需要选择轻量级模型或对模型做优化。

1. 选择适合实时的模型

| 模型类型 | 优点 | 缺点 | 适合场景 |

|---|---|---|---|

| 逻辑回归(LR) | 推理快、可解释性强 | 线性模型,表达能力弱 | 简单推荐场景(如新闻) |

| 因子分解机(FM) | 捕捉特征交互,效果好 | 推理速度中等 | 电商/短视频推荐 |

| LightGBM | 处理高维特征,效果好 | 推理速度中等 | 复杂推荐场景 |

| 深度学习模型 | 表达能力强 | 推理慢、资源消耗大 | 需要精细优化(如模型量化) |

推荐选择:优先用LR/FM/LightGBM,若需要深度学习,可通过模型量化、剪枝、TensorRT加速降低延迟。

2. 部署模型推理服务

我们用Flask+ONNX Runtime部署一个轻量级推理服务(ONNX Runtime比原生框架快2-5倍)。

第一步:训练并导出ONNX模型

先训练一个LR模型(用Scikit-learn),然后导出为ONNX格式:

from sklearn.linear_model import LogisticRegression

from sklearn.datasets import make_classification

import onnx

from onnxruntime import InferenceSession

# 1. 生成模拟数据(特征:实时+离线)

X, y = make_classification(n_samples=1000, n_features=5) # 5维特征:recent_pet_clicks、total_clicks等

# 2. 训练LR模型

model = LogisticRegression()

model.fit(X, y)

# 3. 导出为ONNX模型

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

initial_type = [('float_input', FloatTensorType([None, 5]))]

onnx_model = convert_sklearn(model, initial_types=initial_type)

with open('lr_model.onnx', 'wb') as f:

f.write(onnx_model.SerializeToString())

第二步:用Flask部署推理服务

from flask import Flask, request, jsonify

import onnxruntime as rt

import numpy as np

app = Flask(__name__)

# 加载ONNX模型

sess = rt.InferenceSession('lr_model.onnx')

input_name = sess.get_inputs()[0].name # 输入节点名:float_input

output_name = sess.get_outputs()[0].name # 输出节点名:output_label

# 特征拼接函数:实时特征+离线特征

def merge_features(user_id):

# 1. 从Redis取实时特征

import redis

r = redis.Redis(host='redis', port=6379)

realtime_features = r.hgetall(f'user:{user_id}:realtime')

recent_pet_clicks = int(realtime_features.get(b'recent_pet_clicks', b'0'))

# 2. 从HBase取离线特征

offline_features = get_offline_feature(user_id)

total_clicks = offline_features['total_clicks']

preference_tags = offline_features['preference_tags']

is_pet_lover = 1 if 'pet' in preference_tags else 0 # 转成布尔特征

# 3. 拼接成模型输入(5维特征)

return np.array([

recent_pet_clicks,

total_clicks,

is_pet_lover,

0, # 占位符:可添加更多特征

0

], dtype=np.float32)

@app.route('/recommend', methods=['POST'])

def recommend():

user_id = request.json['user_id']

item_ids = request.json['item_ids'] # 需要评分的候选视频ID列表

# 1. 获取用户特征

user_features = merge_features(user_id)

# 2. 对每个候选视频计算推荐分数(假设视频特征已预存)

scores = []

for item_id in item_ids:

# 从HBase取视频特征(如:is_pet_video、duration)

item_features = get_item_feature(item_id)

# 拼接用户特征+视频特征(假设模型输入是10维)

model_input = np.concatenate([user_features, item_features])

# 模型推理

result = sess.run([output_name], {input_name: [model_input]})

score = result[0][0]

scores.append({"item_id": item_id, "score": float(score)})

# 3. 按分数排序,返回Top10

scores_sorted = sorted(scores, key=lambda x: x['score'], reverse=True)[:10]

return jsonify({"recommendations": scores_sorted})

if __name__ == '__main__':

app.run(host='0.0.0.0', port=5000, debug=False)

关键说明:

特征拼接:实时特征(如

recent_pet_clicks

total_clicks

is_pet_video

InferenceSession

item_ids

步骤五:系统优化——从“能跑”到“秒级响应”

完成上述步骤后,系统已经能运行,但要达到秒级延迟(端到端<1秒),还需要做以下优化:

1. 优化数据管道延迟

Kafka优化:

用

batch.size

linger.ms

compression.type

Flink优化:

用

EventTime

ProcessingTime

setParallelism

2. 优化特征读取延迟

Redis优化:

用Pipeline批量读取特征(比如一次读取10个用户的特征);用分片集群(Redis Cluster)解决单节点容量瓶颈;避免大Key(比如单个Key存储10万条数据),拆分到多个Key。

HBase优化:

预分区(Pre-splitting),避免热点问题;用布隆过滤器(Bloom Filter)加速RowKey查询。

3. 优化模型推理延迟

模型轻量化:

用LR/FM代替深度学习模型;对深度学习模型做量化(如将32位浮点转16位)、剪枝(删除不重要的权重)。

推理引擎优化:

用ONNX Runtime/TensorRT代替原生框架;用GPU加速(如NVIDIA T4显卡),推理速度比CPU快10倍以上。

4. 优化服务端延迟

异步处理:用

asyncio

CompletableFuture

5. 监控与调优

延迟监控:用Prometheus监控每个环节的延迟(Kafka consumer lag、Flink window delay、Redis响应时间、推理服务延迟);可视化:用Grafana展示延迟趋势,快速定位瓶颈(比如Kafka lag突然升高,说明消费者处理不过来);压测:用JMeter或Locust模拟百万级并发,测试系统的吞吐量与延迟。

进阶探讨:从“秒级”到“更智能”

当你实现了秒级推荐后,还可以探索以下进阶方向:

1. 混合推荐:实时+离线的融合

实时模型擅长捕捉短期兴趣(如用户刚点击的宠物视频),离线模型擅长捕捉长期兴趣(如用户过去30天的游戏偏好)。融合策略可以是:

加权融合:

最终分数 = 0.6×实时分数 + 0.4×离线分数

分数 = a×实时 + b×离线 + c

2. 流批一体:处理复杂事件

用Flink的**复杂事件处理(CEP)**识别用户的“复杂行为模式”,比如:

用户连续点击3个宠物视频→标记为“宠物爱好者”;用户在5分钟内评论2次→增加“互动活跃”标签。

代码示例:Flink CEP识别连续点击

import org.apache.flink.cep.CEP;

import org.apache.flink.cep.PatternStream;

import org.apache.flink.cep.pattern.Pattern;

import org.apache.flink.cep.pattern.conditions.SimpleCondition;

// 定义模式:连续3次点击宠物视频,间隔≤1分钟

Pattern<UserBehavior, ?> pattern = Pattern.<UserBehavior>begin("first_click")

.where(new SimpleCondition<UserBehavior>() {

@Override

public boolean filter(UserBehavior behavior) {

return behavior.getAction().equals("click") && behavior.getItemId().toString().startsWith("pet_");

}

})

.next("second_click")

.where(new SimpleCondition<UserBehavior>() {

@Override

public boolean filter(UserBehavior behavior) {

return behavior.getAction().equals("click") && behavior.getItemId().toString().startsWith("pet_");

}

})

.within(Time.minutes(1))

.next("third_click")

.where(new SimpleCondition<UserBehavior>() {

@Override

public boolean filter(UserBehavior behavior) {

return behavior.getAction().equals("click") && behavior.getItemId().toString().startsWith("pet_");

}

})

.within(Time.minutes(1));

// 应用模式到行为流

PatternStream<UserBehavior> patternStream = CEP.pattern(behaviorStream.keyBy(UserBehavior::getUserId), pattern);

// 处理匹配的事件

DataStream<String> resultStream = patternStream.select((patternMatchResult) -> {

UserBehavior first = patternMatchResult.get("first_click").get(0);

return "User " + first.getUserId() + " is a pet lover!";

});

3. 冷启动问题:新用户/新物品的推荐

新用户:用“热门推荐”+“内容-based推荐”(如根据用户注册时填写的兴趣标签推荐);新物品:用“关联推荐”(如与热门物品相似的新物品)+“实时探索”(给少量用户推荐新物品,快速收集反馈)。

总结:秒级推荐的核心逻辑

实现秒级推荐,本质是用“实时数据管道”连接用户行为与推荐结果,关键环节包括:

数据采集:用Kafka接收高并发行为数据;实时处理:用Flink计算新鲜的用户特征;特征存储:Redis存实时特征,HBase存离线特征;模型推理:用轻量级模型+优化引擎实现低延迟推理;系统优化:通过监控与调优,解决各个环节的延迟瓶颈。

通过本文的步骤,你已经可以搭建一个能处理百万级并发、端到端延迟<1秒的实时推荐系统原型。

行动号召:一起完善你的实时推荐系统

现在轮到你动手实践了!如果遇到以下问题,欢迎在评论区留言讨论:

Kafka consumer lag居高不下怎么办?Redis存储实时特征时出现大Key问题?模型推理延迟超过500ms如何优化?

也欢迎分享你在实时推荐中的实践经验,让我们一起把“秒级推荐”做得更智能、更稳定!

关注我,后续会更新实时推荐的AB测试、模型在线更新策略等进阶内容,敬请期待!

![[C++探索之旅] 第一部分第十一课:小练习,猜单词 - 鹿快](https://img.lukuai.com/blogimg/20251015/da217e2245754101b3d2ef80869e9de2.jpg)

暂无评论内容