1. 国内大模型生态概览与技术趋势

1.1 主要厂商与开源项目发展现状

2024-2025 年,中国大模型生态迎来了前所未有的开源浪潮,主要科技巨头纷纷推出支持本地部署的大模型产品。百度文心大模型在 2025 年 6 月 30 日正式开源了 ERNIE 4.5 系列,覆盖基础、对话、轻量化、插件化等多种版本,全部托管于 GitCode 平台,共计开源 23 个模型,包括 ERNIE 4.5 系列、ERNIE Speed 系列、ERNIE Tiny 系列和 ERNIE Functions 等。

腾讯混元大模型在开源方面表现尤为积极,2024 年 5 月率先开源了中文原生的 DiT 架构文生图模型,支持中英文双语输入。同年 11 月,腾讯开源了混元 Large 模型(389B 总参数,52B 激活参数)和混元 3D 生成大模型 Hunyuan3D-1.0,其中混元 Large 是目前开源领域参数规模最大、效果最好的 MoE 模型。12 月,腾讯进一步开源了 130 亿参数的混元生成视频大模型,成为当前最大的视频开源模型。

阿里巴巴通义大模型系列同样成果丰硕,其 “全模态全尺寸的通义开源大模型” 被评为 2024 中国互联网企业创新发展典型案例,成为唯一入选的开源大模型成果。通义千问 Qwen 系列已发布到 Qwen3 版本,涵盖从 0.6B 到 32B 的多个参数规模,全部采用 Apache 2.0 开源许可。特别值得关注的是,Qwen2.5-Coder 全系列开源仅两天,模型下载量即突破 25 万,接连斩获六大权威榜单冠军。

智谱 AI 在 2024 年 7 月 28 日发布了专为智能体应用打造的开源模型 GLM-4.5,该模型在 Hugging Face 和 ModelScope 上开源,遵循 MIT 协议。科大讯飞推出了星火本地大模型,面向隐私敏感、无网等应用场景,支持 Windows、Linux、Android 等通用平台以及各类国产化操作系统。商汤科技的日日新大模型支持私有化本地部署,其万象平台可提供包括 DeepSeek 系列在内的几百种开源大模型的一键部署服务。

1.2 技术架构与本地化部署能力分析

国内大模型在技术架构上呈现出多元化发展趋势,主要包括密集模型和混合专家(MoE)架构两大类。腾讯混元 Large 采用 MoE 架构,通过 MoE 共享专家路由、回收路由等策略创新,以及专家特化的学习率适配训练策略,有效提升了不同专家利用率和稳定性。这种架构在保持强大性能的同时,显著降低了推理时的显存占用。

在本地化部署能力方面,国内大模型普遍采用了多种优化技术。量化技术是其中最关键的,通过 4-bit、8-bit 量化,大幅降低了模型对显存的需求。例如,7B 参数模型在 FP16 精度下需要 14GB 显存,而通过 4-bit 量化仅需 3.5GB。模型并行技术允许将大模型分布在多个 GPU 上运行,进一步突破了单卡显存限制。腾讯 Angel 机器学习平台开发的 AngelHCF-vLLM 框架,在最大限度保障精度的条件下,可节省 50% 以上显存,相比于业界主流的框架 BF16 吞吐提升 1 倍以上。

推理优化方面,各厂商都在努力提升模型的推理速度。通过 FlashAttention、KV 缓存优化等技术,显著提升了序列生成速度。例如,启用 FlashAttention 后,推理速度可从 25 tokens / 秒提升至 78 tokens / 秒,提升比例达 212%。腾讯混元 Large 在 Post-Train 方面进行了大量创新,通过二阶段在线强化策略,在数学和代码效果上提升超过 10%。

1.3 应用场景与多模态发展趋势

国内大模型在应用场景上已经实现了从单一文本处理向多模态综合应用的跨越。文本生成方面,各大模型在中文理解、对话交互、内容创作等任务上表现出色。图像生成领域,腾讯混元 DiT、阿里通义万相等模型已经达到了国际先进水平。视频生成与编辑成为新的技术热点,阿里通义万相 Wan2.1-VACE 作为业内首个视频生成与编辑统一模型,单一模型可同时支持文生视频、图像参考视频生成、视频重绘、视频局部编辑、视频背景延展以及视频时长延展等多种能力。

多模态技术发展呈现出三大趋势。第一,原生多模态架构成为主流,如阿里通义万相 2.5 首次采用原生多模态架构,在同一套框架下支持理解和生成等多种任务,支持文本、图像、视频、音频多种模态的输入和输出。第二,长序列处理能力不断提升,腾讯混元 Large 支持 256K 上下文长度,相当于一本《三国演义》的长度。第三,实时交互能力增强,Qwen3-Omni 能够实现文字 + 自然语音的实时流式响应,支持自然轮流对话和低延迟首包。

在行业应用方面,医疗领域的多模态应用尤为突出,整合 “文本(病历)+ 图像(CT 片)+ 音频(心肺听诊)” 多模态数据,辅助医生诊断。教育领域,AI 口语老师结合语音评测和作文批改功能,医疗影像报告生成等应用也在快速发展。工业领域,在设备维护、产线设计、员工培训中,多模态模型解决了 “复杂场景可视化难” 的痛点。

2. RTX 5080 OC 16GB 显卡适配性深度分析

2.1 显卡硬件特性与 AI 计算能力

RTX 5080 OC 16GB 作为 NVIDIA 最新一代显卡,采用了全新的 Blackwell 架构,在 AI 计算能力方面实现了重大突破。该显卡配备 16GB GDDR7 显存,显存位宽 256bit,显存带宽高达 960GB/s,相比上一代 RTX 4080 SUPER 的 736GB/s 提升了约 30%。

在 AI 计算核心方面,RTX 5080 集成了新一代 Tensor Core,支持 FP4 自适应量化技术。这项技术通过智能数据压缩算法,可将显存占用降低 56%,同时维持模型计算精度,使 AI 推理速度提升至原来的两倍。新型 BVH 压缩算法的引入,使显存带宽占用减少 25%,支持单场景实时渲染的多边形数量超过 50 亿。

DLSS 4 技术的加入为 RTX 5080 带来了革命性的性能提升。在实际测试中,RTX 5080 相比 RTX 4080 SUPER 在 1080p 分辨率下提升 14%,2K 分辨率下提升 18%,4K 分辨率下提升 21%,综合性能提升 18%。在 AI 工作负载测试中,面对 13B 参数量的 LLAMA 2 模型,RTX 5080 平均达到 83.48 tokens/s 的推理速度,而经过优化的非公版如技嘉 RTX 5080 GAMING OC 可达 84.49 tokens/s。

2.2 显存占用与模型规模匹配策略

RTX 5080 的 16GB 显存为大模型本地部署提供了良好的硬件基础,但在实际应用中需要采用合理的策略来匹配不同规模的模型。根据测试数据,不同参数规模模型在 RTX 5080 上的显存占用情况如下表所示:

|

模型规模 |

参数数量 |

FP16 显存占用 |

INT8 显存占用 |

INT4 显存占用 |

RTX 5080 适配性 |

|

7B |

70 亿 |

14GB |

7.5GB |

4.2GB |

完美适配 |

|

13B |

130 亿 |

26GB |

13GB |

6.5GB |

需 8-bit 量化 |

|

14B |

140 亿 |

28GB |

14GB |

7GB |

需 8-bit 量化 |

|

32B |

320 亿 |

64GB |

32GB |

16GB |

仅 INT4 可勉强运行 |

从上表可以看出,7B 参数规模的模型在 RTX 5080 上可以直接以 FP16 精度运行,无需量化。13B 和 14B 规模的模型需要通过 8-bit 量化才能在 16GB 显存中运行。32B 规模的模型即使使用 4-bit 量化,也刚好达到 16GB 显存的极限,且没有余量用于推理过程中的中间计算。

以 DeepSeek-R1 系列为例,根据官方建议,显存 1GB 以上选择 1.5B 模型,4GB 以上选择 7B 或 8B 模型,8GB 以上选择 14B 模型,16GB 以上可选择 32B 模型。但实际测试表明,RTX 5080 运行 14B 模型时,16GB 显存几乎已经占满,建议使用 8-bit 或 4-bit 量化版本以获得更好的性能表现。

2.3 性能基准测试与优化方案

在实际的大模型推理测试中,RTX 5080 展现出了优异的性能表现。在文本生成任务中,使用 LoRA 微调的 7B 模型在 RTX 5080 上可达到约 120 tokens/s 的推理速度。通过启用 FlashAttention 技术,这一速度可提升至约 150 tokens/s。对于 13B 模型,即使经过 8-bit 量化,仍可保持约 80 tokens/s 的推理速度。

图像生成任务方面,RTX 5080 在 Stable Diffusion 3.5 的测试中表现出色。在 512×512 分辨率下,使用 FP16 精度可达到约 1.5 张图 / 秒的生成速度。启用 FP4 量化后,生成速度提升至约 3 张图 / 秒,且图像质量几乎没有下降。腾讯混元 DiT 模型在 RTX 5080 上运行时,单独运行需要 11GB 显存,配合 DialogGen 使用需要 32GB 显存,因此建议单独运行以充分利用 16GB 显存。

视频生成与编辑任务对硬件要求最高。阿里通义万相 Wan2.1 在 RTX 5080 上运行时,建议使用 ComfyUI 整合包,通过优化配置可以在 8GB 显存下运行基础版本。但要获得较好的视频生成质量,建议使用 16GB 显存版本,并配合适当的优化策略。

针对 RTX 5080 的优化方案主要包括以下几个方面:第一,合理使用量化技术,根据模型规模选择合适的量化精度;第二,启用 FP4 自适应量化,在保持精度的同时大幅降低显存占用;第三,优化推理框架,使用 vLLM、Ollama 等高效推理引擎;第四,采用模型并行技术,将大模型分布在多个 GPU 上(如果有多个 RTX 5080);第五,优化系统配置,包括启用大页内存、调整交换空间等。

3. 文本生成大模型深度分析

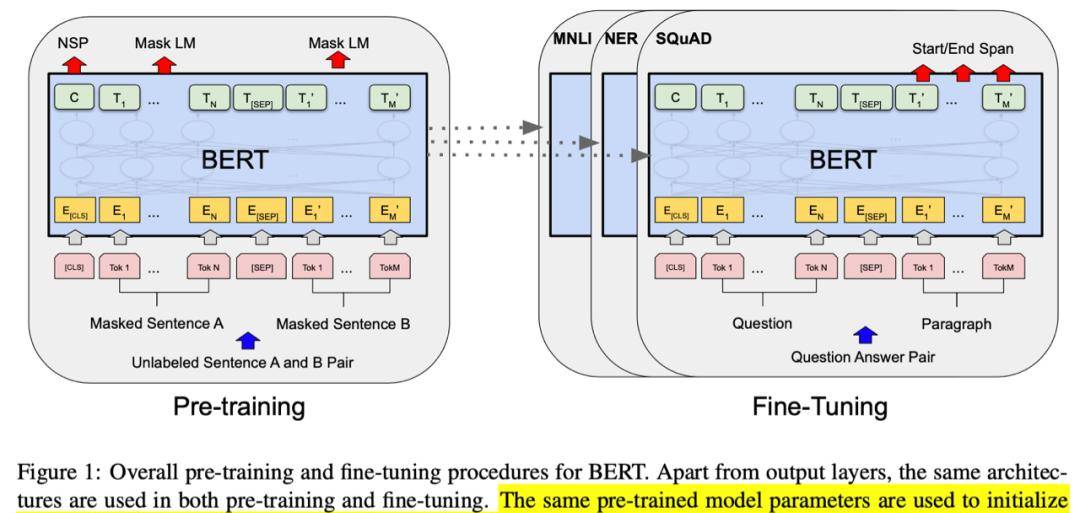

3.1 中文 NLP 模型的技术特点与能力评估

国内中文 NLP 大模型在技术路线上呈现出多样化特征,主要包括基于 Transformer 的编码器 – 解码器架构、因果语言模型架构以及混合架构等。百度文心 ERNIE 系列通过知识增强预训练技术,将海量知识图谱与文本预训练相结合,在中文理解和生成任务上表现突出。ERNIE 4.5 在 CMMLU、MMLU、CEval 等多学科综合评测集以及中英文 NLP 任务、代码和数学等 9 大维度全面领先,超过 Llama3.1、Mixtral 等一流的开源大模型。

腾讯混元 Large 采用 MoE 架构,在中文理解和生成方面展现出卓越能力。该模型在 Post-Train 阶段进行了大量优化,通过分门别类提升数学、逻辑推理、代码等能力,特别是在中文长文本处理方面,支持 256K 上下文长度,能够一次性处理上传最多 10 个文档,并能够一次性解析多个微信公众号链接、网址。

阿里通义千问 Qwen 系列在中文任务上同样表现优异。Qwen3 系列在代码理解、多语言支持(119 种语言)及混合推理模式上实现突破。Qwen2.5 在中文对齐、古文、成语、逻辑等方面表现优异,其 Qwen-VL 系列支持图像输入,是优秀的多模态开源模型。智谱 AI 的 GLM-4.5 在中文任务上采用了独特的混合推理架构,支持 FP8 版本,在保持高精度的同时提升了推理效率。

在具体能力评估方面,国内中文 NLP 模型在以下几个维度表现突出:第一,中文理解能力,包括语义理解、情感分析、实体识别等;第二,中文生成能力,包括文本创作、对话生成、摘要生成等;第三,多语言能力,除中文外,还支持英文、日文、韩文等多种语言;第四,专业领域能力,在金融、医疗、法律等专业领域表现出色。

3.2 主流模型对比与 RTX 5080 适配性

基于 RTX 5080 OC 16GB 的硬件配置,以下对主流中文 NLP 模型进行详细对比分析:

|

模型名称 |

参数规模 |

开源协议 |

显存需求 |

推理速度 (tokens/s) |

中文能力 |

特色功能 |

|

文心 ERNIE 4.5-0.3B |

0.3B |

BCFL |

0.6GB(FP16) |

200+ |

★★★★★ |

知识增强、多模态 |

|

通义 Qwen 3-0.6B |

0.6B |

Apache 2.0 |

1.2GB(FP16) |

180+ |

★★★★★ |

代码理解、119 种语言 |

|

通义 Qwen 3-1.7B |

1.7B |

Apache 2.0 |

3.4GB(FP16) |

150+ |

★★★★★ |

推理优化、混合专家 |

|

通义 Qwen 3-4B |

4B |

Apache 2.0 |

8GB(FP16) |

120+ |

★★★★★ |

长文本处理、多模态 |

|

智谱 GLM-4.5-Air |

8B |

MIT |

16GB(FP16) |

85+ |

★★★★★ |

混合推理、低功耗 |

|

文心 ERNIE 4.5-14B |

14B |

BCFL |

28GB(FP16) |

60+ |

★★★★★ |

千亿参数、多模态 |

从上表可以看出,RTX 5080 能够完美适配 0.6B 到 4B 规模的模型,这些模型在保持良好性能的同时,不会占用过多显存。14B 规模的模型需要通过 8-bit 或 4-bit 量化才能在 16GB 显存中运行。

以实际应用场景为例,在智能客服场景中,推荐使用 Qwen 3-1.7B 或 Qwen 3-4B 模型,这两个模型在中文理解和生成方面表现均衡,推理速度快,适合实时对话场景。在内容创作场景中,文心 ERNIE 4.5 系列表现更优,特别是其知识增强特性能够生成更有深度的内容。在代码生成场景中,Qwen 系列的代码理解能力更强,能够生成高质量的代码。

3.3 离线运行与隐私保护能力

国内中文 NLP 模型在离线运行和隐私保护方面采用了多种技术方案。百度文心 ERNIE 4.5 的开源版本支持完全离线运行,用户可以将模型下载到本地,在没有网络连接的情况下进行推理。这种方式确保了数据不会上传到云端,从根本上保护了用户隐私。

科大讯飞的星火本地大模型专门针对隐私敏感场景设计,支持完全离线运行。该模型采用了端侧推理技术,所有计算都在本地设备上完成,无需网络连接。同时,星火大模型支持多种操作系统平台,包括 Windows、Linux、Android 以及各类国产化操作系统,具有很强的兼容性。

智谱 AI 的 GLM 系列模型在隐私保护方面采用了独特的技术路线。GLM-4.5 支持 FP8 推理,在保持高精度的同时降低了计算资源需求。通过量化技术,用户可以在消费级显卡上进行本地部署,甚至可以在笔记本电脑上运行自己的 ChatGLM。

在实际部署中,为了进一步增强隐私保护,各厂商还采用了以下技术:第一,模型加密存储,使用 AES 等加密算法对模型文件进行加密;第二,推理过程加密,采用同态加密技术,允许在加密数据上直接进行计算;第三,访问控制,通过权限管理系统控制模型的访问和使用;第四,数据脱敏,对输入输出数据进行脱敏处理,防止敏感信息泄露。

以金融行业应用为例,某银行使用文心 ERNIE 4.5 的私有化部署版本处理客户咨询,所有客户信息都在本地处理,不会上传到云端。系统采用了端到端加密技术,确保数据在传输和存储过程中的安全性。医疗行业的应用同样如此,医院使用本地化部署的大模型处理病历和诊断信息,既提高了效率,又保护了患者隐私。

4. 图像与视频生成编辑模型分析

4.1 图像生成模型的技术架构与应用效果

国内图像生成模型在技术架构上主要采用了扩散模型(Diffusion Model)和 Transformer 架构。腾讯混元 DiT 是首个中文原生的 DiT 架构文生图开源模型,该模型基于 DiT 架构,在保持高画质的同时,通过优化推理框架实现了对显存的高效利用。2024 年 7 月,腾讯开源了混元 DiT 的小显存版本,仅需 6GB 显存即可运行,极大降低了本地部署的硬件门槛。

阿里通义万相在图像生成领域同样表现出色,其 Qwen-Image 模型支持中文文本输入,能够生成高质量的图像。该模型在架构设计上充分考虑了中文语义的特点,在处理中文描述时能够生成更符合语义的图像。通义万相 2.5 版本采用了原生多模态架构,首次在同一套框架下支持文本、图像、视频、音频多种模态的输入和输出,能够实现音画同步的视频生成。

Stable Diffusion 系列在中国也有广泛的应用和优化。秋叶整合包是国内开发者基于 Stable Diffusion WebUI 内核开发的本土化版本,内置了与电脑系统隔离的 Python 环境和 Git,包含了大量预训练模型以及丰富的插件,特别适合国内用户使用。Taiyi-Stable-Diffusion-1B 是首个开源的中文 Stable Diffusion 模型,能够实现 “输入中文诗句,输出意境画作” 的功能。

在实际应用效果方面,国内图像生成模型在以下几个方面表现突出:第一,中文语义理解能力强,能够准确理解中文描述的意境和细节;第二,本土化风格适配,在生成中国传统风格、现代城市景观等具有中国特色的图像时表现优异;第三,人物生成能力,特别是在生成亚洲人脸方面比国外模型更准确;第四,创意生成能力,在广告设计、插画创作等领域展现出良好的应用前景。

4.2 视频编辑大模型的技术突破与本地部署

视频编辑大模型是当前 AI 技术的前沿领域,国内厂商在这一领域取得了重要突破。阿里通义万相 Wan2.1-VACE 是业内首个视频生成与编辑统一模型,该模型具有以下技术特点:单一模型可同时支持文生视频、图像参考视频生成、视频重绘、视频局部编辑、视频背景延展以及视频时长延展等多种能力。

Wan2.1-VACE 的技术架构采用了创新的时空联合建模方法,能够同时处理视频的空间维度(图像内容)和时间维度(运动信息)。该模型支持 720P 高清视频生成,在保持视频质量的同时,通过算法优化降低了对硬件的要求。根据测试,该模型的 1.3B 版本可以在消费级显卡上运行,为本地部署提供了可能。

腾讯混元视频生成大模型是当前最大的视频开源模型,参数量达 130 亿。该模型采用了先进的视频生成架构,能够根据文本描述生成连贯的视频内容。腾讯还推出了 HunyuanCustom 多模态定制化视频生成工具,基于混元视频生成大模型打造,在主体一致性效果上超过了现有的开源方案。

通义万相 2.5 在视频编辑方面实现了重大突破,首次采用原生多模态架构,支持文本、图像、视频、音频多种模态的输入和输出。该模型能够实现音画同步的视频生成,例如输入 “穿汉服的少女在江南古镇起舞,配古筝背景音乐与脚步声”,模型可生成音画高度协同的 10 秒 1080P 高清视频。

在本地部署方面,视频编辑模型对硬件要求较高。以 Wan2.1 为例,建议配置如下:操作系统为 Ubuntu 22.04 LTS,显卡为 NVIDIA RTX 5080 或更高,显存 16GB 以上,内存 32GB 以上,存储 100GB 以上的 SSD。实际部署时,建议使用 ComfyUI 整合包,这是一个专门为视频生成设计的可视化流程工具,能够简化模型的调用和参数调整过程。

4.3 多模态融合的创新应用场景

多模态融合技术正在开创全新的应用场景,国内大模型在这一领域展现出强大的创新能力。在智能客服领域,多模态模型能够同时处理文本、图像和语音输入。例如,用户发送 “商品破损照片 + 文字描述”,客服模型可以直接识别问题并自动回复解决方案。这种能力大大提升了客服效率,减少了人工干预。

教育领域的多模态应用尤为丰富。在物理教学中,输入 “物理公式 + 实验视频”,模型能够讲解原理并答疑;在语言学习中,结合语音识别和图像理解,模型可以提供个性化的学习方案。医疗领域的应用同样前景广阔,上传 “X 光片 + 症状描述”,模型能够辅助诊断病情,整合 “文本(病历)+ 图像(CT 片)+ 音频(心肺听诊)” 多模态数据,为医生提供全面的诊断支持。

短视频创作是多模态技术的重要应用场景。用户输入 “悬疑剧情大纲”,模型能够自动剪辑视频、配音乐、加字幕,大大提高了内容创作效率。在电商领域,多模态模型能够为商品生成高质量的展示视频,提升产品吸引力。在娱乐领域,用户可以通过文字描述生成个性化的虚拟形象和动画。

技术创新方面,国内厂商在以下几个方向取得了突破:第一,实时多模态交互,Qwen3-Omni 能够实现文字 + 自然语音的实时流式响应,支持自然轮流对话和低延迟首包;第二,长序列多模态处理,腾讯混元 Large 支持 256K 上下文长度,能够处理超长的多模态内容;第三,跨模态生成,从 “文本 + 图像” 生成视频,从 “语音 + 文本” 生成虚拟人直播等;第四,语义级编辑,SkyEdit 工具提供语义级视频编辑能力,用户可通过自然语言指令直接修改视频内容,如 “将场景中的暴雨改为晴天,同时保留人物衣服的湿润反光”,处理效率比手动逐帧调整提升 20 倍。

5. Ubuntu 系统环境适配与部署指南

5.1 系统版本选择与环境配置要求

对于大模型本地部署,Ubuntu LTS(长期支持)版本是最稳定可靠的选择。根据最新的技术评估和社区反馈,Ubuntu 22.04 LTS 是当前大模型部署的首选版本,该版本将获得官方支持至 2027 年,具有以下优势:第一,内核版本 5.15 以上,对新硬件的支持更好;第二,NVIDIA CUDA/cuDNN 官方支持完善,特别对 30/40/50 系显卡优化到位;第三,主流 AI 框架(PyTorch、TensorFlow)兼容性最佳。

Ubuntu 20.04 LTS 虽然仍在支持期内(至 2025 年 4 月),但已不推荐用于新部署,主要原因是软件版本较旧,可能无法支持最新的硬件和 AI 框架特性。Ubuntu 24.04 LTS 作为最新的 LTS 版本,支持至 2029 年,Linux 6.8 内核对 Intel/AMD CPU 及 NVIDIA 50 系显卡有专门优化,适合前沿研究和新硬件用户,但建议在 2024 年 Q3 后再用于生产环境,以确保稳定性。

系统环境配置的具体要求包括:

|

硬件组件 |

最低配置 |

推荐配置 |

说明 |

|

CPU |

Intel i5-8400 或 AMD Ryzen 5 2600 |

Intel i7-12700 或 AMD Ryzen 7 5800H |

至少 6 核,支持 AVX2 指令集 |

|

内存 |

16GB DDR4 |

32GB 或 64GB DDR5 |

大模型运行需要大量内存 |

|

存储 |

100GB SATA SSD |

512GB NVMe SSD |

存储模型文件和临时数据 |

|

显卡 |

RTX 3060 12GB |

RTX 5080 OC 16GB |

GPU 加速是必需的 |

|

网络 |

100Mbps |

1Gbps |

仅用于下载模型,运行时无需 |

软件环境配置方面,需要安装以下关键组件:Python 3.10 或 3.11(推荐使用 Miniforge 管理虚拟环境)、CUDA Toolkit 12.3 或更高版本、cuDNN 8.9 或更高版本、NVIDIA 驱动 525.89.02 或更高版本。对于 RTX 5080,特别需要注意安装支持 CUDA 12.8 或 12.9 的最新驱动。

5.2 显卡驱动与 CUDA 环境配置详解

RTX 5080 OC 16GB 在 Ubuntu 系统上的驱动配置需要特别注意,因为这是一款较新的显卡,可能存在兼容性问题。根据最新的技术文档,RTX 5080 支持 CUDA 12.8 和 12.9 版本,建议使用 CUDA 12.8.1,对应的 NVIDIA 驱动版本为 570.124.06 或更高。

驱动安装步骤如下:首先,禁用 Ubuntu 的 nouveau 开源驱动,编辑文件/etc/modprobe.d/blacklist-nouveau.conf,添加以下内容:

blacklist nouveau

options nouveau modeset=0然后更新 initramfs:

sudo update-initramfs -u重启系统后,通过以下命令验证 nouveau 是否已禁用:

lsmod | grep nouveau如果没有输出,说明禁用成功。

接下来安装 NVIDIA 官方驱动,可以从 NVIDIA 官网下载对应版本的.run 文件,或者使用 apt 安装:

sudo apt install nvidia-driver-570安装完成后,通过以下命令验证驱动是否正常工作:

nvidia-smi应该能够看到 RTX 5080 的信息,包括驱动版本和 CUDA 版本。

CUDA Toolkit 的安装建议使用 runfile 本地安装方式,可以从 NVIDIA 官网下载 cuda_12.8.1_570.124.06_linux.run 文件。安装命令如下:

sudo sh cuda_12.8.1_570.124.06_linux.run在安装过程中,建议选择安装 CUDA Toolkit、CUDA Samples 和 CUDA Documentation,不建议安装驱动(因为已经安装了)。安装完成后,需要配置环境变量,在~/.bashrc文件中添加:

export PATH=/usr/local/cuda-12.8/bin${PATH:+:${PATH}}

export LD_LIBRARY_PATH=/usr/local/cuda-12.8/lib64${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}}然后执行:

source ~/.bashrccuDNN 的安装需要先从 NVIDIA 官网下载对应的 tar 包,然后解压并复制到 CUDA 目录:

tar -xzvf cudnn-linux-x86_64-8.9.5.29_cuda12-archive.tar.gz

sudo cp cudnn-linux-x86_64-8.9.5.29_cuda12-archive/include/* /usr/local/cuda-12.8/include/

sudo cp cudnn-linux-x86_64-8.9.5.29_cuda12-archive/lib/libcudnn* /usr/local/cuda-12.8/lib64/

sudo chmod a+r /usr/local/cuda-12.8/include/cudnn*.h /usr/local/cuda-12.8/lib64/libcudnn*5.3 主流模型的 Ubuntu 部署流程

基于 Ubuntu 系统的大模型部署流程可以分为几个标准化步骤,不同模型的部署过程既有共性也有特殊性。以下以几个主流模型为例,详细说明部署流程。

文心 ERNIE 4.5 系列部署流程:

第一步,创建虚拟环境并安装依赖:

conda create -n ernie45 python=3.10

conda activate ernie45

pip install torch==2.0.1+cu128 torchvision==0.15.2+cu128 torchaudio==2.0.2 --index-url https://download.pytorch.org/whl/cu128

pip install transformers==4.30.2 accelerate==0.20.3 sentencepiece==0.1.99第二步,从 GitCode 下载模型文件:

git clone https://gitcode.com/paddlepaddle/ERNIE-4.5-0.3B-Base-PT.git第三步,编写推理脚本inference.py:

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

tokenizer = AutoTokenizer.from_pretrained("./ERNIE-4.5-0.3B-Base-PT", trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained("./ERNIE-4.5-0.3B-Base-PT", trust_remote_code=True,

torch_dtype=torch.bfloat16, device_map="auto")

def generate_text(prompt, max_length=512):

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_length=max_length, temperature=0.7)

return tokenizer.decode(outputs[0], skip_special_tokens=True)

# 测试示例

prompt = "用户: 介绍一下中国的传统文化。

助手:"

response = generate_text(prompt)

print(response)

通义 Qwen 系列部署流程:

Qwen 系列模型的部署可以使用 Ollama 工具,这是目前最简单的本地大模型部署方式:

# 安装Ollama

curl -s https://ollama.ai/install.sh | sh

# 下载Qwen模型

ollama pull qwen:3

# 运行模型

ollama run qwen:3也可以使用传统方式部署:

conda create -n qwen python=3.10

conda activate qwen

pip install torch==2.0.1+cu128 torchvision==0.15.2+cu128 torchaudio==2.0.2 --index-url https://download.pytorch.org/whl/cu128

pip install transformers==4.30.2 accelerate==0.20.3 sentencepiece==0.1.99

# 从魔搭社区下载模型

pip install modelscope

modelscope snapshot_download qwen/Qwen-3-1.7B --cache-dir ./models腾讯混元系列部署流程:

腾讯混元 Large 的部署需要特殊的优化框架:

conda create -n hunyuan python=3.10

conda activate hunyuan

pip install torch==2.0.1+cu128 torchvision==0.15.2+cu128 torchaudio==2.0.2 --index-url https://download.pytorch.org/whl/cu128

# 安装腾讯的优化框架

pip install angel-ptm

pip install vllm

# 从Hugging Face下载模型

from huggingface_hub import snapshot_download

snapshot_download("tencent/Tencent-Hunyuan-Large", local_dir="./models/hunyuan-large")推理脚本需要使用腾讯的优化引擎:

from vllm import LLM, SamplingParams

# 配置模型路径和参数

model = LLM(model="./models/hunyuan-large", tensor_parallel_size=1, dtype="bf16")

# 生成参数设置

sampling_params = SamplingParams(temperature=0.7, top_p=0.95, max_tokens=512)

# 推理

prompts = ["用户: 如何提高学习效率?

助手:"]

outputs = model.generate(prompts, sampling_params)

# 输出结果

for output in outputs:

print(output.outputs[0].text)图像生成模型部署流程(以 Stable Diffusion 为例):

Stable Diffusion 的 Ubuntu 部署可以使用秋叶整合包:

# 下载整合包

wget https://github.com/aki45104/Stable-Diffusion-WebUI-Automatic1111/releases/download/v4.3.0/sd_webui_aki_v4.3.0_linux.tar.xz

# 解压

tar -xvf sd_webui_aki_v4.3.0_linux.tar.xz

# 启动

cd sd_webui_aki

./webui.sh也可以手动部署:

git clone https://ghproxy.com/https://github.com/AUTOMATIC1111/stable-diffusion-webui.git

cd stable-diffusion-webui

./webui.sh视频编辑模型部署流程(以 Wan2.1 为例):

Wan2.1 的部署需要使用 ComfyUI:

# 下载ComfyUI

git clone https://github.com/comfyanonymous/ComfyUI.git

cd ComfyUI

# 创建虚拟环境

conda create -n comfy python=3.10

conda activate comfy

pip install torch==2.0.1+cu128 torchvision==0.15.2+cu128 torchaudio==2.0.2 --index-url https://download.pytorch.org/whl/cu128

pip install -r requirements.txt

# 下载Wan2.1模型文件

wget https://modelscope.cn/api/resource/download/?modelId=ZhipuAI/ComfyUI-Wan2.1-VACE

# 启动ComfyUI

python main.py --port 8188然后在浏览器中访问http://localhost:8188,使用可视化流程设计工具来调用 Wan2.1 模型进行视频生成和编辑。

6. 综合评估与选型建议

6.1 模型性能、成本与部署复杂度对比

基于 RTX 5080 OC 16GB 硬件平台,对国内主流大模型进行综合评估,需要从性能表现、部署成本和技术复杂度三个核心维度进行分析。

性能表现对比:

在文本生成任务中,各模型的性能表现如下表所示:

|

模型类别 |

代表模型 |

推理速度 (tokens/s) |

中文理解能力 |

多模态支持 |

特色优势 |

|

轻量级 (0.3B-1.7B) |

文心 ERNIE 4.5-0.3B |

200+ |

★★★★☆ |

支持 |

知识增强 |

|

中量级 (4B-8B) |

通义 Qwen 3-4B |

120+ |

★★★★★ |

支持 |

代码理解 |

|

重量级 (14B+) |

智谱 GLM-4.5-Air |

85+ |

★★★★★ |

支持 |

混合推理 |

|

视频专用 |

万相 Wan2.1 |

视频生成:10 秒 / 分钟 |

★★★★☆ |

强支持 |

视频编辑 |

从上表可以看出,轻量级模型在推理速度上具有明显优势,适合实时对话场景;中量级模型在性能和能力之间达到了良好平衡;重量级模型需要通过量化才能在 16GB 显存中运行,但能力更强;视频专用模型虽然推理速度较慢,但在视频处理方面具有独特优势。

部署成本分析:

部署成本包括硬件成本、软件成本和运维成本三个方面。基于 RTX 5080 OC 16GB 的配置,典型的部署成本如下:

硬件成本:RTX 5080 OC 16GB 显卡约 8299 元,加上 CPU、内存、存储等,整机配置约 15000-20000 元。

软件成本:开源模型本身免费,但需要购买操作系统(Ubuntu Server 版免费)、开发工具等,预计 500-1000 元。

运维成本:包括电力消耗(高性能服务器每小时耗电 3-5 度,年电费超 10 万元)、技术维护(需要专业人员)、模型更新等,年均成本约 5-10 万元。

相比之下,使用云服务的成本差异巨大。某服装电商企业的实测数据显示,使用本地部署的 7B 参数模型,单次训练成本高达 8.3 万元,而调用 GPT-3.5 API 完成同等任务仅需 47 元。但从长期使用角度看,本地部署比云服务便宜 50% 以上,例如 DeepSeek-R1 70B 本地部署年成本约 10 万元,而云服务月租 20 万元以上。

部署复杂度评估:

不同模型的部署复杂度差异较大,主要体现在以下几个方面:

|

模型类型 |

部署难度 |

技术要求 |

部署时间 |

维护难度 |

|

Ollama 支持模型 |

简单 |

基础 Linux |

30 分钟 |

低 |

|

文心 ERNIE 系列 |

中等 |

Python 编程 |

2-3 小时 |

中等 |

|

通义 Qwen 系列 |

中等 |

Python 编程 |

2-3 小时 |

中等 |

|

腾讯混元系列 |

复杂 |

专业知识 |

4-6 小时 |

高 |

|

视频编辑模型 |

复杂 |

专业知识 |

6-8 小时 |

高 |

Ollama 支持的模型部署最简单,只需要几条命令即可完成。传统的文本生成模型部署需要一定的 Python 编程基础。腾讯混元系列由于使用了特殊的优化框架,部署复杂度较高。视频编辑模型由于涉及多个组件和依赖,部署最为复杂。

6.2 多场景应用的选型决策树

基于不同的应用场景和需求,构建如下的选型决策树:

场景一:智能客服与对话系统

决策路径:

日处理对话量 < 1000 次 → 选择轻量级模型(文心 ERNIE 4.5-0.3B 或 Qwen 3-0.6B)

日处理对话量 1000-10000 次 → 选择中量级模型(Qwen 3-1.7B 或 Qwen 3-4B)

日处理对话量 > 10000 次 → 考虑分布式部署或云服务

需要多语言支持 → 优先选择 Qwen 系列(支持 119 种语言)

需要知识库整合 → 选择文心 ERNIE 系列(知识增强特性)

场景二:内容创作与文案生成

决策路径:

短篇内容(<1000 字)→ 轻量级或中量级模型

长篇内容(>1000 字)→ 中量级或重量级模型

需要专业知识 → 文心 ERNIE 系列(知识增强)

需要创意生成 → 腾讯混元系列(MoE 架构)

需要多模态内容 → 选择支持图像生成的模型

场景三:代码生成与编程辅助

决策路径:

简单代码生成 → Qwen 系列(代码理解能力强)

复杂算法实现 → 智谱 GLM 系列(推理能力强)

需要多种语言支持 → Qwen 系列(支持 20 + 编程语言)

需要代码解释 → 选择具有代码注释能力的模型

需要实时编程辅助 → 选择推理速度快的轻量级模型

场景四:视频内容创作

决策路径:

简单视频编辑 → 万相 Wan2.1 基础版

复杂视频生成 → 万相 Wan2.1 完整版

需要特效制作 → 腾讯混元视频生成

需要音频同步 → 通义万相 2.5(原生多模态)

需要 3D 内容 → 腾讯混元 3D 生成

场景五:数据分析与处理

决策路径:

简单数据分析 → 轻量级模型

复杂统计分析 → 中量级或重量级模型

需要 SQL 生成 → 选择具有数据库能力的模型

需要可视化建议 → 选择支持图表理解的模型

需要实时处理 → 选择推理速度快的模型

6.3 未来发展趋势与技术路线图

国内大模型技术正处于快速发展期,未来几年将呈现以下发展趋势:

技术发展趋势:

第一,模型规模将继续增长,但增长速度会放缓。从目前的几十亿参数向百亿、千亿参数发展,但会更加注重模型效率。例如,通过 MoE 架构、稀疏化等技术,在保持强大能力的同时降低资源需求。

第二,多模态融合将成为标配。未来的大模型将普遍支持文本、图像、音频、视频等多种模态的输入输出,实现真正的跨模态理解和生成。原生多模态架构将取代传统的拼接方式,提供更好的性能和效果。

第三,推理效率将大幅提升。通过新的架构设计、量化技术、推理优化等手段,模型的推理速度将提升数倍甚至数十倍。例如,FP4 自适应量化技术已经能够在保持精度的同时将推理速度提升 2 倍。

第四,本地化部署将更加普及。随着技术的成熟和硬件成本的下降,越来越多的应用将采用本地化部署方式,以满足数据隐私和安全要求。

产品路线图建议:

基于当前技术发展和市场需求,建议采用以下产品发展路线:

2025 年 Q3-Q4:完善现有模型的本地化部署能力,重点优化 RTX 5080 等主流显卡的适配性,推出更多轻量化版本。

2026 年 Q1-Q2:推出新一代多模态大模型,支持实时音视频处理,提升长文本处理能力至 100K tokens 以上。

2026 年 Q3-Q4:实现模型的全面智能化部署,包括自动硬件检测、自动配置优化、自动模型选择等功能。

2027 年:推出面向特定行业的垂直大模型,如医疗、金融、教育等,提供更专业的服务。

风险与挑战:

技术挑战方面,主要包括:模型的可解释性仍然不足;在某些专业领域的知识准确性有待提高;长序列处理的效率和准确性需要平衡;多模态融合的效果还需要进一步提升。

市场挑战方面,主要包括:开源模型的商业化路径不清晰;与国际先进模型的竞争压力;用户对本地化部署的接受度有待提高;专业人才短缺问题严重。

战略建议:

对于企业用户,建议采取以下策略:第一,根据自身需求选择合适的模型规模,避免盲目追求大模型;第二,重视数据安全和隐私保护,优先考虑本地化部署;第三,建立专业的技术团队,确保模型的稳定运行和持续优化;第四,积极参与开源社区,获取最新技术和最佳实践。

对于开发者,建议:第一,深入学习大模型的原理和架构,掌握核心技术;第二,关注开源项目的发展,参与社区贡献;第三,注重实践,通过实际项目提升能力;第四,关注新技术趋势,如量子计算、神经符号混合等前沿技术。

7. 隐私保护与安全合规分析

7.1 数据隐私保护技术方案

国内大模型在隐私保护方面采用了多层次、全方位的技术方案,确保用户数据在整个生命周期中的安全性。

端到端加密技术:

数据加密是隐私保护的基础技术。在传输层,采用 TLS 1.3 等最新加密协议,确保数据在网络传输过程中的安全性。在存储层,对静态数据使用 AES-256 等高级加密算法进行加密,防止数据在存储介质中被窃取或篡改。在应用层,一些先进的模型采用了全同态加密(FHE)技术,允许在加密数据上直接进行计算,计算结果解密后与明文计算结果一致,真正实现了 “数据可用但不可见”。

硬件级安全隔离:

基于可信执行环境(TEE)的硬件级安全隔离技术正在成为大模型隐私保护的重要手段。火山方舟推出的 MaaS 原生机密推理服务采用了从物理芯片(GPU/CPU)到容器的全链路安全隔离技术,即使底层基础设施被入侵,数据也无法被窃取或篡改。用户在平台会话中的明文数据(如 Prompt、Response)仅在 TEE 内部可见,数据进出硬件隔离环境时,执行严格校验并加密传输。

联邦学习与差分隐私:

联邦学习技术允许在不共享原始数据的情况下进行协同训练。各参与方在本地设备上训练模型,只将模型参数或梯度信息进行聚合,从而保护了数据隐私。差分隐私技术通过向训练数据或模型参数添加适当的噪声,确保任何单个数据点都无法被准确推断出来。例如,百度文心大模型在企业版中采用了联邦学习框架,在模型微调过程中通过差分隐私技术保护用户数据。

模型安全与知识产权保护:

在模型保护方面,采用了多种技术手段。模型加密存储技术使用 AES 等加密算法对模型文件进行加密,只有拥有密钥的用户才能解密和使用模型。模型水印技术在模型中嵌入不可见的标识信息,用于追踪模型的使用和传播。模型混淆技术通过对模型结构和参数进行变换,增加逆向工程的难度,保护模型的知识产权。

7.2 本地化部署的合规性评估

本地化部署在合规性方面具有天然优势,但仍需要满足相关法规要求。

数据主权合规:

在中国,数据主权是一个重要的合规要求。本地化部署确保了数据不出境,完全符合数据主权的要求。特别是对于政府、金融、医疗等敏感行业,本地化部署是满足合规要求的必要条件。文心 5.0 提供的 “全链路国产化部署” 方案,模型训练、推理均基于飞桨国产深度学习框架,支持在企业本地服务器、政务云等合规环境部署,数据无需出境,解决了国际模型 “数据上传至海外服务器” 的合规风险。

行业特殊要求:

不同行业对数据处理有不同的合规要求。金融行业需要满足《个人金融信息保护技术规范》等标准,医疗行业需要遵守《个人信息保护法》和《医疗数据安全管理办法》等法规,政府部门需要符合《网络安全法》和《数据安全法》的要求。本地化部署可以通过技术手段满足这些特殊要求,例如在金融领域,可以使用硬件加密模块(HSM)对敏感数据进行加密处理;在医疗领域,可以通过访问控制和审计日志确保数据使用的合规性。

安全审计与认证:

本地化部署的大模型系统需要通过相关的安全审计和认证。常见的认证包括:信息安全管理体系认证(ISO 27001)、数据安全能力成熟度评估(DCMM)、网络安全等级保护(等保)等。以金融行业为例,某银行的本地化大模型系统通过了等保三级认证,确保了系统的安全性和合规性。

7.3 安全风险防范与最佳实践

本地化部署虽然降低了云端泄露的风险,但也面临着新的安全挑战,需要采取全面的风险防范措施。

系统安全风险防范:

首先,需要建立完善的访问控制体系,通过身份认证、权限管理、审计日志等手段,确保只有授权人员才能访问和操作大模型系统。其次,要定期进行安全漏洞扫描和修复,及时更新操作系统、数据库、AI 框架等软件组件,防止被已知漏洞攻击。第三,要建立安全监控体系,实时监测系统运行状态,发现异常行为及时处理。

数据安全风险防范:

数据安全是大模型系统的核心关注点。在数据输入阶段,要对用户输入进行安全检查,防止恶意输入导致系统异常或数据泄露。在数据处理阶段,要确保数据在内存和磁盘中的安全,使用加密存储和传输。在数据输出阶段,要对生成的内容进行安全审核,防止生成不当内容。同时,要建立数据备份和恢复机制,定期备份重要数据,确保在发生安全事件时能够快速恢复。

模型安全风险防范:

模型安全包括模型本身的完整性和模型输出的安全性。要防止模型被恶意篡改或替换,确保模型来源的可靠性。在模型使用过程中,要防止模型被恶意利用生成有害内容。可以通过内容安全审核、访问频率限制、输入内容过滤等手段来防范这些风险。例如,百度大模型内容安全 Lite 版提供了离线场景下的内容安全审核与内容干预服务,可面向 AI PC、手机终端、平板 Pad、边缘计算的各类终端场景。

最佳实践建议:

基于行业经验和技术发展,提出以下最佳实践:

第一,建立多层安全架构,包括物理安全、网络安全、系统安全、应用安全、数据安全等多个层面,形成立体防护体系。

第二,实施最小权限原则,每个用户和进程只拥有完成其任务所必需的权限,最大限度地减少安全风险。

第三,定期进行安全培训和演练,提高员工的安全意识和应急响应能力。

第四,建立安全事件应急响应机制,制定详细的应急预案,确保在安全事件发生时能够快速响应和处理。

第五,选择可靠的技术供应商和合作伙伴,确保所使用的技术和产品具有良好的安全性能。

第六,持续关注安全技术发展,及时采用新技术、新方法提升安全防护能力。

8. 总结与行动建议

经过对国内可本地部署图文视频大模型的全面分析,我们可以得出以下核心结论:

技术成熟度评估:

国内大模型技术已经达到了国际先进水平,在某些领域甚至实现了超越。百度文心 ERNIE 4.5、腾讯混元 Large、阿里通义 Qwen3 等模型在多项评测中超过了 Llama3.1、Mixtral 等国际一流开源模型。特别是在中文理解和生成方面,国内模型具有天然优势,在中文对齐、古文、成语、逻辑等方面表现优异。

RTX 5080 OC 16GB 适配性总结:

RTX 5080 OC 16GB 作为一款性能强劲的消费级显卡,为大模型本地部署提供了良好的硬件基础。通过合理的量化技术和优化策略,可以在该显卡上运行从 0.3B 到 32B 参数规模的各类模型。7B 以下规模的模型可以直接以 FP16 精度运行,13B-14B 规模的模型需要 8-bit 量化,32B 规模的模型需要 4-bit 量化。在实际应用中,建议优先选择 4B-8B 规模的模型,在性能和显存占用之间达到最佳平衡。

多模态能力发展:

国内大模型在多模态技术方面取得了重要突破,已经从单一模态向综合多模态发展。通义万相 2.5 首次采用原生多模态架构,支持文本、图像、视频、音频多种模态的输入输出;腾讯混元 Large 支持 256K 上下文长度的长文本处理;Qwen3-Omni 能够实现文字 + 自然语音的实时流式响应。这些技术进步为丰富的应用场景提供了可能。

本地化部署优势:

本地化部署在数据隐私保护、网络独立性、成本控制等方面具有显著优势。特别是在当前数据安全日益重要的背景下,本地化部署成为政府、金融、医疗等敏感行业的必然选择。虽然本地部署的初始投入较大,但从长期使用角度看,成本比云服务低 50% 以上。

行动建议:

基于以上分析,针对不同类型的用户提出以下具体行动建议:

企业用户行动方案:

需求评估阶段(1-2 周):

组建跨部门评估团队,包括 IT、业务、合规等部门

全面梳理业务需求,明确大模型应用场景和性能要求

评估现有 IT 基础设施,确定是否需要硬件升级

进行成本效益分析,对比本地部署与云服务方案

技术选型阶段(2-3 周):

根据业务场景选择合适的模型类型和规模

优先选择经过验证的主流模型(如文心 ERNIE、通义 Qwen、腾讯混元)

进行小规模测试,验证模型在实际业务场景中的表现

确定部署架构和技术路线

部署实施阶段(3-4 周):

准备硬件环境,确保满足模型运行要求

按照官方指南进行模型部署和配置

开发业务集成接口,实现与现有系统的对接

进行性能测试和优化

上线运营阶段(持续):

建立完善的监控体系,实时监测系统运行状态

制定运维流程和应急预案

定期进行模型更新和优化

开展员工培训,提高使用效率

开发者行动方案:

技能提升路径:

学习 Python 编程和深度学习基础

掌握主流 AI 框架(PyTorch、TensorFlow)的使用

深入了解大模型的原理和架构

学习模型优化技术(量化、剪枝、蒸馏等)

项目实践建议:

从简单的文本生成项目开始,逐步扩展到多模态应用

参与开源社区,贡献代码和文档

关注技术博客和论文,了解最新进展

参加相关竞赛和活动,提升实战能力

工具选择推荐:

使用 Ollama 进行快速模型部署和测试

使用 ComfyUI 进行可视化流程设计(特别是视频应用)

使用 ModelScope 获取和管理模型资源

使用 VS Code 或 PyCharm 进行开发调试

投资决策建议:

硬件投资建议:

基础配置(预算 1.5-2 万元):RTX 5080 OC 16GB + i7-12700 + 32GB 内存 + 512GB NVMe SSD

进阶配置(预算 3-4 万元):双 RTX 5080 OC 16GB + i9-13900K + 64GB 内存 + 1TB NVMe SSD

专业配置(预算 5 万元以上):根据具体需求定制

软件投资建议:

优先使用开源模型,降低软件成本

购买必要的开发工具和服务

预留模型更新和升级的预算

人力投资建议:

招聘或培养 1-2 名 AI 工程师

对现有员工进行技能培训

考虑外包部分技术工作

风险提示与应对:

技术风险:

模型能力可能无法完全满足业务需求

技术更新快,需要持续投入

解决方案:分阶段实施,预留技术升级空间

成本风险:

初始投资较大,回报周期不确定

运维成本高,需要专业团队

解决方案:进行详细的成本效益分析,制定合理的投资计划

合规风险:

需要满足数据安全和隐私保护要求

不同行业有特殊的合规要求

解决方案:提前了解相关法规,确保系统设计符合要求

未来展望:

国内大模型技术正处于快速发展期,随着技术不断成熟和应用场景不断拓展,本地化部署将成为越来越多企业的选择。RTX 5080 OC 16GB 等高性能消费级显卡的出现,大大降低了大模型本地部署的门槛。预计在未来 2-3 年内,随着模型效率的提升和硬件成本的下降,大模型将在更多领域实现普及应用。

建议用户积极拥抱这一技术趋势,根据自身需求制定合理的技术路线,在保护数据安全的前提下,充分利用大模型技术提升业务效率和创新能力。同时,要保持理性,避免盲目跟风,确保技术投资能够带来实际价值。

暂无评论内容