大家好,上一期我们了解了 Dify 平台的技术架构与核心优势。今天,我们就来使用Dify平台来构建一个简单的智能问答应用。

使用dify的三种方式

|

服务形式 |

适用场景 |

|

云服务 无需部署即可使用 |

适合个人、中小企业。 官方云服务地址:https://cloud.dify.ai |

|

社区版 本地化部署 |

适合有研发能力、对数据隐私有要求的企业 |

|

Dify Premium 使用AWS EC2部署 |

允许自定义品牌,适合对平台有定制需求的企业 |

我们使用云服务版本来演示,注册账号就能用,方便又快捷。

模型的选择与配置

要用到哪些模型?

在智能问答应用中,至少需要用到两种模型:

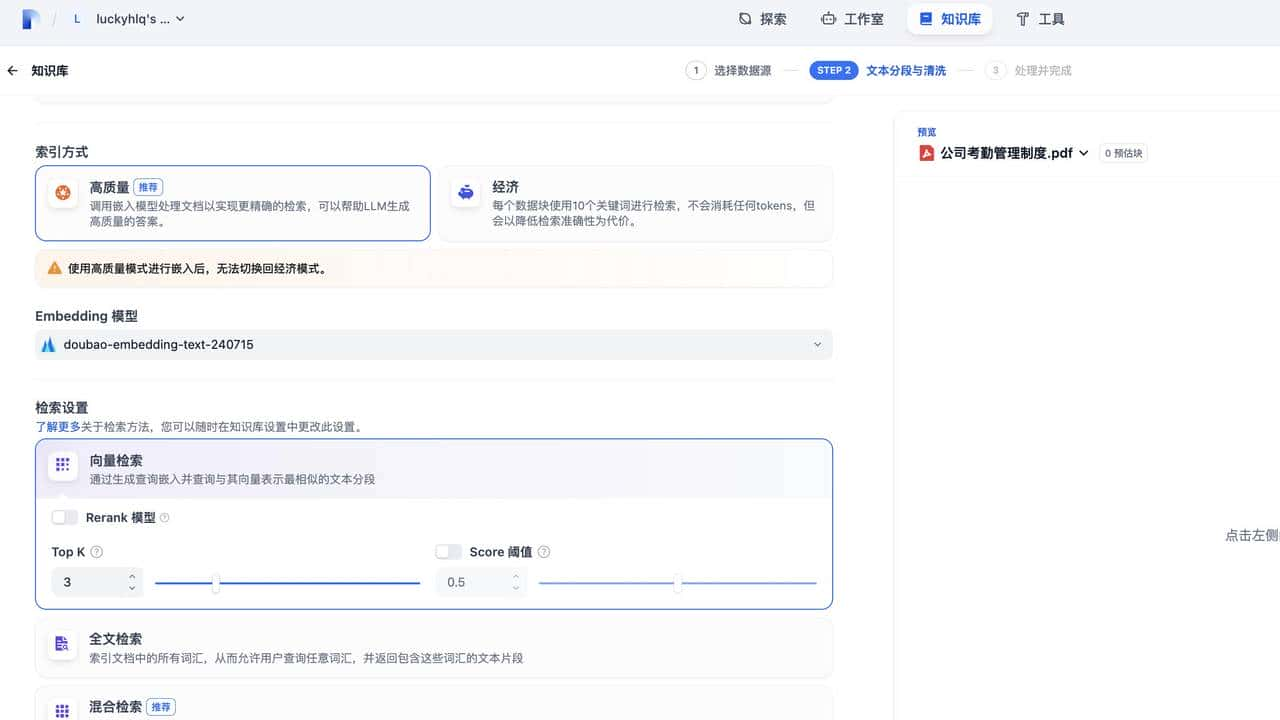

- 向量化模型–负责构建知识库,问题的语义理解和检索;

- 大语言模型–负责最终答案的生成。

模型哪里来?

必须白嫖!!!

火山引擎的多款大模型,包括字节的豆包大模型,deepseek等都是免费使用。

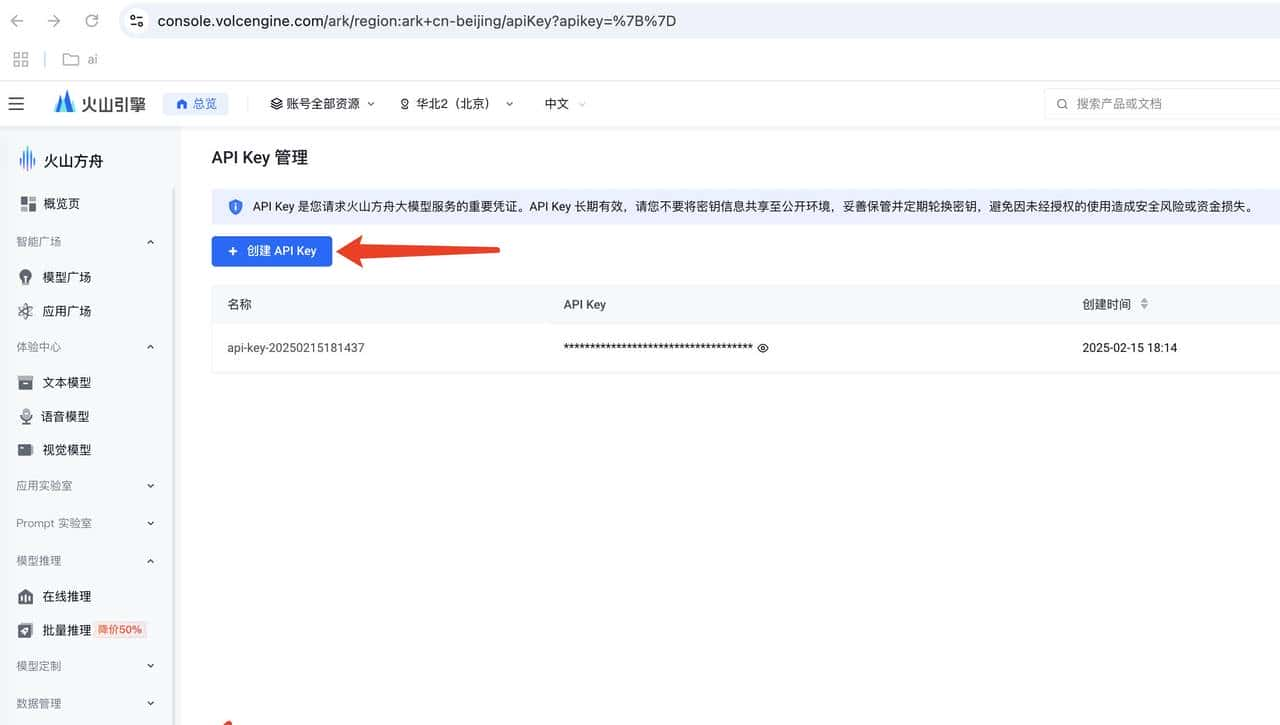

百度搜索“火山引擎”–>注册账号–>火山方舟–>进入控制台,然后按下面操作:

- 开通模型

向量化模型选 Doubao-embedding text-240715

大语言模型选 deepseek-V3

- 创建api key

- 创建接入点

dify 模型配置

- 注册登陆dify,官方云服务网站:https://cloud.dify.ai

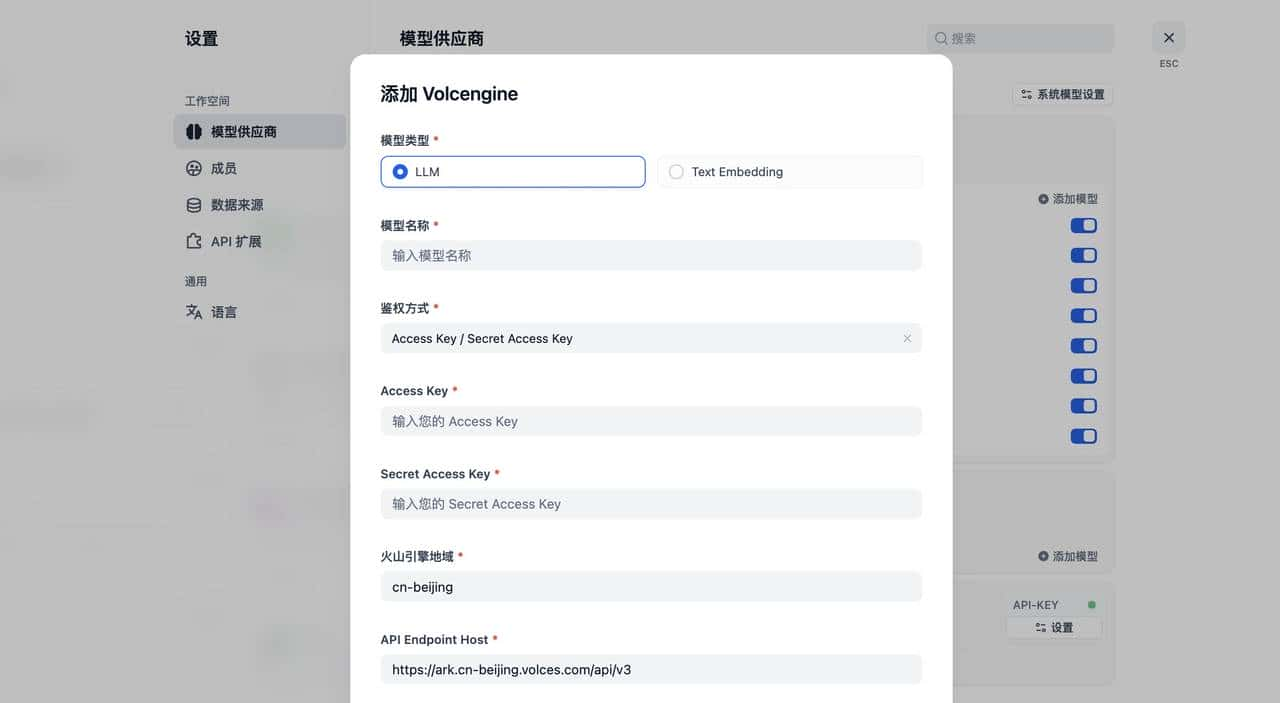

- 在插件市场中安装火山引擎大模型插件

- 配置模型的参数,将火山引擎的模型、API Key、接入点等信息复制过来

搭建智能问答应用

在 Dify 中创建知识库

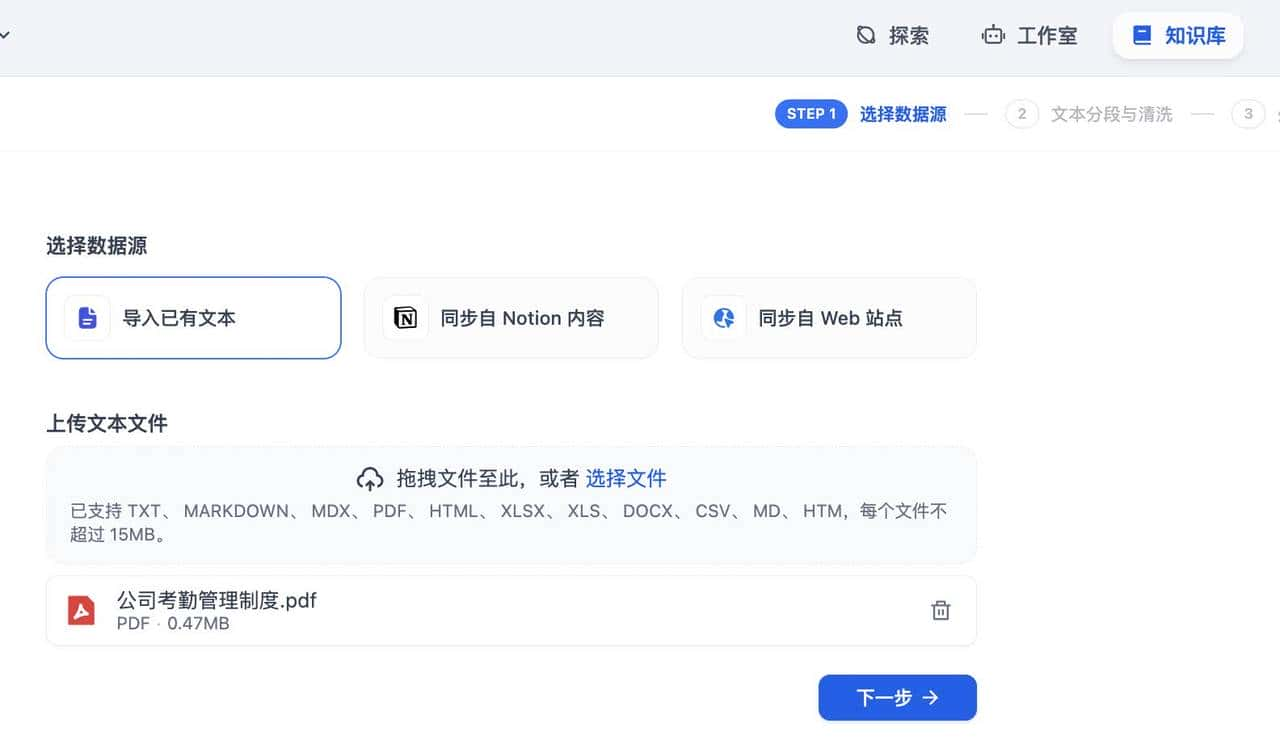

- 准备数据,我们选取公司的考勤制度文件

- 创建知识库,并上传文件

- 保存知识库

在 Dify 中创建智能应用

- 创建一个聊天应用

- 配置应用:设置提示词,选择创建好的知识库,设置大模型。

到这,我们就完成了一个关于公司考勤制度的智能问答助手的应用创建。

关于提示词(prompt)工程

Prompt 工程是引导模型生成高质量输出的关键,Dify 平台提供了可视化界面来协助我们设计高效的指令逻辑。

Prompt 的重大性

一个好的 Prompt 能够让模型更准确地理解我们的需求,生成符合预期的结果。例如,在一个文本生成任务中,不同的 Prompt 可能会导致模型生成截然不同的内容。

通过可视化界面设计 Prompt

- 在 Dify 的可视化界面中,我们可以直观地构建 Prompt。

- 可以利用 Dify 提供的模板和示例来快速创建 Prompt。我们可以在这个基础上再进行修改和定制,添加自己的具体要求。

- 进行 Prompt 调试和优化。我们可以多次测试不同的 Prompt,观察模型的输出结果,根据结果调整 Prompt 的内容和逻辑,直到得到满意的输出。

总结

本期课程我们完成了一个简单的智能问答应用开发。通过这个例子,我们完成了模型的配置,知识库的搭建,应用的Prompt设计。下一期,我们继续深入,看看智能问答应用存在的问题,该怎么解决。

有兴趣的同学可以先去博主个人主页看一下《RAG如何让大模型更靠谱…》这篇文章。

© 版权声明

文章版权归作者所有,未经允许请勿转载。如内容涉嫌侵权,请在本页底部进入<联系我们>进行举报投诉!

THE END

- 最新

- 最热

只看作者