日志在Spring Boot应用中的核心价值与常见误区

在微服务架构下,Spring Boot应用的日志已从单纯的”问题排查工具”升级为系统可观测性的核心支柱。它不仅是定位生产故障的”黑匣子”,更是性能优化、安全审计和业务运营的关键数据来源。某电商平台曾通过分析日志中的用户行为数据,发现支付流程中30%的延迟源于第三方接口调用,进而推动架构优化,将交易成功率提升至99.98%。

不过生产环境中,日志配置不当导致的问题屡见不鲜:某金融应用因未限制日志文件大小,3天内占满服务器磁盘引发服务宕机;某政务系统日志中明文输出身份证号,触发数据合规风险。结合Spring Boot默认集成的Logback框架,我们先梳理三大高频误区及解决方案:

误区1:日志内容模糊,缺乏业务上下文

反面案例:

java

log.info("处理开始");

// ...业务逻辑...

log.info("处理结束");

此类日志在故障排查时毫无价值——”处理什么?谁的请求?结果如何?”均无法追溯。

改善方案:融入业务标识,遵循”5W1H”原则(

Who/What/When/Where/Why/How):

java

log.info("开始处理用户支付请求. 用户ID={}, 订单ID={}, 金额={}", userId, orderId, amount);

// ...业务逻辑...

log.info("用户支付请求处理完成. 用户ID={}, 订单ID={}, 结果={}, 耗时={}ms", userId, orderId, result, duration);

误区2:日志级别滥用,ERROR与INFO混淆

反面案例:

java

try {

userService.login(username, password);

} catch (InvalidCredentialsException e) {

log.error("用户登录失败", e); // 错误:预期业务异常误用ERROR级别

}

ERROR级别应仅用于需要人工介入的系统故障(如数据库连接失败),而用户输入错误等预期场景属于业务事件,需用INFO级别。

改善方案:按影响范围分级:

java

try {

userService.login(username, password);

} catch (InvalidCredentialsException e) {

log.info("用户登录失败: 错误密码. username={}", username); // 业务异常→INFO

} catch (Exception e) {

log.error("登录系统异常. username={}", username, e); // 系统异常→ERROR+堆栈

}

误区3:日志性能忽视,循环打印与同步阻塞

某订单系统在批量处理10万条数据时,因循环中打印DEBUG日志,导致I/O阻塞,处理耗时从10分钟增至2小时。优化原则:避免循环日志,改用批量统计:

java

// 错误:循环打印日志

for (Order order : orders) {

log.debug("处理订单: {}", order); // 10万条日志→性能灾难

}

// 优化:批量统计日志

log.info("开始处理订单. 总数={}", orders.size());

int success = 0, fail = 0;

for (Order order : orders) {

try {

process(order);

success++;

} catch (Exception e) {

fail++;

log.error("订单处理失败. orderId={}", order.getId(), e); // 仅记录异常订单

}

}

log.info("订单处理完成. 总数={}, 成功={}, 失败={}", orders.size(), success, fail);

日志级别选择策略及实战场景示例

日志级别的合理配置直接影响系统性能与可观测性。Spring Boot支持通过logging.level配置全局及包级别的日志级别,结合环境差异动态调整,是企业级应用的基础能力。

一、级别定义与适用场景

Spring Boot继承了SLF4J的日志级别体系,从低到高为TRACE < DEBUG < INFO < WARN < ERROR < FATAL,生产环境常用INFO+WARN+ERROR三级,具体策略如下:

级别适用场景示例INFO核心业务流程节点、关键操作结果”用户支付成功. orderId=12345″WARN非致命异常、资源不足预警”数据库连接池剩余1个. 阈值=5″ERROR系统故障、数据异常需人工介入”MySQL连接失败: Connection refused”

二、多环境级别配置实战

通过Spring Profile实现环境隔离,在application.yml中定义:

yaml

# 全局配置

logging:

level:

root: WARN # 全局默认WARN

com.example.business: INFO # 业务包INFO

com.example.framework: ERROR # 框架包ERROR

---

# 开发环境 (spring.profiles.active=dev)

spring:

profiles: dev

logging:

level:

root: DEBUG # 开发环境DEBUG便于调试

com.example: TRACE # 应用包TRACE级详细日志

---

# 生产环境 (spring.profiles.active=prod)

spring:

profiles: prod

logging:

level:

com.example.payment: WARN # 支付模块敏感操作仅WARN

com.example.order: INFO # 订单模块INFO级流程日志

三、动态级别调整(企业级运维必备)

Spring Boot Actuator提供/actuator/loggers端点,支持运行时调整日志级别,无需重启应用。配置步骤:

- 添加Actuator依赖:

xml

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>

- 暴露日志端点:

yaml

management:

endpoints:

web:

exposure:

include: loggers # 暴露loggers端点

- 动态调整(通过POST请求):

bash

# 将com.example.order包级别调整为DEBUG

curl -X POST http://localhost:8080/actuator/loggers/com.example.order

-H "Content-Type: application/json"

-d '{"configuredLevel":"DEBUG"}'

企业级实践:结合监控告警,当系统出现异常时,自动将相关模块日志级别临时调整为DEBUG,问题解决后恢复,平衡排查效率与性能开销。

结构化日志的设计与实现方法

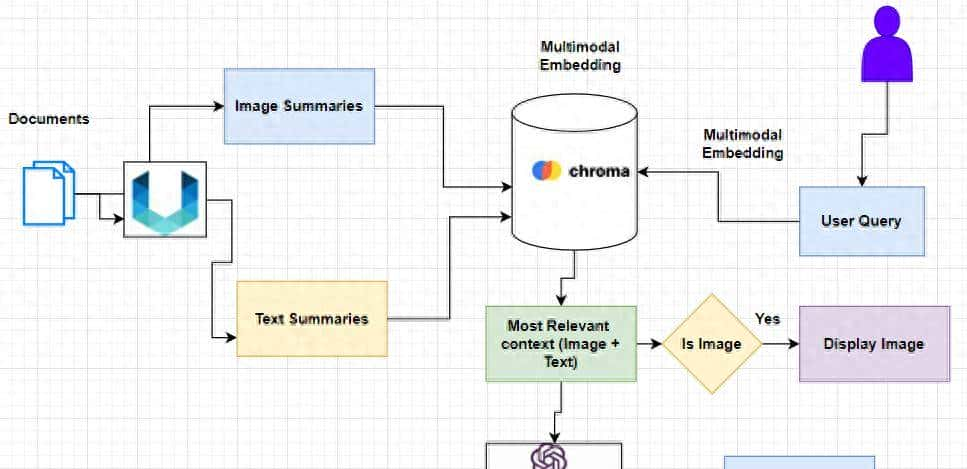

在分布式系统中,传统文本日志难以被机器解析,而结构化日志(如JSON格式)通过固定字段存储日志上下文,成为日志聚合分析的基础。某互联网公司通过结构化日志改造,将问题排查时间从平均2小时缩短至15分钟。

一、结构化日志核心字段设计

企业级应用需包含以下关键字段,确保可追溯性与可分析性:

|

字段名 |

说明 |

示例值 |

|

timestamp |

日志时间戳(UTC) |

“2025-10-13T10:00:00Z” |

|

level |

日志级别 |

“INFO” |

|

traceId |

分布式追踪ID(Sleuth生成) |

“a1b2c3d4e5f6” |

|

spanId |

调用链SpanID |

“x7y8z9” |

|

service |

服务名 |

“order-service” |

|

userId |

用户ID(业务上下文) |

“user_9527” |

|

orderId |

订单ID(业务标识) |

“order_12345” |

|

message |

日志内容 |

“支付成功” |

二、基于Logback的JSON日志实现

通过logstash-logback-encoder插件生成JSON格式日志,步骤如下:

- 添加依赖:

xml

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>8.0</version>

</dependency>

- 配置logback-spring.xml:

xml

<configuration>

<!-- 引入Spring Profile支持 -->

<springProperty scope="context" name="APP_NAME" source="spring.application.name" defaultValue="unknown"/>

<!-- JSON编码器 -->

<appender name="JSON_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>logs/${APP_NAME}.log</file>

<rollingPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy">

<fileNamePattern>logs/${APP_NAME}-%d{yyyy-MM-dd}.%i.log</fileNamePattern>

<maxFileSize>100MB</maxFileSize> <!-- 单文件100MB -->

<maxHistory>30</maxHistory> <!-- 保留30天 -->

</rollingPolicy>

<encoder class="net.logstash.logback.encoder.LogstashEncoder">

<!-- 自定义字段 -->

<customFields>{"service":"${APP_NAME}"}</customFields>

<!-- 包含MDC上下文(如traceId、userId) -->

<includeMdcKeyName>traceId</includeMdcKeyName>

<includeMdcKeyName>userId</includeMdcKeyName>

<!-- 时间格式 -->

<timestampPattern>yyyy-MM-dd'T'HH:mm:ss.SSS'Z'</timestampPattern>

</encoder>

</appender>

<!-- 生产环境使用JSON输出 -->

<springProfile name="prod">

<root level="INFO">

<appender-ref ref="JSON_FILE"/>

</root>

</springProfile>

</configuration>

三、MDC上下文传递(分布式追踪关键)

通过SLF4J的MDC(映射诊断上下文)添加 traceId 等全局字段,在请求入口(如拦截器)设置:

java

@Component

public class TraceIdInterceptor implements HandlerInterceptor {

@Override

public boolean preHandle(HttpServletRequest request, HttpServletResponse response, Object handler) {

// 生成或从请求头获取traceId

String traceId = request.getHeader("X-Trace-Id");

if (traceId == null) {

traceId = UUID.randomUUID().toString().replace("-", "");

}

MDC.put("traceId", traceId); // 添加到MDC

MDC.put("userId", SecurityUtils.getCurrentUserId()); // 添加用户ID

return true;

}

@Override

public void afterCompletion(HttpServletRequest request, HttpServletResponse response, Object handler, Exception ex) {

MDC.clear(); // 请求结束清除MDC

}

}

日志输出时,JSON将自动包含traceId和userId字段,实现跨服务日志串联。

日志输出格式规范与最佳实践

日志格式的规范性直接影响可读性与分析效率。企业级应用需遵循”** 人可阅读,机可解析 **”原则,兼顾开发排查与自动化分析需求。

一、基础格式规范

无论文本还是JSON格式,需包含以下核心要素:

- 时间戳:准确到毫秒,统一UTC时区(避免跨地域部署时差问题)。

- 级别标识:醒目区分INFO/WARN/ERROR,文本日志可用颜色或符号(如[ERROR])。

- 上下文信息:服务名、线程名、TraceId,便于分布式追踪。

- 业务关键值:用户ID、订单ID等,支持按业务维度筛选。

二、文本日志格式示例(开发环境)

在logback-spring.xml中配置控制台输出:

xml

<appender name="CONSOLE" class="ch.qos.logback.core.ConsoleAppender">

<encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<!-- 格式:时间 级别 服务名 线程 TraceId 用户ID 日志内容 -->

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%level] ${APP_NAME} [%thread] traceId=%X{traceId:-} userId=%X{userId:-} - %msg%n</pattern>

<!-- 彩色输出(开发环境友善) -->

<withJansi>true</withJansi>

</encoder>

</appender>

输出效果:

log

2025-10-13 10:30:45.123 [INFO] order-service [http-nio-8080-exec-1] traceId=a1b2c3 userId=user_9527 - 订单创建成功. orderId=12345

三、最佳实践:避免日志”陷阱”

- 禁用字符串拼接,使用占位符:

java

// 错误:无论级别是否启用,都会执行字符串拼接

log.debug("处理用户: " + user.getName() + ", ID: " + user.getId());

// 正确:级别未启用时,不执行参数计算

log.debug("处理用户: {}, ID: {}", user.getName(), user.getId());2.敏感信息脱敏,使用Logback的MaskingPatternLayout:

xml

<encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<pattern>%d{yyyy-MM-dd HH:mm:ss} [%level] - %msg%n</pattern>

<layout class="net.logstash.logback.mask.MaskingPatternLayout">

<!-- 手机号脱敏:保留前3后4位 -->

<mask>regex:(1[3-9]d{9}) -> $1****$2</mask>

<!-- 身份证号脱敏:保留前6后4位 -->

<mask>regex:([1-9]d{5})(d{8})(d{4}) -> $1********$3</mask>

</layout>

</encoder>3.大型对象日志限制,避免打印整个对象:

java

// 错误:User对象可能包含大量字段,日志冗长

log.info("用户信息: {}", user);

// 正确:仅打印关键字段

log.info("用户基本信息: id={}, name={}, type={}", user.getId(), user.getName(), user.getType());日志性能优化技巧与监控方案

高并发场景下,日志I/O可能成为性能瓶颈。某电商平台在秒杀活动中,因同步日志写入导致TPS下降30%,通过异步+批量优化后恢复正常。以下是企业级性能优化与监控实践。

一、性能优化核心技巧

- 异步日志配置(必选):使用Logback的AsyncAppender将日志写入异步化,避免阻塞业务线程:

xml

<appender name="ASYNC_FILE" class="ch.qos.logback.classic.AsyncAppender">

<appender-ref ref="JSON_FILE"/> <!-- 引用实际输出Appender -->

<queueSize>1024</queueSize> <!-- 队列大小:峰值QPS*2 -->

<discardingThreshold>0</discardingThreshold> <!-- 不丢弃任何日志 -->

<neverBlock>true</neverBlock> <!-- 队列满时不阻塞业务线程 -->

<maxFlushTime>1000</maxFlushTime> <!-- 最大刷新时间(ms) -->

</appender>2.批量日志处理:对循环内高频日志,采用批量汇总输出:

java

// 优化前:循环打印1000条日志

for (OrderItem item : items) {

log.info("处理商品: {}", item.getId()); // 1000次I/O

}

// 优化后:批量统计

log.info("开始处理商品. 总数={}", items.size());

int success = 0, fail = 0;

for (OrderItem item : items) {

try {

process(item);

success++;

} catch (Exception e) {

fail++;

log.error("商品处理失败. id={}", item.getId(), e); // 仅记录异常

}

}

log.info("商品处理完成. 总数={}, 成功={}, 失败={}", items.size(), success, fail);3.抽样日志(高并发场景):对流量大的接口,按比例抽样记录详细日志:

java

// 1%抽样率记录详细请求日志

if (Math.random() < 0.01) {

log.info("详细请求信息: request={}, headers={}", request, headers);

}二、日志监控体系搭建(Prometheus+Grafana)

- 暴露日志指标:通过Micrometer监控日志输出量、错误率,添加依赖:

xml

<dependency>

<groupId>io.micrometer</groupId>

<artifactId>micrometer-registry-prometheus</artifactId>

</dependency>2.配置Actuator端点:

yaml

management:

endpoints:

web:

exposure:

include: prometheus,health

metrics:

export:

prometheus:

enabled: true3.Prometheus采集配置:在prometheus.yml中添加:

yaml

scrape_configs:

- job_name: 'spring-boot-app'

metrics_path: '/actuator/prometheus'

static_configs:

- targets: ['localhost:8080']4.Grafana日志面板:导入仪表盘模板(如ID:12856),监控关键指标: logback_events_total{level=”error”}:错误日志量 logback_events_total{level=”warn”}:警告日志量 自定义告警:当错误日志5分钟内超过100条时触发告警。

三、分布式追踪集成(Sleuth+Zipkin)

通过Spring Cloud Sleuth自动生成TraceId/SpanId,串联跨服务日志:

- 添加依赖:

xml

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-starter-sleuth</artifactId>

</dependency>

<dependency>

<groupId>org.springframework.cloud</groupId>

<artifactId>spring-cloud-sleuth-zipkin</artifactId>

</dependency>

- 配置Zipkin地址:

yaml

spring:

zipkin:

base-url: http://zipkin-server:9411

sleuth:

sampler:

probability: 0.1 # 生产环境抽样率10%

- 效果:在Kibana中通过traceId搜索,可查看请求完整链路日志,快速定位跨服务问题。

生产环境日志配置模板与案例分析

以下是经过多家企业验证的生产环境日志配置模板,涵盖多环境隔离、ELK集成、安全审计等关键需求,并结合真实案例说明配置价值。

一、完整logback-spring.xml配置

xml

<?xml version="1.0" encoding="UTF-8"?>

<configuration scan="true" scanPeriod="30 seconds">

<!-- 环境变量 -->

<springProperty scope="context" name="APP_NAME" source="spring.application.name" defaultValue="app"/>

<springProperty scope="context" name="LOG_PATH" source="logging.file.path" defaultValue="/var/logs"/>

<!-- 1. 基础Appender定义 -->

<!-- 1.1 生产环境JSON文件输出 -->

<appender name="JSON_FILE" class="ch.qos.logback.core.rolling.RollingFileAppender">

<file>${LOG_PATH}/${APP_NAME}.log</file>

<rollingPolicy class="ch.qos.logback.core.rolling.SizeAndTimeBasedRollingPolicy">

<fileNamePattern>${LOG_PATH}/${APP_NAME}-%d{yyyy-MM-dd}.%i.log</fileNamePattern>

<maxFileSize>100MB</maxFileSize>

<maxHistory>30</maxHistory>

<totalSizeCap>10GB</totalSizeCap> <!-- 总存储上限10GB -->

</rollingPolicy>

<encoder class="net.logstash.logback.encoder.LogstashEncoder">

<customFields>{"service":"${APP_NAME}"}</customFields>

<includeMdcKeyName>traceId</includeMdcKeyName>

<includeMdcKeyName>userId</includeMdcKeyName>

<timestampPattern>yyyy-MM-dd'T'HH:mm:ss.SSS'Z'</timestampPattern>

</encoder>

</appender>

<!-- 1.2 异步Appender -->

<appender name="ASYNC" class="ch.qos.logback.classic.AsyncAppender">

<appender-ref ref="JSON_FILE"/>

<queueSize>2048</queueSize>

<discardingThreshold>0</discardingThreshold>

<neverBlock>true</neverBlock>

</appender>

<!-- 1.3 控制台输出(开发/测试环境) -->

<appender name="CONSOLE" class="ch.qos.logback.core.ConsoleAppender">

<encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<pattern>%d{yyyy-MM-dd HH:mm:ss.SSS} [%level] ${APP_NAME} [%thread] traceId=%X{traceId:-} userId=%X{userId:-} - %msg%n</pattern>

<withJansi>true</withJansi>

</encoder>

</appender>

<!-- 2. 环境差异化配置 -->

<springProfile name="dev | test">

<root level="DEBUG">

<appender-ref ref="CONSOLE"/>

</root>

</springProfile>

<springProfile name="prod">

<!-- 2.1 根日志级别 -->

<root level="WARN">

<appender-ref ref="ASYNC"/>

</root>

<!-- 2.2 业务包级别 -->

<logger name="com.example.business" level="INFO" additivity="false">

<appender-ref ref="ASYNC"/>

</logger>

<!-- 2.3 支付模块单独输出 -->

<logger name="com.example.payment" level="WARN" additivity="false">

<appender-ref ref="ASYNC"/>

</logger>

</springProfile>

</configuration>

二、ELK日志聚合案例

某金融科技公司通过ELK实现日志聚焦管理,架构如下:

- Logstash采集:Spring Boot日志通过TCP发送至Logstash,配置logstash.conf:

ruby

input {

tcp {

port => 5000

codec => json_lines

}

}

output {

elasticsearch {

hosts => ["es-cluster:9200"]

index => "%{[service]}-%{+YYYY.MM.dd}"

}

}- Kibana分析:创建索引模式order-service-*,通过Discover面板搜索: 按userId:user_9527筛选用户所有操作日志。 按level:ERROR+@timestamp:最近1小时定位故障时段。

- 安全审计:通过Kibana告警监控message:包含”密码错误”的日志,触发登录异常告警。

三、故障排查案例:从日志到根因

问题:用户反馈”支付后订单状态未更新”,通过以下步骤排查:

- 定位日志:在Kibana中搜索用户IDuserId:user_9527,找到支付请求traceId:a1b2c3。

- 链路分析:通过Zipkin发现支付服务调用库存服务超时(duration=5000ms)。

- 日志详情:查看库存服务日志,发现ERROR: MySQL连接池耗尽,结合Prometheus监控,确认当时数据库连接数达上限。

- 根因:库存服务未配置连接池自动扩容,调整spring.datasource.hikari.maximum-pool-size=20后恢复。

结语

日志是Spring Boot应用的”神经系统”,其配置质量直接决定系统的可观测性与稳定性。本文从价值认知、级别策略、结构化设计、性能优化到生产配置,提供了一套完整的企业级解决方案。核心在于:以业务价值为导向,平衡详细度与性能,结合监控工具构建可观测体系。

感谢关注【AI码力】,获取更多Java秘籍!

- 最新

- 最热

只看作者