前言

在上一章节中,我们完成了 slidev mcp 的环境搭建和基本的测试,但是这还不够,为了测试验证 MCP 的真实性能,我们需要放到大模型的环境下进行交互测试,并根据测试结果不断优化和完善 Agent 的能力。

交互测试 MCP

自检程序完成后说明你的 mcp 工具没问题了,这个时候就可以直接在「交互测试」中测试一下我们的 mcp 接入大模型后组装成的 Agent 效果如何了!

我们新建一个空白测试,然后选择「交互测试」,这个时候你就会进入一个很眼熟的对话框,这个对话框和你平时使用的大模型的别无二致,通过这个功能,我们可以在不进行 mcp 安装的情况下就测试我们开发的 agent 效果如何。

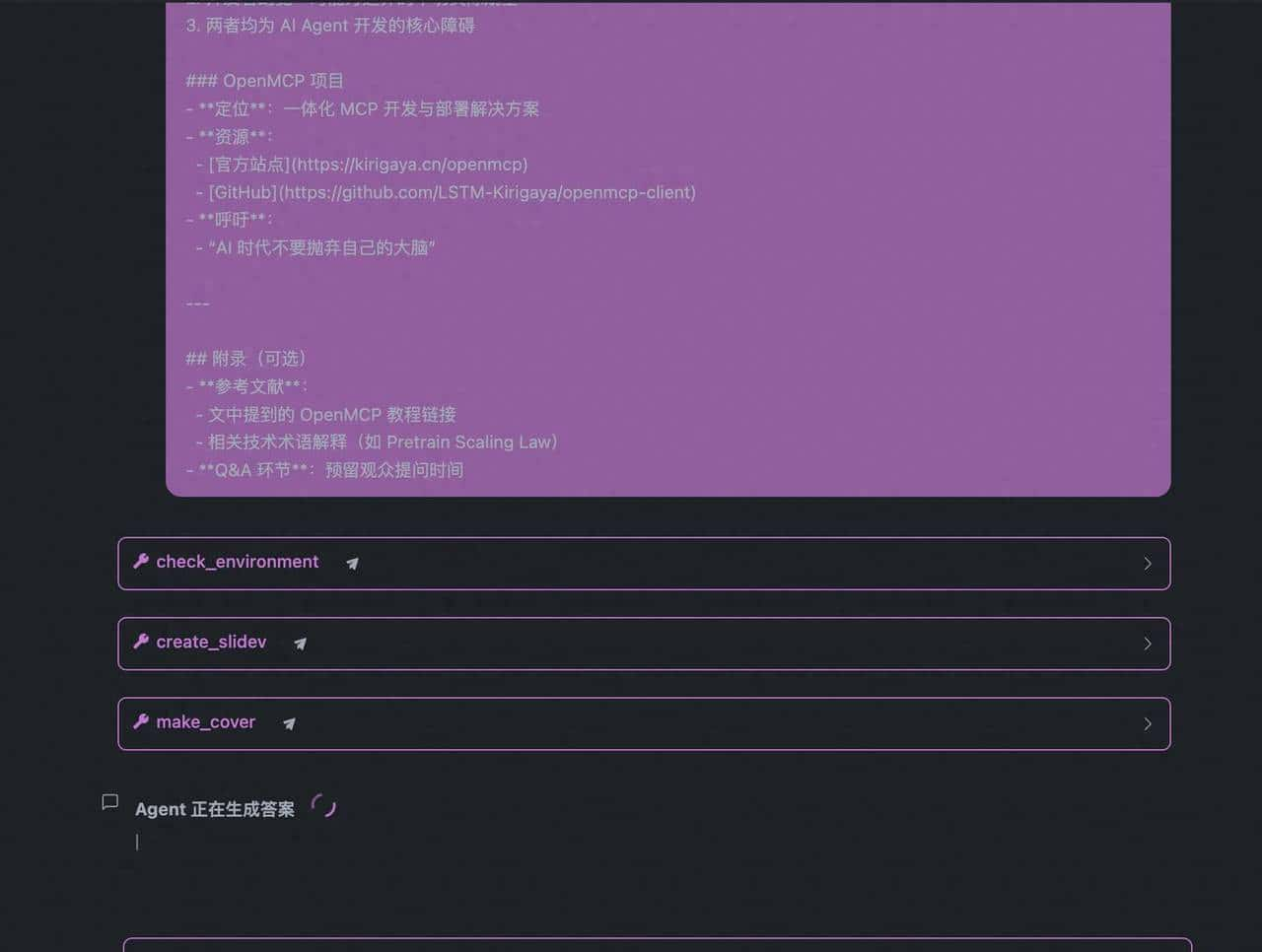

我们在对话框中粘贴我们事先准备好的一个草拟好的演讲提纲

你可以直接把任意大段文本丢给大模型,让大模型帮你生成类似这样的提纲,这里就涉及到一个可以将网站链接转换成 markdown 的项目 crawl4ai 了,此处不做赘述了,网上关于 crawl4ai 也有对应的 mcp,大家可以把它作为额外的服务器载入 openmcp 中。在 openmcp 中连接多个服务器的教程可以看 这里 .

“`markdown

讲演提纲:从大模型的幻觉现象剖析开发 AI Agent 的技术瓶颈和解决思路

封面页

- 标题:从大模型的幻觉现象剖析开发 AI Agent 的技术瓶颈和解决思路|到底谁的幻觉更大?

- 作者:锦恢 (LSTM-Kirigaya)

- 背景图:使用文章中的首张配图(链接)

- 副标题:探讨 AI Agent 开发中的核心挑战与解决之道

1. 前言

- 讲演者背景:Blender MCP 开发者OpenMCP 项目作者

- 核心问题:AI 领域 Demo 多但实用产品少两大关键问题:大模型的幻觉开发者的幻觉

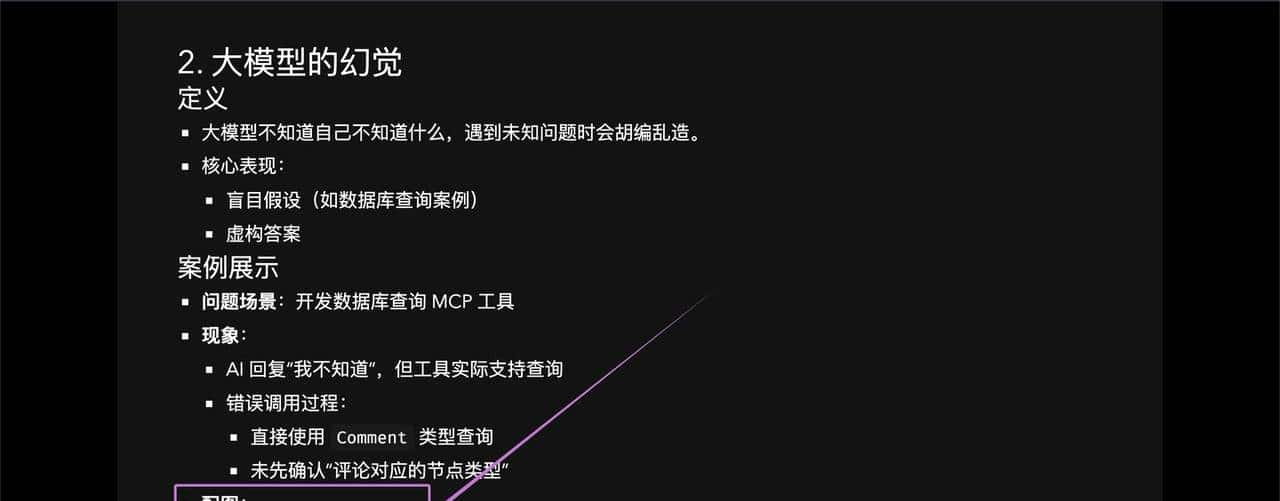

2. 大模型的幻觉

定义

- 大模型不知道自己不知道什么,遇到未知问题时会胡编乱造。

- 核心表现:盲目假设(如数据库查询案例)虚构答案

案例展示

- 问题场景:开发数据库查询 MCP 工具

- 现象:AI 回复“我不知道”,但工具实际支持查询错误调用过程:直接使用 Comment 类型查询未先确认“评论对应的节点类型”

- 配图:错误回复截图错误调用过程截图

3. 解决大模型幻觉的方法

前提条件

- 明确 应用场景 和 设计边界:AI Agent 能做什么?不能做什么?

具体方法

- 系统提示词:明确告知 AI 能力边界提供清晰的指令模板

- MCP 工具原子化拓展:细化查询能力(如先查询“评论节点类型”)

效果展示

- 优化后结果:AI 正确识别节点类型返回结构化数据

- 配图:优化结果截图

4. 开发者的幻觉

核心问题

- 开发者对大模型能力边界的不切实际期望

- 现实背景:Pretrain Scaling Law 已接近极限大模型能力边界逐渐清晰

具体表现

- 在不适合的领域强行开发 AI Agent

- 失败后归咎于“大模型太垃圾”

- 忽视设计边界和方法论

警示

- 开发者需:学习 AI 底层技术理性认识大模型局限避免“饭圈化”思维

5. 结论与 OpenMCP 介绍

核心总结

- 大模型幻觉:不知道自己不知道什么

- 开发者幻觉:对能力边界的不切实际期望

- 两者均为 AI Agent 开发的核心障碍

OpenMCP 项目

- 定位:一体化 MCP 开发与部署解决方案

- 资源:官方站点GitHub

- 呼吁:“AI 时代不要抛弃自己的大脑”

附录(可选)

- 参考文献:文中提到的 OpenMCP 教程链接相关技术术语解释(如 Pretrain Scaling Law)

- Q&A 环节:预留观众提问时间 “`

然后我们询问:

“` 请帮我把下面的大纲做成 slidev ppt:

{{content}} “`

{{content}} 的地方就复制上面的大纲的文本内容。按下回车即可看到大模型会帮我们逐步进行执行:

注意了!如果你的大模型厂商不支持原生的「函数调用」(也就是询问的时候会报错,不过常见的 deepseek,qwen 等等 openmcp 内置的模型都是支持 函数调用),可以尝试把工具栏下面的「开启 XML 指令包裹」开起来:

更多关于 openmcp 「交互测试」的使用方法,可以移步 官方文档.

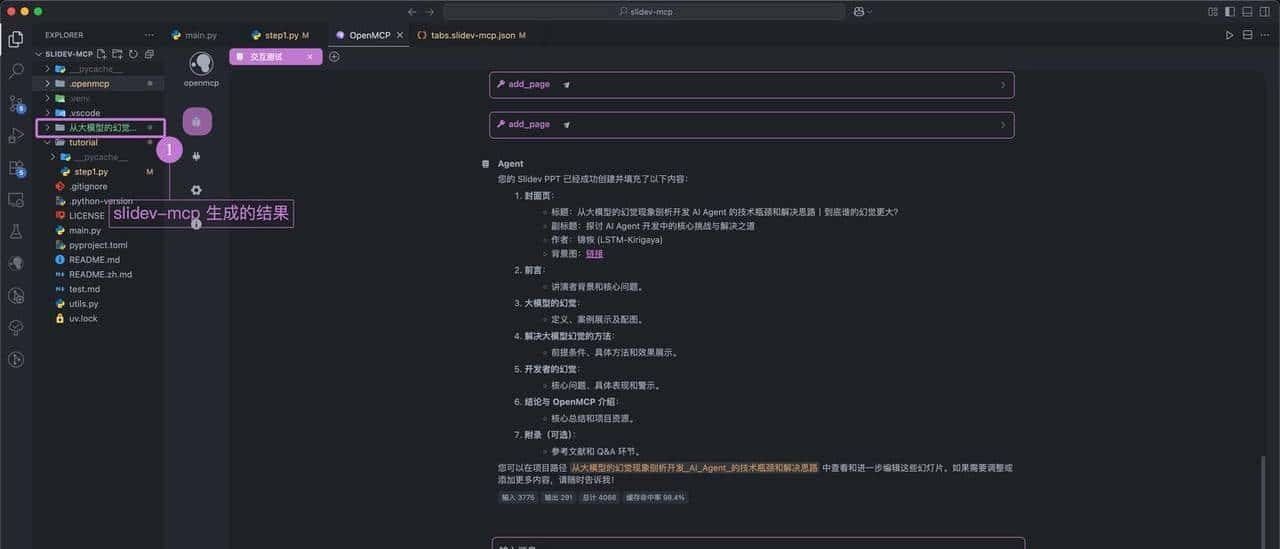

稍等片刻,就能看到 slidev mcp 生成的结果了:

我们进入这个文件夹,然后运行服务器:

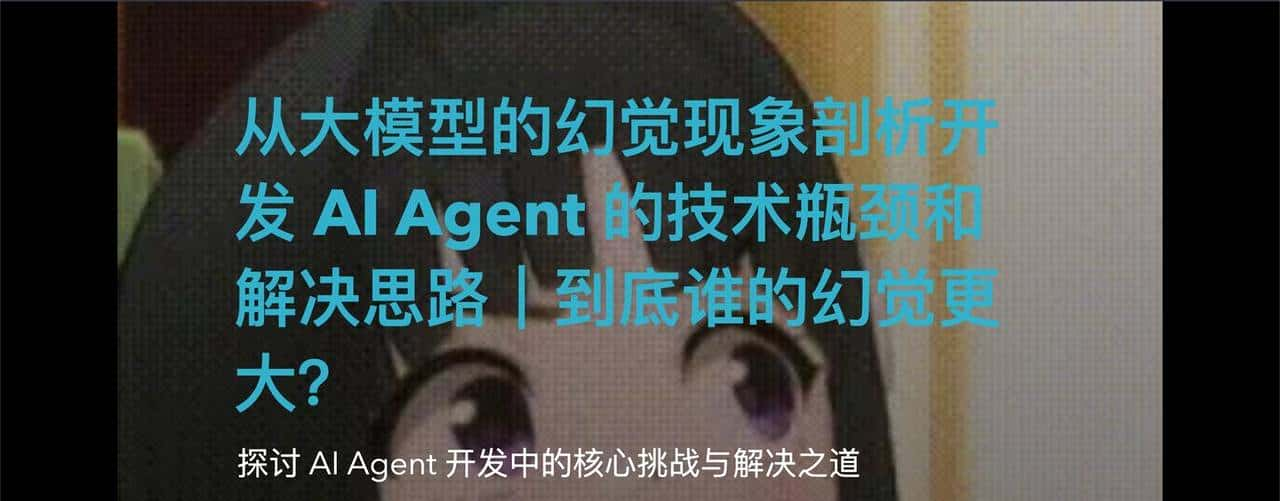

你就可以看到我们生成的效果:

PPT 架子是生成了,但是效果嘛,就有点不尽如人意了。根本缘由在于大模型对于部分参数缺少了上下文,导致胡乱填写。列如大模型不知道封面图要放什么,所以它只会自己从大纲里面找到第一个。

下面这一页也有问题:

我们想要渲染出这张图,但是 agent 给出的渲染结果却是两个链接,这也是不对的。所以,在第一轮交互测试后,我们就有必要开始进行第一次的迭代了。

AI Agent 开发须知:永远不要认为你能一次性就开发出完美的 Agent,Agent 必定要在反复迭代和测试中不断改善。

根据交互测试结果反复迭代 mcp 工具

针对之前的问题,我们可以从如下两个角度出发,进行改善:

- 通过约束 mcp 工具的入口参数来规约调用工具的行为范式。参考.

- 增加 mcp 提词来注入额外的先验知识。参考.

我们在之前的代码中添加如下的代码:

“`python

“`

然后我们启动第二版本的 slidev mcp,点击交互测试,我们先按照下面的步骤来选中我们刚刚创建的 prompt

在正式启动之前,记得先删除之前生成的文件夹(由于 slidev mcp 实现了读取存在的 ppt 的功能,如果读取后再修改,那么本文后面案例的复现难度就会提升)

等待生成后,可以看到,此时的 PPT 就变成正常的双栏结构了,左侧文字,右侧图片。

当然,根据你的领域知识,可能生成的 ppt 还存在其他地方的问题,那么就需要进行下一轮迭代,直到迭代到让你满意为止。

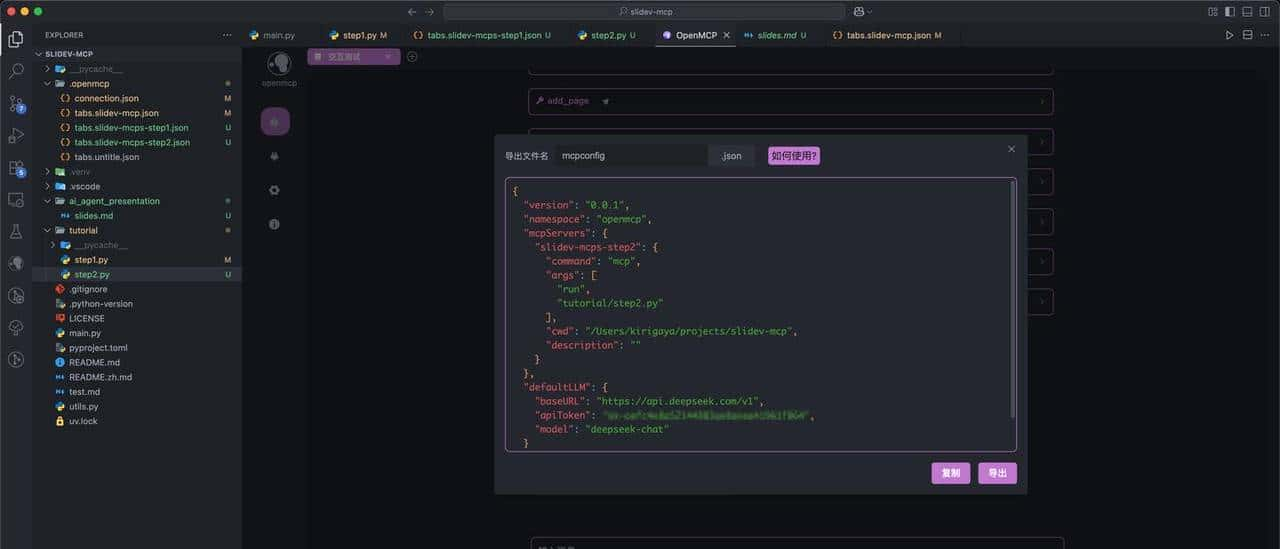

导出 mcp 配置文件

如果你的测试已经让你满意,那么你就可以选择将你的结果导出,点击工具栏最右的「导出 mcpconfig」,然后会出现一个对话框:

选择导出或者复制都行,复制出的配置文件,可以直接载入 Claude Desktop 或者 Cherry Studio 中,也可以根据此处的教程,使用 openmcp-sdk 直接部署到你的服务或者程序中。

结论

好啦!信任通过这篇教程,大家应该能够更加直观地了解到 AI Agent 的一个基本开发流程,以及 mcp 是什么,如何调试和部署了。

想要了解更多的 Agent 开发信息,可以浏览一下 OpenMCP 的官网,那里面提供了不少的使用教程和开发案例。

暂无评论内容