作为一个在Dify部署上吃过无数亏的老韭菜,今天我要把这些年踩过的坑全部分享给你们。信任我,看完这篇文章,你能少熬几个通宵。

前言:为什么选择Dify?

说实话,刚开始接触Dify的时候,我也是一脸懵逼。市面上这么多AI应用开发平台,为啥偏偏选它?

用了半年后我发现,Dify最大的优势就是真的很适合快速搭建AI应用。不像那些需要从头写代码的方案,Dify提供了可视化的工作流编辑器,连我这种后端开发都能快速上手。

但是!划重点来了——开发环境跑得6,不代表生产环境就没问题。这就是我今天要聊的重点。

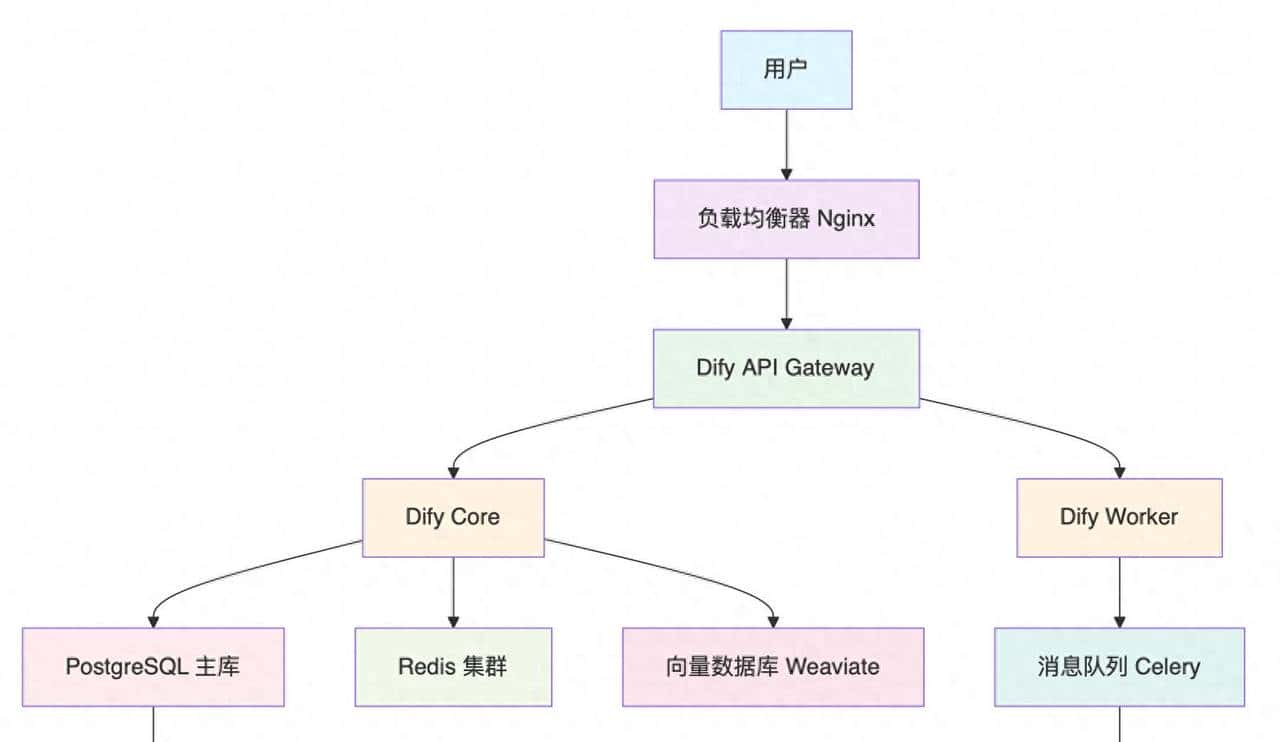

生产环境架构设计

先看看一个典型的Dify生产环境应该长什么样:

看起来挺复杂?别慌,我们一步步来拆解。

第一步:服务器配置要求

这里我要先泼个冷水,别用1核2G的服务器跑生产环境!我之前就犯过这个错误,结果系统三天两头崩溃。

推荐配置

最低配置(适合小团队试水):

- CPU: 4核

- 内存: 8GB

- 存储: 100GB SSD

- 带宽: 10Mbps

生产推荐配置:

- CPU: 8核以上

- 内存: 16GB以上

- 存储: 500GB SSD

- 带宽: 50Mbps以上

高并发配置:

- CPU: 16核以上

- 内存: 32GB以上

- 存储: 1TB SSD

- 带宽: 100Mbps以上

第二步:环境准备

Docker环境安装

老实说,我最开始是拒绝用Docker的,觉得直接装更直接。但是踩了几次环境配置的坑后,我彻底投降了。

# 卸载旧版本Docker(如果有的话)

sudo apt-get remove docker docker-engine docker.io containerd runc

# 安装必要的包

sudo apt-get update

sudo apt-get install

apt-transport-https

ca-certificates

curl

gnupg

lsb-release

# 添加Docker官方GPG密钥

curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo gpg --dearmor -o /usr/share/keyrings/docker-archive-keyring.gpg

# 添加Docker仓库

echo

"deb [arch=amd64 signed-by=/usr/share/keyrings/docker-archive-keyring.gpg] https://download.docker.com/linux/ubuntu

$(lsb_release -cs) stable" | sudo tee /etc/apt/sources.list.d/docker.list > /dev/null

# 安装Docker

sudo apt-get update

sudo apt-get install docker-ce docker-ce-cli containerd.io

# 安装Docker Compose

sudo curl -L "https://github.com/docker/compose/releases/download/v2.20.0/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

sudo chmod +x /usr/local/bin/docker-compose创建项目目录

mkdir -p /opt/dify

cd /opt/dify第三步:配置文件准备

这一步超级关键!我见过太多人直接用默认配置就上生产,结果各种问题。

docker-compose.yml配置

version: '3.8'

services:

# PostgreSQL数据库

db:

image: postgres:15-alpine

restart: always

environment:

POSTGRES_DB: dify

POSTGRES_USER: dify

POSTGRES_PASSWORD: your_strong_password_here

PGDATA: /var/lib/postgresql/data/pgdata

volumes:

- ./volumes/db:/var/lib/postgresql/data

ports:

- "5432:5432"

healthcheck:

test: ["CMD-SHELL", "pg_isready -U dify"]

interval: 30s

timeout: 10s

retries: 5

# Redis缓存

redis:

image: redis:7-alpine

restart: always

command: redis-server --requirepass your_redis_password

volumes:

- ./volumes/redis:/data

ports:

- "6379:6379"

healthcheck:

test: ["CMD", "redis-cli", "--raw", "incr", "ping"]

interval: 30s

timeout: 10s

retries: 5

# Weaviate向量数据库

weaviate:

image: semitechnologies/weaviate:1.21.2

restart: always

environment:

QUERY_DEFAULTS_LIMIT: 25

AUTHENTICATION_ANONYMOUS_ACCESS_ENABLED: 'false'

AUTHENTICATION_APIKEY_ENABLED: 'true'

AUTHENTICATION_APIKEY_ALLOWED_KEYS: 'your_weaviate_api_key'

AUTHORIZATION_ADMINLIST_ENABLED: 'true'

AUTHORIZATION_ADMINLIST_USERS: 'admin'

PERSISTENCE_DATA_PATH: '/var/lib/weaviate'

DEFAULT_VECTORIZER_MODULE: 'none'

CLUSTER_HOSTNAME: 'node1'

volumes:

- ./volumes/weaviate:/var/lib/weaviate

ports:

- "8080:8080"

# Dify API服务

api:

image: langgenius/dify-api:0.6.13

restart: always

environment:

MODE: 'api'

LOG_LEVEL: 'INFO'

SECRET_KEY: 'your_secret_key_here'

DATABASE_URL: 'postgresql://dify:your_strong_password_here@db:5432/dify'

REDIS_URL: 'redis://:your_redis_password@redis:6379/0'

CELERY_BROKER_URL: 'redis://:your_redis_password@redis:6379/1'

WEAVIATE_ENDPOINT: 'http://weaviate:8080'

WEAVIATE_API_KEY: 'your_weaviate_api_key'

depends_on:

- db

- redis

- weaviate

volumes:

- ./volumes/app/storage:/app/storage

ports:

- "5001:5001"

# Dify Worker服务

worker:

image: langgenius/dify-api:0.6.13

restart: always

environment:

MODE: 'worker'

LOG_LEVEL: 'INFO'

DATABASE_URL: 'postgresql://dify:your_strong_password_here@db:5432/dify'

REDIS_URL: 'redis://:your_redis_password@redis:6379/0'

CELERY_BROKER_URL: 'redis://:your_redis_password@redis:6379/1'

WEAVIATE_ENDPOINT: 'http://weaviate:8080'

WEAVIATE_API_KEY: 'your_weaviate_api_key'

depends_on:

- db

- redis

- weaviate

volumes:

- ./volumes/app/storage:/app/storage

# Dify Web界面

web:

image: langgenius/dify-web:0.6.13

restart: always

environment:

CONSOLE_API_URL: 'https://your-domain.com'

APP_API_URL: 'https://your-domain.com'

ports:

- "3000:3000"

depends_on:

- api

# Nginx反向代理

nginx:

image: nginx:alpine

restart: always

ports:

- "80:80"

- "443:443"

volumes:

- ./nginx/nginx.conf:/etc/nginx/nginx.conf

- ./nginx/ssl:/etc/nginx/ssl

- ./nginx/logs:/var/log/nginx

depends_on:

- api

- web

volumes:

db_data:

redis_data:

weaviate_data:

app_storage:Nginx配置

创建 nginx/nginx.conf:

events {

worker_connections 1024;

}

http {

upstream api_backend {

server api:5001;

}

upstream web_backend {

server web:3000;

}

server {

listen 80;

server_name your-domain.com;

return 301 https://$server_name$request_uri;

}

server {

listen 443 ssl http2;

server_name your-domain.com;

ssl_certificate /etc/nginx/ssl/cert.pem;

ssl_certificate_key /etc/nginx/ssl/key.pem;

client_max_body_size 100M;

location /api {

proxy_pass http://api_backend;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

proxy_read_timeout 300s;

proxy_connect_timeout 75s;

}

location / {

proxy_pass http://web_backend;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

}

}

}第四步:启动和初始化

启动服务

# 创建必要的目录

mkdir -p volumes/{db,redis,weaviate,app/storage}

mkdir -p nginx/{ssl,logs}

# 启动所有服务

docker-compose up -d

# 查看服务状态

docker-compose ps数据库初始化

# 进入API容器执行数据库迁移

docker-compose exec api flask db upgrade

# 创建管理员账户

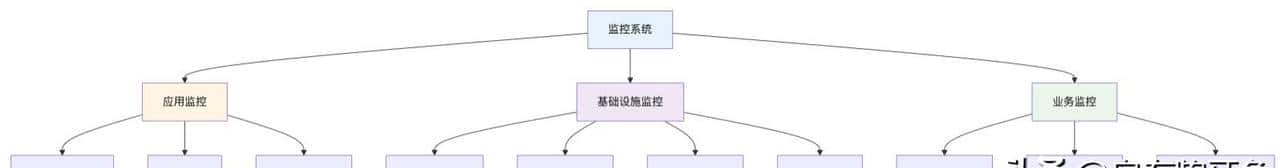

docker-compose exec api flask admin create-admin第五步:监控和维护

部署完成不是结束,而是开始!这里是我血的教训。

系统监控

日志管理

创建

docker-compose.override.yml 添加日志配置:

version: '3.8'

services:

api:

logging:

driver: "json-file"

options:

max-size: "10m"

max-file: "3"

worker:

logging:

driver: "json-file"

options:

max-size: "10m"

max-file: "3"

web:

logging:

driver: "json-file"

options:

max-size: "10m"

max-file: "3"备份策略

数据库备份脚本 backup.sh:

#!/bin/bash

BACKUP_DIR="/opt/dify/backups"

DATE=$(date +%Y%m%d_%H%M%S)

# 创建备份目录

mkdir -p $BACKUP_DIR

# 备份PostgreSQL

docker-compose exec -T db pg_dump -U dify dify > $BACKUP_DIR/dify_db_$DATE.sql

# 备份文件存储

tar -czf $BACKUP_DIR/dify_storage_$DATE.tar.gz volumes/app/storage/

# 清理7天前的备份

find $BACKUP_DIR -name "*.sql" -mtime +7 -delete

find $BACKUP_DIR -name "*.tar.gz" -mtime +7 -delete

echo "备份完成: $DATE"定期维护任务

添加到crontab:

# 每天凌晨2点备份

0 2 * * * /opt/dify/backup.sh

# 每周日凌晨3点重启服务

0 3 * * 0 cd /opt/dify && docker-compose restart

# 每小时清理临时文件

0 * * * * docker system prune -f常见问题排查

问题1:服务启动失败

症状:执行 docker-compose up -d 后某些服务一直重启

排查步骤:

# 查看服务状态

docker-compose ps

# 查看具体服务日志

docker-compose logs api

docker-compose logs db常见缘由:

- 端口被占用

- 配置文件路径错误

- 环境变量配置错误

- 磁盘空间不足

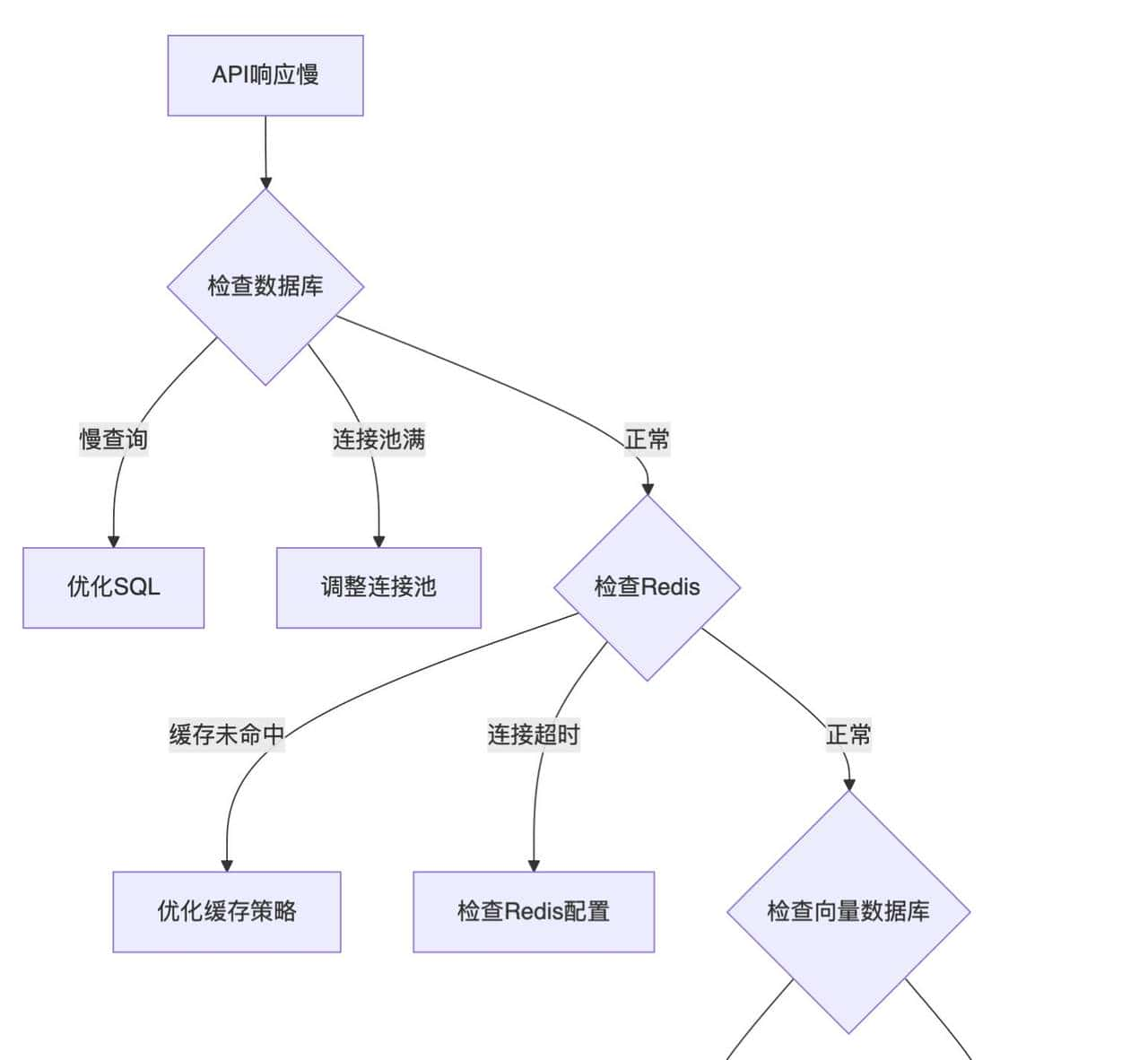

问题2:API响应慢

症状:接口响应时间超过5秒

排查思路:

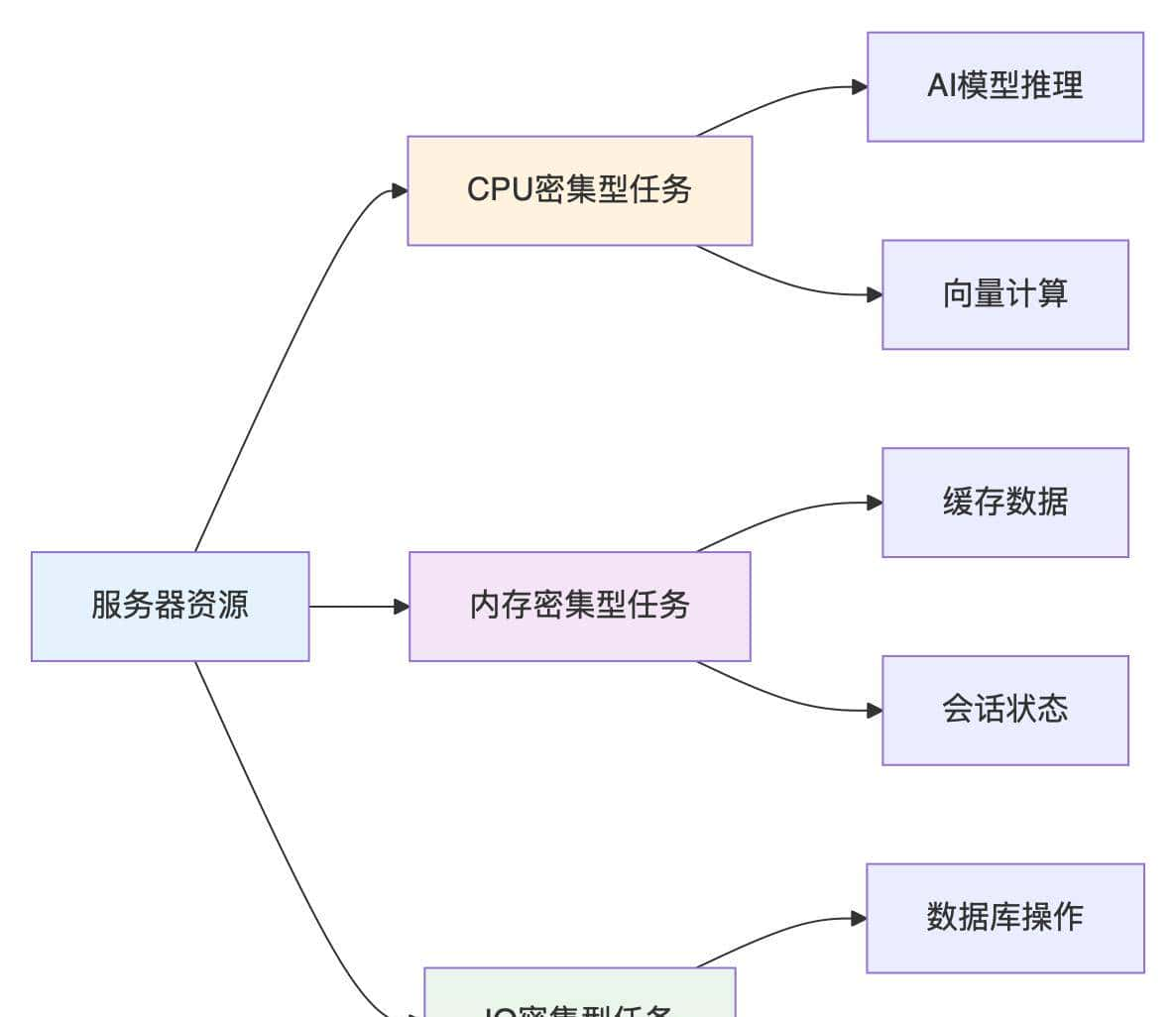

问题3:内存使用过高

解决方案:

- 调整Docker容器内存限制:

services:

api:

deploy:

resources:

limits:

memory: 2G

reservations:

memory: 1G- 优化Python进程:

# 在环境变量中添加

PYTHONOPTIMIZE=1

PYTHONUNBUFFERED=1性能优化提议

数据库优化

-- 添加必要的索引

CREATE INDEX CONCURRENTLY idx_conversations_user_id ON conversations(user_id);

CREATE INDEX CONCURRENTLY idx_messages_conversation_id ON messages(conversation_id);

CREATE INDEX CONCURRENTLY idx_datasets_created_at ON datasets(created_at);

-- 配置PostgreSQL参数

-- 在postgresql.conf中

shared_buffers = '256MB'

effective_cache_size = '1GB'

work_mem = '4MB'

maintenance_work_mem = '64MB'Redis优化

# redis.conf配置

maxmemory 1gb

maxmemory-policy allkeys-lru

save 900 1

save 300 10

save 60 10000应用层优化

- 启用Gunicorn多进程:

services:

api:

environment:

GUNICORN_WORKERS: 4

GUNICORN_TIMEOUT: 120- 调整Celery工作进程:

services:

worker:

environment:

CELERY_WORKER_CONCURRENCY: 4安全配置

防火墙设置

# 只开放必要端口

ufw allow 22 # SSH

ufw allow 80 # HTTP

ufw allow 443 # HTTPS

ufw enableSSL证书配置

推荐使用Let's Encrypt:

# 安装certbot

apt install certbot python3-certbot-nginx

# 获取证书

certbot --nginx -d your-domain.com

# 设置自动续期

echo "0 0,12 * * * root python3 -c 'import random; import time; time.sleep(random.random() * 3600)' && certbot renew -q" | tee -a /etc/crontab总结

部署Dify生产环境的确 不是一件简单的事情,但是按照这个流程走下来,基本不会有大问题。

记住几个关键点:

- 别省服务器配置 – 该花的钱必定要花

- 监控必须到位 – 出问题要第一时间知道

- 备份策略要完善 – 数据丢了真的会想哭

- 定期维护不能少 – 系统不会自己保养

- 安全配置要重点关注 – 被攻击了损失更大

最后,如果你在部署过程中遇到问题,不要慌,多看日志,大部分问题都能从日志中找到答案。实在解决不了,记得在社区求助。

祝你部署顺利,少踩坑,早下班!

#ai##智能体##dify##头条创作挑战赛##头条首发大赛#

- 最新

- 最热

只看作者